LVS-DR集群

Posted 他和晚风一样温柔

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了LVS-DR集群相关的知识,希望对你有一定的参考价值。

文章目录

LVS-DR工作原理

LVS-DR数据包流向分析

- (1)客户端发送请求到 Director Server(负载均衡器),请求的数据报文(源IP 是CI,目标IP 是VIP)到达内核空间。

- (2) Director Server和 Real Server 在同一个网络中,数据通过二层数据链路层来传输。

- (3)内核空间判断数据包的目标IP是本机VTP,此时TPVS(IP虚拟服务器)比对数据包请求的服务是否是集群服务,是集群服务就重新封装数据包。修改源、NACc地址为 Director Server 的 Nac地址,修改目标MAc地址为Real Server的 wAc地址,源工P地址与目标IP地址没有改变,然后将数据包发送给Real Server。

- (4)到达Real Server的请求报文的 MAC地址是自身的 NAC地址,就接收此报文。数据包重新封装报文(源IP地址为VIP,目标IP为CIP),将响应报文通过lo接口传送给物理网卡然后向外发出。

- (5) Real Server直接将响应报文传送到客户端。

DR模式的特点

Director Server(负载调度器)、 Real Server (web节点服务器

- Director Server 和 Real Server 必须在同一个物理网络中。

- Real Server 可以使用私有地址,也可以使用公网地址。如果使用公网地址,可以通过互联网对 RIP 进行直接访问。

- Director Server 作为群集的访问入口,但不作为网关使用。

- 所有的请求报文经由 Director Server,但回复响应报文不能经过 Director Server。

- Real Server的网关不允许指向Director Server IP,即 Real Server 发送的数据包不允许经过 Director Server。

- Real Server 上的 lo 接口配置 VIP 的 IP 地址。

LVS-DR中的ARP问题

问题一

在LVS-DR负载均衡集群中,负载均衡器与节点服务器都要配置相同的VIP地址,在局域网中具有相同的IP地址。势必会造成各服务器ARP通信的紊乱

- 当ARP广播发送到LVS-DR集群时,因为负载均衡器和节点服务器都是连接到相同的网络上,它们都会接收到ARP广播

- 只有前端的负载均衡器进行响应,其他节点服务器不应该响应ARP广播

解决方法:

对节点服务器进行处理,使其不响应针对VIP的ARP请求

- 使用虚接口lo:0承载VIP地址

- 设置内核参数arp_ ignore=1: 系统只响应目的IP为本地IP的ARP请求

问题二

问题说明:RealServer返回报文(源IP是VIP)经路由器转发,重新封装报文时,需要先获取路由器的MAC地址,发送ARP请求时,Linux默认使用IP包的源IP地址(即VIP)作为ARP请求包中的源IP地址,而不使用发送接口的IP地址,路由器收到ARP请求后,将更新ARP表项,原有的VIP对应Director的MAC地址会被更新为VIP对应RealServer的MAC地址。

路由器根据ARP表项,会将新来的请求报文转发给RealServer,导致Director的VIP失效

解决方法:

- 对节点服务器进行处理,设置内核参数arp_announce=2:系统不使用IP包的源地址来设置ARP请求的源地址,而选择发送接口的IP地址

构建LVS-DR集群

构建LVS-DR集群的步骤(理论)

实验环境准备:

| 主机 | ip地址 |

|---|---|

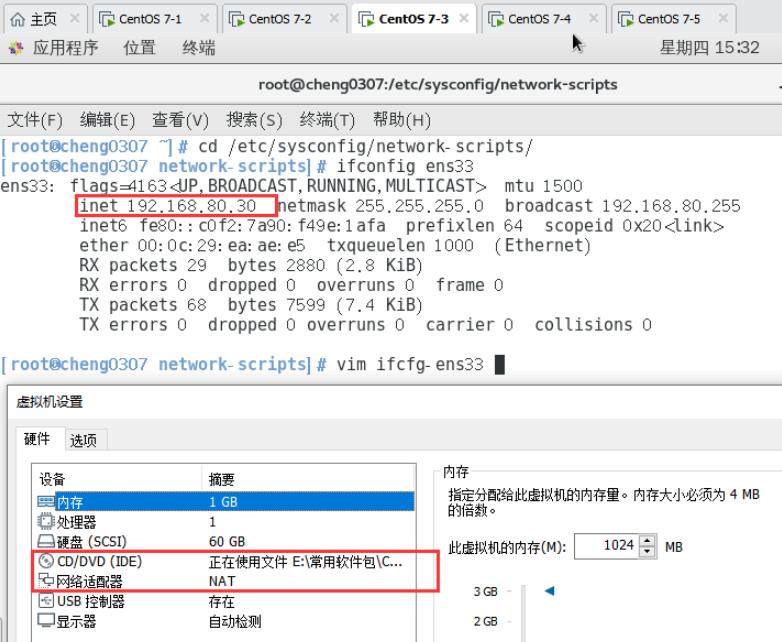

| DR 服务器 | 192.168.80.30 |

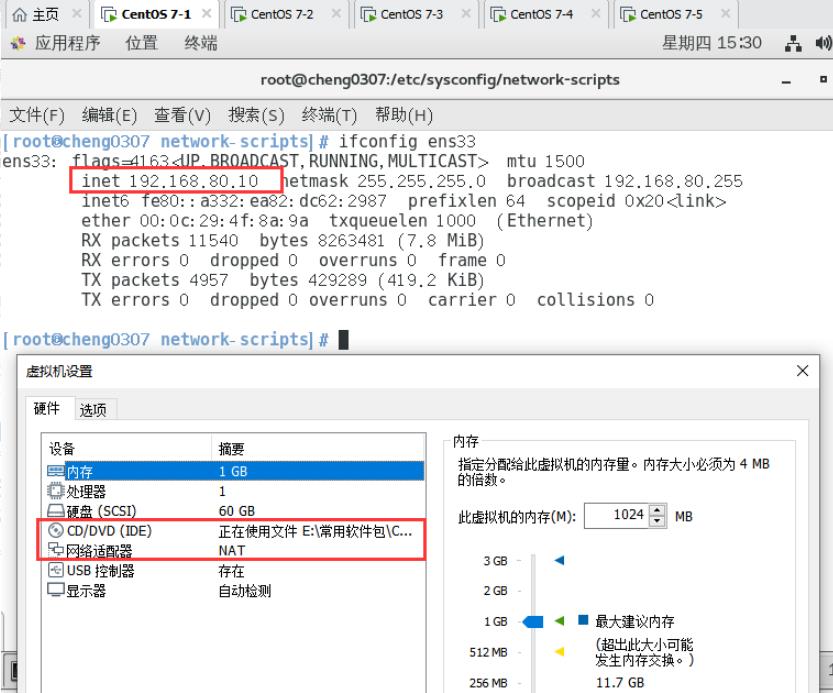

| Web 服务器1 | 192.168.80.10 |

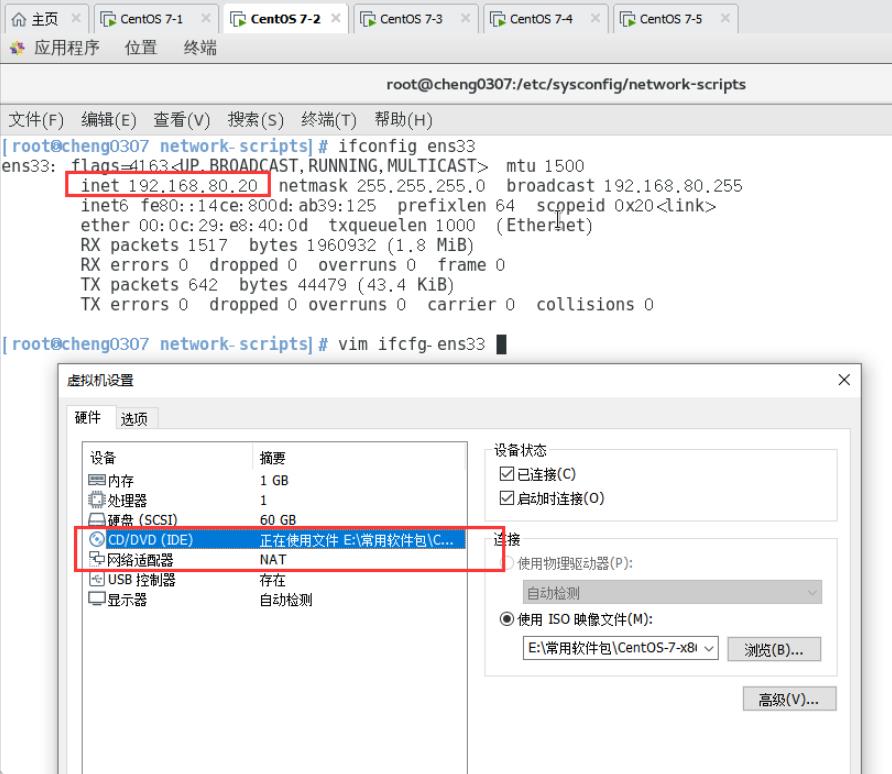

| Web 服务器2 | 192.168.80.20 |

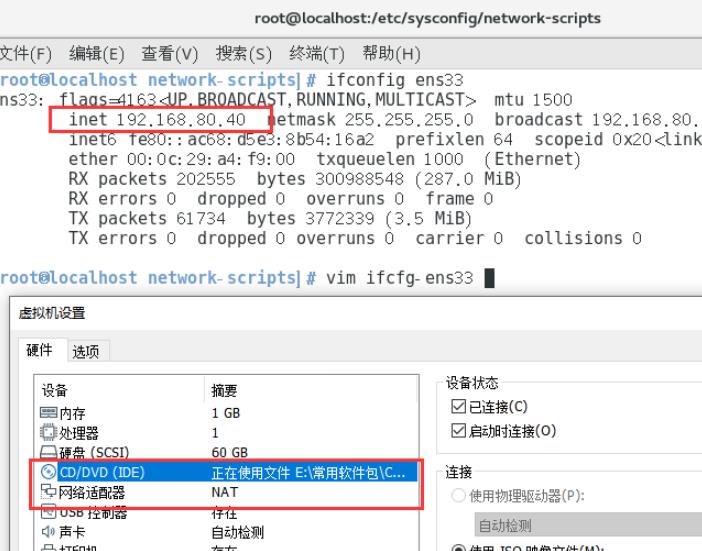

| NFS共享服务器 | 192.168.80.40 |

| vip | 192.168.80.188 |

| 客户端 | 192.168.80.200 |

1.配置负载调度器(192.168.80.30)

systemctl stop firewalld.service

setenforce 0

modprobe ip_vs

cat /proc/net/ip_vs

yum -y install ipvsadm

配置虚拟 IP 地址(VIP:192.168.80.188)

cd /etc/sysconfig/network-scripts/

cp ifcfg-ens33 ifcfg-ens33:0 #若隧道模式,复制为ifcfg-tunl0(小写字母l)

vim ifcfg-ens33:0

DEVICE=ens33:0

ONBOOT=yes #开机自动激活

IPADDR=192.168.80.188

NETMASK=255.255.255.255

ifup ens33:0

ifconfig ens33:0

route add -host 192.168.80.188 dev ens33:0

调整 proc 响应参数

由于 LVS 负载调度器和各节点需要共用 VIP 地址,应该关闭Linux 内核的重定向参数响应

vim /etc/sysctl.conf

net.ipv4.ip_forward = 1

net.ipv4.conf.all.send_redirects = 0

net.ipv4.conf.default.send_redirects = 0

net.ipv4.conf.ens33.send_redirects = 0

sysctl -p #刷新设置

配置负载分配策略

ipvsadm-save > /etc/sysconfig/ipvsadm #保存策略

systemctl start ipvsadm

ipvsadm -C

ipvsadm -A -t 192.168.80.188:80 -s rr #添加虚拟服务器

ipvsadm -a -t 192.168.80.188:80 -r 192.168.80.10:80 -g #若隧道模式,-g替换为-i

ipvsadm -a -t 192.168.80.188:80 -r 192.168.80.20:80 -g #添加真实服务器

ipvsadm #激活

ipvsadm -ln #查看节点状态,Route代表 DR模式

部署共享存储(NFS服务器:192.168.80.40)

systemctl stop firewalld.service

setenforce 0

yum -y install nfs-utils rpcbind

mkdir /opt/kgc /opt/benet

chmod 777 /opt/kgc /opt/benet

vim /etc/exports

/opt/kgc 192.168.80.0/24(rw,sync)

/opt/benet 192.168.80.0/24(rw,sync)

systemctl start nfs.service

systemctl start rpcbind.service

配置节点服务器(192.168.80.10、192.168.80.20)

systemctl stop firewalld.service

setenforce 0

配置虚拟 IP 地址(VIP:192.168.80.188)

###此地址仅用作发送Web响应数据包的源地址,并不需要监听客户机的访问请求(改由调度器监听并分发)。因此使用虚接口lo:0来承载VIP地址,并为本机添加一条路由记录,将访问VIP的数据限制在本地,以避免通信紊乱。

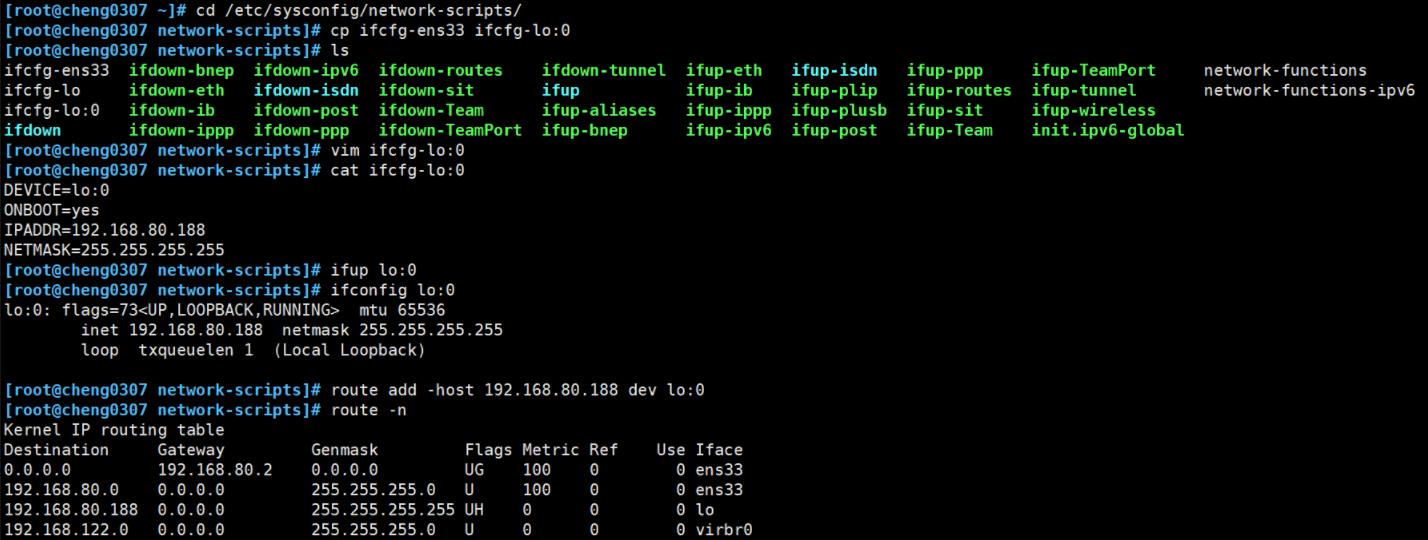

cd /etc/sysconfig/network-scripts/

cp ifcfg-ens33 ifcfg-lo:0

vim ifcfg-lo:0

DEVICE=lo:0

ONBOOT=yes

IPADDR=192.168.80.188 #和VIP保持一致

NETMASK=255.255.255.255 #注意:子网掩码必须全为 1

ifup lo:0

ifconfig lo:0

route add -host 192.168.80.188 dev lo:0 #添加VIP本地访问路由,将访问VIP的数据限制在本地,以避免通信紊乱

vim /etc/rc.local

/sbin/route add -host 192.168.80.188 dev lo:0

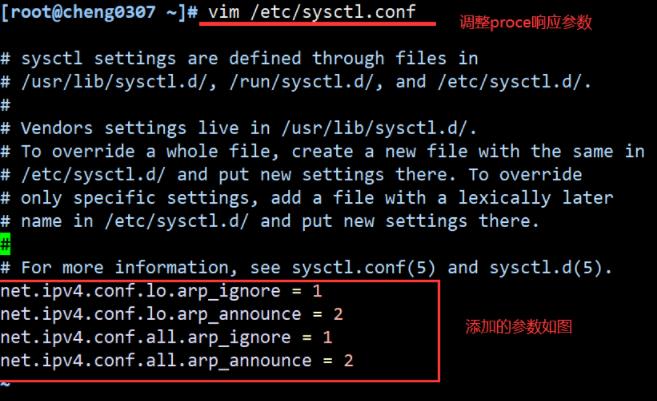

调整 proc 响应参数

vim /etc/sysctl.conf

......

net.ipv4.conf.lo.arp_ignore = 1 #系统只响应目的IP为本地IP的ARP请求

net.ipv4.conf.lo.arp_announce = 2 #系统不使用IP包的源地址来设置ARP请求的源地址,而选择发送接口的IP地址

net.ipv4.conf.all.arp_ignore = 1

net.ipv4.conf.all.arp_announce = 2

sysctl -p

或者 临时添加

echo "1" >/proc/sys/net/ipv4/conf/lo/arp_ignore

echo "2" >/proc/sys/net/ipv4/conf/lo/arp_announce

echo "1" >/proc/sys/net/ipv4/conf/all/arp_ignore

echo "2" >/proc/sys/net/ipv4/conf/all/arp_announce

sysctl -p

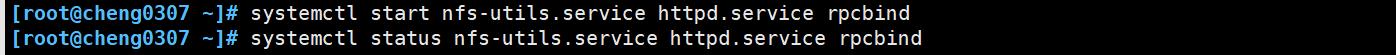

yum -y install nfs-utils rpcbind httpd

systemctl start rpcbind

systemctl start httpd

--192.168.80.10---

mount.nfs 192.168.80.40:/opt/kgc /var/www/html

echo 'this is kgc web!' > /var/www/html/index.html

--192.168.80.20---

mount.nfs 192.168.80.40:/opt/benet /var/www/html

echo 'this is benet web!' > /var/www/html/index.html

4.测试 LVS 群集

在客户端使用浏览器访问 http://192.168.80.188/,默认网关指向192.168.80.188

构建LVS-DR集群操作的具体步骤(实操)

环境搭建工作:

web1配置如下

web2配置如下:

DR服务器配置如下:

NFS共享服务器配置如下:

客户机配置如下:

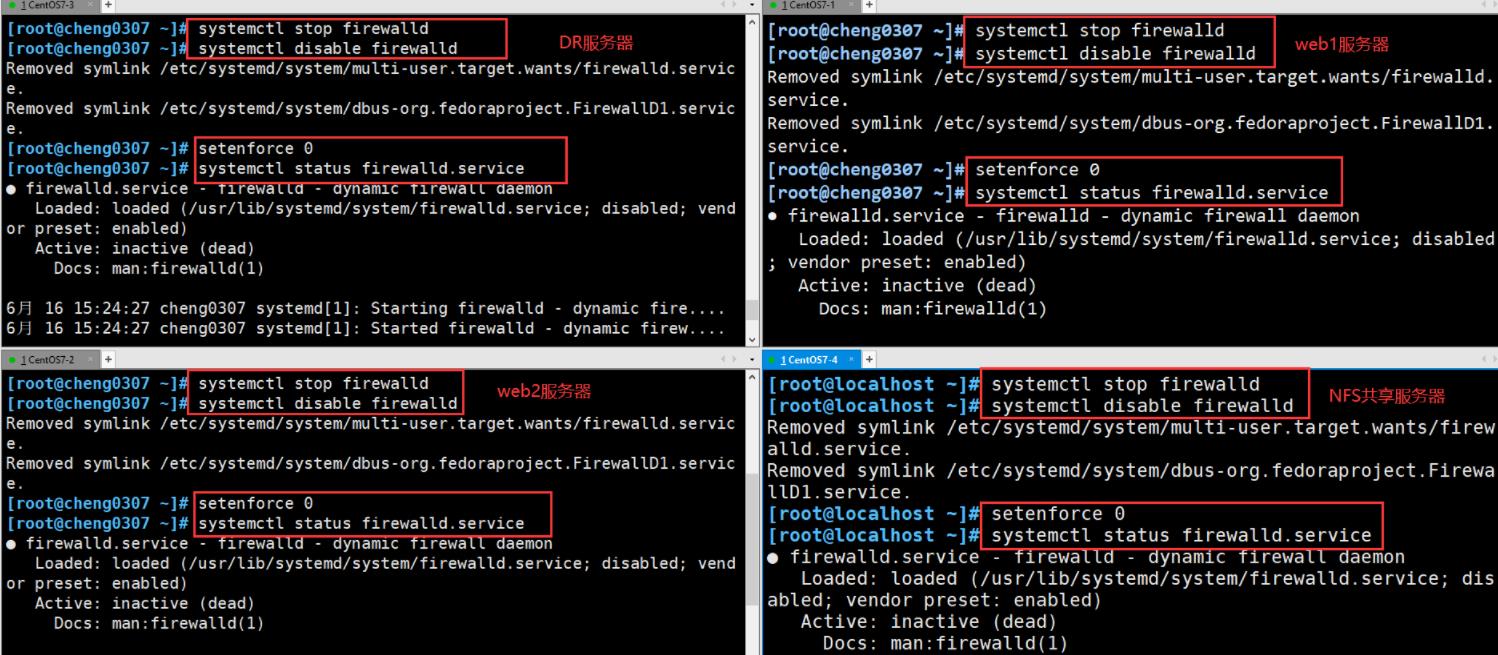

关闭所有服务器的防护墙和selinux

配置负载调度器(192.168.80.30)

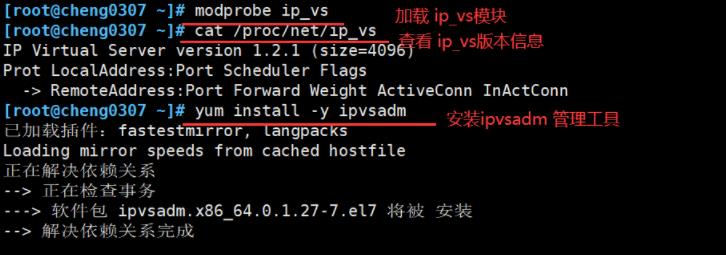

加载模块并安装管理工具

配置虚拟ip

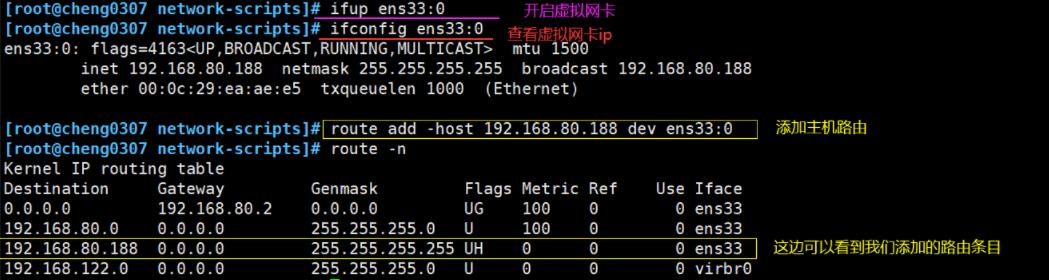

开启虚拟网卡并添加主机路由

关闭Linux 内核的重定向参数响应

刷新设置

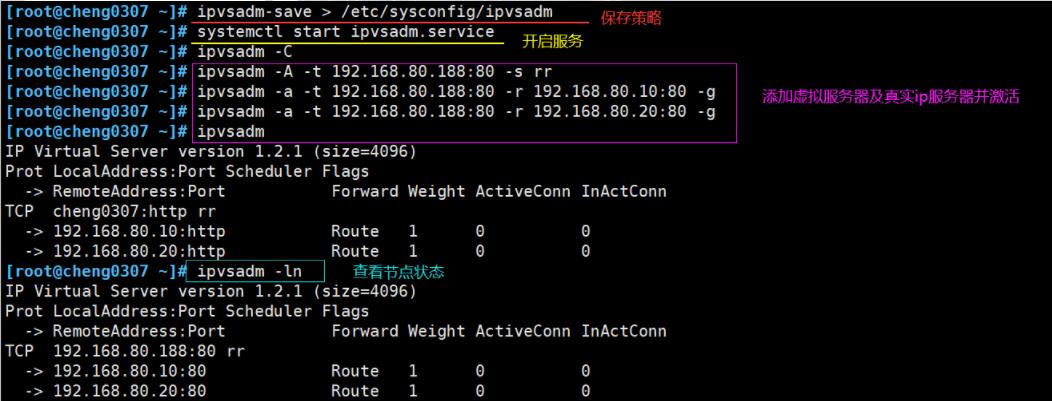

配置负载分配策略

部署共享存储(NFS服务器:192.168.80.40)

安装nfs-utils rpcbind程序(yum源提前配置好)并配置发布目录和策略

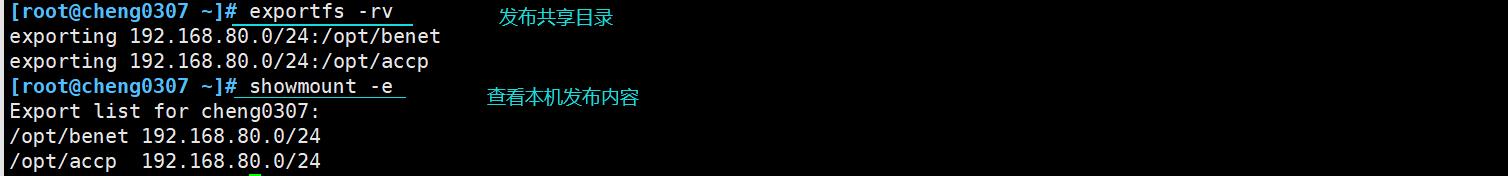

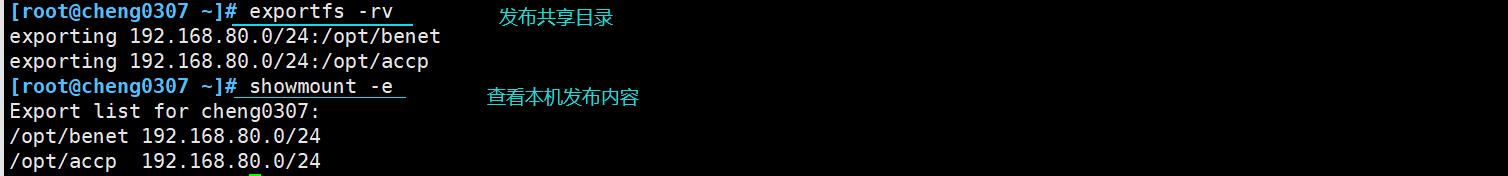

发布共享

开启服务并设置开机自启动

第三步:配置节点服务器(192.168.80.10和192.168.80.20

web1服务器配置如下:

开启接口并为本机添加路由记录

调整 proc 响应参数

刷新配置

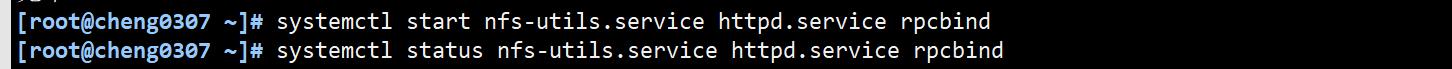

安装nfs-utils rpcbind httpd

开启服务并查看状态确认

挂载共享目录并创建本机的html文件

在浏览器中输入本机ip进行确认

web2服务器配置步骤和web1一致,步骤如下:

第四步:在客户机上测试

以上是关于LVS-DR集群的主要内容,如果未能解决你的问题,请参考以下文章