简单聊聊不可或缺的Nginx反向代理服务器--实现负载均衡上篇

Posted 赵小忠

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了简单聊聊不可或缺的Nginx反向代理服务器--实现负载均衡上篇相关的知识,希望对你有一定的参考价值。

今天又是新的一周,我养足了精神去对待新一周的工作,但是今天到公司发现还是有一点空闲时间的,所以就想与之前接触过的nginx再交往得更深一点儿。

什么是Nginx:

Nginx是一款高性能的http服务器/反向代理服务器及电子邮件(IMAP/POP3)代理服务器。官方测试nginx能够支撑5万并发链接,但是实际生产环境能到2-3万并发连接数(只是听说),并且cpu、内存等资源消耗缺非常低,运行非常稳定。

Nginx在实际生产中的应用场景:

上面已经说了,Nginx是一款高性能的http服务器,所以它可以提供单独的http服务,经常在开发中用作静态网页服务器来使用;还有一点就是它的核心应用,即反向代理服务器和负载均衡:其实反向代理这一点并不难理解,就是通过配置将服务器的IP和指定域名进行映射即可。至于负载均衡,就是当某个网站的访问量达到一定程度后,并且单台服务器不能提供服务的情况下,我们就需要借助软件技术能够让多台服务器轮流分担访问压力,目的是达到不会因为某台服务器负载高宕机而某台服务器闲置的这种不公平情况,经常我们会采取某种轮询机制来让它们正常工作。

什么是负载均衡(Load Balance):

一台普通服务器的处理能力是有限的,假如能达到每秒几万个到几十万个请求,但却无法在一秒钟内处理上百万个甚至更多的请求。但若能将多台这样的服务器组成一个系统,并通过软件技术将所有请求平均分配给所有服务器,那么这个系统就完全拥有每秒钟处理几百万个甚至更多请求的能力。这就是负载均衡最初的基本设计思想。

负载均衡是由多台服务器以对称的方式组成一个服务器集合,每台服务器都具有等价的地位,都可以单独对外提供服务而无须其他服务器的辅助。通过某种负载分担技术,将外部发送来的请求按照某种策略分配到服务器集合的某一台服务器上,而接收到请求的服务器独立地回应客户的请求。负载均衡解决了大量并发访问服务问题,其目的就是用最少的投资获得接近于大型主机的性能。

在Linux环境上安装Nginx:

- 安装PCRE yum install –y pcrepcre-devel

- 安装ZLIB yum install –y zlibzlib-devel

- 安装OPENSSL yum install –y opensslopenssl-devel

| ./configure \\ --prefix=/usr/local/nginx \\ --pid-path=/var/run/nginx/nginx.pid \\ --lock-path=/var/lock/nginx.lock \\ --error-log-path=/var/log/nginx/error.log \\ --http-log-path=/var/log/nginx/access.log \\ --with-http_gzip_static_module \\ --http-client-body-temp-path=/var/temp/nginx/client \\ --http-proxy-temp-path=/var/temp/nginx/proxy \\ --http-fastcgi-temp-path=/var/temp/nginx/fastcgi \\ --http-uwsgi-temp-path=/var/temp/nginx/uwsgi \\ --http-scgi-temp-path=/var/temp/nginx/scgi |

Nginx实现负载均衡:

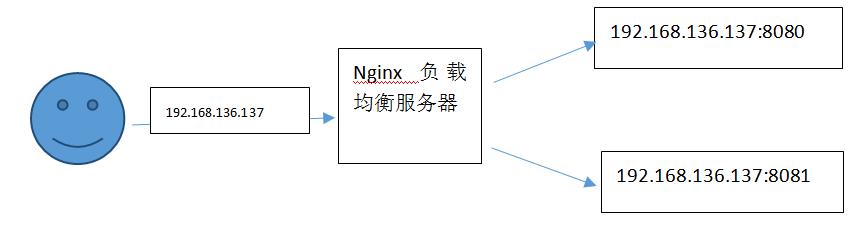

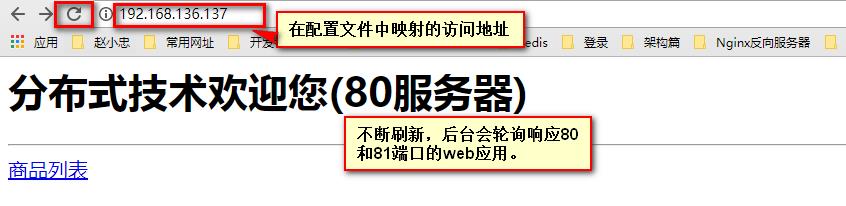

需求:当我们在浏览器访问某一地址时,后台由多个不同端口的服务器来轮询响应?

实现步骤:

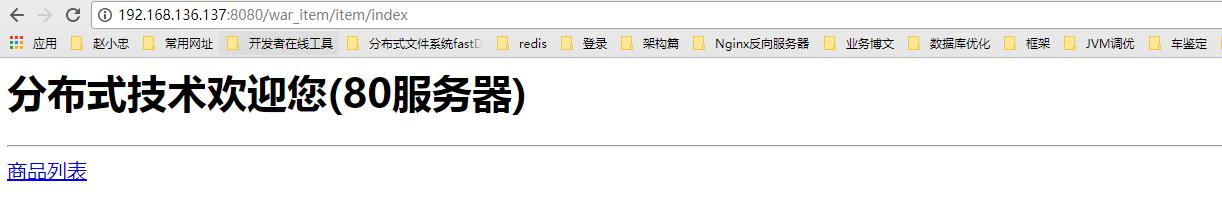

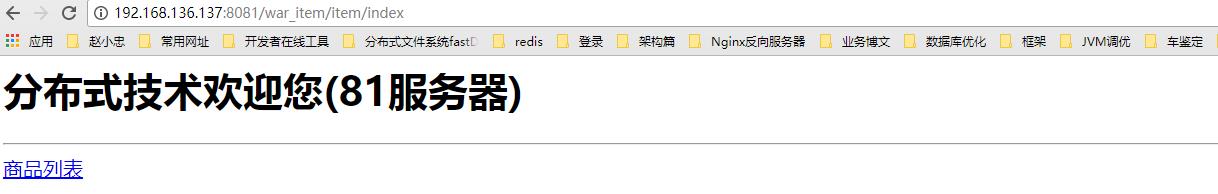

第一步、准备2台或2台以上的Tomcat服务器,并且保证它们的端口号不发生冲突并能正常访问,我这里准备了2台并且在每个Tomcat中扔进一个运行正常的web项目。

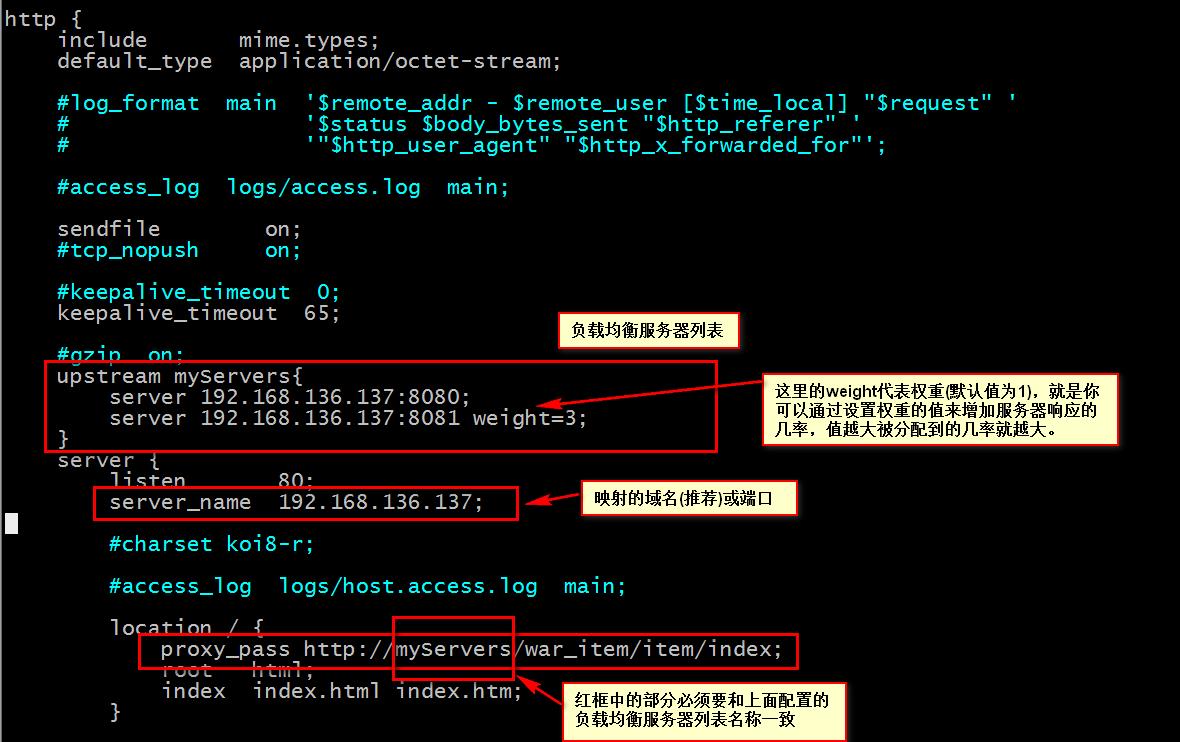

第二步、配置Nginx的负载均衡,我这里采用轮询+权重的机制来实现的,说明一点:正常情况下负载均衡的配置是通过域名映射来访问的,我这儿没有映射域名,如果各位想通过映射域名则配置域名然后去修改hosts文件即可。

第三步、通过配置文件中的配置,访问资源,最后发现俩个Tomcat服务器上的web应用轮询响应(这里本应该给各位上传一段测试后的视频的,但是咨询了一下午没能做到,还望各位将就一下吧)。

以上是关于简单聊聊不可或缺的Nginx反向代理服务器--实现负载均衡上篇的主要内容,如果未能解决你的问题,请参考以下文章