Graph Representation Learning学习笔记-chapter4

Posted Dodo·D·Caster

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Graph Representation Learning学习笔记-chapter4相关的知识,希望对你有一定的参考价值。

Chapter4 Multi-relational Data and Knowledge Graphs

this chapter : multi-relational graphs’ node embeddings

多关系图的表示方式

- 三元组 e = (u, T, v)

- u, v : 不同的节点

- T : uv节点的关系

4.1 Reconstructing multi-relational data

目标:给定两个节点的嵌入 z u z_u zu 和 z v z_v zv, 重构这些节点的relationship.

decoder (与chapter3不同,加入了节点关系来预测边的存在)

- input:a pair of node embedding + a relation type

- output : the likelihood that the edge (u, T, v) exist in the graph

4.2 Loss functions

简单地重构loss的缺点(equation)

- 计算复杂度很高

- mean-squared error in Equation (均方误差)

- 不适合二进制比较(goal:从低维嵌入decode邻接张量)

- 适合回归不适合分类任务

mean-squared error 不理解

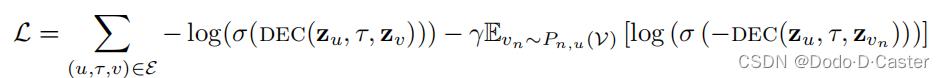

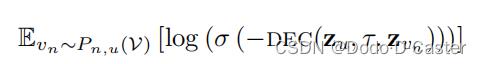

Cross-entropy loss with negative sampling

负采样的交叉熵损失

- 表示edge存在的log-likelihood

- 表示edge不存在的log-likelihood

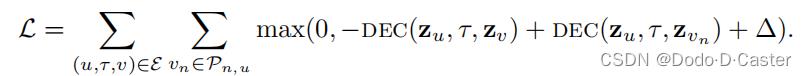

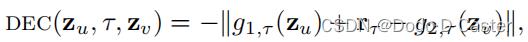

Max-margin loss

- 如果正样本的分数比负样本大,则loss小

- 如果所有样本的分数差至少有∆这么大,则loss=0

- ∆ : margin

4.3 Multi-relational decoders

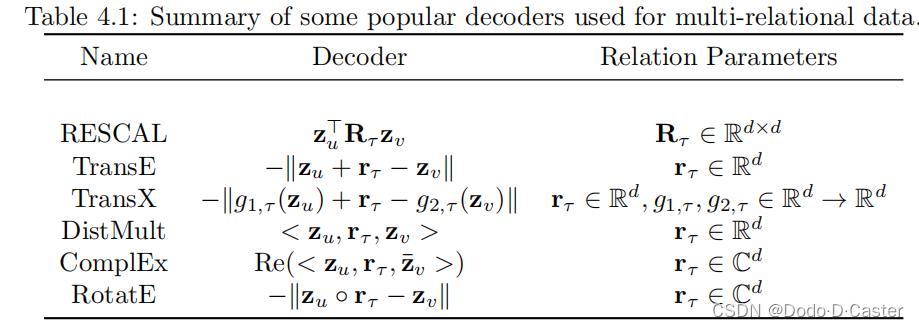

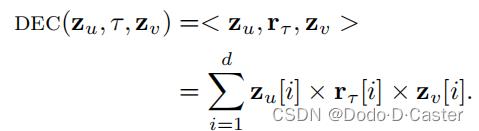

RESCAL decoder

缺点:表示关系时有很高的计算和统计消耗

- R是d*d的矩阵,所以有 O ( d 2 ) O(d^2) O(d2)个参数来表示边

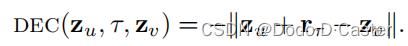

Translational decoders

降低参数量的方法:TransE

- 降到了d个参数

- 边存在的可能性和头尾节点的嵌入距离成正比

- 缺点:太简陋

对TransE的拓展:TransX

DistMult

- 不基于translate嵌入,而是通过从简单图中归纳出dot product decoder

- 缺点:只能encode对称关系,但很多关系图中的边是有向的、非对称的

Complex decoders

- 通过对终止节点(尾节点)进行复共轭(complex conjugate),解决了DistMult的缺点,适用于非对称关系

RotatE

- 将decoder定义为rotations in the complex plane(复平面上的旋转)

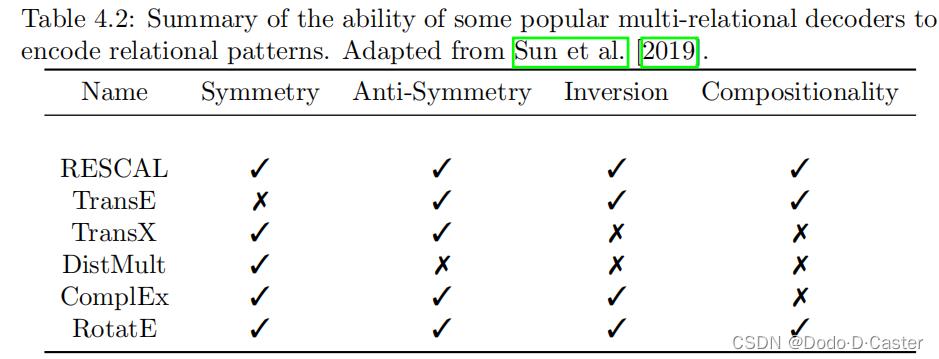

检测decoder表达能力的方法

检测decoder是否能represent边的不同逻辑模式,如对称,反对称,反演和传递

Symmetry:(u,T,v)存在,则(v,T,u)存在

anti-Synmmetry:(u,T,v)存在,则(v,T,u)不存在

Inversion:(u,T1,v)存在,则(v,T2,u)存在 (相比对称,关系T不同)

Compositionality:(u,T1,y)存在,(y,T2,v)存在,则(v,T3,u)存在

以上是关于Graph Representation Learning学习笔记-chapter4的主要内容,如果未能解决你的问题,请参考以下文章