百度飞桨各个库版本记录!

Posted 汀、

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了百度飞桨各个库版本记录!相关的知识,希望对你有一定的参考价值。

1.PaddleNLP

PaddleNLP是一款简单易用且功能强大的自然语言处理开发库。聚合业界优质预训练模型并提供开箱即用的开发体验,覆盖NLP多场景的模型库搭配产业实践范例可满足开发者灵活定制的需求。

-

📝 2022.8.1 PaddleNLP v2.3.5发布!CodeGen 对话式程序生成大模型发布,可Taskflow一键调用;通用信息抽取技术英文模型UIE en正式发布,支持英文各项信息抽取工作; RGL RGL是百度自研的 Prompt-based tuning 小样本学习算法,论文被 Findings of NAACL 2022 接收,欢迎大家使用!

PaddleNLP v2.3.5发布 https://github.com/PaddlePaddle/PaddleNLP/releases/tag/v2.3.5:

1. UIE英文版,欢迎各位在国际渠道传播;

2. 多分类、多标签、层次分类等文本分类系统方案,配套数据增强策略提升模型效果;新增小样本模型RGL;

3. 语义检索Neural Search 升级:新增部署和网页版系统全流程功能;新增无监督语义向量模型DiffCSE;

4. 代码生成模型CodeGen支持Taskflow一键调用,支持刷Leetcode、代码续写、根据注释生成代码等… …

-

🍭 2022.6.29 PaddleNLP v2.3.4发布!ERNIE Tiny 全系列中文预训练小模型发布,快速提升预训练模型部署效率,通用信息抽取技术UIE Tiny 系列模型全新升级,支持速度更快效果更好的UIE小模型。

-

🔥 2022.5.16 PaddleNLP v2.3全新发布!🎉

-

📬 2021.12.12 PaddleNLP v2.2发布!新增开箱即用的NLP能力Taskflow!配套语义检索、智能问答、评论观点抽取产业案例,快速搭建端到端NLP系统!配套视频课程直通车!

1.1 UIE

多模型选择,满足精度、速度要求

| 模型 | 结构 | 语言 |

|---|---|---|

uie-base (默认) | 12-layers, 768-hidden, 12-heads | 中文 |

uie-base-en | 12-layers, 768-hidden, 12-heads | 英文 |

uie-medical-base | 12-layers, 768-hidden, 12-heads | 中文 |

uie-medium | 6-layers, 768-hidden, 12-heads | 中文 |

uie-mini | 6-layers, 384-hidden, 12-heads | 中文 |

uie-micro | 4-layers, 384-hidden, 12-heads | 中文 |

uie-nano | 4-layers, 312-hidden, 12-heads | 中文 |

2. ERNIE

ERNIE/README.zh.md at develop · PaddlePaddle/ERNIE · GitHub

文心大模型ERNIE是百度发布的产业级知识增强大模型,涵盖了NLP大模型和跨模态大模型。2019年3月,开源了国内首个开源预训练模型文心ERNIE 1.0,此后在语言与跨模态的理解和生成等领域取得一系列技术突破,并对外开源与开放了系列模型,助力大模型研究与产业化应用发展。提醒: ERNIE老版本代码已经迁移至repro分支,欢迎使用我们全新升级的基于动静结合的新版ERNIE套件进行开发

- 2022.8.18:

- 图文跨模态预训练模型

ERNIE-Vil2(base)正式开源

- 图文跨模态预训练模型

- 2022.5.20:

- 最新开源ERNIE 3.0系列预训练模型:

- 110M参数通用模型ERNIE 3.0 Base

- 280M参数重量级通用模型ERNIE 3.0 XBase

- 74M轻量级通用模型ERNIE 3.0 Medium

- 新增语音-语言跨模态模型ERNIE-SAT 正式开源

- 新增ERNIE-Gen(中文)预训练模型,支持多类主流生成任务:主要包括摘要、问题生成、对话、问答

- 动静结合的文心ERNIE开发套件:基于飞桨动态图功能,支持文心ERNIE模型动态图训练。您仅需要在模型训练开启前,修改一个参数配置,即可实现模型训练的动静切换。

- 将文本预处理、预训练模型、网络搭建、模型评估、上线部署等NLP开发流程规范封装。

- 支持NLP常用任务:文本分类、文本匹配、序列标注、信息抽取、文本生成、数据蒸馏等。

- 提供数据清洗、数据增强、分词、格式转换、大小写转换等数据预处理工具。

- 最新开源ERNIE 3.0系列预训练模型:

- 2021.12.3:

- 多语言预训练模型

ERNIE-M正式开源

- 多语言预训练模型

- 2021.5.20:

- 2020.9.24:

- 2020.5.20:

ERNIE-GEN模型正式开源! (点击进入)- 最强文本生成预训练模型正式开源,相关工作已被

IJCAI-2020收录。- 首次把 ERNIE 预训练技术能力扩展至文本生成领域,在多个典型任务上取得最佳。

- 您现在即可下载论文报告的所有模型(包含 base/large/large-430G)。

- 首次在预训练阶段加入span-by-span 生成任务,让模型每次能够生成一个语义完整的片段。

- 提出填充式生成机制和噪声感知机制来缓解曝光偏差问题。

- 精巧的 Mulit-Flow Attention 实现框架。

- 最强文本生成预训练模型正式开源,相关工作已被

- 2020.4.30 发布ERNIESage, 一种新型图神经网络模型,采用ERNIE做为aggreagtor. 由PGL实现。

- 2020.3.27 在SemEval2020五项子任务上夺冠。

- 2019.12.26 GLUE榜第一名。

- 2019.11.6 发布ERNIE Tiny。

- 2019.7.7 发布ERNIE 2.0。

- 2019.3.16 发布ERNIE 1.0。

2.1 ERNIE3.0

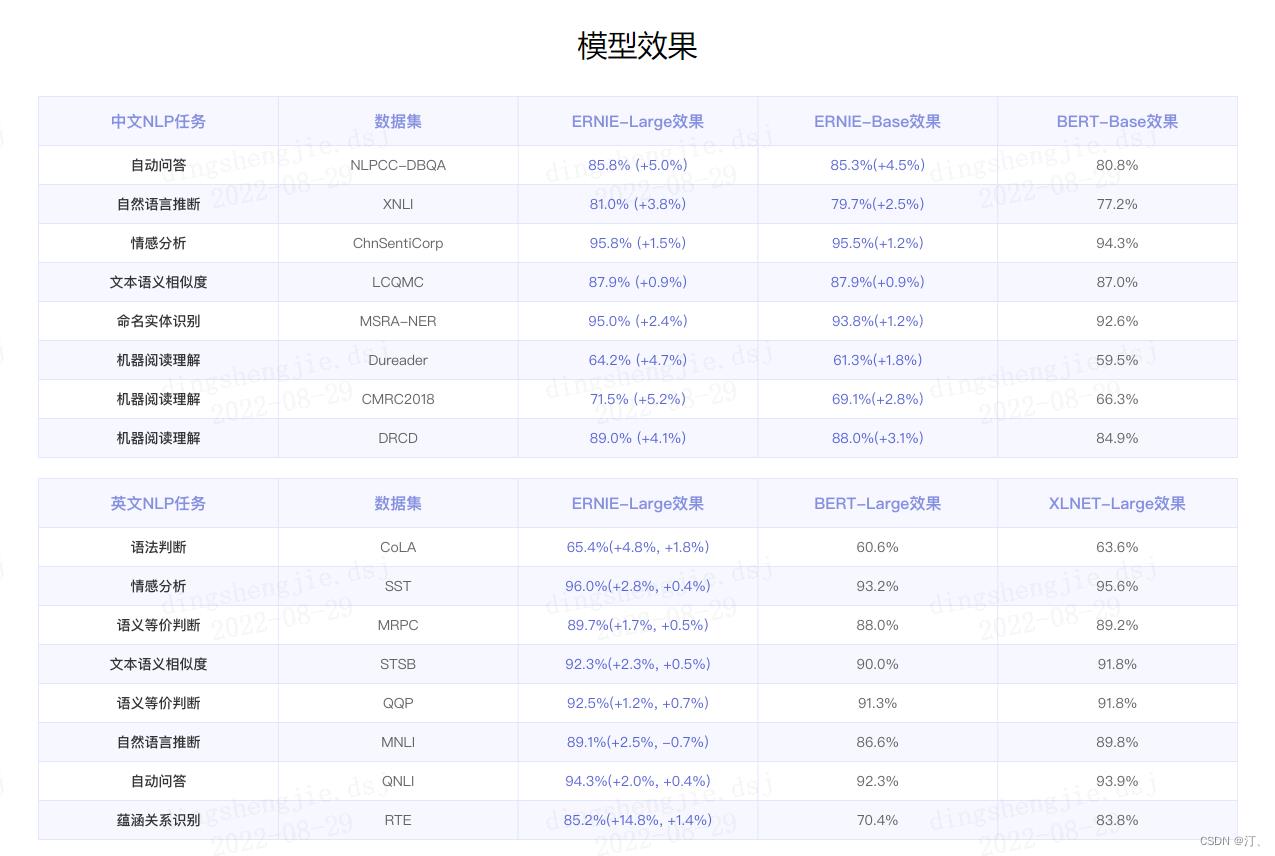

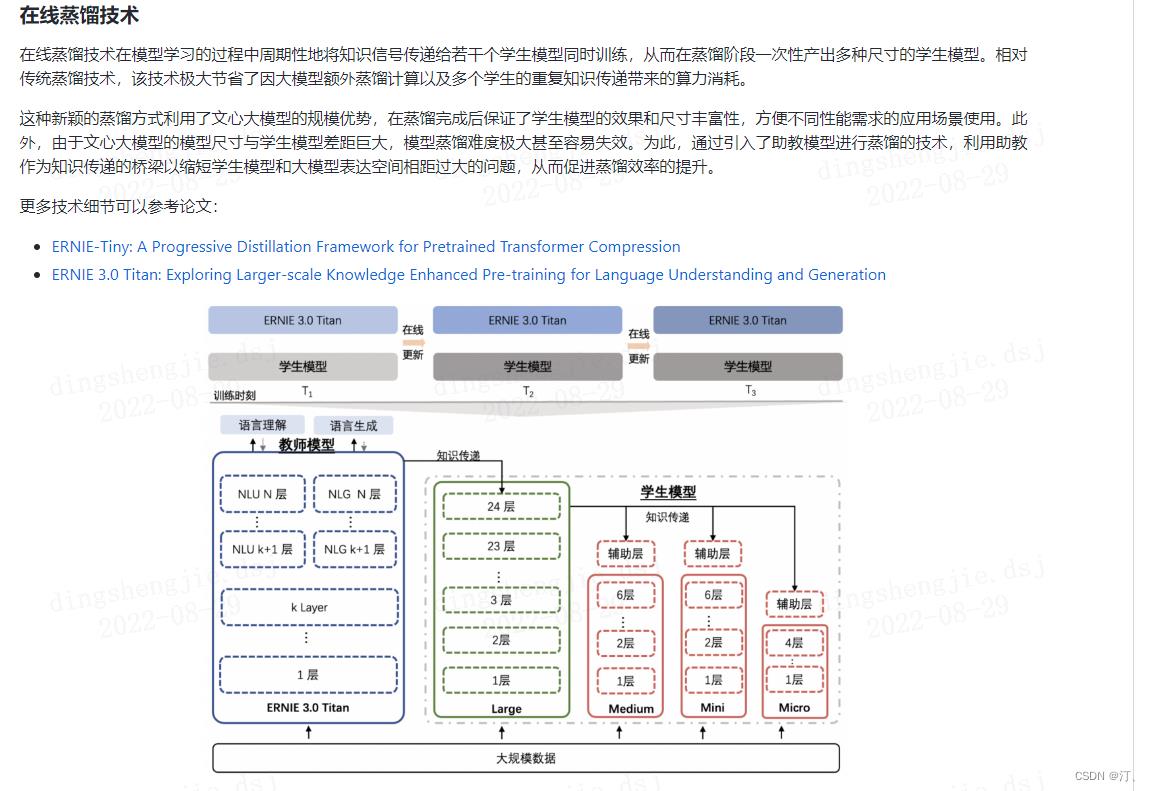

文心大模型ERNIE 3.0 基础上通过在线蒸馏技术得到的轻量级模型,模型结构与 ERNIE 2.0 保持一致,相比 ERNIE 2.0 具有更强的中文效果。

本项目开源 ERNIE 3.0 Base 、ERNIE 3.0 Medium 、 ERNIE 3.0 Mini 、 ERNIE 3.0 Micro 、 ERNIE 3.0 Nano 五个模型:

- ERNIE 3.0-Base (12-layer, 768-hidden, 12-heads)

- ERNIE 3.0-Medium (6-layer, 768-hidden, 12-heads)

- ERNIE 3.0-Mini (6-layer, 384-hidden, 12-heads)

- ERNIE 3.0-Micro (4-layer, 384-hidden, 12-heads)

- ERNIE 3.0-Nano (4-layer, 312-hidden, 12-heads)

2.2 ERNIE模型汇总

下表汇总介绍了目前PaddleNLP支持的ERNIE模型对应预训练权重

| Pretrained Weight | Language | Details of the model |

|---|---|---|

ernie-1.0-base-zh | Chinese | 12-layer, 768-hidden, 12-heads, 108M parameters. Trained on Chinese text. |

ernie-tiny | Chinese | 3-layer, 1024-hidden, 16-heads, _M parameters. Trained on Chinese text. |

ernie-2.0-base-en | English | 12-layer, 768-hidden, 12-heads, 103M parameters. Trained on lower-cased English text. |

ernie-2.0-base-en-finetuned-squad | English | 12-layer, 768-hidden, 12-heads, 110M parameters. Trained on finetuned squad text. |

ernie-2.0-large-en | English | 24-layer, 1024-hidden, 16-heads, 336M parameters. Trained on lower-cased English text. |

ernie-3.0-base-zh | Chinese | 12-layer, 768-hidden, 12-heads, 118M parameters. Trained on Chinese text. |

ernie-3.0-medium-zh | Chinese | 6-layer, 768-hidden, 12-heads, 75M parameters. Trained on Chinese text. |

ernie-3.0-mini-zh | Chinese | 6-layer, 384-hidden, 12-heads, 27M parameters. Trained on Chinese text. |

ernie-3.0-micro-zh | Chinese | 4-layer, 384-hidden, 12-heads, 23M parameters. Trained on Chinese text. |

ernie-3.0-nano-zh | Chinese | 4-layer, 312-hidden, 12-heads, 18M parameters. Trained on Chinese text. |

rocketqa-base-cross-encoder | Chinese | 12-layer, 768-hidden, 12-heads, 118M parameters. Trained on DuReader retrieval text. |

rocketqa-medium-cross-encoder | Chinese | 6-layer, 768-hidden, 12-heads, 75M parameters. Trained on DuReader retrieval text. |

rocketqa-mini-cross-encoder | Chinese | 6-layer, 384-hidden, 12-heads, 27M parameters. Trained on DuReader retrieval text. |

3.PaddleSlim

PaddleSlim是一个专注于深度学习模型压缩的工具库,提供低比特量化、知识蒸馏、稀疏化和模型结构搜索等模型压缩策略,帮助开发者快速实现模型的小型化。

-

2022.08.16:自动化压缩功能升级

- 支持直接加载ONNX模型和Paddle模型导出至ONNX

- 发布量化分析工具试用版,发布YOLO系列离线量化工具

- 更新YOLO-Series自动化压缩模型库

模型 Base mAPval

0.5:0.95ACT量化mAPval

0.5:0.95模型体积压缩比 预测时延FP32 预测时延INT8 预测加速比 PPYOLOE-s 43.1 42.6 3.9倍 6.51ms 2.12ms 3.1倍 YOLOv5s 37.4 36.9 3.8倍 5.95ms 1.87ms 3.2倍 YOLOv6s 42.4 41.3 3.9倍 9.06ms 1.83ms 5.0倍 YOLOv7 51.1 50.9 3.9倍 26.84ms 4.55ms 5.9倍 YOLOv7-Tiny 37.3 37.0 3.9倍 5.06ms 1.68ms 3.0倍 -

🔥 2022.07.01: 发布v2.3.0版本

- 发布自动化压缩功能

- 升级量化功能

- 统一量化模型格式;离线量化支持while op;修复BERT大模型量化训练过慢的问题。

- 新增7种离线量化方法, 包括HIST, AVG, EMD, Bias Correction, AdaRound等。

- 支持半结构化稀疏训练

- 新增延时预估工具

- 支持对稀疏化模型、低比特量化模型的性能预估;支持预估指定模型在特定部署环境下 (ARM CPU + Paddle Lite) 的推理性能;提供 SD625、SD710、RK3288 芯片 + Paddle Lite 的预估接口。

- 提供部署环境自动扩展工具,可以自动增加在更多 ARM CPU 设备上的预估工具。

-

2021.11.15: 发布v2.2.0版本

- 支持动态图离线量化功能.

-

2021.5.20: 发布V2.1.0版本

- 扩展离线量化方法

- 新增非结构化稀疏

- 增强剪枝功能

- 修复OFA功能若干bug

以上是关于百度飞桨各个库版本记录!的主要内容,如果未能解决你的问题,请参考以下文章