网络爬虫:中国大学排名定向爬虫

Posted 宅家的小魏

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了网络爬虫:中国大学排名定向爬虫相关的知识,希望对你有一定的参考价值。

中国大学排名定向爬虫

Copyright: Jingmin Wei, Pattern Recognition and Intelligent System, School of Artificial and Intelligence, Huazhong University of Science and Technology

文章目录

本教程主要参考中国大学慕课的 Python 网络爬虫与信息提取,为个人学习笔记。

在学习过程中遇到了一些问题,都手动记录并且修改更正,保证所有的代码为有效。且结合其他的博客总结了一些常见问题的解决方式。

本教程不商用,仅为学习参考使用。如需转载,请联系本人。

Reference

功能描述

输入:大学排名URL链接

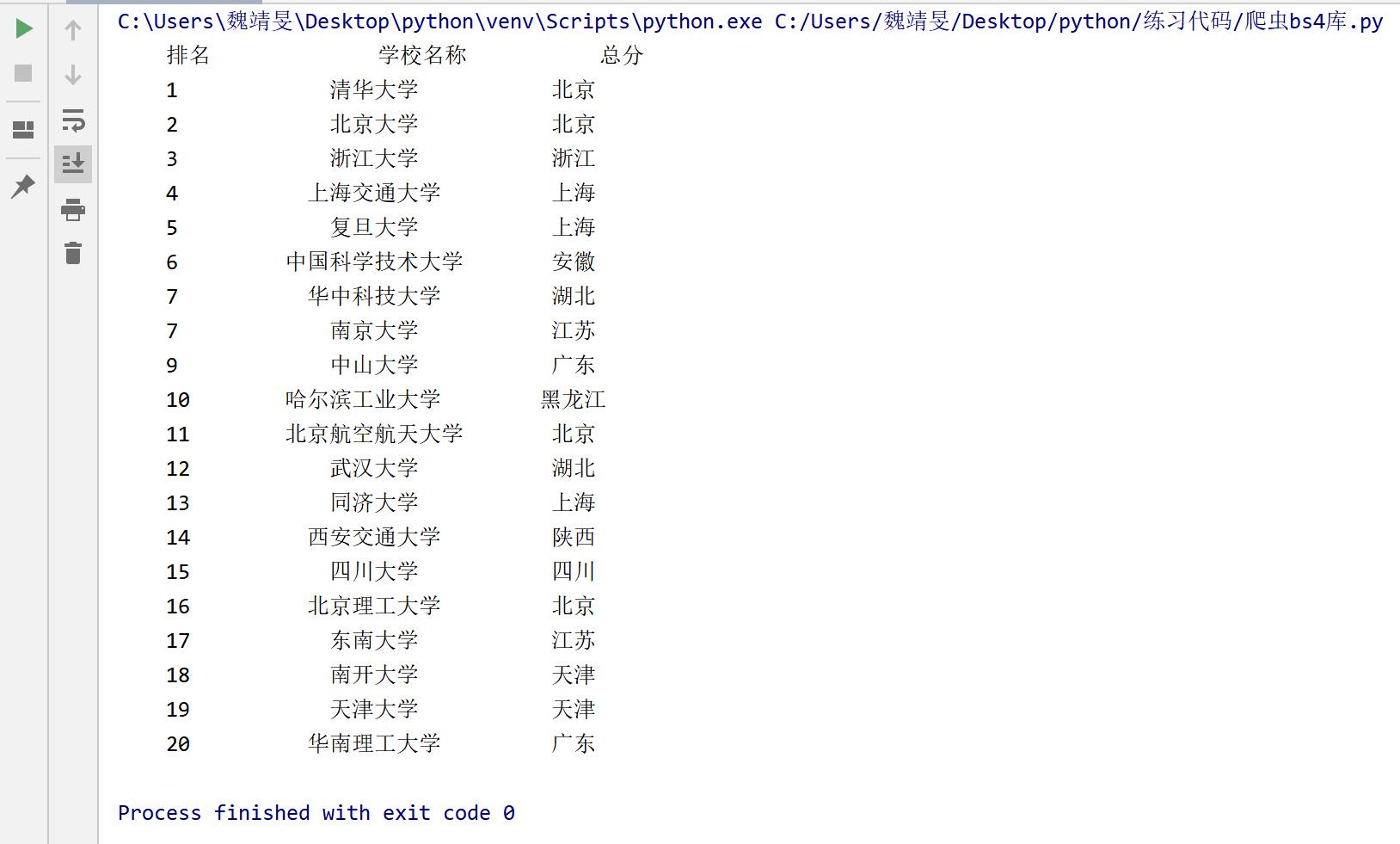

输出:大学排名信息的屏幕输出(排名,大学名称,总分)

技术路线:requests‐bs4

定向爬虫:仅对输入 URL 进行爬取,不扩展爬取

定向爬虫可行性

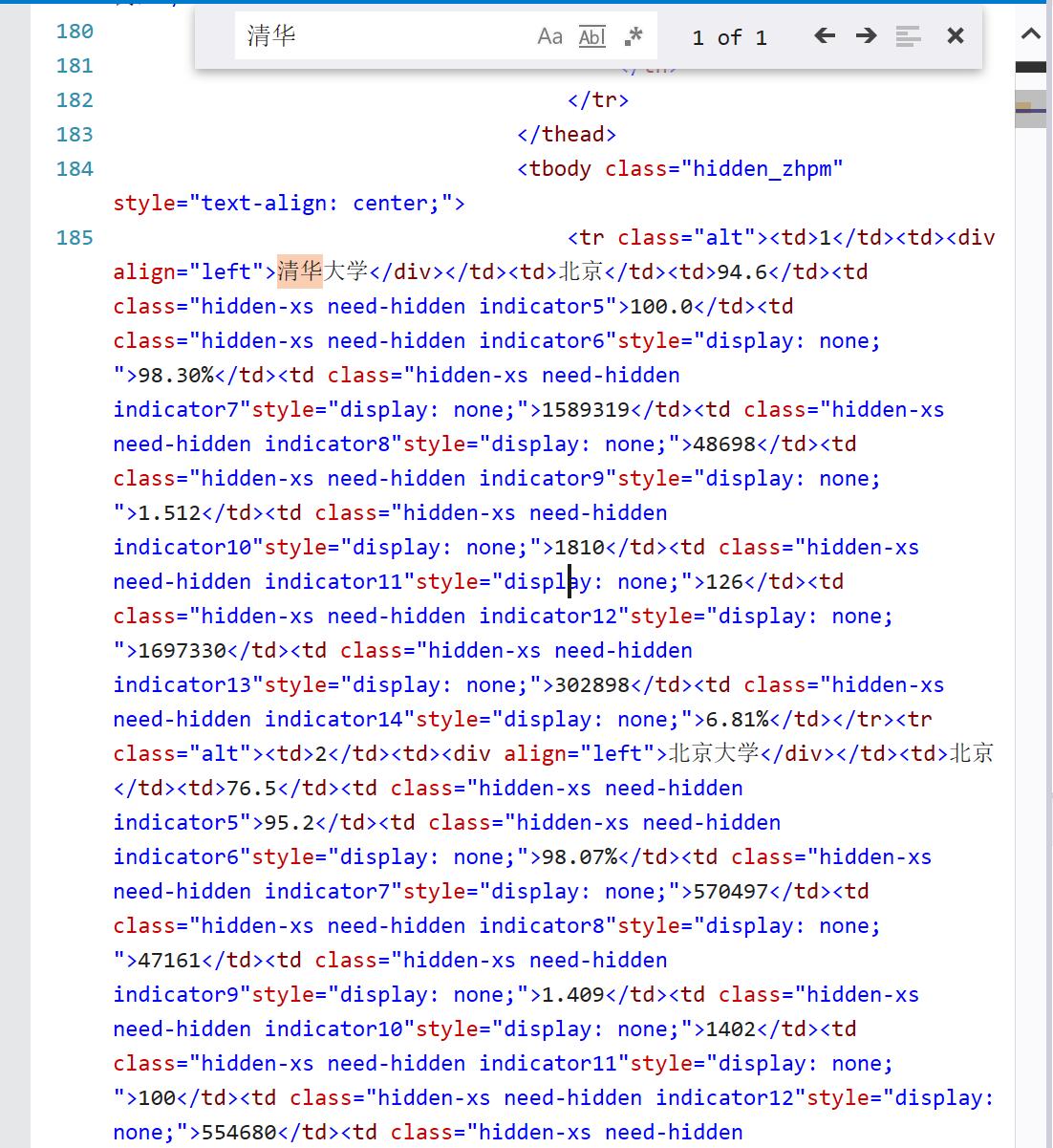

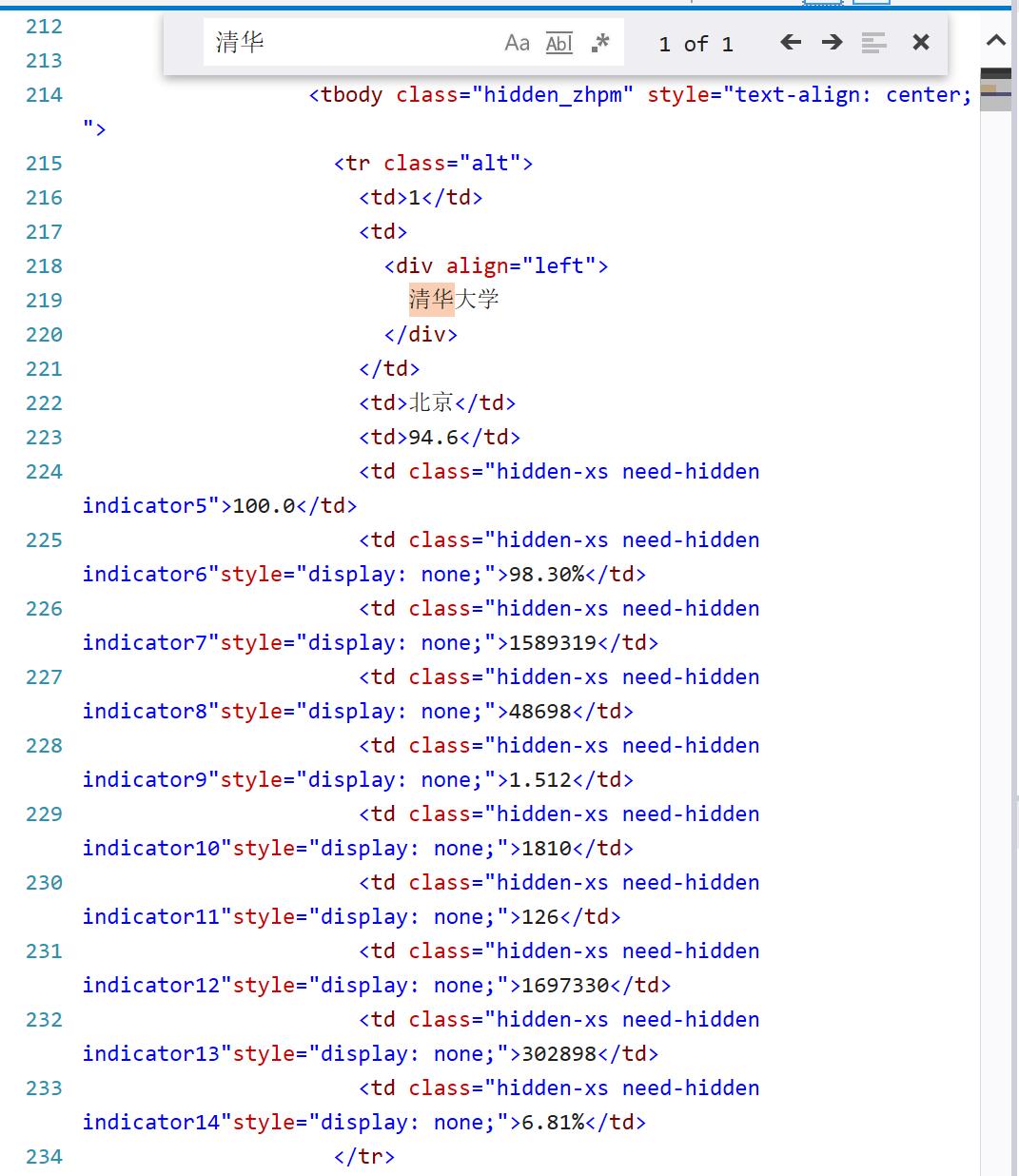

1.确定要爬取的信息是否写在 html 的页面代码中

http://www.zuihaodaxue.cn/zuihaodaxuepaiming2019.html

2.没有 robots 协议,即没有爬虫的限制

程序的结构设计

步骤1:从网络上获取大学排名网页内容 getHTMLText()

步骤2:提取网页内容中信息到合适的数据结构 fillUnivList()

步骤3:利用数据结构展示并输出结果 printUnivList()

程序编写

先使用异常处理形式爬取网站,修改编码并返回 url 的内容。(requests)

然后找到 tbody 标签,在tbody孩子标签中挨个检索 tr(for循环),如果类型和 tag 一致,则查找 tr 中的 td 标签,以二维列表的数据结构存储信息 [[“1”, “清华大学”, “北京”], [“2”, “北京大学”, “北京”], …]。(BeautifulSoup)

最后格式化输出信息。

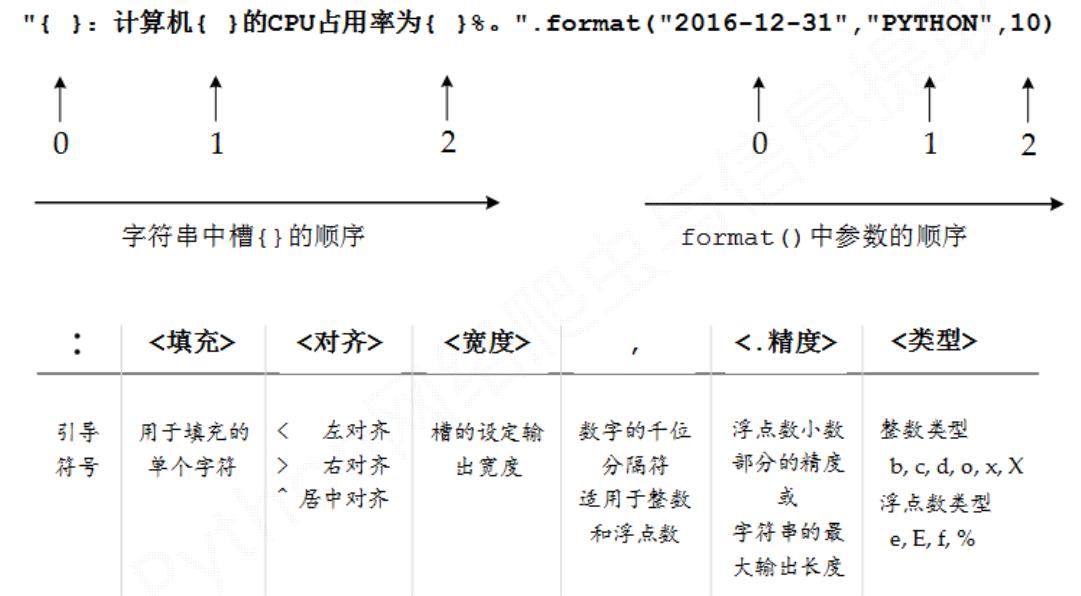

格式化输出回顾:

源代码

import requests

from bs4 import BeautifulSoup

import bs4

def getHTMLText(url):

try:

r = requests.get(url, timeout=30)

r.raise_for_status()

r.encoding = r.apparent_encoding

return r.text

except:

return ""

def fillUnivList(ulist, html):

soup = BeautifulSoup(html, "html.parser")

for tr in soup.find('tbody').children: #先检索到tbody标签

if isinstance(tr, bs4.element.Tag):

tds = tr('td') #查询tr中的td标签,等价于tr.find_all('td')

ulist.append([tds[0].string, tds[1].string, tds[3].string]) #使用二维列表存储信息

def printUnivList(ulist, num):

print(":^10\\t:^6\\t:^10".format("排名","学校名称","总分")) #取10/6/10位中间对齐

for i in range(num):

u = ulist[i]

print(":^10\\t:^6\\t:^10".format(u[0], u[1], u[3]))

def main():

uinfo = []

url = "http://www.zuihaodaxue.cn/zuihaodaxuepaiming2019.html"

html = getHTMLText(url)

fillUnivList(uinfo, html)

printUnivList(uinfo, 20) # 20 univ

main()

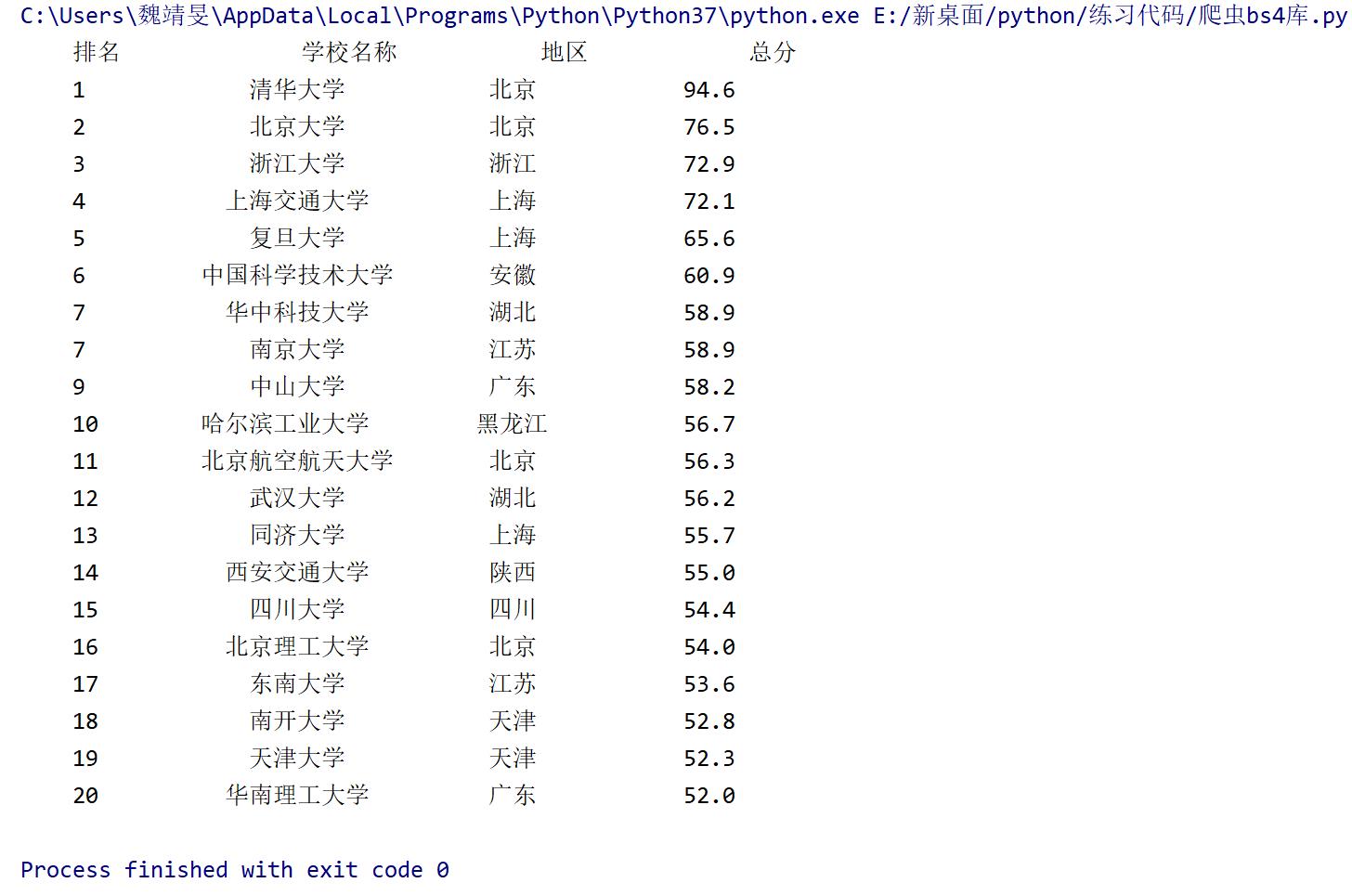

程序优化

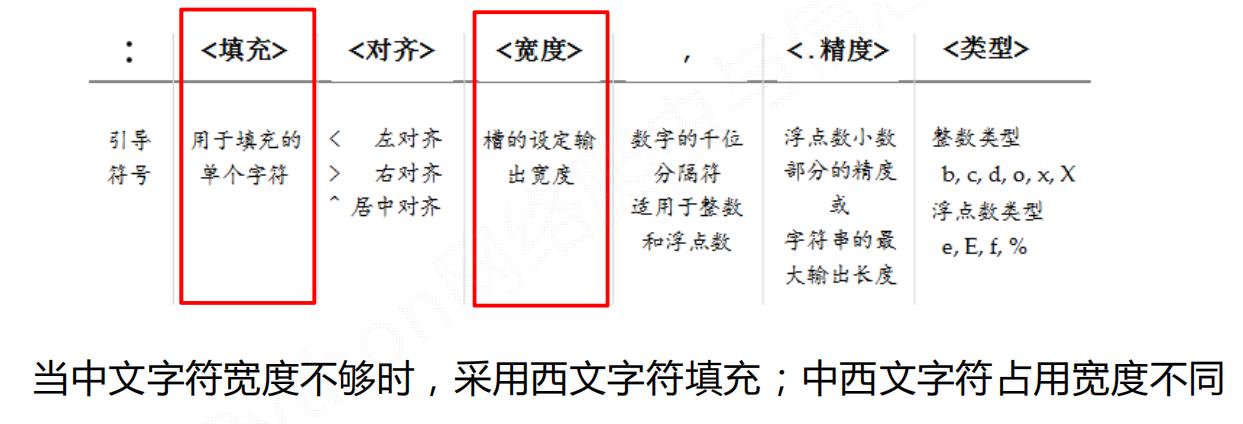

中文对齐问题的原因:

当中文字符宽度不够时,采用西文字符填充;中西文字符占用宽度不同。

中文对齐问题的解决:

采用中文字符的空格填充 chr(12288)

def printUnivList(ulist, num):

tplt = "0:^10\\t1:3^10\\t2:^10"

# 3表示需要填充时使用format的第三个变量进行填充,即使用中文空格

print(tplt.format("排名", "学校名称", "总分", chr(12288)))

for i in range(num):

u = ulist[i]

print(tplt.format(u[0], u[1], u[3], chr(12288)))

优化后的程序如下:

# -*- coding:utf-8 -*-

import requests

from bs4 import BeautifulSoup

import bs4

def getHTMLText(url):

try:

r = requests.get(url, timeout=30)

r.raise_for_status()

r.encoding = r.apparent_encoding

return r.text

except:

return ""

def fillUnivList(ulist, html):

soup = BeautifulSoup(html, "html.parser")

for tr in soup.find('tbody').children: # 先检索到tbody标签

if isinstance(tr, bs4.element.Tag):

tds = tr('td') # 查询tr中的td标签,等价于tr.find_all('td')

ulist.append([tds[0].string, tds[1].string, tds[2].string, tds[3].string]) # 使用二维列表存储信息

def printUnivList(ulist, num):

tplt = "0:^10\\t1:4^10\\t2:^10\\t3:^10"

# 3表示需要填充时使用format的第三个变量进行填充,即使用中文空格

print(tplt.format("排名", "学校名称", "地区", "总分", chr(12288)))

for i in range(num):

u = ulist[i]

print(tplt.format(u[0], u[1], u[2], u[3], chr(12288)))

def main():

uinfo = []

url = "http://www.zuihaodaxue.cn/zuihaodaxuepaiming2019.html"

html = getHTMLText(url)

fillUnivList(uinfo, html)

printUnivList(uinfo, 20) # 20 univ

if __name__ == "__main__":

main()

总结

采用 requests‐bs4 路线实现了中国大学排名定向爬虫

对中英文混排输出问题进行优化

以上是关于网络爬虫:中国大学排名定向爬虫的主要内容,如果未能解决你的问题,请参考以下文章