pytorh 自动求梯度

Posted 东东就是我

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了pytorh 自动求梯度相关的知识,希望对你有一定的参考价值。

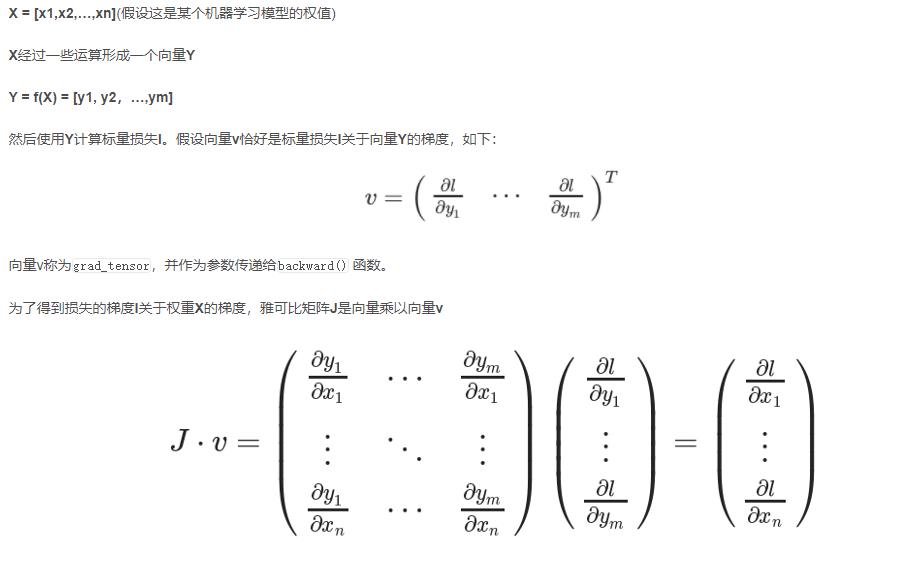

1. 雅可比

https://blog.csdn.net/u011984148/article/details/99670194

为什么使用雅可比

求出每个y=f(x) 的偏导数 ,乘以损失函数对y的偏导数,就是损失函数对每个x的偏导数。

自动求梯度的原理就是链式求导

在pytorch中怎么链式求导呢,下面都是我的假设,根据图中设置参数

import torch

input=torch.tensor(10,)

x1=torch.tensor(10.,requires_grad=True)

x2=torch.tensor(20.,requires_grad=True)

x3=torch.tensor(30.,requires_grad=True)

x=[x1,x2,x3]

y1=x1*input

y2=y1+x2

y3=y2*x3.exp()

y=[y1,y2,y3]

label=1

l=torch.mean(y3-label) #l=(y3-label)/1

l.backward()

print(x1.grad)

print(x2.grad)

print(x3.grad)

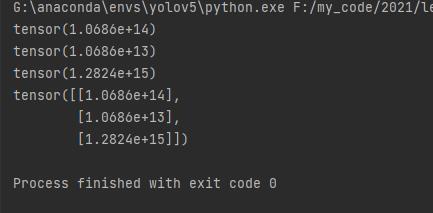

#向量v称为grad_tensor,并作为参数传递给backward() 函数。就是l对y3的导数

#v=[l/y1,l/y2,l/y3]

z1=torch.exp(x3)

v=torch.tensor([[z1,z1,1]]).t()

#计算雅可比[[y1/x1,y2/x1,y3/x1],[y1/x2,y2/x2,y3/x2],[y1/x3,y2/x3,y3/x3]] 偏导

j=torch.tensor([[input,0,0],[0,1,0],[0,0,y3]])

jvp=j.mm(v)

print(jvp)

可以看到结果一模一样

所以 ,知道在叶子节点保存相应的偏导数,然后和loss梯度相乘,就可以得到loss下的每个权重的偏导数

以上是关于pytorh 自动求梯度的主要内容,如果未能解决你的问题,请参考以下文章