Linux安装配置ELK日志收集系统,elasticsearch+kibana+filebeat轻量级配置安装

Posted the丶only

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Linux安装配置ELK日志收集系统,elasticsearch+kibana+filebeat轻量级配置安装相关的知识,希望对你有一定的参考价值。

一:ELK简介

ELK是三个开源软件的缩写,分别表示:Elasticsearch , Logstash, Kibana , 它们都是开源软件。新增了一个FileBeat,它是一个轻量级的日志收集处理工具(Agent),Filebeat占用资源少,适合于在各个服务器上搜集日志后传输给Logstash,官方也推荐此工具。

Elasticsearch是个开源分布式搜索引擎,提供搜集、分析、存储数据三大功能。它的特点有:分布式,零配置,自动发现,索引自动分片,索引副本机制,restful风格接口,多数据源,自动搜索负载等。

Logstash 主要是用来日志的搜集、分析、过滤日志的工具,支持大量的数据获取方式。一般工作方式为c/s架构,client端安装在需要收集日志的主机上,server端负责将收到的各节点日志进行过滤、修改等操作在一并发往elasticsearch上去。

Kibana 也是一个开源和免费的工具,Kibana可以为 Logstash 和 ElasticSearch 提供的日志分析友好的 Web 界面,可以帮助汇总、分析和搜索重要数据日志。

Filebeat隶属于Beats。目前Beats包含四种工具:

- Packetbeat(搜集网络流量数据)

- Topbeat(搜集系统、进程和文件系统级别的 CPU 和内存使用情况等数据)

- Filebeat(搜集文件数据)

- Winlogbeat(搜集 Windows 事件日志数据)

官方文档:https://www.elastic.co/guide/index.html

官方安装文档:https://www.elastic.co/guide/en/elastic-stack/current/installing-elastic-stack.html

二:ELK安装

官方提供多种安装方式,有压缩包安装,源仓库在线安装,docker安装等。

这里直接用源仓库在线安装,选择自己系统版本,这里是ubuntu版本。

根据官方文档安装:https://www.elastic.co/guide/en/elasticsearch/reference/7.16/deb.html

1:下载并安装公共签名密钥

wget -qO - https://artifacts.elastic.co/GPG-KEY-elasticsearch | sudo apt-key add -

2:安装apt-transport-https扩展包

sudo apt-get install apt-transport-https

3:保存仓库源

echo "deb https://artifacts.elastic.co/packages/7.x/apt stable main" | sudo tee -a /etc/apt/sources.list.d/elastic-7.x.list

4:更新后安装

所有软件公用一个仓库源,添加后,可在线安装所有最新版软件,根据自己架构选择软件,我只需要简单的nginx日志收集,所以选择elasticsearch,kibana,filebeat(轻量级)三个软件即可。

filebeat直接采集日志到elasticsearch即可,不需要Logstash采集和通过Logstash 传送至elasticsearch。所以不需要安装Logstash。

#1:安装elasticsearch

sudo apt-get update && sudo apt-get install elasticsearch

#2:安装kibana

sudo apt-get install kibana

#3:安装filebeat(在需要采集日志的客户端安装)

sudo apt-get install filebeat

5:设置开机启动

#分别设置elasticsearch/filebeat/kibana

sudo systemctl enable elasticsearch

三:ELK配置

1:elasticsearch配置文件

编辑配置文件

sudo vim /etc/elasticsearch/elasticsearch.yml

配置文件都挺全,取消注释即可,必备的配置选项

# ------------------------------------ Node ------------------------------------

node.name: node-1

# ----------------------------------- Paths ------------------------------------

path.data: /var/lib/elasticsearch

path.logs: /var/log/elasticsearch

# ---------------------------------- Network -----------------------------------

network.host: 0.0.0.0

http.port: 9200

# --------------------------------- Discovery ----------------------------------

cluster.initial_master_nodes: ["node-1"]

# ---------------------------------- Security ----------------------------------

xpack.security.enabled: true

xpack.license.self_generated.type: basic

xpack.security.transport.ssl.enabled: true

配置文件说明:

Paths路径默认即可,无需更改。

Network监听地址,默认只监听本地127.0.0.1,如果需要所有地方可监听访问,改为0.0.0.0。端口默认9200。

由于改了监听地址,启动会报错,需要配置node.name: node-1和cluster.initial_master_nodes: ["node-1"]两个选项,启动正常。

Security选项,如果配置kibana,许多功能,需要基本的安全策略才可以使用,这里配置基本密码安全策略。

初始化密码:

找到安装目录,我在线安装目录为/usr/share/elasticsearch,如不知道,可用命令whereis查询。

cd /usr/share/elasticsearch

执行命令

bin/elasticsearch-setup-passwords interactive

执行后,选择y(yes),选择分别设置elastic(超级管理员),kibana_system,logstash_system,beats_system,apm_system,remote_monitoring_user等用户的密码。这里设置所有为123456

配置完成,在浏览器输入地址端口,然后输入账号elastic,密码123456。可得到返回值,说明正常。

2:kibana配置文件

编辑配置文件

sudo vim /etc/kibana/kibana.yml

基础配置选项

# 默认端口

server.port: 5601

# 默认监听地址,访问地址,改为所有地方可访问

server.host: "0.0.0.0"

# 公共访问地址

server.publicBaseUrl: "http://192.168.152.100:5601"

# 服务名称

server.name: "kibana"

# 连接elasticsearch地址

elasticsearch.hosts: ["http://192.168.152.100:9200"]

# dashboards. Kibana creates a new index if the index doesn't already exist.

kibana.index: ".kibana"

# 连接elasticsearch账号密码,上面自己设置的密码

elasticsearch.username: "elastic"

elasticsearch.password: "123456"

# Supported languages are the following: English - en , by default , Chinese - zh-CN .

# 设置中文

i18n.locale: "zh-CN"

3:filebeat配置文件

编辑配置文件

sudo vim /etc/kibana/filebeat.yml

需要更改的配置内容,其他默认即可。

filebeat.inputs:

- type: filestream

# Change to true to enable this input configuration.

# 配置是否生效,false改为true

enabled: true

# Paths that should be crawled and fetched. Glob based paths.

# 指定要监控的日志,可以指定具体得文件或者目录

paths:

- /var/log/*.log

# =================================== Kibana ===================================

setup.kibana:

# kibana主机地址

host: "192.168.152.100:5601"

# ---------------------------- Elasticsearch Output ----------------------------

output.elasticsearch:

# Array of hosts to connect to.

# elasti地址

hosts: ["192.168.152.100:9200"]

# elasti账号密码

username: "elastic"

password: "123456"

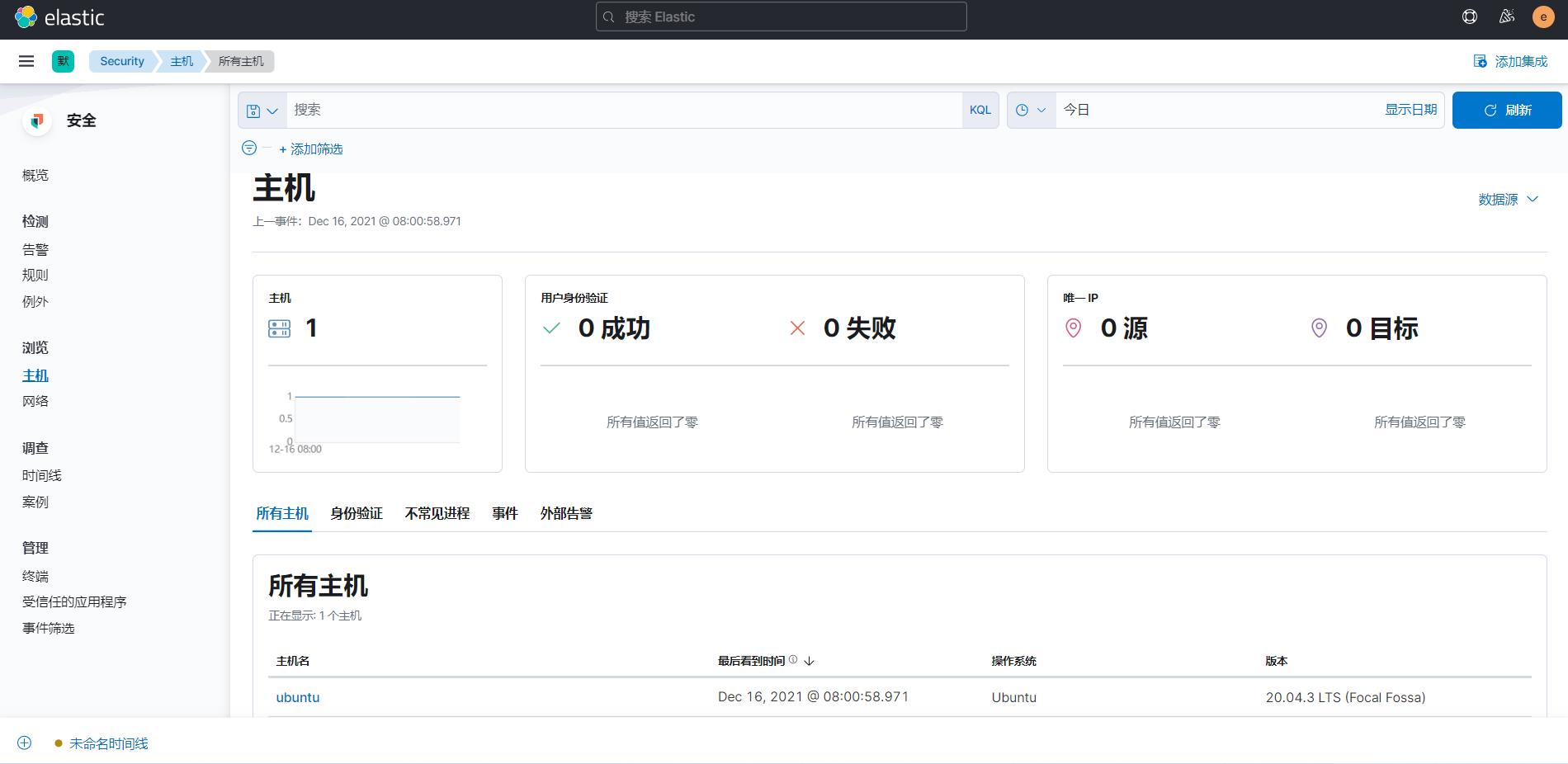

三:登录kibana,查看索引节点

浏览器输入kibana配置的地址加上5601端口,我这里为 http://192.168.152.100:5601,输入密码。

查看客户端的filebeat是否添加成功,在栈堆检测中,可查看已添加成功的节点和索引

添加的filebeat客户端索引默认格式为:filebeat-7.16.0-2021.12.14-000001

添加成功后,在主机也可以查看到主机,或者在日志中,查看实时日志数据。

安装完成。

以上是关于Linux安装配置ELK日志收集系统,elasticsearch+kibana+filebeat轻量级配置安装的主要内容,如果未能解决你的问题,请参考以下文章

Linux ELK日志分析系统 | logstash日志收集 | elasticsearch 搜索引擎 | kibana 可视化平台 | 架构搭建 | 超详细