二分类的评价指标总结

Posted AI浩

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了二分类的评价指标总结相关的知识,希望对你有一定的参考价值。

混淆矩阵

| 真实值 1 | 真实值0 | |

|---|---|---|

| 预测值 1 | 真正例 TP | 伪正例 FP |

| 预测值 0 | 伪反例 FN | 真反例TN |

ACC:classification accuracy,描述分类器的分类准确率

计算公式为:ACC=(TP+TN)/(TP+FP+FN+TN)

BER:balanced error rate

计算公式为:BER=1/2*(FPR+FN/(FN+TP))

TPR:true positive rate,描述识别出的所有正例占所有正例的比例

计算公式为:TPR=TP/ (TP+ FN)

FPR:false positive rate,描述将负例识别为正例的情况占所有负例的比例

计算公式为:FPR= FP / (FP + TN)

TNR:true negative rate,描述识别出的负例占所有负例的比例

计算公式为:TNR= TN / (FP + TN)

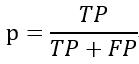

PPV:Positive predictive value

计算公式为:PPV=TP / (TP + FP)

NPV:Negative predictive value

计算公式:NPV=TN / (FN + TN)

其中TPR即为敏感度(sensitivity),TNR即为特异度(specificity)。

TPR 与 FPR详细说明

真正例率 TPR = TP / (TP + FN)

表示,预测为正例且真实情况为正例的,占所有真实情况中正例的比率。

假正例率 FPR = FP / (TN + FP)

表示,预测为正例但真实情况为反例的,占所有真实情况中反例的比率。

TPR越大,则表示挑出的越有可能(是正确的);FPR越大,则表示越不可能(在挑选过程中,再挑新的出来,即再挑认为是正确的出来,越有可能挑的是错误的)。

TPR 与 FPR 呈反相关,随着采样的继续越不可能是正例的被采样出来,TPR降低,FPR升高。

查准率/正确率(precision)

查准率(precision),指的是预测值为1且真实值也为1的样本在预测值为1的所有样本中所占的比例。

召回率(recall)

召回率(recall),也叫查全率,指的是预测值为1且真实值也为1的样本在真实值为1的所有样本中所占的比例。所有的好西瓜中有多少比例被算法挑了出来。

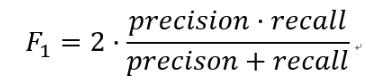

F1-Score

F1分数(F1 Score),是统计学中用来衡量二分类(或多任务二分类)模型精确度的一种指标。它同时兼顾了分类模型的准确率和召回率。F1分数可以看作是模型准确率和召回率的一种加权平均,它的最大值是1,最小值是0,值越大意味着模型越好。

F1分数(F1-Score),又称为平衡F分数(BalancedScore),它被定义为精确率和召回率的调和平均数。

在这里插入图片描述

一些指标的代码实现:

def perf_measure(y_true, y_pred):

TP, FP, TN, FN = 0, 0, 0, 0

for i in range(len(y_true)):

if y_true[i] == 1 and y_pred[i] == 1:

TP += 1

if y_true[i] == 0 and y_pred[i] == 1:

FP += 1

if y_true[i] == 0 and y_pred[i] == 0:

TN += 1

if y_true[i] == 1 and y_pred[i] == 0:

FN += 1

return TP, FP, TN, FN

# Compute confusion matrix

TP, FP, TN, FN = perf_measure(test_y, output_2)

print(TP, FP, TN, FN)

# Sensitivity, hit rate, recall, or true positive rate

TPR = TP / (TP + FN)

# Specificity or true negative rate

TNR = TN / (TN + FP)

# Precision or positive predictive value

PPV = TP / (TP + FP)

# Negative predictive value

NPV = TN / (TN + FN)

# Fall out or false positive rate

FPR = FP / (FP + TN)

# False negative rate

FNR = FN / (TP + FN)

# False discovery rate

FDR = FP / (TP + FP)

precision = TP / (TP + FP) # 查准率

recall = TP / (TP + FN) # 查全率

print(TPR, TNR, PPV, NPV, FPR, FNR, FDR, precision, recall)

以上是关于二分类的评价指标总结的主要内容,如果未能解决你的问题,请参考以下文章