Introspective Distillation for Robust Question Answering 论文笔记

Posted 乄洛尘

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Introspective Distillation for Robust Question Answering 论文笔记相关的知识,希望对你有一定的参考价值。

Introspective Distillation for Robust Question Answering 论文笔记

- 一、Abstract

- 二、引言

- 三、Related work

- 四、内省蒸馏

- 五、Experiments

- 5.1 Visual QA

- 5.1.1 数据集

- 5.1.2 Metric and setting

- 5.1.3 Methods

- 5.1.4 Overall results

- 5.1.5 Ablation studies

- Can we use the predicted probability of the ground-truth answer (“Prob.” for short) as the matching scores? Better not.

- Can the student learn more from the more accurate teacher, i.e. w ∝ s w\\proptos w∝s?No.

- Can the student equally learn from ID and OOD teachers, i.e. w I D = w O O D = 0.5 w^ID=w^OOD=0.5 wID=wOOD=0.5? No.

- Can the student only learn from OOD-teacher? Yes, but worse than IntroD.

- Should we use the hard or soft variant to calculate the knowledge weights? It depends on the debiasing ability of the causal teacher.

- Can we use the ID-Prediction P I D \\textID-Prediction P^ID ID-PredictionPID as the ID-Knowledge \\textID-Knowledge ID-Knowledge? No.

- Can we ensemble the two teacher models and directly use that without distillation? In other words, is IntroD just an ensemble method? No.

- 5.2 Extractive QA

- 六、Conclusion

- 附录

写在前面

这是一篇关于VQA de-bias的文章,出自获得2021年的CCF优秀博士论文之一的牛玉磊大神。之前有一篇CF-VQA也是这位大佬的工作。本文看问题角度与其他方法不一样,结合了知识蒸馏的部分,不知道咋想出来的?

- 论文地址:Introspective Distillation for Robust Question Answering

- 代码地址:Github,开源了但没完全开~

- 收录于:NeurIPS 2021

一、Abstract

开始点出语言bia普遍存在于QA模型中,引出本文的VQA和阅读理解任务。接着指出现有的de-bias的方法精度高的原因:提前知道了测试集数据的分布,换句话说,能够利用测试集的bias。本文提出一种新颖的de-bias方法——IntroD,能够在这两种任务中发挥出最大的作用。本文主要贡献在于通过introspecting内省是否训练样本符合ID的事实或者OOD的事实,从而融合ID和OOD的bias。实验在VQAv2,CPv2,SQuAD数据集进行,在牺牲少量精度的情况下,能够维持OOD的性能,甚至超过了之前的那些no-bias方法。

二、引言

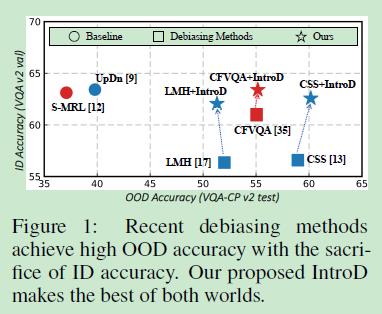

引入问答的基础概念→模型利用数据集中的bias→在out-of-distribution(OOD)的数据分布中性能下降→本文认为虽然有一些方法提升了ID和OOD的性能,但是源于大部分的模型都存在假设:训练和测试分布非常不同甚至完全相反,所以模型可能在ID内面临严重的性能下降?能解释通吗?理论上可以,因为这些方法降低了原来模型在ID内的性能。这就引出本文的主题了,能够使得模型同时在ID和OOD分布上的精度都很高吗?下图为作者给出的证据:

接下来突出本文的核心,建立一个鲁棒性的模型能够同时在ID和OOD上保持足够的精度。而这一点使得作者认为模型需要公平的利用这两种分布的bias。因此,作者提出introD来融合/混合这两种bias。

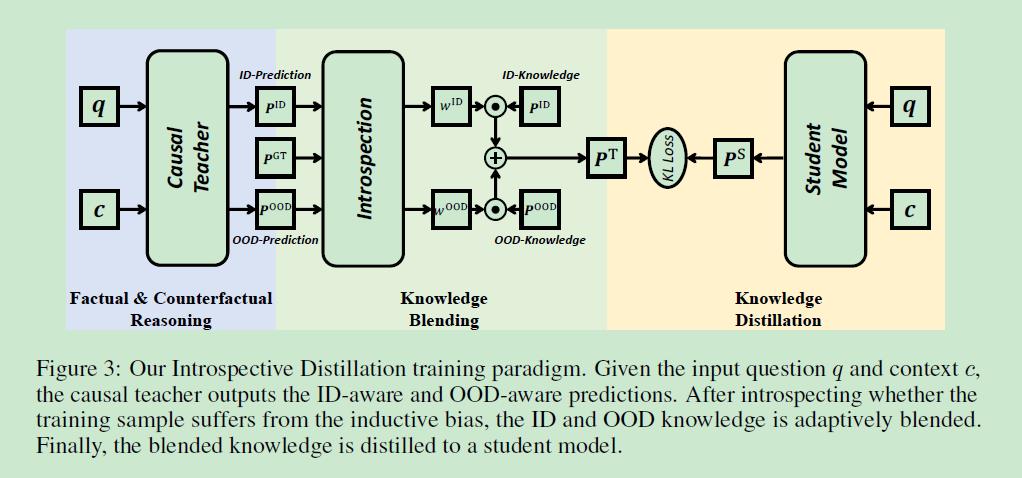

综的框架:两种专家模型:ID-教师,OOD-教师,每一个教师负责捕捉相应的bias,再蒸馏出一个内省学术来学习这两类教师,而这存在三种情况:

- 如果ID-bias > OOD-bias, 那么 ID-teacher < OOD-teacher,即ID教师过拟合,所以学生需要从OOD教师中学到更多。

这种情况存在于ID教师的损失<OOD教师的损失时,即上图a所示。 - 如果ID-bias < OOD-bias, 那么 ID-teacher > OOD-teacher,即OOD教师过拟合,所以学生需要从ID教师中学到更多。

这种情况存在于ID教师的损失<OOD教师的损失时,即上图c所示。 - 如果ID-bias ≈ OOD-bias, 那么 ID-teacher ≈ OOD-teacher,即两个教师正常拟合,所以学生需要同等地学习两位教师。

这种情况存在于ID教师的损失≈ OOD教师的损失时,即上图b所示。

接下来就是讲的蒸馏了,在这部分之前,主要问题就是教师模型的获得,特别是OOD的教师,因为OOD分布在训练过程中不可视。然后作者也是用了自己之前发表的文章内容,即反事实VQA,CF-VQA。根据因果模型来进行反事实推理,从而想象出未知的OOD分布,从而获得OOD教师模型。另外,作者表明:本文方法成功的来源之处在于因果反省,而非简单的ensemble嵌入。

三、Related work

3.1 视觉问答

概念的介绍→bias的存在→VQA-CP数据集→影响VQAv2数据集的精度,目前仍有待解决。

3.2 Extractive Question Answering

该任务旨在回答所给自然语言上下文(段落)的问题,同时是个位置预测的分类问题,因此这种分类问题也存在bias,从而引入数据集SQuAd用于评估语言模型是否存在位置bias。

3.3 Ensemble-based methods for debiasing

该方法显式地构建并包含了捷径bias,这种捷径能够通过一个单独的分支或者统计先验进行捕捉。这些方法虽在OOD的分布上取得了很高的精度,但是在ID分布上确是降低了很多精度,原因在于这些方法是根据训练集和测试集的分布有着完全不同甚至相反的比例这种假设来进行训练的。本文采用之前提出的CF-VQA和ID-OOD教师模型,实现了ID-OOD评估的平衡。

3.4 Knowledge Distillation

知识蒸馏将教师的知识蒸馏到一个小型的学生模型上,本文提出的Introspection反省与自蒸馏相关,只不过自蒸馏是将学生模型自身作为下一次训练中的教师。其不同之处:自蒸馏仍处于ID分布内,并不存在对于看见的事实或者看不见的反事实进行比较推理,这也是为啥本文的自反省引入了融合/混血知识而不是直接copy自蒸馏。另外有一点不同在于本文的蒸馏并未使用一个固定的权重超参数,而是基于反省角度的权重,并不需要额外的超参数选择。

四、内省蒸馏

输入为视觉或者自然文本 C = c , Q = q C=c,Q=q C=c,Q=q,QA模型旨在产生答案 A = a A=a A=a,本质为多分类问题,即 a ∈ A a\\in \\mathbbA a∈A。作者提出的IntroD旨在平等地融合ID和OOD-bias,该方法由三个模块组成:

- casual teacher:用于捕捉ID和OOD-bias

- introspection:用于融合/混合这两种不同的bias

- distillation:用于蒸馏出鲁棒性的学生模型

4.1 ID-Teacher and OOD-Teacher

由于无法得到OOD分布,所以没办法得到OOD教师模型,这里引入CF-VQA方法,采用反事实推理得到OOD教师模型。同时ID教师也能近似地通过事实推理使用相同的casual模型来得到。

根据反事实推理,casual模型能够想象出OOD分布,因此使用相同的casual模型部署ID和OOD教师。通过事实推理,casual模型能够预测出答案

P

I

D

P^ID

PID,该答案包含了ID-bias;通过反事实推理,casual模型能够估计直接的影响来排除掉bias,并产生反事实的预测

P

O

O

D

P^OOD

POOD,即,非直接的影响或者自然的非直接的影响反映着看不见的OOD分布。教师模型采用交叉熵损失在ID数据上训练,并未分别训练ID和OOD教师模型。

4.2 Introspection of Inductive Bias

Introspection 模块首先测试是否模型过度利用了ID或者OOD的bias,如果ID-bias主导了学习,那么学生模型就应该倾向于OOD的教师模型。因此引出两个问题,如何定义“主导”和“更倾向”,换句话说,如何反省和权衡这两种bias。

4.2.1 Introspecting the bias

通过比较ID和OOD教师的预测来反省bias的影响,如果ID内的主导了样本的学习,那么ID教师的置信度将会大于OOD教师的,用公式表示如下:

s

I

D

=

∑

a

∈

A

G

T

P

I

D

(

a

)

,

s

O

O

D

=

∑

a

∈

A

G

T

P

O

O

D

(

a

)

,

s^\\mathrmID=\\sum_a \\in \\mathcalA^\\mathrmGT P^\\mathrmID(a), \\quad s^\\mathrmOOD=\\sum_a \\in \\mathcalA^\\mathrmGT P^\\mathrmOOD(a),

sID=a∈AGT∑PID(a),sOOD=a∈AGT∑POOD(a),

其中

A

G

T

\\mathcalA^\\mathrmGT

AGT为gt answer,

S

S

S得分反映了训练样本与bias的契合程度。如果

s

I

D

>

s

O

O

D

s^\\mathrmID>s^\\mathrmOOD

sID>sOOD,那么样本的学习由ID-bias主导反之亦然。接下来就是

s

I

D

,

s

O

O

D

s^\\mathrmID,s^\\mathrmOOD

sID,sOOD的确定了,表示如下:

s

I

D

=

1

X

E

(

P

G

T

,

P

I

D

)

=

1

∑

a

∈

A

−

P

G

T

(

a

)

log

P

I

D

(

a

)

,

s

O

O

D

=

1

X

E

(

P

G

T

,

P

O

O

D

)

=

1

∑

a

∈

A

−

P

G

T

(

a

)

log

P

O

O

D

(

a

)

,

\\beginaligned s^\\mathrmID &=\\frac1X E\\left(P^\\mathrmGT, P^\\mathrmID\\right)=\\frac1\\sum_a \\in \\mathcalA-P^\\mathrmGT(a) \\log P^\\mathrmID(a), \\\\ s^\\mathrmOOD &=\\frac1X E\\left(P^\\mathrmGT, P^\\mathrmOOD\\right)=\\frac1\\sum_a \\in \\mathcalA-P^\\mathrmGT(a) \\log P^\\mathrmOOD(a), \\endaligned

sIDsOOD=XE(PGT,PID)1=∑a∈A−PGT(a)logPID(a)1,=XE(PGT,POOD)1=∑a∈A−PGT(a)logPOOD(a)1,其中

P

G

T

P^GT

PGT为真实标签,采用交叉熵来训练比之前的相加效果要好。

4.2.2 Weighting the bias

利用知识的权重求和来融合/混合ID和OOD的知识,目的在于公平的混合ID或者OOD的bias。因此就有前面说的三种情况,如果 s I D > s O O D s^\\mathrmID>s^\\mathrmOOD sID>sOOD,那么学生模型就应该从OOD教师模型中学习的更多,因此就要增加 w O O D w^OOD wOOD,使得 w O O D > w I D w^OOD>w^ID wOOD>wID。类似的,当 s I D < s O O D s^\\mathrmID<s^\\mathrmOOD sID<