ZoomNet 解读局部感知自适应缩放神经网络的三维目标检测

Posted AI 菌

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了ZoomNet 解读局部感知自适应缩放神经网络的三维目标检测相关的知识,希望对你有一定的参考价值。

摘要

三维目标检测是自动驾驶和机器人技术中的一项重要任务。虽然已经取得了很大的进展,但在估计远处和遮挡物体的三维姿态方面仍然存在挑战。本文提出了一种新的基于立体图像的三维检测框架 ZoomNet。

ZoomNet 采用了一个普通的2D目标检测模型用于获取左右边界框对。为了进一步利用rgb图像中丰富的纹理线索进行更精确的视差估计,本文引入了一个直观的概念模块——自适应变焦,它同时将二维实例边界框的大小调整为统一的分辨率,并相应地调整相机的内部参数。通过这种方式,本文能够从调整大小的方框图像中估算出更高质量的视差图,然后为附近和远处的物体构建密集的点云。此外,本文引入了学习部分位置作为补充特征来提高抗遮挡能力,并提出了三维拟合评分来更好地估计三维检测质量。

在KITTI 3D检测数据集上进行的大量实验表明,ZoomNet大大超过了以往所有最先进的方法,其中 A P b v AP_bv APbv(IoU=0.7)比伪激光雷达提高了9.4%。消融研究也表明,本文的自适应缩放策略在 A P 3 d AP_3d AP3d(IoU=0.7)上提高了10%以上。

此外,由于官方的KITTI基准测试缺乏像素级部件位置等细粒度的注释,本文还通过增加KITTI的详细实例级注释(包括像素级部件位置、像素级差异等)来展示我们的KFG数据集。KFG数据集和代码开源在:https://github.com/detectRecog/ZoomNet

一、引言

近年来,基于立体图像的三维检测框架致力于探索如何有效地利用立体三维信息,并将现有的二维/三维检测模型插入到它们的框架中。

如上图所示,将 ZoomNet 与现有框架进行比较:

- 框架(a)执行2D检测,然后通过3D-2D几何约束推断3D姿态。

- 框架(b)估计视差图构建伪激光雷达,然后对伪激光雷达上执行三维检测。

- 框架©执行实例级的差异估计和分析,获得了优越的性能。

人类的视觉系统可以通过仔细观察和分析每个物体实例来准确地定位三维空间中的物体。它还可以根据物体三维形状的先验知识,为有严重遮挡的物体估计3D姿势形状。这种实例级分析和形状先验在现有的基于立体图像的框架中远远没有得到很好的利用。

考虑到上述问题,在本文中,提出了一个新的框架ZoomNet ,如上图©所示。本文的主要贡献如下:

- 提出了一种新的基于立体图像的三维检测框架ZoomNet;

- 提出了一种有效的自适应缩放策略,通过该策略,所有实例都能以相同的分辨率进行分析,并构造出无论实例距离如何,实例pc都具有均匀的密度;

- 提出部分定位以提高网络对遮挡的鲁棒性和三维拟合评分,以更好地估计三维检测质量;

- 对KITTI数据集的评估表明,ZoomNet大大优于所有现有的基于立体图像的方法。更重要的是,它首先在Hard数据集上达到70%的高AP。

二、方法

如图4所示,本文提出的ZoomNet包含两个主要阶段:

- (A) 2D检测和自适应缩放。在阶段(A)中,本文对输入的立体图像进行二维目标检测和边界框关联。对检测到的每个实例,估计二维分类概率和三维边界框(或维M)的大小。

- (B) 实例级细粒度分析。在阶段(B)中,ZoomNet对所有实例执行细粒度分析,其中像素估计被预测,包括视差,部分位置,前景/背景(f/g)标记。然后,利用这些像素估计构建实例pc进行姿态估计。在姿态估计中,预测旋转R、平移T和衡量三维边界盒的好坏的三维拟合得分。因此,ZoomNet对一个实例的最终输出是(M, R, T, S),其中3D检测置信值S是2D分类概率和3D拟合得分的乘积。

2.1 2D检测和自适应缩放

在这个阶段,给定一个左右图像对,目标检测器预测一系列的立体实例及其对应的维度M和二维分类概率P。然后,通过自适应缩放,使得远处的汽车在更大的分辨率中分析得到更好的深度估计。

2D检测

与普通的二维检测任务不同,立体图像的目标检测需要关联立体图像中的区域建议。最近,Stereo - RCNN 扩展了Fast - RCNN 用于立体输入,同时检测和关联立体图像中的实例。然后,提取立体ROI特征并将其连接起来进行对象类别分类,并对维度、方向和关键点进行回归。本文采用Stereo-RCNN作为二维检测的主干,放弃了关键点和方向预测分支。RoI实例包含一对立体边界框可以表示为(x, x ˉ \\barx xˉ, y, w h),其中(x, y, w, h)表示左边 RoI L 的左上角坐标(x, y),宽度w和高度h。( x ˉ \\barx xˉ, y, w, h) 表示相应的RoI R 的左上角坐标( x ˉ \\barx xˉ,y),宽度w和高度h。

自适应缩放

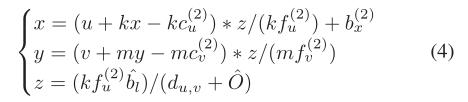

为了获得更好的深度估计,本文引入了一种有效的自适应缩放策略。当我们从投影图像中采样像素时,像素可能是矩形而不是正方形因此,结果像素阵列的大小可以随两个缩放参数而变化:水平缩放参数k和垂直缩放参数m。根据KITTI官方标准,本文将左摄像头和右摄像头分别标记为P2和P3。通过选择不同的缩放参数对像素进行重新采样,P2的内参如下:

上标(2)表示它属于P2。fu, fv 表示焦距,cu, cv 表示主点偏移。bx 为基准摄像机的基线。右侧相机P3的内部参数也以同样的方式改变为

P

^

3

\\hatP_3

P^3。k、m为调节P2、P3焦距的变焦参数。

此外,缩放参数还调整左RoI L和右RoI R的大小,使得结果图像的大小等于第二阶段中的预期大小,即:k=W/w,m=H/h,其中(W,H)是阶段(B)中预定义的输入图像大小。

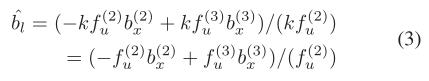

与基于伪激光雷达的方法中的深度估计不同,自适应缩放通过分析较大图像上的视差,可以将远距离车辆的深度估计误差降低k。假设图像水平缩放k,对于视差δD中的给定误差,自适应缩放影响深度δZ中的误差,如下所示:

2.2 基于实例的细粒度分析

在此阶段,ZoomNet对所有实例执行细粒度分析。我们将放大的左RoI和放大的右RoI分别表示为 L ^ \\hatL L^和 R ^ \\hatR R^。对于左输入 L ^ \\hatL L^,生成三个像素级预测,即,视差图、部件位置图和f/g标记。然后,基于这三个预测估计三维姿态。最后,通过考虑二维分类概率和我们提出的三维拟合分数,对估计的三维边界框的优度进行评分。多亏了多功能和灵活的深度神经网络,本文设计并实现了由三个子网络组成的可端对端训练的网络。

视差预测

继伪激光雷达之后,我们采用 PSMnet 在 L ^ \\hatL L^ 和 R ^ \\hatR R^ 之间进行立体匹配,最大视差值较小,因为 L ^ \\hatL L^和 R ^ \\hatR R^大致对齐。与训练后固定网络参数的伪激光雷达不同,允许进行梯度处理,以便在变焦网络中进行端到端学习。我们认为端到端学习允许子网络通过后续3D旋转和平移回归的额外监督进行训练,从而使网络能够更准确地预测差异。

零件定位与掩模预测

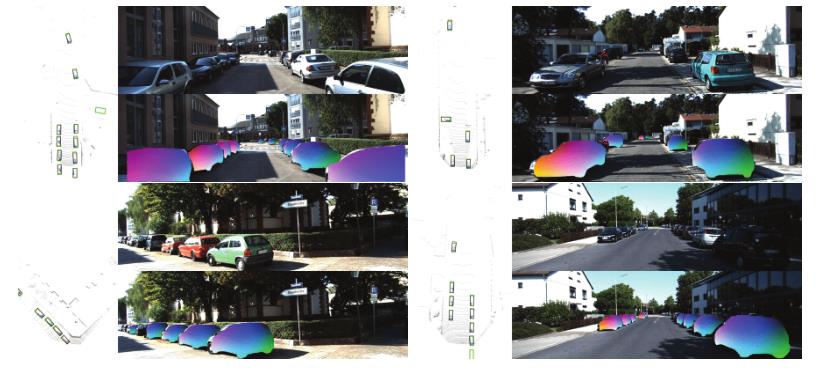

本文将前景像素的部分标签表示为三个连续值(px、py、pz)∈ [0,1]指示其在对象坐标中的相对三维位置。我们的零件位置是在2D像素上预测的,而不是3D点。如下图所示,我们通过将(px、py、pz)视为三个RGB通道来可视化零件位置。

本文设计了一个编码器-解码器架构,用于估计L上的部件位置和f/g分割掩码(见图4)。编码器是共享的,但我们对零件位置和b/f分段掩码使用不同的解码器。由于预测L上的零件位置很简单,当两辆车严重重叠时,仅在L上确定感兴趣的实例是不明确的。因此,如图4所示,我们在掩码预测中聚合由同一编码器提取的L的特征和R的特征,以减轻这种模糊性。

点云构造

给定分割模板、零件位置图和左视差图,本文从前景像素构建PCs。将图像平面中的像素转换为相机坐标系中的3D点需要2D图像上的像素坐标以及对应的相机固有参数。通常的做法是将高度kw和宽度mh的这些二维特征图重塑为原始宽度w和高度h,然后使用原始相机内部参数P2和P3将原始输入图像L中的像素投影到三维点。在自适应缩放的帮助下,不需要向下采样或向上采样2D特征贴图。

相反,我们使用相应的伪相机固有参数

P

^

2

\\hatP_2

P^2 和

P

^

3

\\hatP_3

P^3 在幻觉放大的左图像

L

^

\\hatL

L^上执行该投影。

L

^

\\hatL

L^ 是通过在水平方向上按k和在垂直方向上按m进行缩放得到的。这样,L的起点从(x,y)变为(kx,my),L和R之间的视差偏移变为

O

^

=

k

(

x

−

x

ˉ

)

\\hatO=k(x− \\barx)

O^=k(x−xˉ)。但是,

P

^

2

\\hatP_2

P^2 和

P

^

3

\\hatP_3

P^3 之间的基线距离保持不变:

对于每个前景点(u,v),u∈ [0,W),v∈ [0,H)在分割图上,我们将该点的预测视差表示为

d

u

,

v

du,v

du,v。三维点在摄像机坐标系(x,y,z)中的位置可计算为:

此外,对于摄影机坐标中的每个3D点(x、y、z),对象坐标中的零件位置(px、py、pz)也将被集成。假设分割图上有N个前景像素,则构造的PC的维数为N∗ 6,其中N∗ 3是3D位置,另一个是N∗ 3是相应的估计零件位置。

姿态估计与细化

在构建了基于实例的PC之后,我们对预定义数量的E点进行采样,以进行3D特征提取。由于ZoomNet生成的点基本上均匀地分布在实例曲面上,如前所述,只需随机采样E点。通常的做法是通过直接回归或分类与回归的组合来估计旋转R和平移T。然而,受最近一项名为DenseFusion 的 RGB-D 姿势估计工作的启发,我们认为基于CAD模型的距离损失可以更好地衡量姿势估计的质量。因此,我们修改DenseFusion 以进行姿势估计,并通过移除CNN模块和利用预测的零件位置作为颜色嵌入对其进行裁剪。

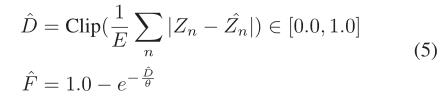

如上所述,2D分类概率P与3D检测质量没有很好的相关性。因此,我们提出了3D拟合分数来更好地衡量3D检测的质量。然而,纯粹在构造的PC上预测质量是非常模糊的。训练目标 F ^ \\hatF F^与构建的实例PC和由GT视差构建的GT实例PC之间的平均距离 D ^ \\hatD D^相关联。对于每个前景点(以n为例),让[Xn,Yn,Zn]为生成的点坐标, [ X ^ n , Y ^ n , Z ^ n ] [\\hatX_n,\\hatY_n,\\hatZ_n] [X^n,Y^n,Z^n]为GT点坐标。训练目标制定为:

我们将

D

^

\\hatD

D^裁剪到[0.0, 1.0]范围,因为当深度误差超过1米时,3D检测结果往往失败。由于很难正确估计深度,我们使用公式(5)专门设计了损耗,以强制网络专注于深度预测。

2.3 训练

在阶段(B)中,输入图像大小(W,H)被设置为(256,128)。在训练和测试阶段,E都设置为500,因为根据经验,我们发现采样更多的点不会提高姿势估计性能。阶段(B)中的多任务损失公式如下:

其中,

L

m

L_m

Lm是估计的像素级分割分数和GT b/f分割掩码之间的二分类交叉熵损失。对于每个GT前景像素,

L

d

L_d

Ld是估计视差和GT视差之间的平滑L1距离,

L

p

a

L_pa

Lpa是估计零件位置和GT前景区域上GT零件位置之间的平滑L1距离。

L

p

o

L_po

Lpo和

L

r

L_r

Lr分别是基于CAD模型的姿势估计损失和细化损失。

L

s

L_s

Ls 是预测3D拟合分数

F

F

F和

F

^

\\hatF

F^之间的平滑L1距离。

经验上,我们发现当θ设置为8时,3D拟合分数与2D分类概率的配合更好。此外,为了稳定联合训练,较低的权重w=0.1分配给零件位置和遮罩的丢失。姿势估计和优化中的学习速率设置为全局学习率的0.1。

在阶段(B)的训练期间,我们通过随机但“适度”地移动左/右作物的水平起点来执行数据扩充。默认情况下,将在二维检测结果的左/右边界框处裁剪左/右裁剪。当左/右边界框的水平起点 x ˉ \\barx xˉ,x发生变化时,左/右裁剪之间的像素级视差也相应地发生变化。“适度”移动意味着生成的视差图应满足两个要求:

- (1) 前景像素的最小视差应大于0;

- (2) 前景像素的最大视差应小于立体匹配的默认最大视差。

三、实验

3.1 三维和鸟瞰图目标检测

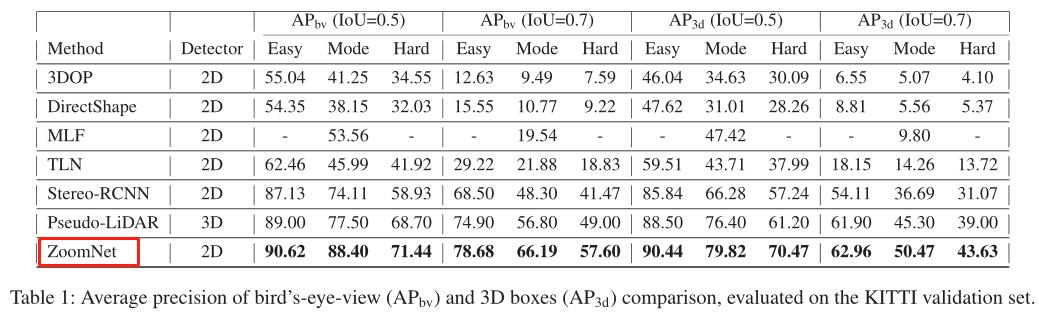

如下表1所示,本文的方法优于所有其他最先进的方法,尤其是在IoU阈值为0.7的

A

P

b

v

AP_bv

APbv上。在最具挑战性的指标

A

P

3

d

AP_3d

AP3d(IoU=0.7)上,本文的方法稳定地超过了Strreo R-CNN 14%。

ZoomNet在具有挑战性的困难模式下实现了接近70%的AP。由于硬集中的汽车大多距离较远且难以看到,因此原因可能有两个:(i)由于自适应变焦,ZoomNet通过引入距离不变策略,可以更准确地检测远处的汽车。(ii)ZoomNet对遮挡具有很强的鲁棒性。

定量的检测结果如下图所示:

3.2 不同距离的比较

如式(2)所述,与估计全图像视差相比,自适应缩放可以减少远距离车辆的深度估计误差。为了测试自适应缩放在不同距离下对3D检测性能的影响,本文将验证集中的所有汽车按深度分为三类:(i)0∼ 20m,(ii)20∼ 40m,以及(iii)大于40m。结果如图5所示。对于近距离车辆(0∼ 20米),伪激光雷达和ZoomNet之间的差距很小。他们在近距离的高性能也表明,基于立体图像的方法对于低速机器人是有希望的,因为低速机器人和我们人类一样,不需要关心太远的物体。

随着深度增加到40m以上,性能差距越来越大。特别是在困难环境下,对于40米以外的汽车,ZoomNet达到42.7%的AP,比伪激光雷达高约120%。这一趋势验证了ZoomNet对于远距离车辆具有明显更好的3D检测性能。

3.3 不同遮挡水平的比较

为了验证ZoomNet比基于关键点的方法对遮挡更具鲁棒性,本文在不同遮挡水平上比较了ZoomNet和Stereo R-CNN。

A

P

3

d

AP_3d

AP3d(IoU=0.7)的结果如表2所示。遮挡级别0、1、2分别表示“完全可见”、“部分遮挡”、“难以看见”。本文只关心困难数据集中的比较,因为属于遮挡级别2的车辆只存在于困难数据集中。

在所有的遮挡水平上,本文的ZoomNet稳定地超过了 Stereo R-CNN。特别是在遮挡级别1上,ZoomNet的性能比Stereo R-CNN高95%。但是,当在ZoomNet中删除零件位置时,遮挡级别2的性能会下降很多,并且比立体R-CNN稍差。AP的大幅下降表明零件位置对于检测堵塞车辆至关重要。

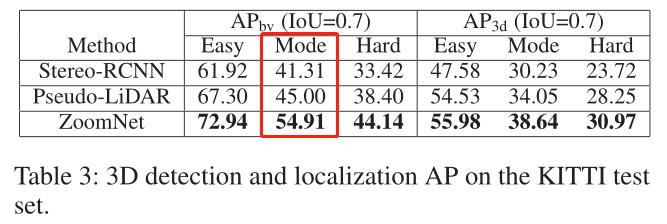

3.4 测试集结果

为了证明所提出模型的有效性,如表3所示,报告了官方KITTI测试的评估结果。值得注意的是,ZoomNet在

A

P

b

v

AP_bv

APbv(IoU=0.7)方面超过了最先进的方法9.9%。

3.5 消融实验

在这项消融研究中,验证了零件位置、3D拟合分数(3DFS)和自适应缩放(AZ)结果的贡献,如表4所示。当不使用零件位置时,我们调整姿势估计的输入通道。当不使用3DFS时,我们将二维分类概率视为三维检测置信度。当不使用AZ时,我们将2D特征贴图重塑为原始大小,并以L而不是缩放图像

L

^

\\hatL

L^投影像素,以构建PCs。

四、结论

在本文中,提出了一种新的基于立体图像的三维检测框架。通过利用自适应缩放以统一的分辨率处理不同距离的车辆,并利用零件位置解决严重遮挡下的模糊性,ZoomNet 在具有挑战性的KITTI 3D和BEV目标检测任务上大大超过了所有现有的基于图像的方法。更重要的是,ZoomNet是第一个在困难场景中实现70%高AP的基于图像的方法。高3D检测性能表明ZoomNet可作为自主驾驶和机器人导航的竞争性可靠备份。

以上是关于ZoomNet 解读局部感知自适应缩放神经网络的三维目标检测的主要内容,如果未能解决你的问题,请参考以下文章