从零开发一款Android RTMP播放器

Posted 涂程

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了从零开发一款Android RTMP播放器相关的知识,希望对你有一定的参考价值。

1. 背景介绍

15年移动端直播应用火起来的时候,主要的直播协议是RTMP,多媒体服务以Adobe的AMS、wowza、Red5、crtmpserver、nginx rtmp module等,后面过长RTMP服务SRS开始流行。android端播放器主要以开始以EXOPlayer播放HLS,但是HLS有延迟高的确定,随后大家主要使用开源的ijkplyer,ijkplayer通过ffmpeg进行拉流及解码,支持多种音视频编码,还有跨平台,API与系统播放器保持一致等特征,后续各大厂提供的直播SDK均有ijkplayer身影。

当时在做一款游戏SDK,SDK主要提供了游戏画面声音采集、音视频编解码、直播推流、直播拉流播放等,SDK为游戏提供直播功能,播放也是采用了现成的ijkplayer播放器。但是SDK推广的时候遇到了问题,游戏厂家嫌弃SDK体积大(其实总共也就3Mb左右),我们需要一款体积小,性能高的播放器,由于开发成本的原因一直没有时间做,后面换工作期间,花了一个月时间把这款播放器开发出来,并开源了出来。oarplayer 是基于MediaCodec与srs-librtmp,完全不依赖ffmpeg,纯C语言实现的播放器。本文主要介绍这款播放器的实现思路。

2. 整体架构设计

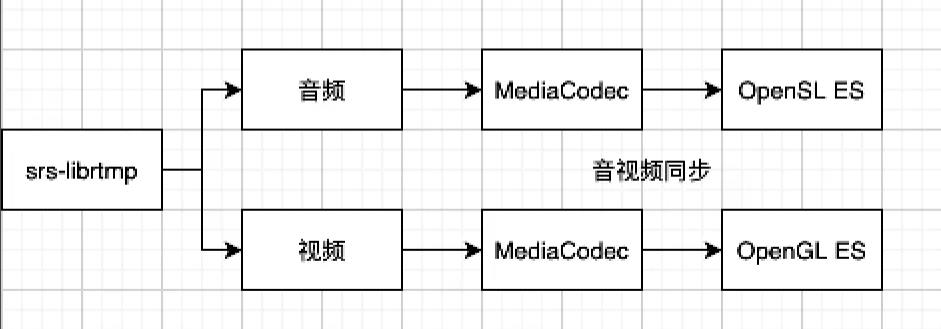

播放器整体播放流程如下:

通过srs-librtmp拉取直播流,通过package type分离音视频流,将package数据缓存到package队列,解码线程不断从package队列读取package交由解码器解码,解码器将解码后的frame存储到frame队列,opensles播放线程与opengles渲染线程从frame队列读取frame播放与渲染,这里还涉及到音视频同步。

播放器主要涉及了以下线程:

- rtmp拉流线程;

- 音频解码线程;

- 视频解码线程;

- 音频播放线程;

- 视频渲染线程;

- JNI回调线程。

3. API接口设计

通过以下几步即可完成rtmp播放:

- 实例化OARPlayer:

OARPlayer player = new OARPlayer(); - 设置视频源:

player.setDataSource(rtmp_url); - 设置surface:

player.setSurface(surfaceView.getHolder()); - 开始播放:

player.start(); - 停止播放:

player.stop(); - 释放资源:

player.release();

Java层方法封装了JNI层方法,JNI层封装调用了对应的具体功能。

4. rtmp拉流线程

oarplayer使用的是srs-librtmp,srs-librtmp是从SRS服务器导出的一个客户端库,作者提供srs-librtmp初衷是:

- 觉得rtmpdump/librtmp的代码太难读了,而SRS的代码可读性很好;

- 压测工具srs-bench是个客户端,需要一个客户端库;

- 觉得服务器能搞好,客户端也不在话下

目前srs-librtmp作者已经停止维护,主要原因如作者所说:

决定开源项目正义的绝对不是技术多好,而是能跑多久。技术很牛,性能很强,代码风格很好,固然是个好事,但是这些都顶不上一个“不维护”的大罪过,代码放出来不维护,怎么跟进业内技术的不断发展呢。而决定能跑多久的,首先是技术热情,然后是维护者的领域背景。SRS的维护者都是服务器背景,大家的工作都是在服务器,客户端经验太少了,无法长久维护客户端的库。因此,SRS决定果断放弃srs-librtmp,不再维护客户端库,聚焦于服务器的快速迭代。客户端并非不重要,而是要交给专业的客户端的开源项目和朋友维护,比如FFmpeg也自己实现了librtmp。

oarplayer当初使用srs-librtmp是基于srs-librtmp代码的可读性考虑。oarplayer有相当高的模块化特性,可以很方便的替换各个rtmp lib实现。这里介绍srs-librtmp接口:

- 创建srs_rtmp_t对象:

srs_rtmp_create(url); - 设置读写超时时间:

srs_rtmp_set_timeout; - 开始握手:

srs_rtmp_handshake; - 开始连接:

srs_rtmp_connect_app; - 设置播放模式:

srs_rtmp_play_stream; - 循环读取音视频包:

srs_rtmp_read_packet(rtmp, &type, ×tamp, &data, &size); - 解析音频包:

- 获取编码类型:

srs_utils_flv_audio_sound_format; - 获取音频采样率:

srs_utils_flv_audio_sound_rate; - 获取采样位深:

srs_utils_flv_audio_sound_size; - 获取声道数:

srs_utils_flv_audio_sound_type; - 获取音频包类型:

srs_utils_flv_audio_aac_packet_type;

- 获取编码类型:

- 解析视频包:

- 获取编码类型:

srs_utils_flv_video_codec_id; - 是否关键帧:

srs_utils_flv_video_frame_type; - 获取视频包类型:

srs_utils_flv_video_avc_packet_type;

- 获取编码类型:

- 解析metadata类型;

- 销毁srs_rtmp_t对象:

srs_rtmp_destroy;

这里有个小技巧,我们在拉流线程中,循环调用srs_rtmp_read_packet方法,可以通过srs_rtmp_set_timeout设置超时时间,但是如果超时时间设置的太短,会导致频繁的唤起线程,如果设置超时时间太长,我们在停止时,必须等待超时结束才会能真正结束。这里我们可以使用poll模型,将rtmp的tcp socket放入poll中,再放入一个管道fd,在需要停止时向管道写入一个指令,唤醒poll,直接停止rtmp拉流线程。

5. 主要数据结构

5.1 package结构:

typedef struct OARPacket

int size;//包大小

PktType_e type;//包类型

int64_t dts;//解码时间戳

int64_t pts;//显示时间戳

int isKeyframe;//是否关键帧

struct OARPacket *next;//下一个包地址

uint8_t data[0];//包数据内容

OARPacket;

5.2 package队列:

typedef struct oar_packet_queue

PktType_e media_type;//类型

pthread_mutex_t *mutex;//线程锁

pthread_cond_t *cond;//条件变量

OARPacket *cachedPackets;//队列首地址

OARPacket *lastPacket;//队列最后一个元素

int count;//数量

int total_bytes;//总字节数

uint64_t max_duration;//最大时长

void (*full_cb)(void *);//队列满回调

void (*empty_cb)(void *);//队列为空回调

void *cb_data;

oar_packet_queue;

5.3 Frame类型

typedef struct OARFrame

int size;//帧大小

PktType_e type;//帧类型

int64_t dts;//解码时间戳

int64_t pts;//显示时间戳

int format;//格式(用于视频)

int width;//宽(用于视频)

int height;//高(用于视频)

int64_t pkt_pos;

int sample_rate;//采样率(用于音频)

struct OARFrame *next;

uint8_t data[0];

OARFrame;

5.4 Frame队列

typedef struct oar_frame_queue

pthread_mutex_t *mutex;

pthread_cond_t *cond;

OARFrame *cachedFrames;

OARFrame *lastFrame;

int count;//帧数量

unsigned int size;

oar_frame_queue;

6. 解码线程

我们的rtmp流拉取、解码、渲染、音频输出都在C层实现。在C层,Android 21之后系统提供了AMediaCodec接口,我们直接find_library(media-ndk mediandk),并引入<media/NdkMediaCodec.h>头文件即可。对于Android 21之前版本,可以在C层调用Java层的MediaCodec。下面分别介绍两种实现:

6.1 Java层代理解码

Java层MediaCodec解码使用步骤:

- 创建解码器:

codec = MediaCodec.createDecoderByType(codecName); - 配置解码器格式:

codec.configure(format, null, null, 0); - 启动解码器:

codec.start() - 获取解码输入缓存ID:

dequeueInputBuffer - 获取解码输入缓存:

getInputBuffer - 获取解码输出缓存:

dequeueOutputBufferIndex - 释放输出缓存:

releaseOutPutBuffer - 停止解码器:

codec.stop();

Jni层封装对应的调用接口即可。

6.2 C层解码器使用

C层接口介绍:

- 创建Format:

AMediaFormat_new; - 创建解码器:

AMediaCodec_createDecoderByType; - 配置解码参数:

AMediaCodec_configure; - 启动解码器:

AMediaCodec_start; - 输入音视频包:

- 获取输入buffer序列:

AMediaCodec_dequeueInputBuffer - 获取输入buffer:

AMediaCodec_getInputBuffer - 拷贝数据:

memcpy - 输入buffer放入解码器:

AMediaCodec_queueInputBuffer

- 获取输入buffer序列:

- 获取解码后帧:

- 获取输出buffer序列:

AMediaCodec_dequeueOutputBuffer - 获取输出buffer:

AMediaCodec_getOutputBuffer

- 获取输出buffer序列:

我们发现不管是Java层还是C层的接口都是提供了类似的思路,其实他们最终调用的还是系统的解码框架。

这里我们可以根据系统版本来觉得使用Java层接口和C层接口,我们的oarplayer,主要的代码都是在C层实现,所以我们也有限使用C层接口。

7. 音频输出线程

音频输出我们使用opensl实现,之前文章介绍过Android音频架构,其实也可以使用AAudio或者Oboe。这里再简单介绍下opensl es的使用。

- 创建引擎:

slCreateEngine(&engineObject, 0, NULL, 0, NULL, NULL); - 实现引擎:

(*engineObject)->Realize(engineObject, SL_BOOLEAN_FALSE); - 获取接口:

(*engineObject)->GetInterface(engineObject, SL_IID_ENGINE, &engineEngine); - 创建输出混流器:

(*engineEngine)->CreateOutputMix(engineEngine, &outputMixObject, 0, NULL, NULL);; - 实现混流器:

(*outputMixObject)->Realize(outputMixObject, SL_BOOLEAN_FALSE); - 配置音频源:

SLDataLocator_AndroidSimpleBufferQueue loc_bufq = SL_DATALOCATOR_ANDROIDSIMPLEBUFFERQUEUE, 2; - 配置Format:

SLDataFormat_PCM format_pcm = SL_DATAFORMAT_PCM, channel, SL_SAMPLINGRATE_44_1,SL_PCMSAMPLEFORMAT_FIXED_16, SL_PCMSAMPLEFORMAT_FIXED_16,SL_SPEAKER_FRONT_LEFT | SL_SPEAKER_FRONT_RIGHT, SL_BYTEORDER_LITTLEENDIAN; - 创建播放器:

(*engineEngine)->CreateAudioPlayer(engineEngine,&bqPlayerObject, &audiosrc, &audioSnk,2, ids, req); - 实现播放器:

(*bqPlayerObject)->Realize(bqPlayerObject, SL_BOOLEAN_FALSE); - 获取播放接口:

(*bqPlayerObject)->GetInterface(bqPlayerObject, SL_IID_PLAY, &bqPlayerPlay); - 获取缓冲区接口:

(*bqPlayerObject)->GetInterface(bqPlayerObject, SL_IID_ANDROIDSIMPLEBUFFERQUEUE,&bqPlayerBufferQueue); - 注册缓存回调:

(*bqPlayerBufferQueue)->RegisterCallback(bqPlayerBufferQueue, bqPlayerCallback, oar); - 获取音量调节器:

(*bqPlayerObject)->GetInterface(bqPlayerObject, SL_IID_VOLUME, &bqPlayerVolume); - 缓存回调中不断的从音频帧队列读取数据,并写入缓存队列:

(*bqPlayerBufferQueue)->Enqueue(bqPlayerBufferQueue, ctx->buffer,(SLuint32)ctx->frame_size);

上面就是音频播放的opensl es接口使用介绍。

8. 渲染线程

相比较于音频播放,视频渲染可能更复杂一些,除了opengl引擎创建,opengl线程创建,oarplayer使用的是基于音频的同步方式,所以在视频渲染时还需要考虑音视频同步问题。

8.1 OpenGL引擎创建

- 生成buffer:

glGenBuffers - 绑定buffer:

glBindBuffer(GL_ARRAY_BUFFER, model->vbos[0]) - 设置清屏色:

glClearColor - 创建纹理对象:

texture2D - 创建着色器对象:

glCreateShader - 设置着色器源码:

glShaderSource - 编译着色器源码:

glCompileShader - 附着着色器:

glAttachShader - 连接着色器:

glLinkProgram

opengl与硬件交互还需要EGL环境,下面展示EGL初始化流程代码:

static void init_egl(oarplayer * oar)

oar_video_render_context *ctx = oar->video_render_ctx;

const EGLint attribs[] = EGL_SURFACE_TYPE, EGL_WINDOW_BIT, EGL_RENDERABLE_TYPE,

EGL_OPENGL_ES2_BIT, EGL_BLUE_SIZE, 8, EGL_GREEN_SIZE, 8, EGL_RED_SIZE,

8, EGL_ALPHA_SIZE, 8, EGL_DEPTH_SIZE, 0, EGL_STENCIL_SIZE, 0,

EGL_NONE;

EGLint numConfigs;

ctx->display = eglGetDisplay(EGL_DEFAULT_DISPLAY);

EGLint majorVersion, minorVersion;

eglInitialize(ctx->display, &majorVersion, &minorVersion);

eglChooseConfig(ctx->display, attribs, &ctx->config, 1, &numConfigs);

ctx->surface = eglCreateWindowSurface(ctx->display, ctx->config, ctx->window, NULL);

EGLint attrs[] = EGL_CONTEXT_CLIENT_VERSION, 2, EGL_NONE;

ctx->context = eglCreateContext(ctx->display, ctx->config, NULL, attrs);

EGLint err = eglGetError();

if (err != EGL_SUCCESS)

LOGE("egl error");

if (eglMakeCurrent(ctx->display, ctx->surface, ctx->surface, ctx->context) == EGL_FALSE)

LOGE("------EGL-FALSE");

eglQuerySurface(ctx->display, ctx->surface, EGL_WIDTH, &ctx->width);

eglQuerySurface(ctx->display, ctx->surface, EGL_HEIGHT, &ctx->height);

initTexture(oar);

oar_java_class * jc = oar->jc;

JNIEnv * jniEnv = oar->video_render_ctx->jniEnv;

jobject surface_texture = (*jniEnv)->CallStaticObjectMethod(jniEnv, jc->SurfaceTextureBridge, jc->texture_getSurface, ctx->texture[3]);

ctx->texture_window = ANativeWindow_fromSurface(jniEnv, surface_texture);

8.2 音视频同步

常见的音视频同步有三种:

- 基于视频同步;

- 基于音频同步;

- 基于第三方时间戳同步。

这里我们使用基于音频帧同步的方法,渲染画面时,判断音频时间戳diff与视频画面渲染周期,如果大于周期,则等待,如果大于0小于周期,如果小于0则立马绘制。

下面展示渲染代码:

/**

*

* @param oar

* @param frame

* @return 0 draw

* -1 sleep 33ms continue

* -2 break

*/

static inline int draw_video_frame(oarplayer *oar)

// 上一次可能没有画, 这种情况就不需要取新的了

if (oar->video_frame == NULL)

oar->video_frame = oar_frame_queue_get(oar->video_frame_queue);

// buffer empty ==> sleep 10ms , return 0

// eos ==> return -2

if (oar->video_frame == NULL)

_LOGD("video_frame is null...");

usleep(BUFFER_EMPTY_SLEEP_US);

return 0;

int64_t time_stamp = oar->video_frame->pts;

int64_t diff = 0;

if(oar->metadata->has_audio)

diff = time_stamp - (oar->audio_clock->pts + oar->audio_player_ctx->get_delta_time(oar->audio_player_ctx));

else

diff = time_stamp - oar_clock_get(oar->video_clock);

_LOGD("time_stamp:%lld, clock:%lld, diff:%lld",time_stamp , oar_clock_get(oar->video_clock), diff);

oar_model *model = oar->video_render_ctx->model;

// diff >= 33ms if draw_mode == wait_frame return -1

// if draw_mode == fixed_frequency draw previous frame ,return 0

// diff > 0 && diff < 33ms sleep(diff) draw return 0

// diff <= 0 draw return 0

if (diff >= WAIT_FRAME_SLEEP_US)

if (oar->video_render_ctx->draw_mode == wait_frame)

return -1;

else

draw_now(oar->video_render_ctx);

return 0;

else

// if diff > WAIT_FRAME_SLEEP_US then use previous frame

// else use current frame and release frame

// LOGI("start draw...");

pthread_mutex_lock(oar->video_render_ctx->lock);

model->update_frame(model, oar->video_frame);

pthread_mutex_unlock(oar->video_render_ctx->lock);

oar_player_release_video_frame(oar, oar->video_frame);

JNIEnv * jniEnv = oar->video_render_ctx->jniEnv;

(*jniEnv)->CallStaticVoidMethod(jniEnv, oar->jc->SurfaceTextureBridge, oar->jc->texture_updateTexImage);

jfloatArray texture_matrix_array = (*jniEnv)->CallStaticObjectMethod(jniEnv, oar->jc->SurfaceTextureBridge, oar->jc->texture_getTransformMatrix);

(*jniEnv)->GetFloatArrayRegion(jniEnv, texture_matrix_array, 0, 16, model->texture_matrix);

(*jniEnv)->DeleteLocalRef(jniEnv, texture_matrix_array);

if (diff > 0) usleep((useconds_t) diff);

draw_now(oar->video_render_ctx);

oar_clock_set(oar->video_clock, time_stamp);

return 0;

9. 总结

本文基于Android端的RTMP播放器实现过程,介绍了RTMP推拉流库、Android MediaCodec Java层与C层接口、OpenSL ES接口、OpenGL ES接口、EGL接口、以及音视频相关知识

推荐阅读:

Android 音视频开发核心知识点笔记整合

以上是关于从零开发一款Android RTMP播放器的主要内容,如果未能解决你的问题,请参考以下文章

我想要一个简单的代码来为我的 android 应用程序项目播放 rtmp 流中的视频

直播 RTMP/RTSP 播放器,无需在 Android 上使用 webview(WOWZA 服务器)