模型推理deepstream-app 介绍

Posted 极智视界

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了模型推理deepstream-app 介绍相关的知识,希望对你有一定的参考价值。

欢迎关注我的公众号 [极智视界],回复001获取Google编程规范

O_o >_< o_O O_o ~_~ o_O

本文介绍了 deepstream-app 的使用与配置说明。

关于 deepstream 的安装可以参考我之前写的文章《【经验分享】ubuntu 安装 deepstream6.0》、《【经验分享】ubuntu 安装 deepstream5.1》,成功安装后会在 /usr/bin 里生成一些例程可执行程序,如 deepstream-app 就是最基础的一个,这里通过这篇文章介绍一下 deepstream-app 的使用和配置说明。

1、deepstream 架构

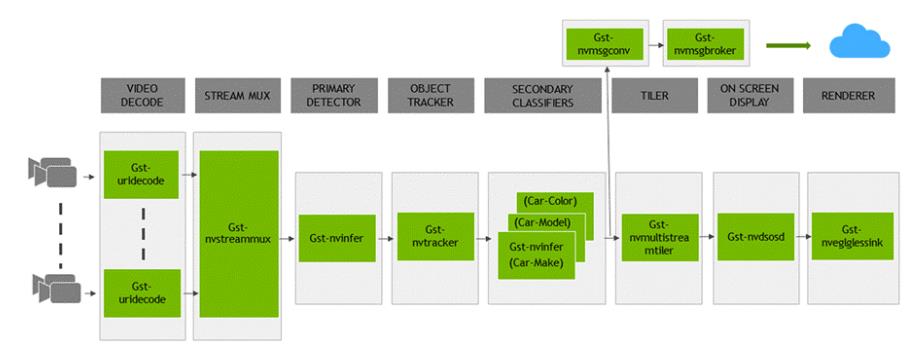

deepstream 架构图如下:

deepstream 参考了 GStreamer 来构建,由很多插件构成,如可以看到 VIDEO DECODE视频编解码、TensorRT推理引擎、OpenCV跟踪器、显示渲染插件等。下面罗列一下主要插件:

- Gst-nvstreammux:这是个流汇集的插件,将多个输入流汇集到一批缓冲区;

- Gst-nvdspreprocess:在预先设置的 ROIs 上做预处理;

- Gst-nvinfer:基于 TensorRT 的推理插件,这是最核心的;

- Gst-nvtracker:基于 OpenCV 的跟踪插件,用于目标 ID 的跟踪;

- Gst-nvmultistreamtiler:用于形成二维数组形式视频帧;

- Gst-nvdsosd:这是屏幕显示插件,用于画一些 boxes、检测框等;

- Gst-nvmsgconv 和 Gst-nvmsgbroker:用于将分析的数据传输至云服务器。

2、deepstream-app 配置说明

deepstream-app 是 deepstream SDK 中的一个例程可执行程序,功能也是十分强大,里面的配置也是比较多,这里详细介绍一下。

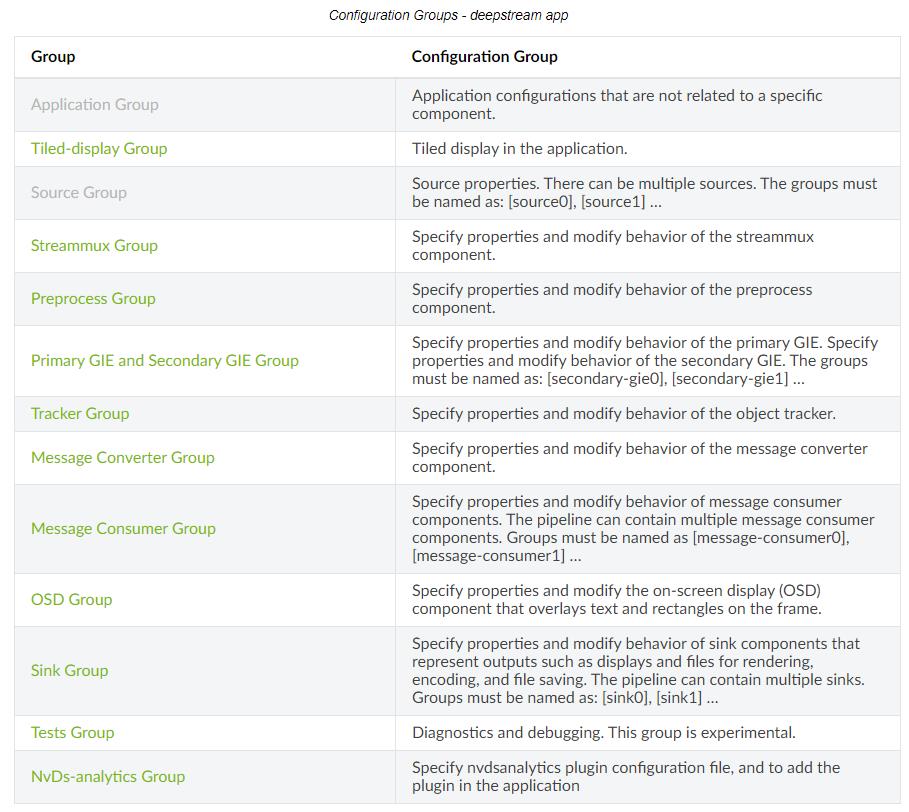

deepstream-app 的配置被拆成了组的形式进行积木搭建,主要有以下这些组:

每个具体的 groups 中又会有很多的配置参数,其中 Primary GIE and Secondary GIE Group 这个插件就是加载 TensorRT ENG 进行推理用的,这里 NVIDIA 的官方文档讲的十分清楚,可以进行相应的查询,这里就不多说了,传送:https://docs.nvidia.com/metropolis/deepstream/dev-guide/text/DS_ref_app_deepstream.html#application-group

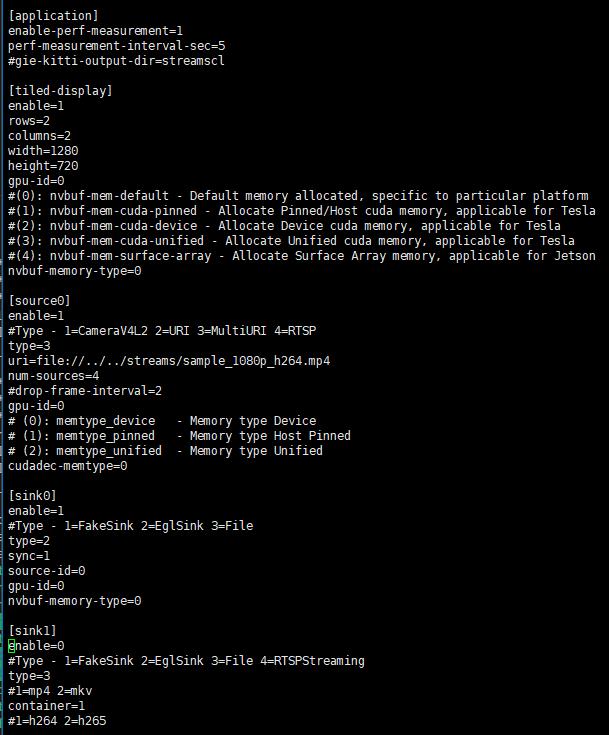

随便看一些实际跑 deepstream-app 的时候 config 里的东西:

可以看到像 application、tiled-display、source、sink… 这些都是可以从上面 NVIDIA 中给出的查询表中查到对应的配置说明的,需要修改的话对应修改一下就行了,这也是 deepstream 的初衷,按功能拆分成小插件,以插件化搭积木形式快速构建深度学习应用,使用者不需要深入理解每个小插件的开发方式。

3、deepstream-app 的使用效果

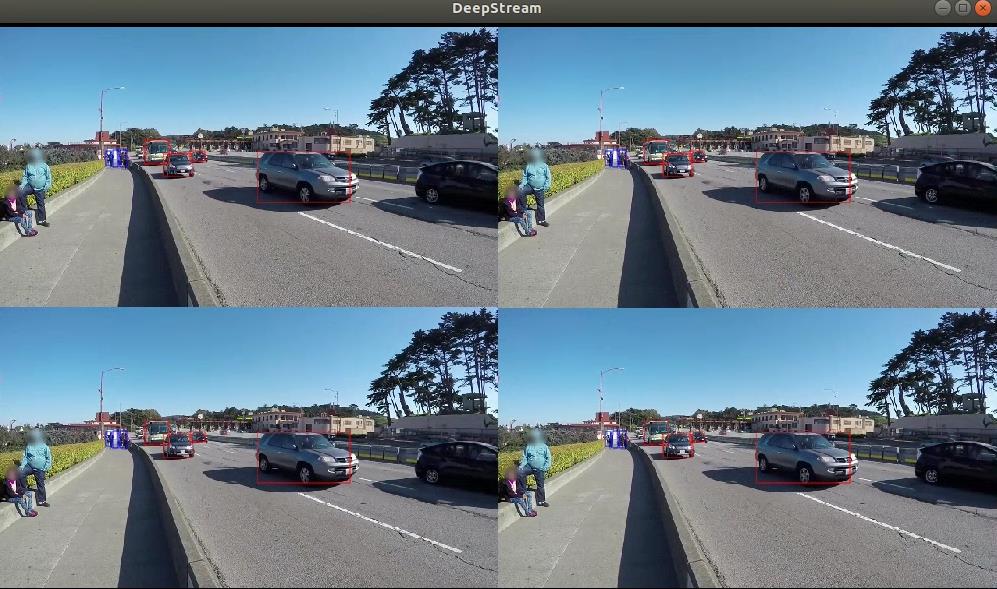

按如下操作演示一个例程:

cd /opt/nvidia/deepstream/deepstream/samples/configs/deepstream-app

deepstream -c ./source4_1080p_dec_infer-resnet_tracker_sgie_tiled_display_int8.txt

会蹦出一个演示视频来,这里放了个截图,效果还是不错的。

这里分享和介绍了一下 deepstream-app 的使用和配置说明,希望我的分享能对你的学习有一点帮助。

【公众号传送】

扫描下方二维码即可关注我的微信公众号【极智视界】,获取更多AI经验分享,让我们用极致+极客的心态来迎接AI !

以上是关于模型推理deepstream-app 介绍的主要内容,如果未能解决你的问题,请参考以下文章

模型推理加速系列BERT加速方案对比 TorchScript vs. ONNX

模型推理加速系列04:BERT加速方案对比 TorchScript vs. ONNX