[Linux 高并发服务器] I/O 多路复用

Posted 鱼竿钓鱼干

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了[Linux 高并发服务器] I/O 多路复用相关的知识,希望对你有一定的参考价值。

[Linux 高并发服务器] IO多路复用

文章概述

该文章为 牛客C++项目课:Linux高并发服务器 的个人笔记,记录了IO多路复用相关的知识点

作者信息

NEFU 2020级 zsl

ID:fishingrod/鱼竿钓鱼干

Email:851892190@qq.com

欢迎各位引用此博客,引用时在显眼位置放置原文链接和作者基本信息

参考资料

感谢前辈们留下的优秀资料,从中学到很多,冒昧引用,如有冒犯可以私信或者在评论区下方指出

| 标题 | 作者 | 引用处 |

|---|---|---|

| Linux 高并发服务器 | 牛客网 | 贯穿全文,以此为基础 |

| select、poll和epoll的区别和 IO多路复用模型讲解 | IT生涯 | 对比三zhongIO多路复用的补充 |

| IO多路复用底层原理分析 | CallMeJiaGu | 自己写的检测和select的差距在哪里 |

| 服务端经典的C10k问题(译) | kbryanzhang | C10K问题译文 |

| 高性能网络编程(二):上一个10年,著名的C10K并发连接问题 | Jack Jiang | C10问题概览和分析 |

另外,各位可以看一下张龙远前辈写的《C++服务器开发精髓》个人觉得可以和牛客的课程对上,然后会有更多细节的补充。

正文部分

I/O 多路复用(I/O 多路转接)的概念

I/O 多路复用使得程序能同时监听多个文件描述符,能够提高程序的性能,Linux 下实现 I/O 多路复用的系统调用主要有 select、poll 和 epoll

这里的I/O实际上指的是读写缓冲区的操作,不要局限于文件和内存之间的信息传输

常见的IO模型

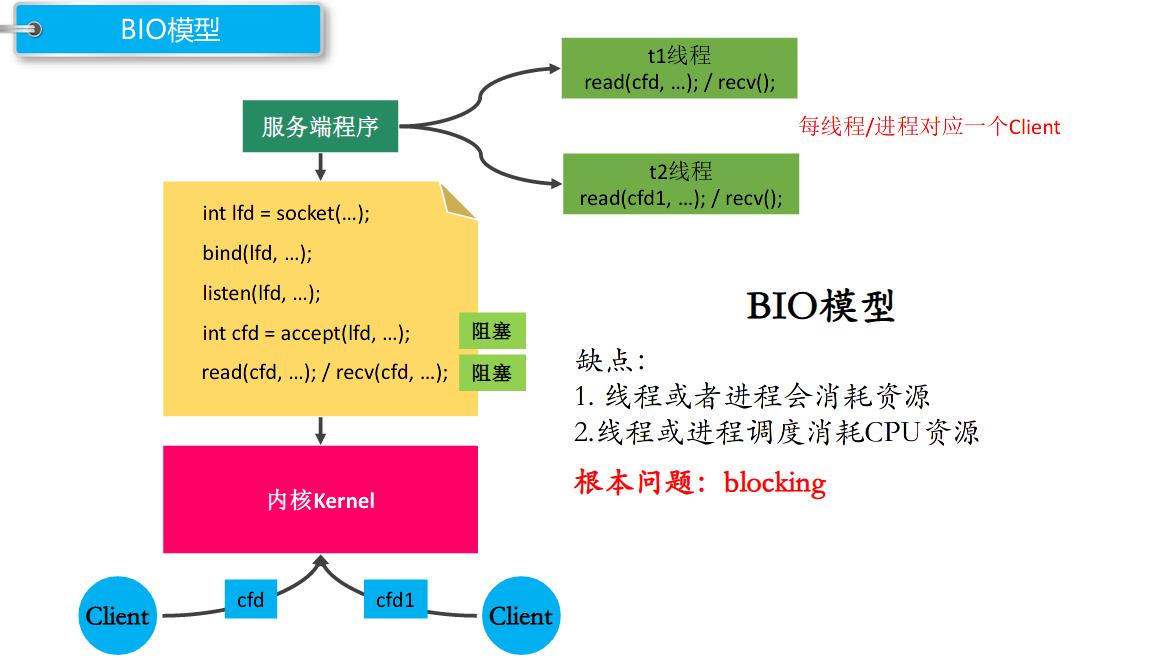

BIO模型

阻塞等待

我们直接设置阻塞的IO函数等待数据传过来然后进行处理,这么做的好处是不占用CPU宝贵的时间片,但是同一时刻只能处理一个操作

为了解决这一问题,我们可以采用多进程和多线程并发技术,这么做的缺点是线程或进程会消耗资源,线程或进程调度也会消耗CPU资源

实际上多线程和多进程并没有解决根本阻塞问题,在子进程子线程当中仍然会阻塞,只不过不会因为一个阻塞等待导致其他请求没法处理

取自牛客网教程的ppt

C10K Problem

这里可以了解一下C10K问题,译文和概览分析已经放在参考资料里了

对于C10K问题的解决思路主要有两个方向:

- 每个进程/线程处理单个链接,然后搭配多进程/线程

- 每个进程/线程处理多个链接,IO多路复用

第一个思路就是BIO模型,阻塞等待+多线程多进程,然而随着互联网的发展,并发需求越来越高,传统的进程/线程服务器模型因为进程/线程消耗资源过大,无法真正解决C10K问题。C10K问题的核心在于减少CPU等核心计算资源的使用。

下面介绍的NIO模型搭配上IO多路复用技术可以较好的解决C10K问题

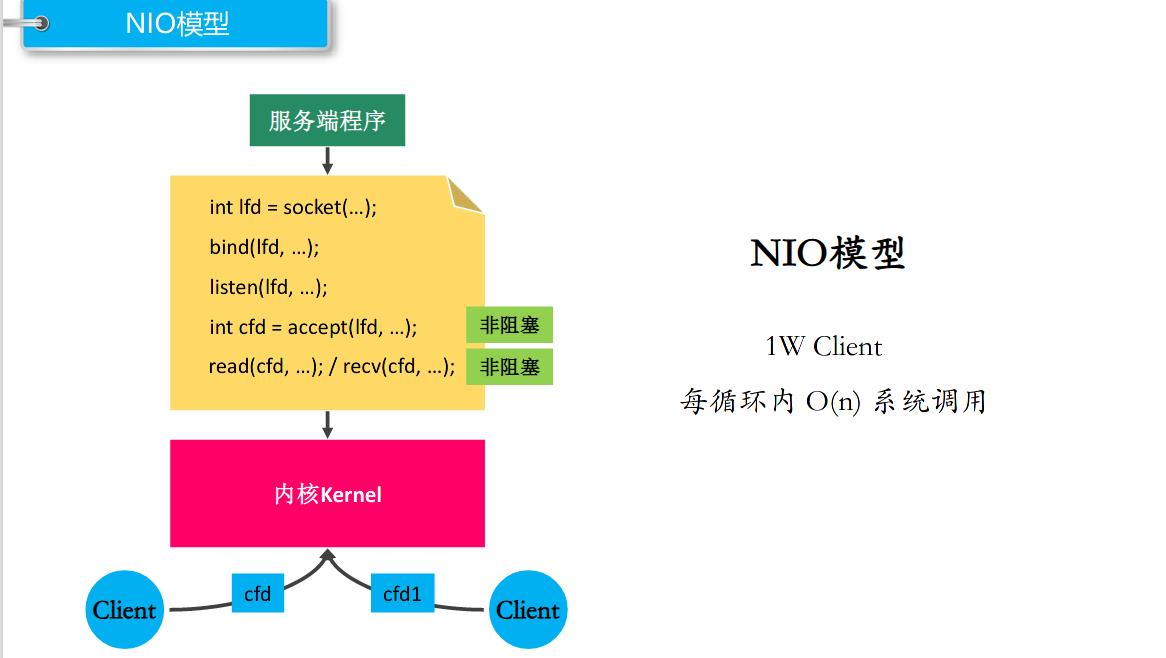

NIO 模型

非阻塞忙轮询

程序每隔一段时间询问一次有没有数据有没有到达,优点是提高了程序的执行效率,缺点是需要占用更多的CPU和系统资源

取自牛客网PPT

解决方案是采用I/O 多路复用技术

I/O 多路复用技术

如果让我们直接写一个NIO模型那么很可能是下面这样的结构

代码摘自IO多路复用底层原理分析

while true {

for(i in stream[]) {

if(i has data)

read until unavailable

}

}

这么做的缺点是,如果没有准备就绪的流,那么就会浪费很多时间。解决方案是如果没有就绪的流就阻塞起来,直到出现准备就绪的流

我个人感觉这个有点像多进程/线程模型当中的条件变量,检测到符合条件的才开始工作。

select

委托内核查看有几个文件描述符有数据到了,但是不能告诉你具体是那几个,底层检测是靠二进制位来实现的,具体要看哪几个还是要轮询。

select的主旨思想:

摘自牛客PDF

- 首先要构造一个关于文件描述符的列表,将要监听的文件描述符添加到该列表中。

- 调用一个系统函数,监听该列表中的文件描述符,直到这些描述符中的一个或者多个进行I/O

操作时,该函数才返回。

a.这个函数是阻塞

b.函数对文件描述符的检测的操作是由内核完成的- 在返回时,它会告诉进程有多少(哪些)描述符要进行I/O操作。

代码示例:

服务端

#include <stdio.h>

#include <arpa/inet.h>

#include <unistd.h>

#include <stdlib.h>

#include <string.h>

#include <sys/select.h>

int main() {

// 创建socket

int lfd = socket(PF_INET, SOCK_STREAM, 0);

struct sockaddr_in saddr;

saddr.sin_port = htons(9999);

saddr.sin_family = AF_INET;

saddr.sin_addr.s_addr = INADDR_ANY;

// 绑定

bind(lfd, (struct sockaddr *)&saddr, sizeof(saddr));

// 监听

listen(lfd, 8);

// 创建一个fd_set的集合,存放的是需要检测的文件描述符

fd_set rdset, tmp;

FD_ZERO(&rdset);

FD_SET(lfd, &rdset);

int maxfd = lfd;

while(1) {

tmp = rdset;

// 调用select系统函数,让内核帮检测哪些文件描述符有数据

int ret = select(maxfd + 1, &tmp, NULL, NULL, NULL);

if(ret == -1) {

perror("select");

exit(-1);

} else if(ret == 0) {

continue;

} else if(ret > 0) {

// 说明检测到了有文件描述符的对应的缓冲区的数据发生了改变

if(FD_ISSET(lfd, &tmp)) {

// 表示有新的客户端连接进来了

struct sockaddr_in cliaddr;

int len = sizeof(cliaddr);

int cfd = accept(lfd, (struct sockaddr *)&cliaddr, &len);

// 将新的文件描述符加入到集合中

FD_SET(cfd, &rdset);

// 更新最大的文件描述符

maxfd = maxfd > cfd ? maxfd : cfd;

}

for(int i = lfd + 1; i <= maxfd; i++) {

if(FD_ISSET(i, &tmp)) {

// 说明这个文件描述符对应的客户端发来了数据

char buf[1024] = {0};

int len = read(i, buf, sizeof(buf));

if(len == -1) {

perror("read");

exit(-1);

} else if(len == 0) {

printf("client closed...\\n");

close(i);

FD_CLR(i, &rdset);

} else if(len > 0) {

printf("read buf = %s\\n", buf);

write(i, buf, strlen(buf) + 1);

}

}

}

}

}

close(lfd);

return 0;

}

客户端

#include <stdio.h>

#include <arpa/inet.h>

#include <stdlib.h>

#include <unistd.h>

#include <string.h>

int main() {

// 创建socket

int fd = socket(PF_INET, SOCK_STREAM, 0);

if(fd == -1) {

perror("socket");

return -1;

}

struct sockaddr_in seraddr;

inet_pton(AF_INET, "127.0.0.1", &seraddr.sin_addr.s_addr);

seraddr.sin_family = AF_INET;

seraddr.sin_port = htons(9999);

// 连接服务器

int ret = connect(fd, (struct sockaddr *)&seraddr, sizeof(seraddr));

if(ret == -1){

perror("connect");

return -1;

}

int num = 0;

while(1) {

char sendBuf[1024] = {0};

sprintf(sendBuf, "send data %d", num++);

write(fd, sendBuf, strlen(sendBuf) + 1);

// 接收

int len = read(fd, sendBuf, sizeof(sendBuf));

if(len == -1) {

perror("read");

return -1;

}else if(len > 0) {

printf("read buf = %s\\n", sendBuf);

} else {

printf("服务器已经断开连接...\\n");

break;

}

// sleep(1);

usleep(1000);

}

close(fd);

return 0;

}

select的缺陷

- 每次调用select要把fd从用户态拷贝到内核态,时间开销大

- select在内核中也是对fd进行遍历,如果fd很多开销也很大

- select支持的文件描述符数量太少了

- fds集合不能重用,每次需要重置

代码示例

poll

poll和select区别不大,主要解决了selct文件描述符限制的问题,因为他是用链表实现的。但是其他几个缺陷还是没有解决

代码示例

服务端

#include <stdio.h>

#include <arpa/inet.h>

#include <unistd.h>

#include <stdlib.h>

#include <string.h>

#include <poll.h>

int main() {

// 创建socket

int lfd = socket(PF_INET, SOCK_STREAM, 0);

struct sockaddr_in saddr;

saddr.sin_port = htons(9999);

saddr.sin_family = AF_INET;

saddr.sin_addr.s_addr = INADDR_ANY;

// 绑定

bind(lfd, (struct sockaddr *)&saddr, sizeof(saddr));

// 监听

listen(lfd, 8);

// 初始化检测的文件描述符数组

struct pollfd fds[1024];

for(int i = 0; i < 1024; i++) {

fds[i].fd = -1;

fds[i].events = POLLIN;

}

fds[0].fd = lfd;

int nfds = 0;

while(1) {

// 调用poll系统函数,让内核帮检测哪些文件描述符有数据

int ret = poll(fds, nfds + 1, -1);

if(ret == -1) {

perror("poll");

exit(-1);

} else if(ret == 0) {

continue;

} else if(ret > 0) {

// 说明检测到了有文件描述符的对应的缓冲区的数据发生了改变

if(fds[0].revents & POLLIN) {

// 表示有新的客户端连接进来了

struct sockaddr_in cliaddr;

int len = sizeof(cliaddr);

int cfd = accept(lfd, (struct sockaddr *)&cliaddr, &len);

// 将新的文件描述符加入到集合中

for(int i = 1; i < 1024; i++) {

if(fds[i].fd == -1) {

fds[i].fd = cfd;

fds[i].events = POLLIN;

break;

}

}

// 更新最大的文件描述符的索引

nfds = nfds > cfd ? nfds : cfd;

}

for(int i = 1; i <= nfds; i++) {

if(fds[i].revents & POLLIN) {

// 说明这个文件描述符对应的客户端发来了数据

char buf[1024] = {0};

int len = read(fds[i].fd, buf, sizeof(buf));

if(len == -1) {

perror("read");

exit(-1);

} else if(len == 0) {

printf("client closed...\\n");

close(fds[i].fd);

fds[i].fd = -1;

} else if(len > 0) {

printf("read buf = %s\\n", buf);

write(fds[i].fd, buf, strlen(buf) + 1);

}

}

}

}

}

close(lfd);

return 0;

}

客户端

#include <stdio.h>

#include <arpa/inet.h>

#include <stdlib.h>

#include <unistd.h>

#include <string.h>

int main() {

// 创建socket

int fd = socket(PF_INET, SOCK_STREAM, 0);

if(fd == -1) {

perror("socket");

return -1;

}

struct sockaddr_in seraddr;

inet_pton(AF_INET, "127.0.0.1", &seraddr.sin_addr.s_addr);

seraddr.sin_family = AF_INET;

seraddr.sin_port = htons(9999);

// 连接服务器

int ret = connect(fd, (struct sockaddr *)&seraddr, sizeof(seraddr));

if(ret == -1){

perror("connect");

return -1;

}

int num = 0;

while(1) {

char sendBuf[1024] = {0};

sprintf(sendBuf, "send data %d", num++);

write(fd, sendBuf, strlen(sendBuf) + 1);

// 接收

int len = read(fd, sendBuf, sizeof(sendBuf));

if(len == -1) {

perror("read");

return -1;

}else if(len > 0) {

printf("read buf = %s\\n", sendBuf);

} else {

printf("服务器已经断开连接...\\n");

break;

}

// sleep(1);

usleep(1000);

}

close(fd);

return 0;

}

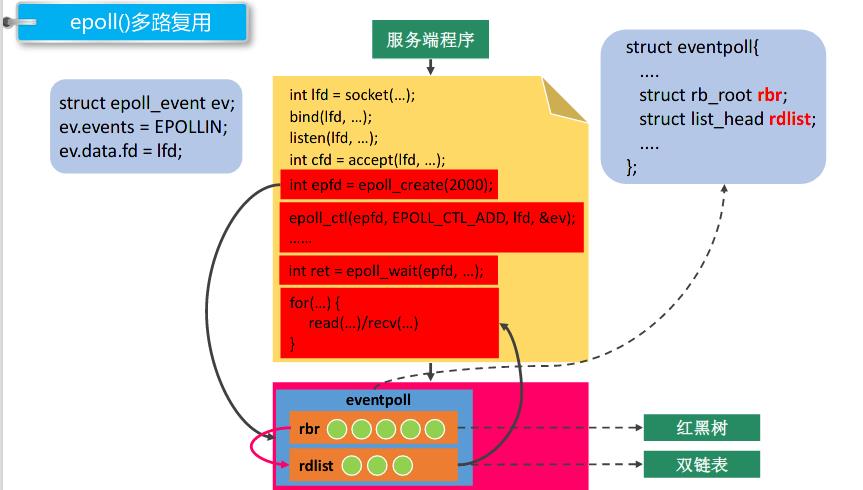

epoll

摘自牛客网PPT

epoll相比select/poll有了以下改进

- 仍然会进入内核态,但是不用拷贝fd之类的信息了

- 采用红黑树检测文件描述符号信息,提高了检测效率

- 使用双向链表存放检测到数据发生改变的文件描述符

代码示例

服务端

#include <stdio.h>

#include <arpa/inet.h>

#include <unistd.h>

#include <stdlib.h>

#include <string.h>

#include <sys/epoll.h>

int main() {

// 创建socket

int lfd = socket(PF_INET, SOCK_STREAM, 0);

struct sockaddr_in saddr;

saddr.sin_port = htons(9999);

saddr.sin_family = AF_INET;

saddr.sin_addr.s_addr = INADDR_ANY;

// 绑定

bind(lfd, (struct sockaddr *)&saddr, sizeof(saddr));

// 监听

listen(lfd, 8);

// 调用epoll_create()创建一个epoll实例

int epfd = epoll_create(100);

// 将监听的文件描述符相关的检测信息添加到epoll实例中

struct epoll_event epev;

epev.events = EPOLLIN;

epev.data.fd = lfd;

epoll_ctl(epfd, EPOLL_CTL_ADD, lfd, &epev);

struct epoll_event epevs[