大数据HDFS应用开发

Posted 赵广陆

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了大数据HDFS应用开发相关的知识,希望对你有一定的参考价值。

目录

1 HDFS 的 Shell 操作(开发重点)

通过前面的学习,我们对HDFS有了基本的了解,下面我们就想实际操作一下,来通过实操加深对HDFS的理解

针对HDFS,我们可以在shell命令行下进行操作,就类似于我们操作linux中的文件系统一样,但是具体命令的操作格式是有一些区别的

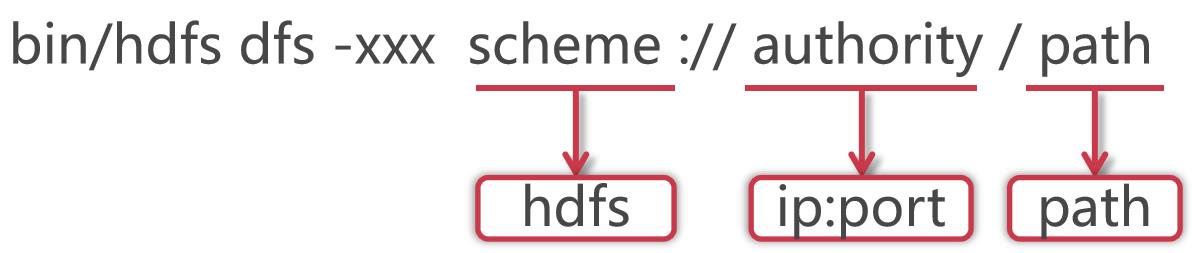

格式如下:

使用hadoop bin目录的hdfs命令,后面指定dfs,表示是操作分布式文件系统的,这些属于固定格式。

如果在PATH中配置了hadoop的bin目录,那么这里可以直接使用hdfs就可以了

这里的xxx是一个占位符,具体我们想对hdfs做什么操作,就可以在这里指定对应的命令了

大多数hdfs 的命令和对应的Linux命令类似

HDFS的schema是hdfs,authority是集群中namenode所在节点的ip和对应的端口号,把ip换成主机名也是一样的,path是我们要操作的文件路径信息

其实后面这一长串内容就是core-site.xml配置文件中fs.defaultFS属性的值,这个代表的是HDFS的地址。

2 HDFS的常见Shell操作

下面我们就来学习一下HDFS中的一些常见的shell操作

其实hdfs后面支持很多的参数,但是有很多是很少用的,在这里我们把一些常用的带着大家一块学习一下,如果大家后期有一些特殊的需求,可以试着来看一下hdfs的帮助文档

直接在命令行中输入hdfs dfs,可以查看dfs后面可以跟的所有参数

注意:这里面的[]表示是可选项,<>表示是必填项

[root@bigdata01 hadoop-3.2.0]# hdfs dfs

Usage: hadoop fs [generic options]

[-appendToFile <localsrc> ... <dst>]

[-cat [-ignoreCrc] <src> ...]

[-checksum <src> ...]

[-chgrp [-R] GROUP PATH...]

[-chmod [-R] <MODE[,MODE]... | OCTALMODE> PATH...]

[-chown [-R] [OWNER][:[GROUP]] PATH...]

[-copyFromLocal [-f] [-p] [-l] [-d] [-t <thread count>] <localsrc> ... <dst>]

[-copyToLocal [-f] [-p] [-ignoreCrc] [-crc] <src> ... <localdst>]

[-count [-q] [-h] [-v] [-t [<storage type>]] [-u] [-x] [-e] <path> ...]

[-cp [-f] [-p | -p[topax]] [-d] <src> ... <dst>]

[-createSnapshot <snapshotDir> [<snapshotName>]]

[-deleteSnapshot <snapshotDir> <snapshotName>]

[-df [-h] [<path> ...]]

[-du [-s] [-h] [-v] [-x] <path> ...]

[-expunge]

[-find <path> ... <expression> ...]

[-get [-f] [-p] [-ignoreCrc] [-crc] <src> ... <localdst>]

[-getfacl [-R] <path>]

[-getfattr [-R] {-n name | -d} [-e en] <path>]

[-getmerge [-nl] [-skip-empty-file] <src> <localdst>]

[-head <file>]

[-help [cmd ...]]

[-ls [-C] [-d] [-h] [-q] [-R] [-t] [-S] [-r] [-u] [-e] [<path> ...]]

[-mkdir [-p] <path> ...]

[-moveFromLocal <localsrc> ... <dst>]

[-moveToLocal <src> <localdst>]

[-mv <src> ... <dst>]

[-put [-f] [-p] [-l] [-d] <localsrc> ... <dst>]

[-renameSnapshot <snapshotDir> <oldName> <newName>]

[-rm [-f] [-r|-R] [-skipTrash] [-safely] <src> ...]

[-rmdir [--ignore-fail-on-non-empty] <dir> ...]

[-setfacl [-R] [{-b|-k} {-m|-x <acl_spec>} <path>]|[--set <acl_spec> <path>]]

[-setfattr {-n name [-v value] | -x name} <path>]

[-setrep [-R] [-w] <rep> <path> ...]

[-stat [format] <path> ...]

[-tail [-f] <file>]

[-test -[defsz] <path>]

[-text [-ignoreCrc] <src> ...]

[-touch [-a] [-m] [-t TIMESTAMP ] [-c] <path> ...]

[-touchz <path> ...]

[-truncate [-w] <length> <path> ...]

[-usage [cmd ...]]

Generic options supported are:

-conf <configuration file> specify an application configuration file

-D <property=value> define a value for a given property

-fs <file:///|hdfs://namenode:port> specify default filesystem URL to use, overrides 'fs.defaultFS' property from configurations.

-jt <local|resourcemanager:port> specify a ResourceManager

-files <file1,...> specify a comma-separated list of files to be copied to the map reduce cluster

-libjars <jar1,...> specify a comma-separated list of jar files to be included in the classpath

-archives <archive1,...> specify a comma-separated list of archives to be unarchived on the compute machines

The general command line syntax is:

command [genericOptions] [commandOptions]

2.1 ls:查询指定路径信息

首先看第一个ls命令

查看hdfs根目录下的内容,什么都不显示,因为默认情况下hdfs中什么都没有

[root@bigdata01 hadoop-3.2.0]# hdfs dfs -ls hdfs://bigdata01:9000/

[root@bigdata01 hadoop-3.2.0]#

其实后面hdfs的url这一串内容在使用时默认是可以省略的,因为hdfs在执行的时候会根据HDOOP_HOME自动识别配置文件中的fs.defaultFS属性

所以这样简写也是可以的

[root@bigdata01 hadoop-3.2.0]# hdfs dfs -ls /

[root@bigdata01 hadoop-3.2.0]#

2.2 put:从本地上传文件

接下来我们向hdfs中上传一个文件,使用Hadoop中的README.txt,直接上传到hdfs的根目录即可

[root@bigdata01 hadoop-3.2.0]# hdfs dfs -put README.txt /

上传成功之后没有任何提示,注意,没有提示就是最好的结果

确认一下刚才上传的文件

[root@bigdata01 hadoop-3.2.0]# hdfs dfs -ls /

Found 1 items

-rw-r--r-- 2 root supergroup 1361 2020-04-08 15:34 /README.txt

在这里可以发现使用hdfs中的ls查询出来的信息和在linux中执行ll查询出来的信息是类似的

在这里能看到这个文件就说明刚才的上传操作是成功的

2.3 cat:查看HDFS文件内容

文件上传上去以后,我们还想查看一下HDFS中文件的内容,很简单,使用cat即可

[root@bigdata01 hadoop-3.2.0]# hdfs dfs -cat /README.txt

For the latest information about Hadoop, please visit our website at:

http://hadoop.apache.org/

and our wiki, at:

http://wiki.apache.org/hadoop/

...........

2.4 get:下载文件到本地

如果我们想把hdfs中的文件下载到本地linux文件系统中需要怎么做呢?使用get即可实现

[root@bigdata01 hadoop-3.2.0]# hdfs dfs -get /README.txt .

get: `README.txt': File exists

注意:这样执行报错了,提示文件已存在,我这条命令的意思是要把HDFS中的README.txt下载当前目录中,但是当前目录中已经有这个文件了,要么换到其它目录,要么给文件重命名

[root@bigdata01 hadoop-3.2.0]# hdfs dfs -get /README.txt README.txt.bak

[root@bigdata01 hadoop-3.2.0]# ll

total 188

drwxr-xr-x. 2 1001 1002 203 Jan 8 2019 bin

drwxr-xr-x. 3 1001 1002 20 Jan 8 2019 etc

drwxr-xr-x. 2 1001 1002 106 Jan 8 2019 include

drwxr-xr-x. 3 1001 1002 20 Jan 8 2019 lib

drwxr-xr-x. 4 1001 1002 4096 Jan 8 2019 libexec

-rw-rw-r--. 1 1001 1002 150569 Oct 19 2018 LICENSE.txt

-rw-rw-r--. 1 1001 1002 22125 Oct 19 2018 NOTICE.txt

-rw-rw-r--. 1 1001 1002 1361 Oct 19 2018 README.txt

-rw-r--r--. 1 root root 1361 Apr 8 15:41 README.txt.bak

drwxr-xr-x. 3 1001 1002 4096 Apr 7 22:08 sbin

drwxr-xr-x. 4 1001 1002 31 Jan 8 2019 share

2.5 mkdir [-p]:创建文件夹

后期我们需要在hdfs中维护很多文件,所以就需要创建文件夹来进行分类管理了

下面我们来创建一个文件夹,hdfs中使用mkdir命令

[root@bigdata01 hadoop-3.2.0]# hdfs dfs -mkdir /test

[root@bigdata01 hadoop-3.2.0]# hdfs dfs -ls /

Found 2 items

-rw-r--r-- 2 root supergroup 1361 2020-04-08 15:34 /README.txt

drwxr-xr-x - root supergroup 0 2020-04-08 15:43 /test

如果要递归创建多级目录,还需要再指定-p参数

[root@bigdata01 hadoop-3.2.0]# hdfs dfs -mkdir -p /abc/xyz

You have new mail in /var/spool/mail/root

[root@bigdata01 hadoop-3.2.0]# hdfs dfs -ls /

Found 3 items

-rw-r--r-- 2 root supergroup 1361 2020-04-08 15:34 /README.txt

drwxr-xr-x - root supergroup 0 2020-04-08 15:44 /abc

drwxr-xr-x - root supergroup 0 2020-04-08 15:43 /test

想要递归显示所有目录的信息,可以在ls后面添加-R参数

[root@bigdata01 hadoop-3.2.0]# hdfs dfs -ls -R /

-rw-r--r-- 2 root supergroup 1361 2020-04-08 15:34 /README.txt

drwxr-xr-x - root supergroup 0 2020-04-08 15:44 /abc

drwxr-xr-x - root supergroup 0 2020-04-08 15:44 /abc/xyz

drwxr-xr-x - root supergroup 0 2020-04-08 15:43 /test

2.6 rm [-r]:删除文件/文件夹

如果想要删除hdfs中的目录或者文件,可以使用rm

删除文件

[root@bigdata01 hadoop-3.2.0]# hdfs dfs -rm /README.txt

Deleted /README.txt

删除目录,注意,删除目录需要指定-r参数

[root@bigdata01 hadoop-3.2.0]# hdfs dfs -rm /test

rm: `/test': Is a directory

[root@bigdata01 hadoop-3.2.0]# hdfs dfs -rm -r /test

Deleted /test

如果是多级目录,可以递归删除吗?可以

[root@bigdata01 hadoop-3.2.0]# hdfs dfs -rm -r /abc

Deleted /abc

错误解决:

hdfs上传文件没有权限写入的问题解决put: Permission denied: user=root, access=WRITE

问题:

如题,在上传文件的时候出现没有权限写入的问题:

命令:

hdfs dfs -put dummy_log_data /user/impala/data/logs/year=2013/month=07/day=28/host=host1

报错信息:

put: Permission denied: user=root, access=WRITE, inode="/user/impala/data/logs/year=2013/month=07/day=28/host=host1":hdfs:impala:drwxr-xr-x

解决:

1、查看该用户的权限

[root@hadoop09-test1-rgtj1-tj1 test_pro]# hdfs dfs -ls /user/impala/data/logs/year=2013/month=07/day=28

Found 1 items

drwxr-xr-x - hdfs impala 0 2020-02-17 22:32 /user/impala/data/logs/year=2013/month=07/day=28/host=host1

2、切换用户进行写入

sudo切换用户指定该用户的目录进行上传写入即可。

sudo -uhdfs hdfs dfs -put dummy_log_data /user/impala/data/logs/year=2013/month=07/day=28/host=host1

3 HDFS案例实操

需求:统计HDFS中文件的个数和每个文件的大小

我们先向HDFS中上传几个文件,把hadoop目录中的几个txt文件上传上去

[root@bigdata01 hadoop-3.2.0]# hdfs dfs -put LICENSE.txt /

[root@bigdata01 hadoop-3.2.0]# hdfs dfs -put NOTICE.txt /

[root@bigdata01 hadoop-3.2.0]# hdfs dfs -put README.txt /

1:统计根目录下文件的个数

[root@bigdata01 hadoop-3.2.0]# hdfs dfs -ls / |grep /| wc -l

3

2:统计根目录下每个文件的大小,最终把文件名称和大小打印出来

[root@bigdata01 hadoop-3.2.0]# hdfs dfs -ls / |grep / | awk '{print $8,$5}'

/LICENSE.txt 150569

/NOTICE.txt 22125

/README.txt 1361

4 Java代码操作HDFS

4.1 配置Windows下Hadoop环境

在windows系统需要配置hadoop运行环境,否则直接运行代码会出现以下问题:

缺少winutils.exe

缺少hadoop.dll

步骤:

第一步:将hadoop2.7.5文件夹拷贝到一个没有中文没有空格的路径下面

第二步:在windows上面配置hadoop的环境变量: HADOOP_HOME,并将%HADOOP_HOME%\\bin添加到path中

第三步:把hadoop2.7.5文件夹中bin目录下的hadoop.dll文件放到系统盘:C:\\Windows\\System32 目录

第四步:关闭windows重启

前面我们学习了在shell命令行下操作hdfs,shell中操作hdfs是比较常见的操作,但是在工作中也会遇到一些需求是需要通过代码操作hdfs的,下面我们就来看一下如何使用java代码操作hdfs,在具体操作之前需要先明确一下开发环境,代码编辑器使用idea,当然了eclipse也可以

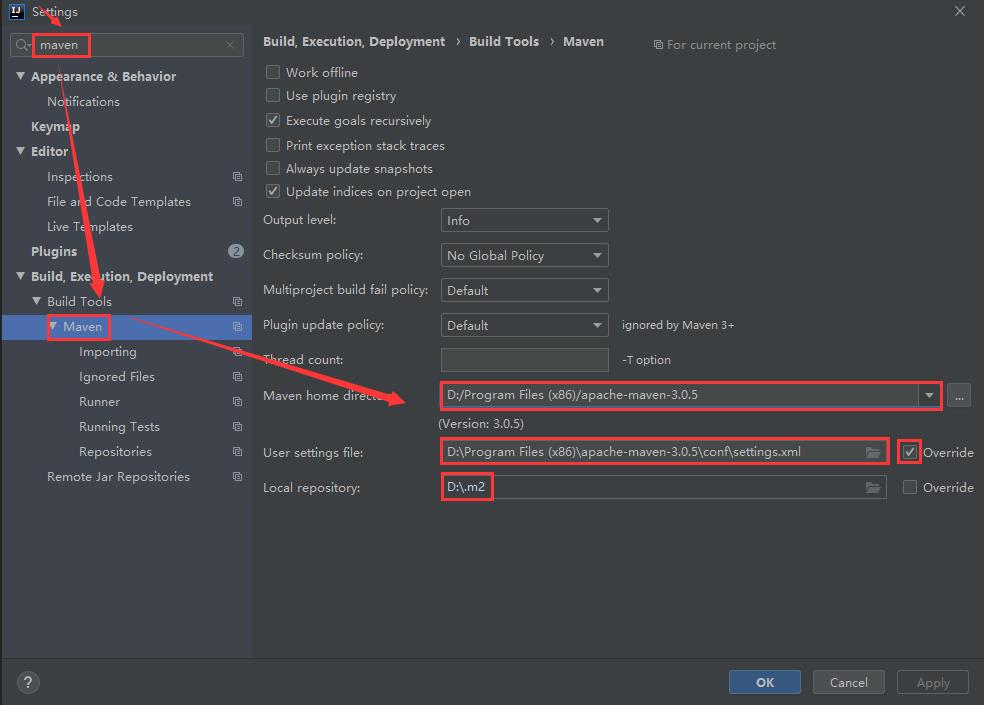

在创建项目的时候我们会创建maven项目,使用maven来管理依赖,是比较方便的。在这里我会把idea的安装包和maven的安装包发给大家,考虑可能会有同学没有使用过maven,所以在这里大致说一下maven在windows中的安装配置。在这里我们使用apache-maven-3.0.5-bin.zip ,当然了,其它版本也可以,没有什么本质的区别,把apache-maven-3.0.5-bin.zip解压到某一个目录下面,在这里我解压到了D:\\Program Files (x86)\\apache-maven-3.0.5目录,解压之后,建议修改一下maven的配置文件,把maven仓库的地址修改到其它盘,例如D盘,默认是在C盘的用户目录下,修改D:\\Program Files (x86)\\apache-maven-3.0.5\\conf下的settings.xml文件,将localRepository标签从注释中移出来,然后将值该为D:.m2,效果如下:

这里的目录名字可以随意起,只要易于识别就可以

<localRepository>D:\\.m2</localRepository>

这样修改之后,maven管理的依赖jar包都会保存到D:.m2目录下了。

接下来需要配置maven的环境变量,和windows中配置JAVA_HOME环境变量是一样的。

先在环境变量中配置M2_HOME=D:\\Program Files (x86)\\apache-maven-3.0.5

然后在PATH环境变量中添加%M2_HOME%\\bin即可

环境变量配置完毕以后,打开cmd窗口,输入mvn命令,只要能正常执行就说明windows本地的maven环境配置好了。

这还没完,还需要在idea中指定我们本地的maven配置

点击idea左上角的File–>Settings,进入如下界面,搜索maven,把本地的maven添加到这里面即可。

下面我们来创建一个maven项目

项目名称为db_hadoop

注意:项目创建好以后,在新打开的界面中需要点击右小角的Enable Auto Import,这样添加到maven依赖会自动引入,否则会发现引入依赖了,但是代码中还是识别不了,这个时候还需要手动引入,比较麻烦。

ok,项目创建好了以后,就需要引入hadoop的依赖了

在这里我们需要引入hadoop-client依赖包,到maven仓库中去找,添加到pom.xml文件中

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>3.2.0</version>

</dependency>

然后创建代码

- 上传文件

package com.imooc.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataOutputStream;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IOUtils;

import java.io.FileInputStream;

import java.net.URI;

/**

* Java代码操作HDFS

* 文件操作:上传文件、下载文件、删除文件

* Created by xuwei

*/

public class HdfsOp {

public static void main(String[] args) throws Exception{

//创建一个配置对象

Configuration conf = new Configuration();

//指定HDFS的地址

conf.set("fs.defaultFS","hdfs://bigdata01:9000");

//获取操作HDFS的对象

FileSystem fileSystem = FileSystem.get(conf);

//获取HDFS文件系统的输出流

FSDataOutputStream fos = fileSystem.create(new Path("/user.txt"));

//获取本地文件的输入流

FileInputStream fis = new FileInputStream("D:\\\\user.txt");

//上传文件:通过工具类把输入流拷贝到输出流里面,实现本地文件上传到HDFS

IOUtils.copyBytes(fis,fos,1024,true);

}

}

执行代码,发现报错,提示权限拒绝,说明windows中的这个用户没有权限向HDFS中写入数据

Caused by: org.apache.hadoop.ipc.RemoteException(org.apache.hadoop.security.AccessControlException): Permission denied: user=yehua, access=WRITE, inode="/":root:supergroup:drwxr-xr-x

解决办法有两个

第一种:去掉hdfs的用户权限检验机制,通过在hdfs-site.xml中配置dfs.permissions.enabled为false即可

第二种:把代码打包到linux中执行

在这里为了在本地测试方便,我们先使用第一种方式

1:停止Hadoop集群

[root@bigdata01 ~]# cd /data/soft/hadoop-3.2.0

[root@bigdata01 hadoop-3.2.0]# sbin/stop-all.sh

Stopping namenodes on [bigdata01]

Last login: Wed Apr 8 20:25:17 CST 2020 from 192.168.182.1 on pts/1

Stopping datanodes

Last login: Wed Apr 8 20:25:40 CST 2020 on pts/1

Stopping secondary namenodes [bigdata01]

Last login: Wed Apr 8 20:25:41 CST 2020 on pts/1

Stopping nodemanagers

Last login: Wed Apr 8 20:25:44 CST 2020 on pts/1

Stopping resourcemanager

Last login: Wed Apr 8 20:25:47 CST 2020 on pts/1

2:修改hdfs-site.xml配置文件

注意:集群内所有节点中的配置文件都需要修改,先在bigdata01节点上修改,然后再同步到另外两个节点上

在bigdata01上操作

[root@bigdata01 hadoop-3.2.0]# vi etc/hadoop/hdfs-site.xml

<configuration>

<property>

<name>dfs.replication</name>

<value>2</value>

</property>

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>bigdata01:50090</value>

</property>

<property>

<name>dfs.permissions.enabled</name>

<value>false</value>

</property>

</configuration>

同步到另外两个节点中

[root@bigdata01 hadoop-3.2.0]# scp -rq etc/hadoop/hdfs-site.xml bigdata02:/data/soft/hadoop-3.2.0/etc/hadoop/

[root@bigdata01 hadoop-3.2.0]# scp -rq etc/hadoop/hdfs-site.xml bigdata03:/data/soft/hadoop-3.2.0/etc/hadoop/

3:启动Hadoop集群

[root@bigdata01 hadoop-3.2.0]# sbin/start-all.sh

Starting namenodes on [bigdata01]

Last login: Wed Apr 8 20:25:49 CST 2020 on pts/1

Starting datanodes

Last login: Wed Apr 8 20:29:57 CST 2020 on pts/1

Starting secondary namenodes [bigdata01]

Last login: Wed Apr 8 20:29:59 CST 2020 on pts/1

Starting resourcemanager

Last login: Wed Apr 8 20:30:04 CST 2020 on pts/1

Starting nodemanagers

Last login: Wed Apr 8 20:30:10 CST 2020 on pts/1

重新再执行代码,没有报错,到hdfs上查看数据

[root@bigdata01 hadoop-3.2.0]# hdfs dfs -ls /

Found 4 items

-rw-r--r-- 2 root supergroup 150569 2020-04-08 15:55 /LICENSE.txt

-rw-r--r-- 2 root supergroup 22125 2020-04-08 15:55 /NOTICE.txt

-rw-r--r-- 2 root supergroup 1361 2020-04-08 15:55 /README.txt

-rw-r--r-- 3 yehua supergroup 17 2020-04-08 20:31 /user.txt

[root@bigdata01 hadoop-3.2.0]# hdfs dfs -cat /user.txt

jack

tom

jessic

下面还需要实现其他功能,对代码进行封装提取

package com.imooc.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataOutputStream;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IOUtils;

import java.io.FileInputStream;

import java.io.IOException;

import java.net.URI;

/**

* Java代码操作HDFS

* 文件操作:上传文件、下载文件、删除文件

* Created by xuwei

*/

public class HdfsOp {

public static void main(String[] args) throws Exception{

//创建一个配置对象

Configuration conf = new Configuration();

//指定HDFS的地址

conf.set("fs.defaultFS","hdfs://bigdata01:9000");

//获取操作HDFS的对象

FileSystem fileSystem = FileSystem.get(c以上是关于大数据HDFS应用开发的主要内容,如果未能解决你的问题,请参考以下文章