测试中间件 - Kafka Tool 快速入门

Posted 程序员牧码

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了测试中间件 - Kafka Tool 快速入门相关的知识,希望对你有一定的参考价值。

简介

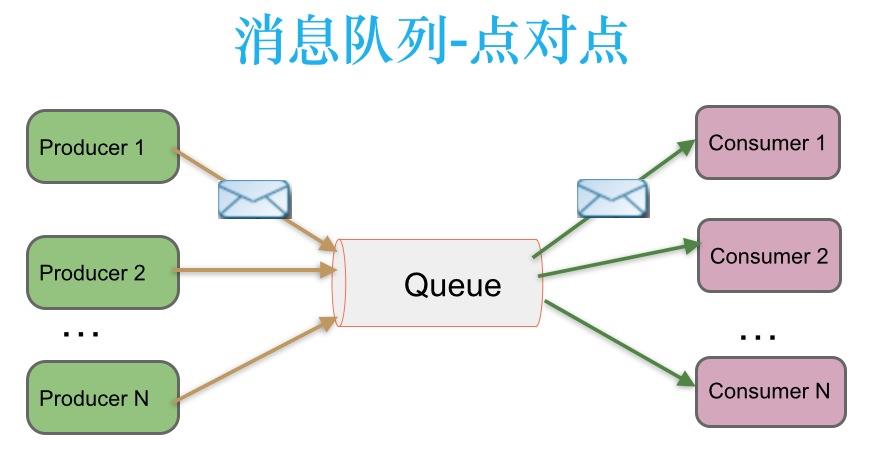

在点对点消息系统中,消息持久化到一个队列中。此时,将有一个或多个消费者消费队列中的数据。但是一条消息只能被消费一次。当一个消费者消费了队列中的某条数据之后,该条数据则从消息队列中删除。该模式即使有多个消费者同时消费数据,也能保证数据处理的顺序。这种架构描述示意图如下

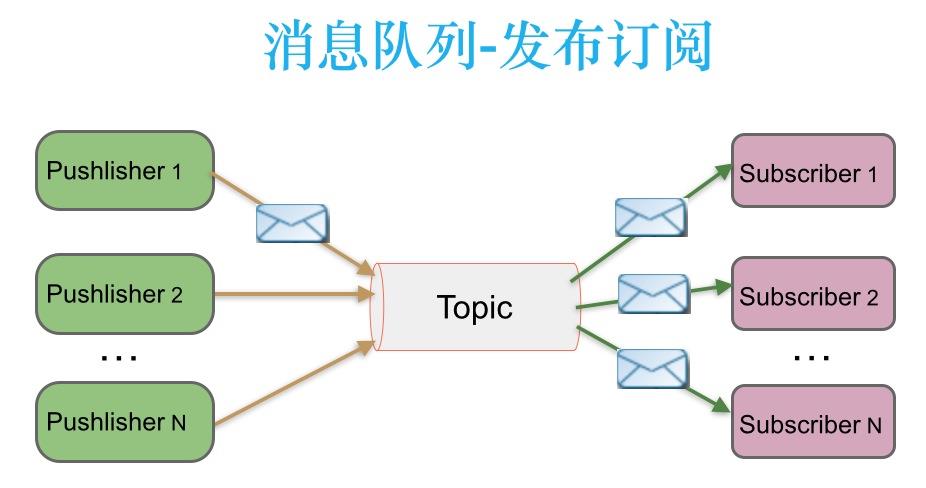

在发布-订阅消息系统中,消息被持久化到一个topic中。与点对点消息系统不同的是,消费者可以订阅一个或多个topic,消费者可以消费该topic中所有的数据,同一条数据可以被多个消费者消费,数据被消费后不会立马删除。在发布-订阅消息系统中,消息的生产者称为发布者,消费者称为订阅者。该模式的示例图如下

总结:不管是用上面哪种模式,只要知道生产者生产数据,通过一些列配置连接中间的管道,然后消费者端也通过一系列配置连接到中间的管道,进行对管道的数据监听,一旦监听到数据,并且符合一定的暗号鉴权,就进行从管道里拿来该数据进行消费。

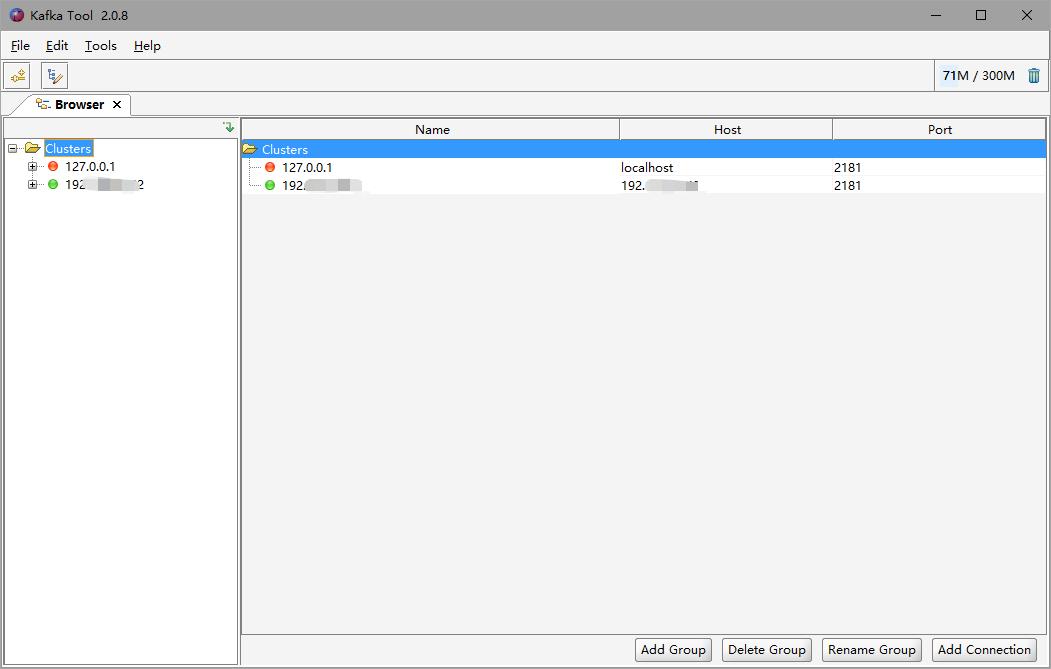

Kafka Tool

连接服务器

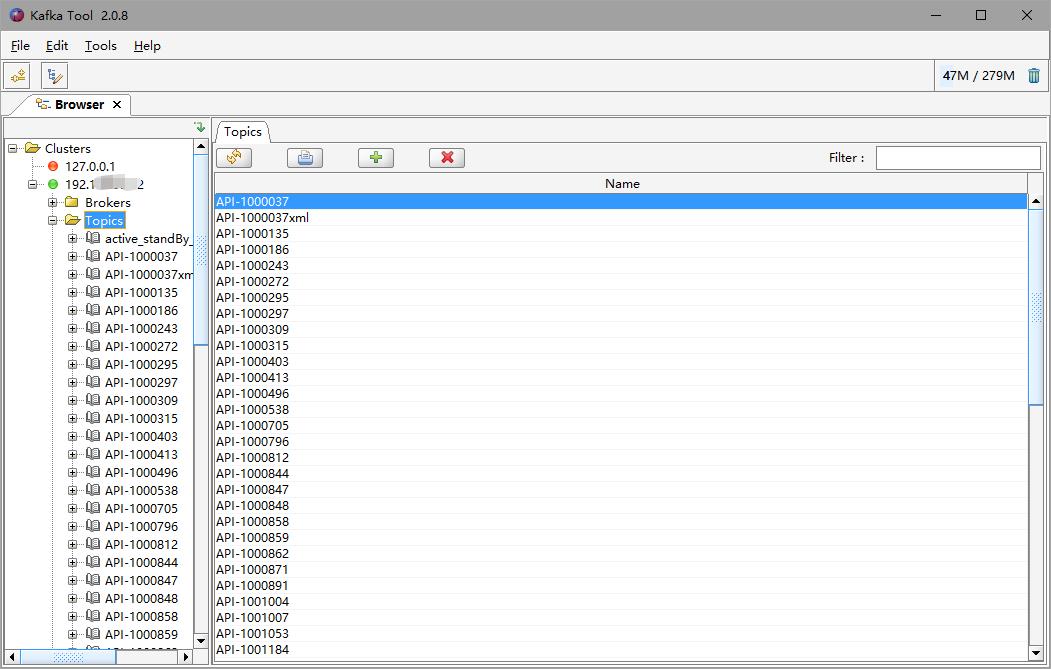

Topic

Partition

分析消息体

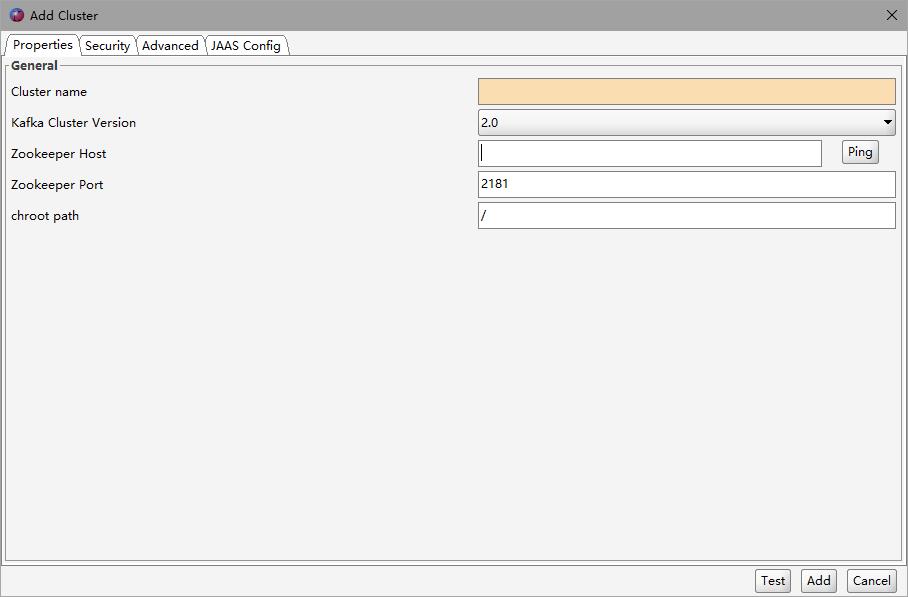

连接 Kafka 服务器

Cluster name:左侧服务器名称,随便填写

Kafka Cluster Version:选择 2.0 即可

Zookeeper Host:IP地址

Zookeeper Port:端口号,默认2181

chroot path:默认 / 即可

在填写完 Zookeeper Host,就可以点击旁边的【Ping】按钮测试下是否 IP 可以连通。

填写完后,可以点击下方的【Test】进行测试 Kafka 服务器是否能连通。

都 OK 后,可以点击下方的【Add】按钮进行添加该服务器到左边列表。

Topic

Topic 的概念可以简单理解成生产者到消费者之间进行数据传递时,当数据规模大到一定程度,每个消费者消费的业务数据都可能不一样,但是数据那么多又集中在管道里,消费者是怎么区分我应该消费哪条数据是我该消费的呢?

此时 Topic 来了,只要生产者发送该数据时,往指定的 topic 管道里发送,消费者也只监听该 topic 管道,说明我监听来的数据一定是我想要的,因为双方“暗号”对上啦~

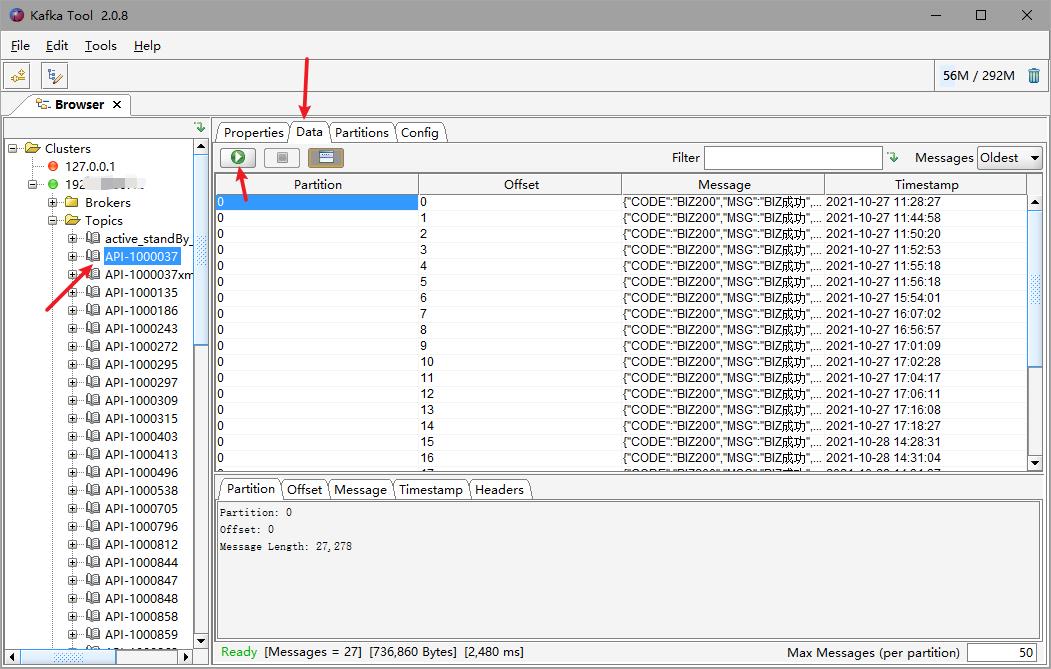

分析消息体(重点)

通过以下箭头操作,就可以看到其中一个 Topic 的消息记录

Partition:与 Redis db 类似,也是 kafka 内部的小数据库分区

Message(重点):消息的详情内容

Timestamp:时间戳,生产者发送时间

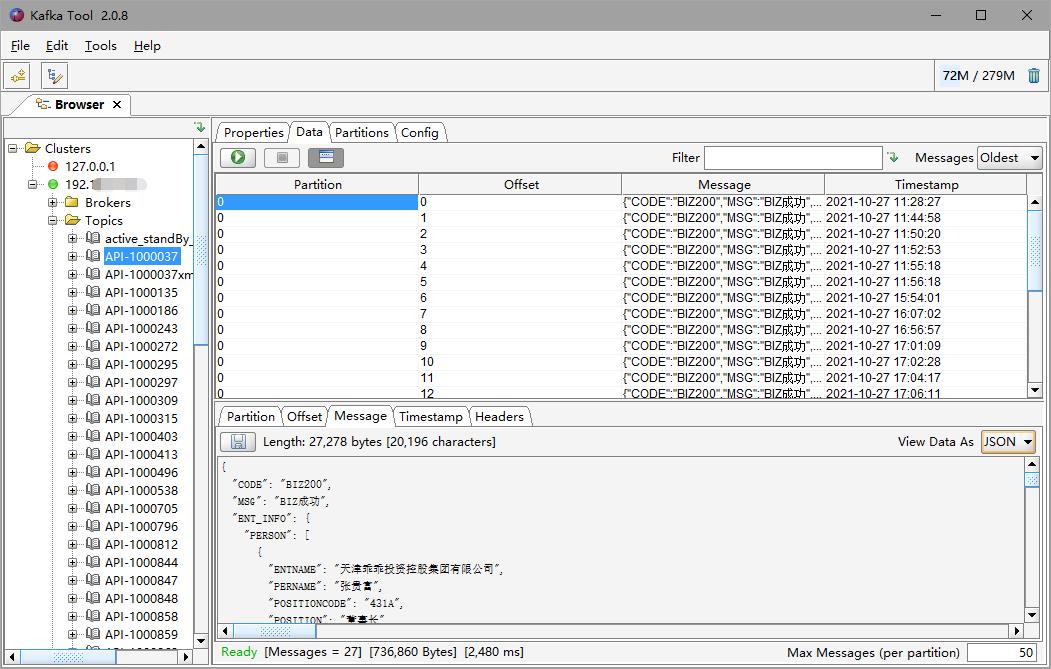

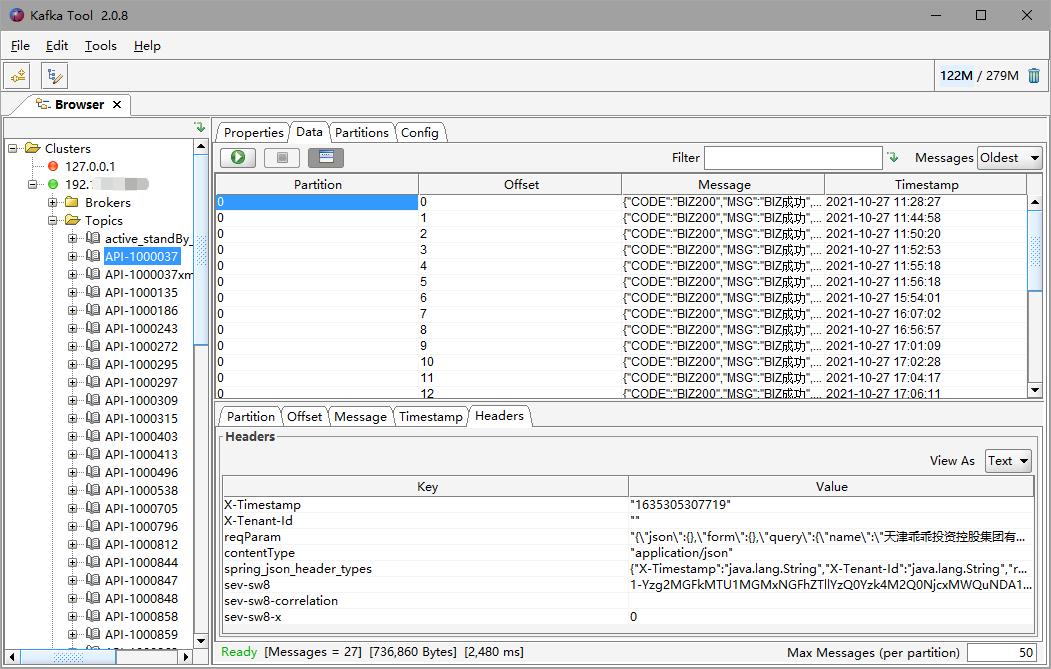

我们选择第一条数据来作为示例,我们只需要关注【Message】【Headers】这两栏就够了

注意:他们都可以切换右上角的【View As】进行数据格式化查看

Message:类型 Http 里的 Body

Headers:类似 Http 里的 Header

以上是关于测试中间件 - Kafka Tool 快速入门的主要内容,如果未能解决你的问题,请参考以下文章