强化学习笔记:Sarsa算法

Posted UQI-LIUWJ

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了强化学习笔记:Sarsa算法相关的知识,希望对你有一定的参考价值。

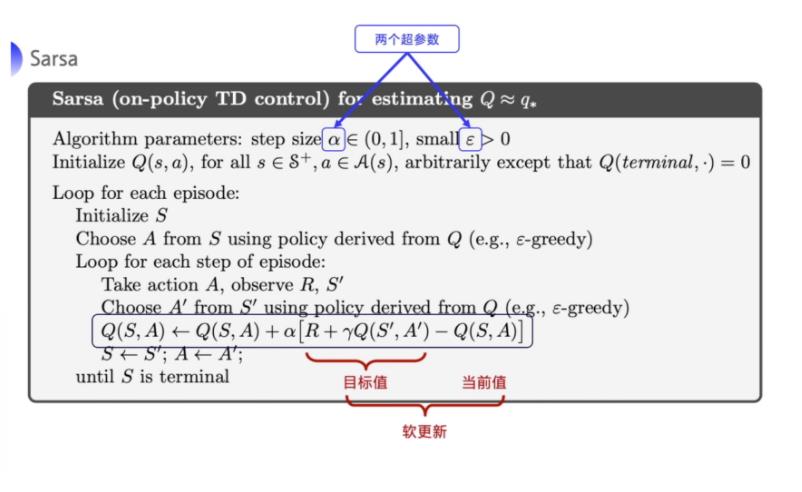

1 Sarsa(0)

Sarsa算法和TD类似,只不过TD是更新状态的奖励函数V,这里是更新Q函数强化学习笔记:Q-learning :temporal difference 方法_UQI-LIUWJ的博客-CSDN博客

| TD |  |

| Sarsa |  |

该算法由于每次更新值函数需要知道当前的状态(state)、当前的动作(action)、奖励(reward)、下一步的状态(state)、下一步的动作(action),即 (St,At,Rt+1,St+1,At+1) 这几个值 ,由此得名 Sarsa 算法。

2 n-step Sarsa

3 与环境交互

右边是环境,左边是 agent 。

我们每次跟环境交互一次之后呢,就可以 learn 一下,向环境输出 action,然后从环境当中拿到 state 和 reward。

Agent 主要实现两个方法:

- 一个就是根据 Q 表格去选择动作,输出 action。

- 另外一个就是拿到 (St,At,Rt+1,St+1,At+1) 这几个值去更新我们的 Q 表格。

4 Sarsa on-policy

Sarsa 是一种 on-policy 策略。

Sarsa 优化的是它实际执行的策略,它直接拿下一步会执行的 action (At+1) 来去优化 Q 表格,所以 on-policy 在学习的过程中,只存在一种确定的策略,它用这种确定的策略去做 action 的选取,也用一种这种确定的策略去做优化。

以上是关于强化学习笔记:Sarsa算法的主要内容,如果未能解决你的问题,请参考以下文章