多智能体强化学习入门

Posted 微笑小星

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了多智能体强化学习入门相关的知识,希望对你有一定的参考价值。

参考文章:万字长文:详解多智能体强化学习的基础和应用 、多智能体强化学习入门(一)——基础知识与博弈

推荐文章:多智能体强化学习路线图 (MARL Roadmap)

推荐综述论文:An Overview of Multi-Agent Reinforcement Learning from Game Theoretical Perspective

参考书籍:《深度强化学习学科前沿与实战应用》

多智能体强化学习(Multi-agent RL简称MARL),是由RL和多智能体系统结合而成的新领域。多智能体系统起源于分布式人工智能,分布式人工智能的研究目标是创建描述自然和社会系统的精确概念模型,研究内容是分布式问题求解(Distributed Problem Solving,DPS)和多智能体系统,核心是把系统分成若干智能,自治的子系统,它们在物理和地理上可以分散,可以独立执行任务,同时又可以相互通信,相互协调,共同完成任务,因此,和传统的人工智能研究相比,多智能体系统不仅考虑个体的智能程度,更多的是整个系统的自主性,社会性等。多智能体环境下具有代表性的算法是OpenAI研究团队提出的MADDPG,在后面会有专门的讲解。

目前的工作主要关注以下两方面的研究:

- 稳定性,要求系统能收敛到均衡态,因此所有的智能体策略都要收敛到协调平衡的状态,最常用的是Nash均衡。

- 适应性。要求当其它智能体改变策略是,系统的表现保持不变或者更加优异,在一般情况下适应性由定义的目标最优、兼容性或者安全性等形式表达。

简介

MARL是指一组具有自我控制能力、能够相互作用的智能体,在同一环境下通过感知器、执行器操作,进而形成完全合作性、完全竞争性或者混合类型的多智能体系统,每个多智能体的奖励都会受到其他智能体动作的影响。因此,如何学习一种策略使得系统达到均衡稳态是该多智能体系统的目标。

纳什均衡

在矩阵博弈中,如果联结策略

(

π

1

∗

,

.

.

.

,

π

n

∗

)

(\\pi_1^*,...,\\pi_n^*)

(π1∗,...,πn∗)满足

V

i

(

π

1

∗

,

.

.

.

,

π

i

∗

,

π

n

∗

)

≥

V

i

(

π

1

,

.

.

.

,

π

i

,

π

n

)

,

∀

π

i

∈

Π

i

,

i

=

1

,

.

.

.

,

n

V_i(\\pi_1^*,...,\\pi_i^*,\\pi_n^*) \\geq V_i(\\pi_1,...,\\pi_i,\\pi_n) , \\forall \\pi_i \\in \\Pi_i,i = 1,...,n

Vi(π1∗,...,πi∗,πn∗)≥Vi(π1,...,πi,πn),∀πi∈Πi,i=1,...,n

则为一个纳什均衡。总体来说,纳什均衡就是一个所有智能体的联结策略。在纳什均衡处,对于所有智能体而言都不能在仅改变自身策略的情况下,来获得更大的奖励。

完全合作型

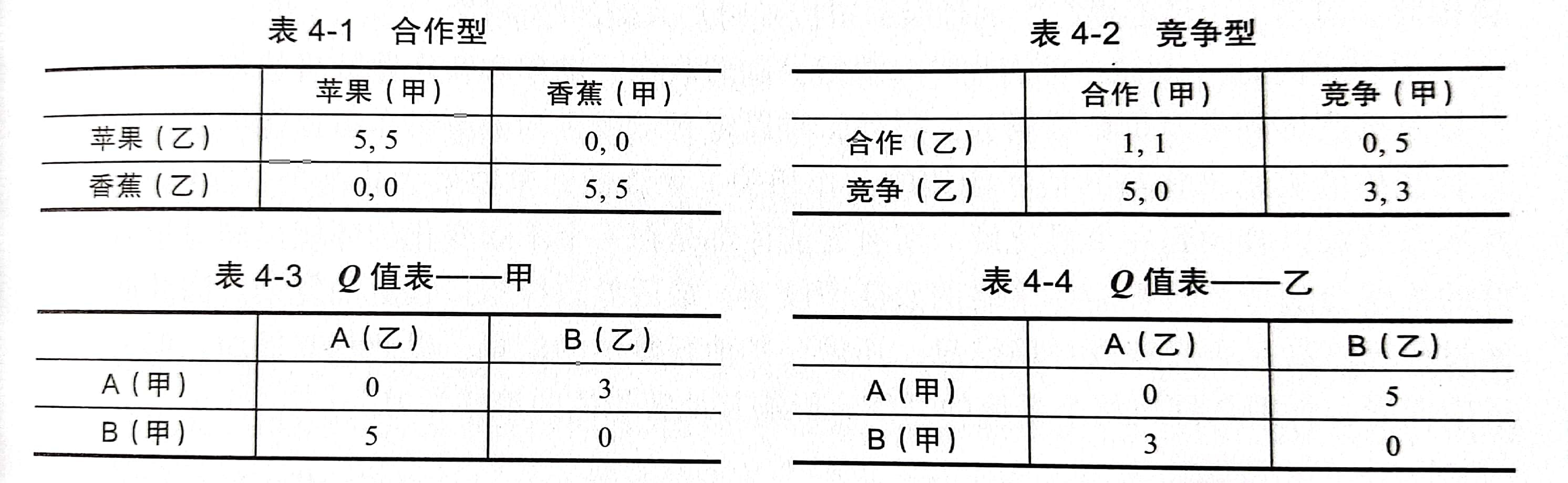

完全合作性的MARL系统中,认为系统的最大奖励需要智能体的相互协调才能获得,但当每个智能体都不清楚其他人选择的动作的情况下,得到的奖励都存在不确定性,会造成整个系统的收敛困难和随机性。相反在已知其他智能体的选择的前提下 ,智能体很容易就能学习到最高的奖励。

完全竞争型

完全竞争型的MARL中,一般采用最大最小化原则,即无论对方采取任何行动,智能体本身总是采取使自己受益最大的动作,最优策略就是无论对手如何选择,双方都应选择竞争,这样双方获得的奖励加起来才能实现最大化。

混合类型

这种类型的RL一般针对静态任务,直接对每个智能体应用单智能体的RL算法,不需要了解其他智能体的动作,所以各自更新独立的Q函数。如果甲乙需要处理AB两个文件,显然同时处理不同的文件能够节省时间,当甲乙做各自的更新表时,双方同时处理一个文件的奖励为0,但处理在各自的Q值表中,自己处理B文件自己得到的奖励是最高的。

马尔科夫博弈

在单智能体中RL可以用MDP来描述,而MARL需要马尔科夫博弈来描述,又称随机博弈(stochastic game)。包含两个概念,首先是多智能体系统的状态符合马尔科夫性,即下一个状态只与向前时刻有关,与前面的时刻无关。第二,博弈描述的是多智能体之间的关系。

马尔科夫博弈描述了多智能体系统,这里定义一个元组:

(

N

,

S

,

a

1

,

a

2

,

.

.

.

,

a

N

,

T

,

γ

,

r

1

,

.

.

.

,

r

N

)

(N,S,a_1,a_2,...,a_N,T,\\gamma,r_1,...,r_N)

(N,S,a1,a2,...,aN,T,γ,r1,...,rN)

其中N是智能体个数,S是系统状态,一般是多智能体的联合状态,例如合一是所有智能体的坐标。

a

1

,

a

2

,

.

.

.

,

a

N

a_1,a_2,...,a_N

a1,a2,...,aN为智能体的动作集合,T为状态转移函数。

T

:

S

∗

a

1

∗

.

.

.

∗

a

N

∗

S

T:S * a_1*... * a_N * S

T:S∗a1∗...∗aN∗S。

r i ( s , a 1 , . . . , a N , s ′ ) r_i(s,a_1,...,a_N,s') ri(s,a1,...,aN,s′)表示智能体在s状态时执行联合动作后再状态s’得到的奖励 r i r_i ri,当每个智能体奖励函数一致时,智能体之间是合作关系,奖励函数相反时,智能体之间是竞争关系。奖励函数介于两者直接是混合关系。

优势与挑战

多智能体学习的优势是可以通过不同智能体之间共享经验,从而更快、更好地完成任务。当一个智能体出现故障时,其他智能体可以代替执行任务,提高系统的鲁棒性。当系统需要提高扩展性时,可以随时引入新的智能体。

同时MARL面临的挑战是随着状态、动作和智能体数目的增加,系统的计算复杂度也指数增长,并且难以定义学习目标,无法做到单独最大化某个智能体的奖励。其次,系统难以收敛到一个最优解。所有的智能体都是在一个不断变化的环节中同时学习,最后的策略会随着其他智能体策略的改变而改变,最后导致探索过程更加复杂。因此探索过程不能只满足获取环境信息,还需要其他智能体的信息,以此相互适应,但有不能过度探索,否则会打破整个系统的平衡,影响其他智能体的策略学习。

部分可见马尔科夫决策过程(POMDP)

在马尔科夫决策过程(简称MDP)中,一个重要前提是智能体对环境的观察是完整的,而现实中的智能体往往只能观察到部分信息,比如很多情况下难以获取系统的精确状态,另外就是智能体的传感器只能覆盖整个环境的一小部分。针对上述问题,部分可见马尔科夫决策过程(简称POMDP)这个更接近现实世界的模型被提出,这可以看作MDP的扩展。

通常,我们采用一个七元组 ( S , A , T , R , O , Z , γ ) (S,A,T,R,O,Z,\\gamma) (S,A,T,R,O,Z,γ)来描述POMDP,其中S、A、T、R、γ和MDP的定义一致。另外有:

O:一组观察结果集,比如机器人传感器获得的环境信息,在MDP中由于完全了解系统状态,O=S,在POMDP中观察仅在概率上取决于潜在的环境信息,因为在不同的环境状态中可以得到相同的观察,因此确定智能体所处的状态变得困难。

Z:

S

∗

A

→

Δ

(

O

)

S * A \\rightarrow \\Delta (O)

S∗A→Δ(O)是一个观察函数,表明系统状态和观察值之间的关系,具体是在智能体在执行动作a进入环境状态s’后得到观察者的概率。

Z

(

s

′

,

a

,

o

′

)

=

P

r

(

O

t

+

1

=

o

′

∣

S

t

+

1

=

s

′

,

A

t

=

a

)

Z(s',a,o') = P_r(O^{t+1} = o'|S^{t+1}=s',A^t = a)

Z(s′,a,o′)=Pr(Ot+1=o′∣St+1=s′,At=a)

现在整体一下流程:在时刻t,环境处于状态s,智能体采取动作a,根据状态转移方程

T

(

s

′

∣

s

,

a

)

T(s'|s,a)

T(s′∣s,a)进入环境状态s’,同时智能体获得观察值o,这取决于概率$Z(o’|s’,a)

,

最

后

智

能

体

得

到

奖

励

,最后智能体得到奖励

,最后智能体得到奖励r = r(s,a)$,目标是使智能体在每个时间步选择的动作能够最大化未来的折扣奖励。

在POMDP中,智能体不能确信自己所处的状态,因此决策的基础是当前所处状态的概率。智能体需要得到观测值来更新自己对当前所处状态的可信度,“信息收集”的动作可以让智能体先运动到邻近的位置,这个位置收集的信息可能加大智能体对自己所处状态的可信度。虽然无法得知状态,但是可以通过观察和动作的历史来决策,t时刻的观察和动作的历史定义为:

h

t

=

(

a

0

,

o

1

,

.

.

.

,

o

t

−

1

,

a

t

−

1

,

o

t

)

h_t = (a_0,o_1,...,o_{t-1},a_{t-1},o_t)

ht=(a0,o1,...,ot−1,at−1,ot)

为了采用较短的历史代替所有的观察和行为,引入了信念状态

b

(

s

)

b(s)

b(s)的概念,表示对当前所处状态的可信度。

b

t

(

s

)

=

P

r

(

s

∣

h

t

)

b_t(s) = P_r(s|h_t)

bt(s)=Pr(s∣ht)

Sondik证明

b

t

(

s

)

b_t(s)

bt(s)是对历史

h

t

h_t

ht的充分估计,在所有状态上维护一个概率分布与维护一个完整历史提供同样的信息。这样就能转化为基于信念空间状态的马尔科夫链来求解,因此POMDP问题的求解转化为求解信念状态函数和策略问题。

- 信念状态函数 B ( s ) : O ∗ A ∗ B ( s ) → B ( s ) B(s) :O * A * B(s) \\rightarrow B(s) B(s)