Zookeeper3.5.7版本——集群部署(linux环境-centos7)

Posted 小志的博客

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Zookeeper3.5.7版本——集群部署(linux环境-centos7)相关的知识,希望对你有一定的参考价值。

目录

一、三台服务器信息

- 三台服务器

服务器名称 服务器ip centos7虚拟机1 192.168.136.27 centos7虚拟机2 192.168.136.28 centos7虚拟机3 192.168.136.29

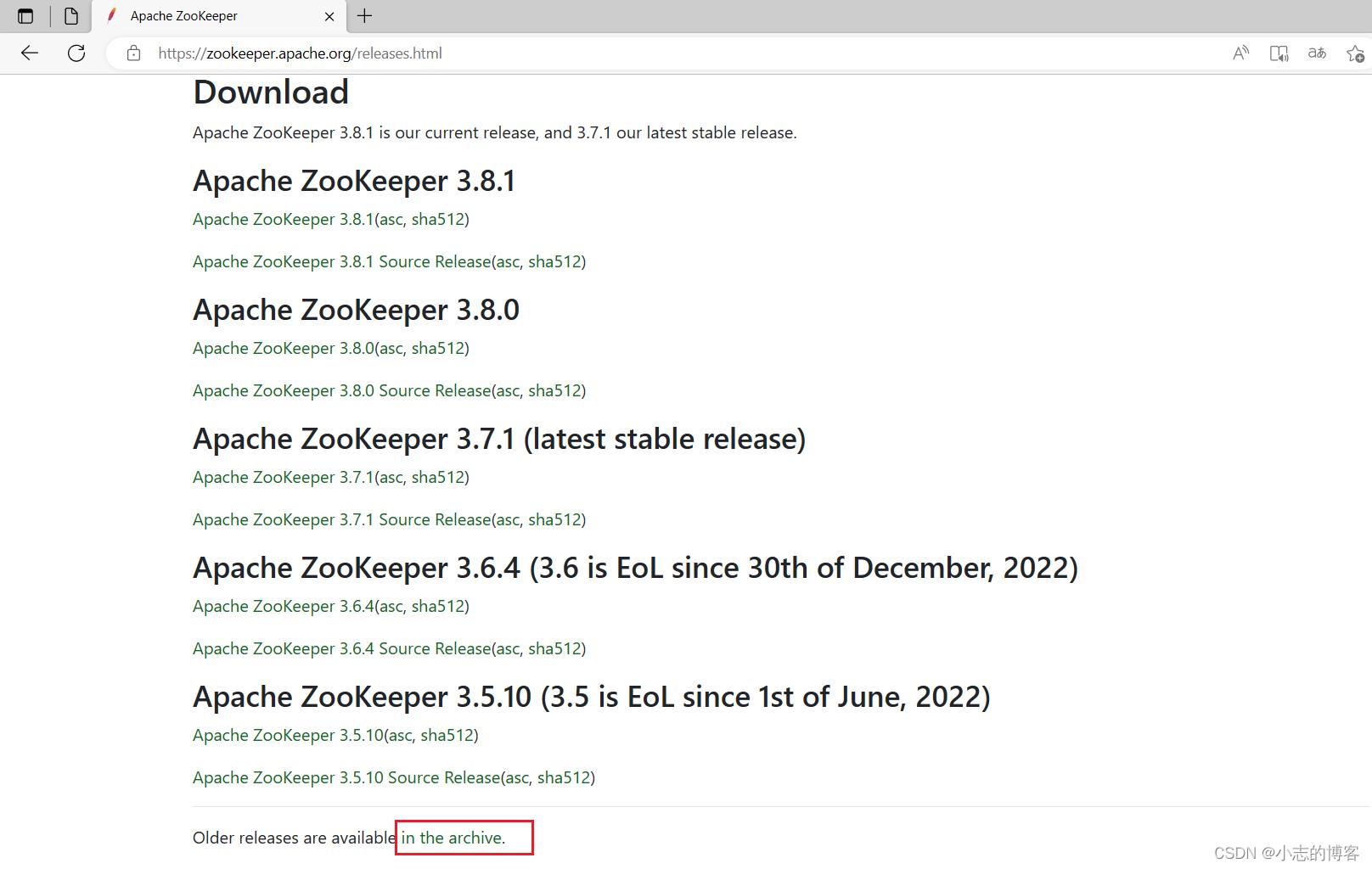

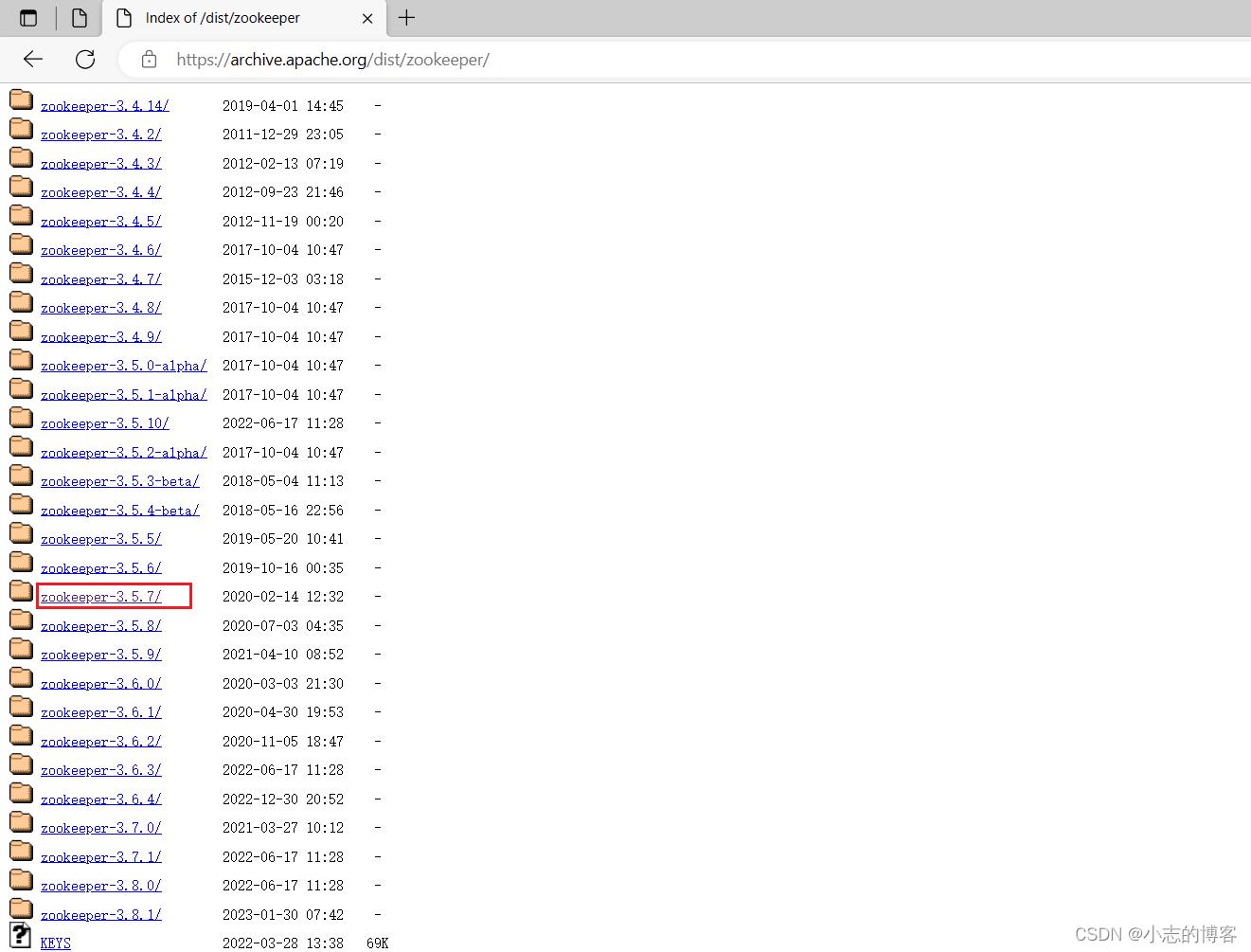

二、Zookeeper3.5.7官网下载

2.1、官网下载地址

2.2、下载步骤

- 下载步骤如下所示:

三、三台服务器都安装jdk11(Zookeeper需要jdk支持)

- linux环境(centos7)安装JDK11步骤图解参考此博文:https://wwwxz.blog.csdn.net/article/details/128899399

四、Zookeeper3.5.7集群部署

4.1、centos7虚拟机1 (192.168.136.27)服务器安装步骤

4.1.1、解压安装(以下所有演示操作lz都使用的root用户)

-

上传安装包到home目录下

[root@localhost /]# cd /home/ [root@localhost home]# ls

-

在opt目录下创建module文件夹

[root@localhost home]# mkdir /opt/module

-

进入home目录,解压安装包到opt/module目录下

[root@localhost home]# tar -zxvf apache-zookeeper-3.5.7-bin.tar.gz -C /opt/module/

-

进入opt/module目录下,修改解压后的apache-zookeeper-3.5.7-bin名称为zookeeper-3.5.7

[root@localhost module]# mv apache-zookeeper-3.5.7-bin/ zookeeper-3.5.7

4.1.2、配置服务器编号

-

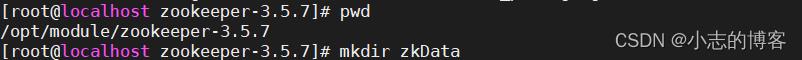

在/opt/module/zookeeper-3.5.7/目录下创建zkData文件夹,如下图所示:

[root@localhost zookeeper-3.5.7]# mkdir zkData

-

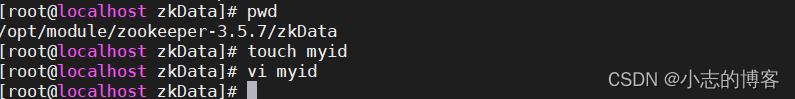

在/opt/module/zookeeper-3.5.7/zkData 目录下创建一个 myid 的文件,在文件中添加与 zoo.cfg配置文件中 server的编号对应,此处文件中内容为1(注意:上下不要有空行,左右不要有空格)

注意:添加 myid 文件,一定要在 Linux 里面创建,在 notepad++里面很可能乱码。[root@localhost zkData]# touch myid [root@localhost zkData]# vi myid

4.1.3、配置zoo.cfg 文件

-

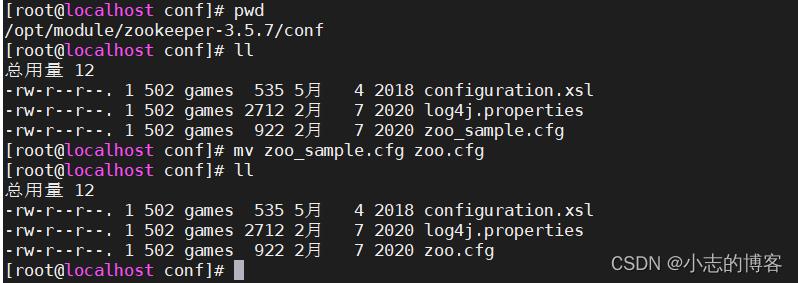

重命名/opt/module/zookeeper-3.5.7/conf 这个目录下的 zoo_sample.cfg 为 zoo.cfg

[root@localhost conf]# pwd /opt/module/zookeeper-3.5.7/conf [root@localhost conf]# mv zoo_sample.cfg zoo.cfg [root@localhost conf]#

-

打开 zoo.cfg 文件

[root@localhost conf]# vim zoo.cfg -

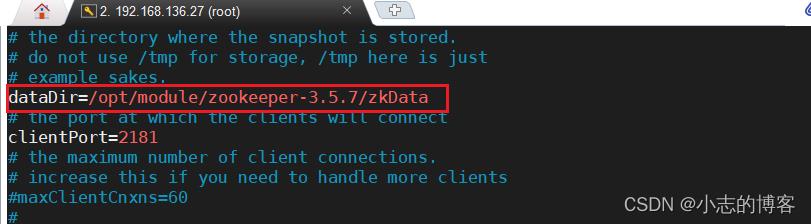

修改dataDir的数据存储路径配置,修改如下内容:

dataDir=/opt/module/zookeeper-3.5.7/zkData

-

增加如下配置

#######################cluster########################## server.1=192.168.136.27:2888:3888 server.2=192.168.136.28:2888:3888 server.3=192.168.136.29:2888:3888

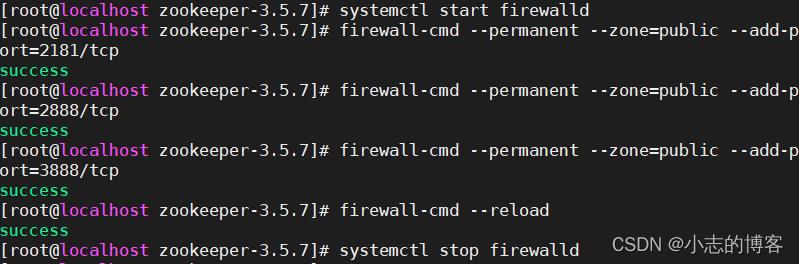

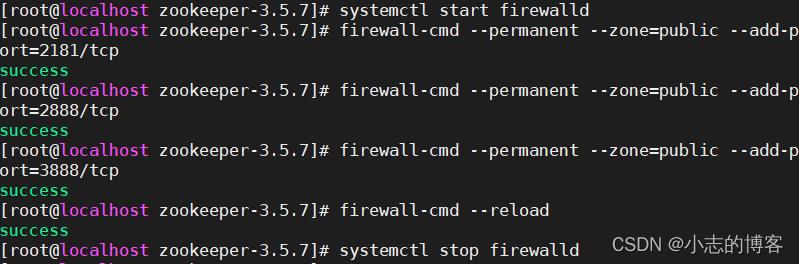

4.1.5、在防火墙中打开要用到的端口 2181、2888、3888,如下所示:

-

开启防火墙,开放2181、2888和3888端口,并重新关闭防火墙如下图所示。

#查看防火墙的状态命令 systemctl status firewalld #打开防火墙的状态命令 sudo systemctl start firewalld #开放2181、2888和3888端口 firewall-cmd --permanent --zone=public --add-port=2181/tcp firewall-cmd --permanent --zone=public --add-port=2888/tcp firewall-cmd --permanent --zone=public --add-port=3888/tcp #重新加载 firewall-cmd --reload #关闭防火墙的状态命令 sudo systemctl stop firewalld

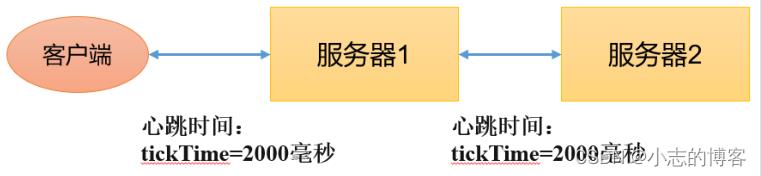

4.1.6、配置参数解读

-

tickTime = 2000:通信心跳时间,Zookeeper服务器与客户端心跳时间,单位毫秒

-

initLimit = 10 :LF 初始通信时限

-

syncLimit = 5 :LF 同步通信时限

-

dataDir :保存Zookeeper中的数据。

注意:默认的tmp目录,容易被Linux系统定期删除,所以一般不用默认的tmp目录。 -

clientPort = 2181 :客户端连接端口

-

server.A=B:C:D

A 是一个数字,表示这个是第几号服务器;集群模式下配置一个文件 myid,这个文件在 dataDir 目录下,这个文件里面有一个数据就是 A 的值,Zookeeper 启动时读取此文件,拿到里面的数据与 zoo.cfg 里面的配置信息比较从而判断到底是哪个 server。

B 是这个服务器的地址;

C 是这个服务器 Follower 与集群中的 Leader 服务器交换信息的端口;

D 是万一集群中的 Leader 服务器挂了,需要一个端口来重新进行选举,选出一个新的Leader,而这个端口就是用来执行选举时服务器相互通信的端口。

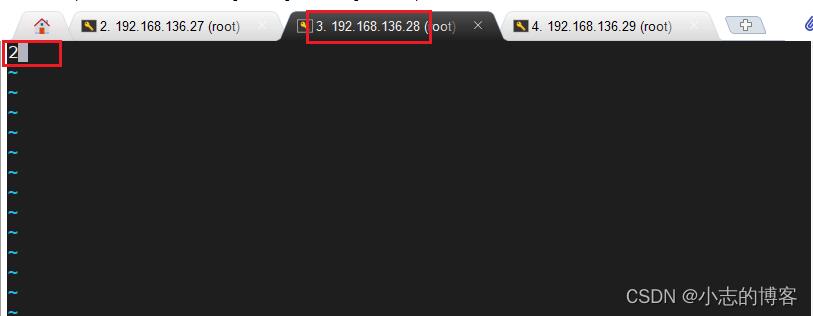

4.2、centos7虚拟机2 (192.168.136.28)服务器安装步骤

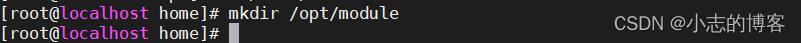

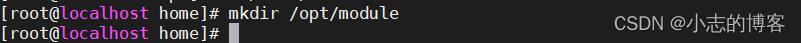

4.2.1、在opt目录下创建module文件夹

-

在opt目录下创建module文件夹 与 centos7虚拟机1 (192.168.136.27)服务器中Zookeeper解压安装包的位置相同即可。

[root@localhost home]# mkdir /opt/module

4.2.2、拷贝配置好的 zookeeper 到centos7虚拟机2 (192.168.136.28)服务器

-

scp基本语法

scp -r $pdir/$fname $user@$host:$pdir/$fname 命令 递归 要拷贝的文件路径/名称 目的地用户@主机:目的地路径/名称 -

在centos7虚拟机1 (192.168.136.27)服务器上 拷贝配置好的 zookeeper 到centos7虚拟机2 (192.168.136.28)服务器

[root@localhost /]# scp -r /opt/module/zookeeper-3.5.7/ root@192.168.136.28:/opt/module/

4.2.3、修改 myid 文件中内容

-

修改 myid 文件中内容为 2

[root@localhost zkData]# pwd /opt/module/zookeeper-3.5.7/zkData [root@localhost zkData]# vi myid

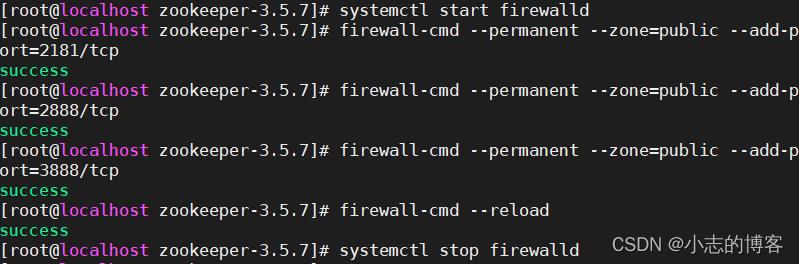

4.2.4、在防火墙中打开要用到的端口 2181、2888、3888,如下所示:

-

开启防火墙,开放2181、2888和3888端口,并重新关闭防火墙如下图所示。

#查看防火墙的状态命令 systemctl status firewalld #打开防火墙的状态命令 sudo systemctl start firewalld #开放2181、2888和3888端口 firewall-cmd --permanent --zone=public --add-port=2181/tcp firewall-cmd --permanent --zone=public --add-port=2888/tcp firewall-cmd --permanent --zone=public --add-port=3888/tcp #重新加载 firewall-cmd --reload #关闭防火墙的状态命令 sudo systemctl stop firewalld

4.3、centos7虚拟机3 (192.168.136.29)服务器安装步骤

4.3.1、在opt目录下创建module文件夹

-

在opt目录下创建module文件夹 与 centos7虚拟机1 (192.168.136.27)服务器中Zookeeper解压安装包的位置相同即可。

[root@localhost home]# mkdir /opt/module

4.3.2、拷贝配置好的 zookeeper 到centos7虚拟机3(192.168.136.29)服务器

-

scp基本语法

scp -r $pdir/$fname $user@$host:$pdir/$fname 命令 递归 要拷贝的文件路径/名称 目的地用户@主机:目的地路径/名称 -

在centos7虚拟机1 (192.168.136.27)服务器上 拷贝配置好的 zookeeper 到centos7虚拟机3(192.168.136.29)服务器

[root@localhost /]# scp -r /opt/module/zookeeper-3.5.7/ root@192.168.136.29:/opt/module/

4.3.3、修改 myid 文件中内容

-

修改 myid 文件中内容为 3

[root@localhost zkData]# pwd /opt/module/zookeeper-3.5.7/zkData [root@localhost zkData]# vi myid

4.3.4、在防火墙中打开要用到的端口 2181、2888、3888,如下所示:

-

开启防火墙,开放2181、2888和3888端口,并重新关闭防火墙如下图所示。

#查看防火墙的状态命令 systemctl status firewalld #打开防火墙的状态命令 sudo systemctl start firewalld #开放2181、2888和3888端口 firewall-cmd --permanent --zone=public --add-port=2181/tcp firewall-cmd --permanent --zone=public --add-port=2888/tcp firewall-cmd --permanent --zone=public --add-port=3888/tcp #重新加载 firewall-cmd --reload #关闭防火墙的状态命令 sudo systemctl stop firewalld

4.4、集群操作

4.4.1、分别启动三台服务器的 Zookeeper服务

-

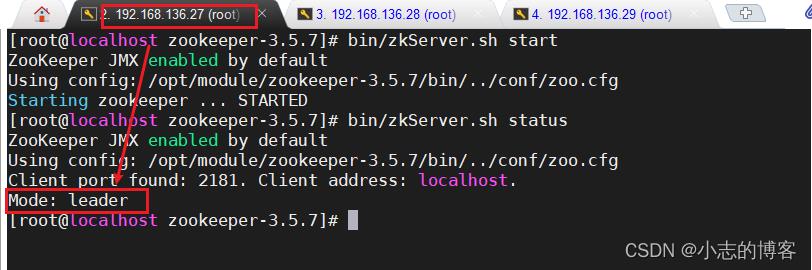

启动centos7虚拟机1 (192.168.136.27)服务器 的Zookeeper服务

[root@localhost zookeeper-3.5.7]# bin/zkServer.sh start

-

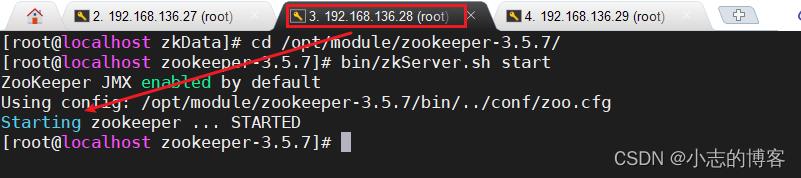

启动centos7虚拟机2(192.168.136.28)服务器 的Zookeeper服务

[root@localhost zookeeper-3.5.7]# bin/zkServer.sh start

-

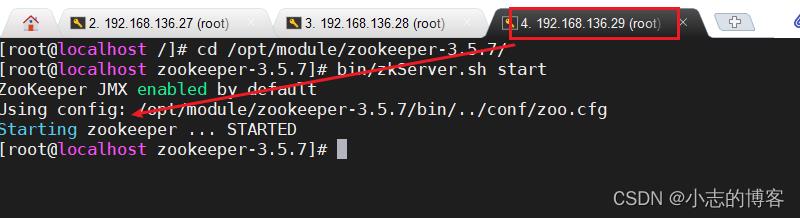

启动centos7虚拟机3(192.168.136.29)服务器 的Zookeeper服务

[root@localhost zookeeper-3.5.7]# bin/zkServer.sh start

4.4.2、分别查看三台服务器的 Zookeeper服务状态

-

查看centos7虚拟机1 (192.168.136.27)服务器 的Zookeeper服务状态

[root@localhost zookeeper-3.5.7]# bin/zkServer.sh status

-

查看centos7虚拟机2 (192.168.136.28)服务器 的Zookeeper服务状态

[root@localhost zookeeper-3.5.7]# bin/zkServer.sh status

-

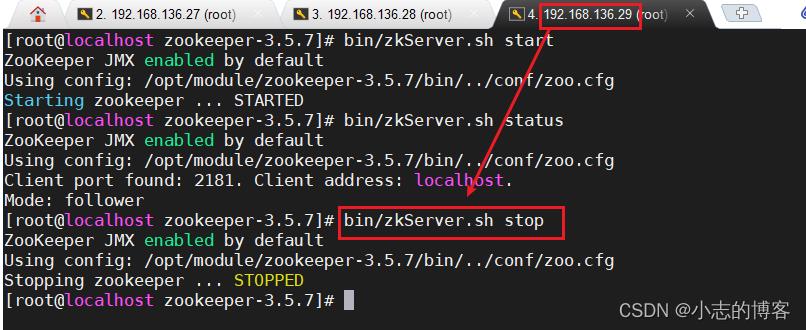

查看centos7虚拟机3 (192.168.136.29)服务器 的Zookeeper服务状态

[root@localhost zookeeper-3.5.7]# bin/zkServer.sh status

4.4.3、分别停止三台服务器的 Zookeeper服务

-

停止centos7虚拟机1 (192.168.136.27)服务器 的Zookeeper服务

[root@localhost zookeeper-3.5.7]# bin/zkServer.sh stop

-

停止centos7虚拟机2 (192.168.136.28)服务器 的Zookeeper服务

[root@localhost zookeeper-3.5.7]# bin/zkServer.sh stop

-

停止centos7虚拟机3 (192.168.136.29)服务器 的Zookeeper服务

[root@localhost zookeeper-3.5.7]# bin/zkServer.sh stop

以上是关于Zookeeper3.5.7版本——集群部署(linux环境-centos7)的主要内容,如果未能解决你的问题,请参考以下文章