Maven开发Spark程序

Posted shi_zi_183

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Maven开发Spark程序相关的知识,希望对你有一定的参考价值。

Maven开发Spark程序

新建Maven项目

将src/main/java改名为src/main/scala

修改pom.xml

pom.xml

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>com.example</groupId>

<artifactId>sparkTest</artifactId>

<version>1.0-SNAPSHOT</version>

<dependencies>

<dependency>

<groupId>org.scala-lang</groupId>

<artifactId>scala-library</artifactId>

<version>2.11.8</version>

</dependency>

<!--spark core depedency-->

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-core_2.12</artifactId>

<version>3.1.2</version>

</dependency>

<!--hadoop-client depedency-->

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>3.3.0</version>

</dependency>

</dependencies>

</project>

引入scala依赖

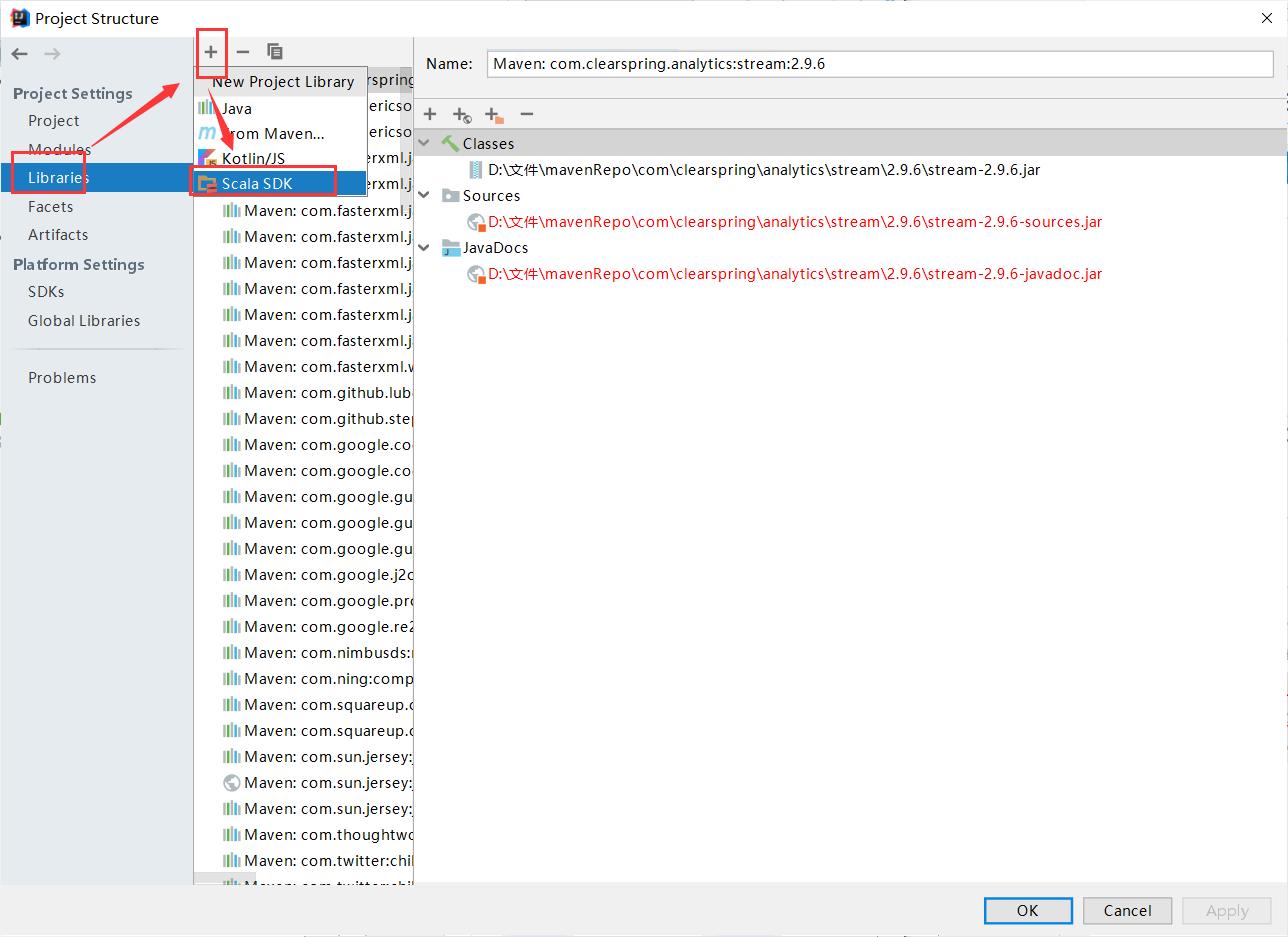

File->Project Structure

这样scala目录就可以创建scala文件了。

编写scala程序

wordCount

package com.example

import org.apache.spark.{SparkConf, SparkContext}

object wordCount {

def main(args: Array[String]): Unit = {

val conf=new SparkConf()

conf.setAppName("MyFirstSparkApplication")

conf.setMaster("yarn")

val sc=new SparkContext(conf)

val data=sc.textFile(args(0))

val words=data.flatMap(_.split("\\n")).flatMap(_.split(" ")).map((_,1)).reduceByKey(_+_).collect()

words foreach println

}

}

IDEA打包

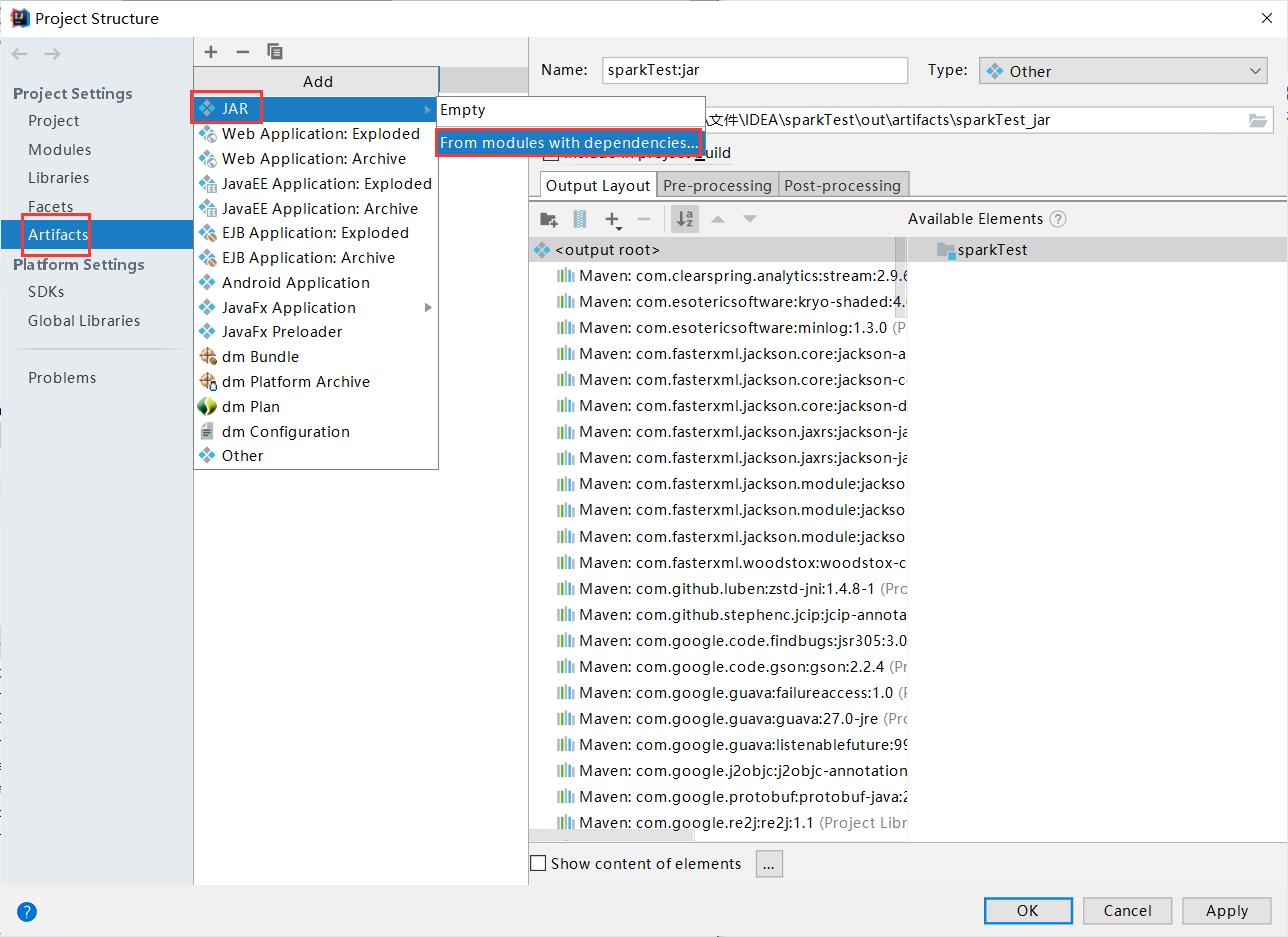

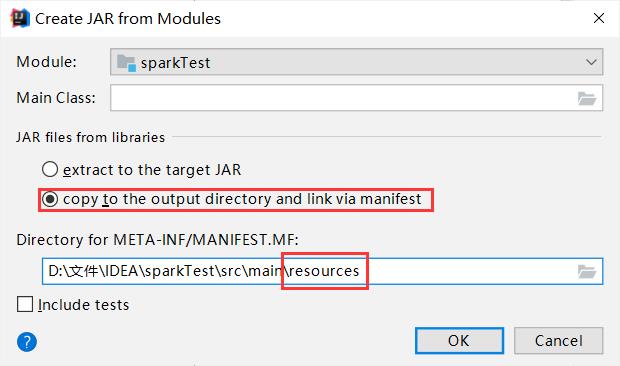

File->Project Structure

集群上运行

spark-submit --master yarn --name wordCount --class com.example.wordCount hdfs:///sparkTest.jar /user/hadoop/input

其中/user/hadoop/input为hdfs路径。

以上是关于Maven开发Spark程序的主要内容,如果未能解决你的问题,请参考以下文章