吃瓜教程——datawhale10月组队学习

Posted scdctlt

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了吃瓜教程——datawhale10月组队学习相关的知识,希望对你有一定的参考价值。

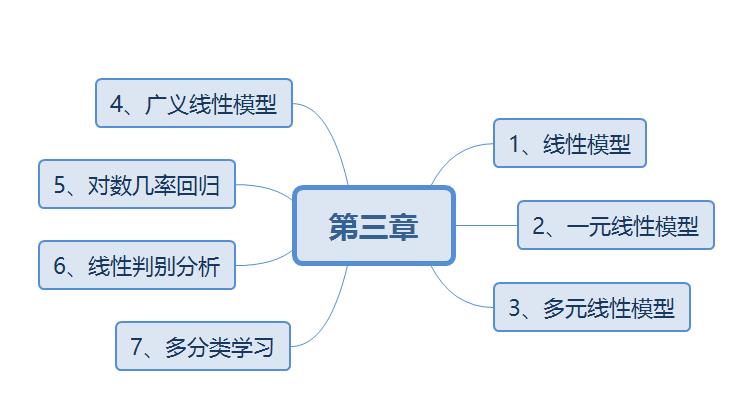

task02:概览西瓜书+南瓜书第1、2章

3.1 线性回归的基本形式

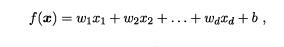

给定d个属性描述,可以通过属性线性组合来进行预测的函数

3.2 线性回归

3.2.1 一元线性线性回归

模型:线性模型

准则:均方误差最小

算法:最小二乘

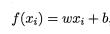

假设x和y满足线性函数关系,使用x的值来预测y

即

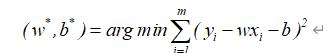

这里,为了求出w和b,我们考虑衡量f(x)与y之间差别,使用均方误差来衡量,即让均方误差最小,为我们的优化准则。

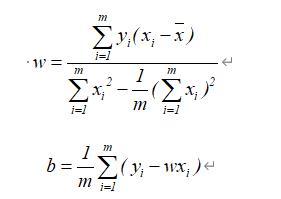

求解过程中使用最小二乘法,分别对w和b求导,再令导数为0,求出w和b的闭式解:

3.2.2 多元线性回归

模型:线性模型

准则:均方误差最小

算法:梯度下降法/最小二乘

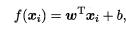

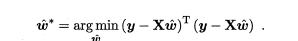

参照一元线性回归,我们这里,属性为多个,此时x对应的系数就为多个,记为w的转置,模型为:

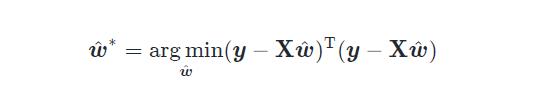

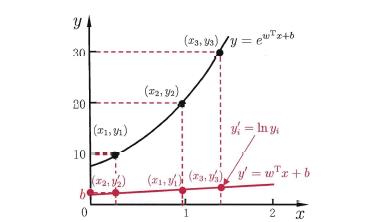

同样的优化的准则为均方误差最小:

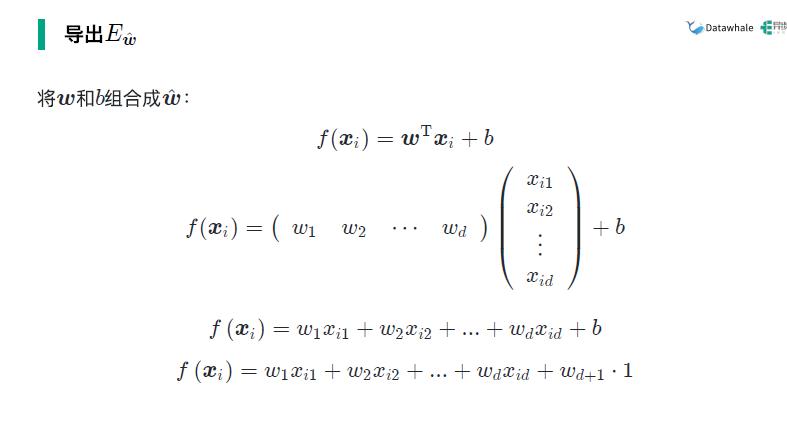

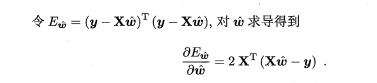

闭式解解法:

根据最小二乘法

求出得到的

最终

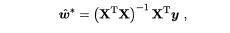

3.3 一般广义线性模型

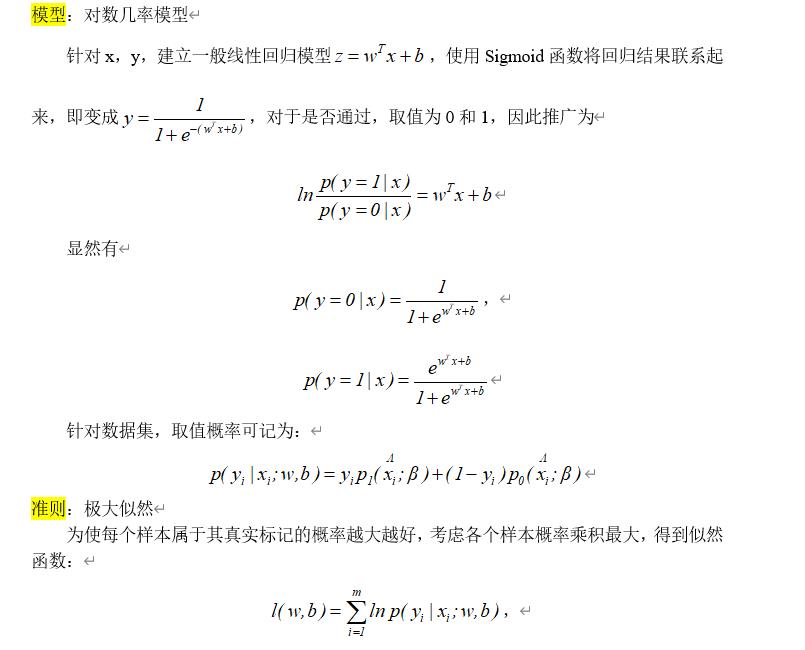

3.4 对数几率回归

模型:非线性模型()

准则:极大似然估计(类的取值概率乘积最大)

算法:梯度下降/牛顿法

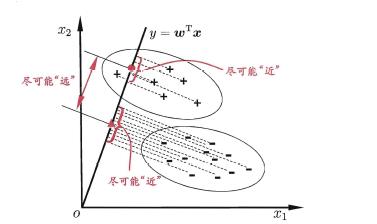

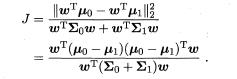

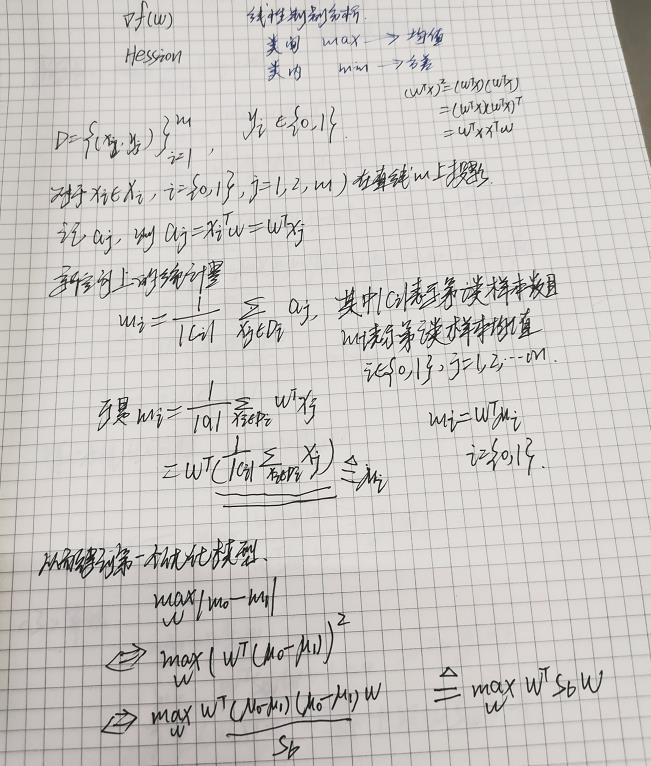

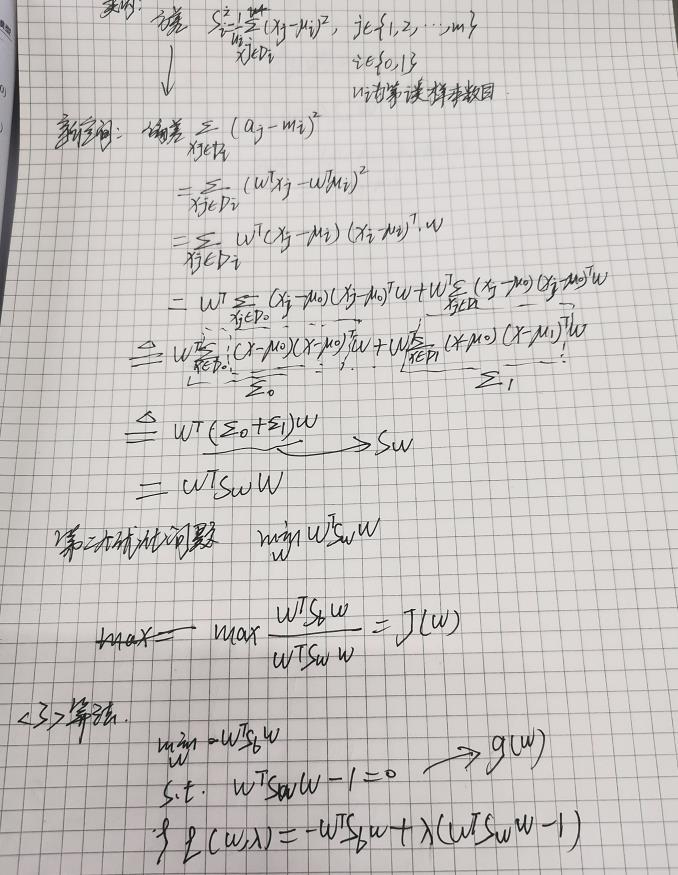

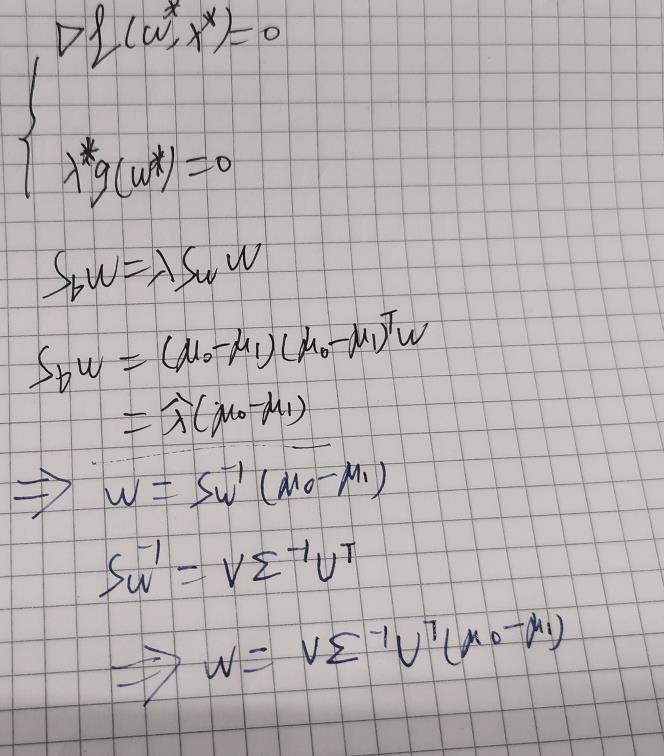

3.5 线性判别分析(LDA)

模型:非线性

准则:类内协方差矩阵最小,类间向量均值最大

想要达到这个准则,即最大化目标,使用两者比值即可

推导过程:

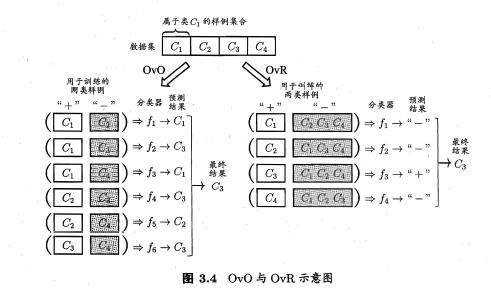

3.6 多分类学习

可由二分类推广到多分类:

三种拆分方式:

ovo,ovr,mvm

对于ovo和ovr来说:

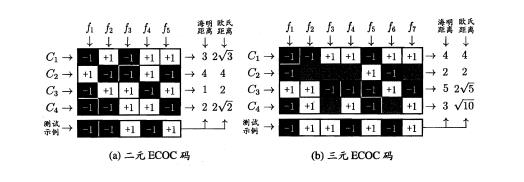

mvm:

对N 个类别做M 次划分, 每次划分将一部分类别划为正类,一部

分划为反类,从而形成一个二分类训练集;这样一共产生M 个训练集,可训练出M 个分类器.

使用海明距离或者欧式距离,取距离最小的作为判定的距离:

以上是关于吃瓜教程——datawhale10月组队学习的主要内容,如果未能解决你的问题,请参考以下文章