[人工智能-深度学习-28]:卷积神经网络CNN - 网络架构与描述方法

Posted 文火冰糖的硅基工坊

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了[人工智能-深度学习-28]:卷积神经网络CNN - 网络架构与描述方法相关的知识,希望对你有一定的参考价值。

作者主页(文火冰糖的硅基工坊):文火冰糖(王文兵)的博客_文火冰糖的硅基工坊_CSDN博客

本文网址:https://blog.csdn.net/HiWangWenBing/article/details/120806599

目录

第1章 卷积神经网络总体概述

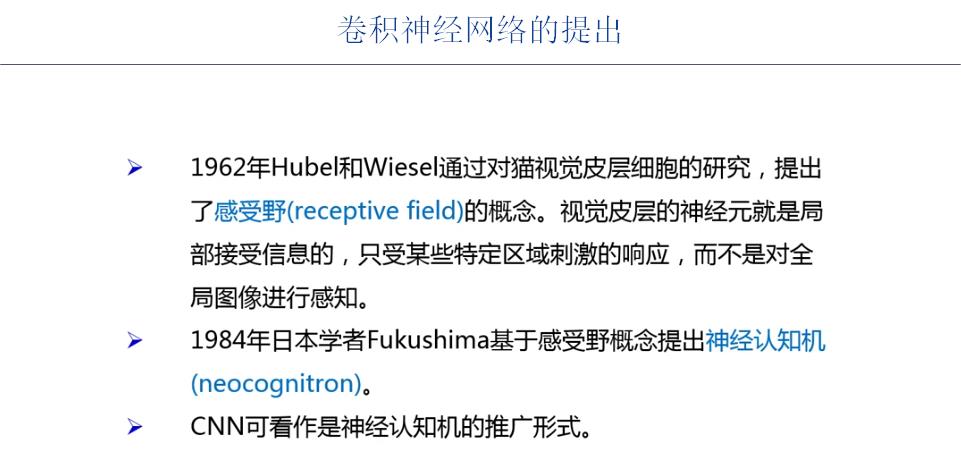

1.1 什么是卷积神经网络

1.2 卷积神经网络的总体框架

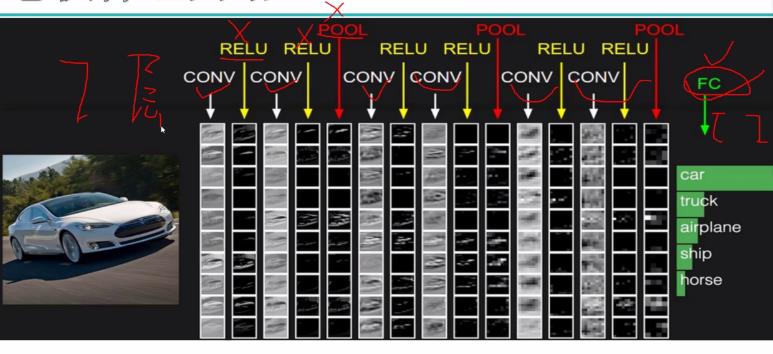

1.3 卷积神经神经网络案例

备注:

- 通常情况下,带训练参数的层,成称为网络的层数。

- RELU和POOL层本身不带有训练参数。

第2章 卷积神经网络的描述方法

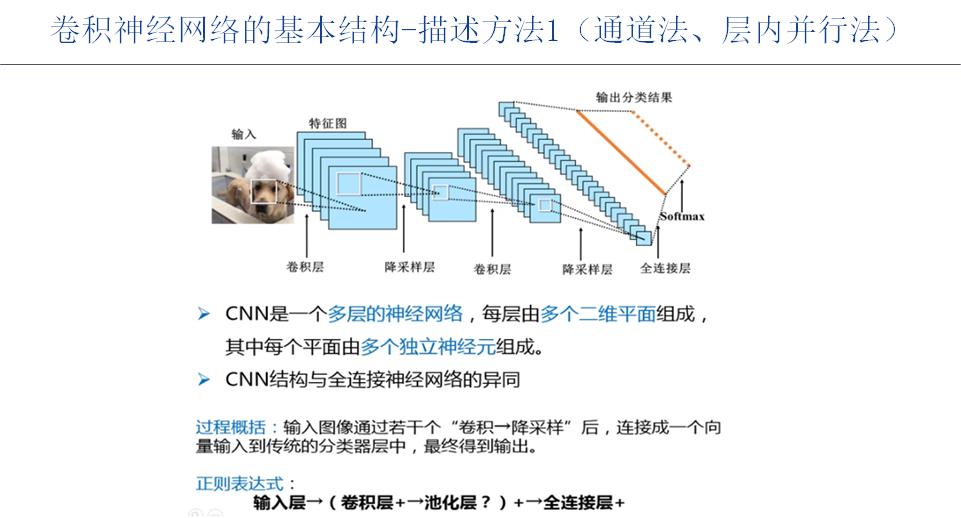

2.1 通道法、层内并行法

通道法关注的是:

通道的数目,即为神经元的数目,与输入图形的三个RGB通道等位

而二维平面,即为每个神经元内部的W矩阵,长度 * 宽度就是每个神经元内部的参数的个数。

通道 * 二维矩阵描述了三维图片在CNN中的尺寸的变化,维度保持不变的变换过程,也反映了每一层参数的个数。

通道法的优缺点:

优点:

- 通道法把每个神经元看成是并行的排列,相对于厚度法,更加直观,直观的体现了单层内部的各个神经元之间的并发行、并行性。

缺点:

- 不方便表达不同层之间的图片处理的串行关系以及形状的变化!!!

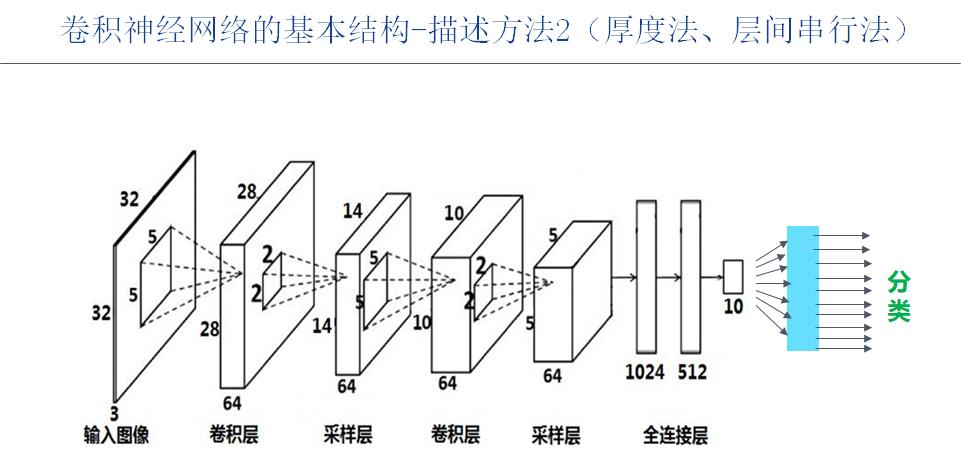

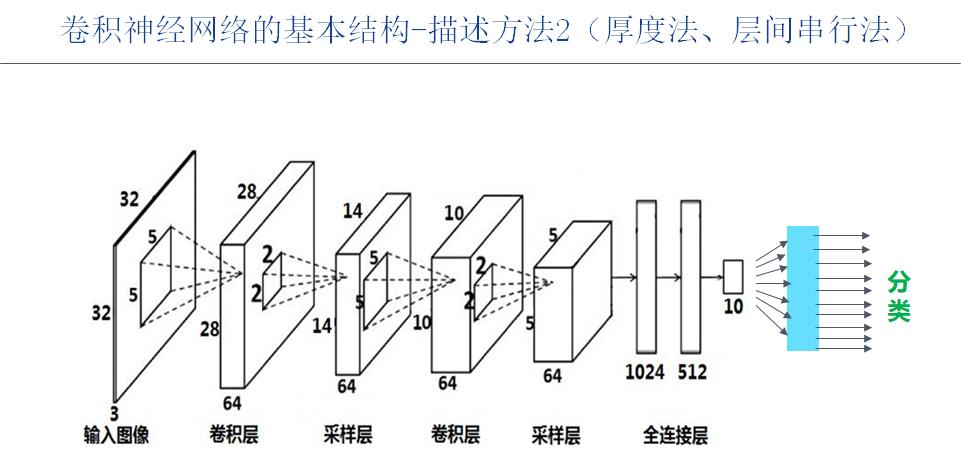

2.2 厚度法、层间串行法

缺点:

(1)串行法把神经元在数据处理的方向叠加在了一起,神经元间的并行性看来其并不那么直观。

(2)由于把神经元叠加在了一起,就要求同层的每个神经元的形状必须相同!!!!

优点:

(1)表达神经网络层之间的串联结构就非常方便。

(2)表达神经网络层内部的三维结构(长*宽*高)也非常方便,直观。

(3)能够方便的表达数据在不同层之间的形状的变化关系:

- 厚度:反应了并行性的神经元个数的变化、即通道个数的变化。

- 长度*宽度(平面):面积的变化,反应了每一层神经元形状的变化,每个神经元W参数的变化情况。

- 厚度 * 长度 * 宽度 =》某一个参数的个数(忽略个数极少的偏置参数)

(4)从输入到输出,表达方式统一、一致。

2.3 神经网络的形状解读

(1)现有神经网络案例解读

输入层:深度为3,即个通道,每个通道的二维数据形状为32 * 32

卷积层1:深度为64,即64个通道或64个神经元,每个通道的二维数据形状为28 * 28(通过卷积获得输出形状),卷积核的大小为5*5(通过对上一层的感受野的大小来体现)

降采用层1:深度为64不变,每个通道的二维数据形状降为原先的一半:14 * 14 (降采样),采样核的大小为2*2(通过对上一层的感受野的大小来体现)

卷积层2:深度为64不变,即64个通道或64个神经元,每个通道的二维数据形状为10 * 10,卷积核的大小为5 * 5 (通过对上一层的感受野的大小来体现)

降采用层2:深度为64不变,即64个通道或64个神经元,每个通道的二维数据形状为5 * 5, 由又降低一半。采样核的大小为2*2。

全连接层1:1024个并行的神经元,即1024个输出,输入取决于降采样层的输出:64*5*5

全连接层2:512个并行的神经元,即512个输出,输入取决于前一个全连接层:1024.

输出层:10个并行的神经元,即10个输出,输入取决于前一个全连接层:512.

(2)特别说明

- 卷积网络的定义方式为:每一层的三维形状,以及该层的输出的个数 = 长度 * 宽度 * 深度 ,深度就是神经元的个数。即每个卷积核神经元的输出是长度 * 宽度。

- 全连接网的定义方式为:每一层的一维形状,以及该层的输出的个数 = 1 * 1 * 深度,深度就是神经元的个数。即每个全连接网络神经元的输出是1*1.

- 上述方式把全连接网络和卷积网络进行统一,因此全连接与卷积之间是可以相互替代(确保总总输出不变)。

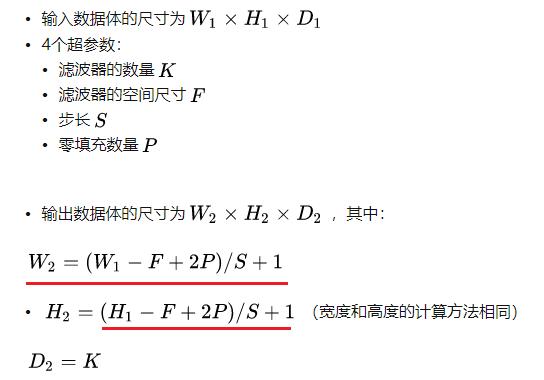

- 卷积网络只定义了网络的输入和输出以及卷积核的大小,并没有定义迭代的步长和填充数据大小。迭代步长和填充数据的大小是需要深度学习框架根据(1)输入形状+(2)输出形状+(3)卷积核形状,自动计算出来的,也就是说通过修正步长和填充,可以确保输入和输出的关系,他们之间的数学公式如下:

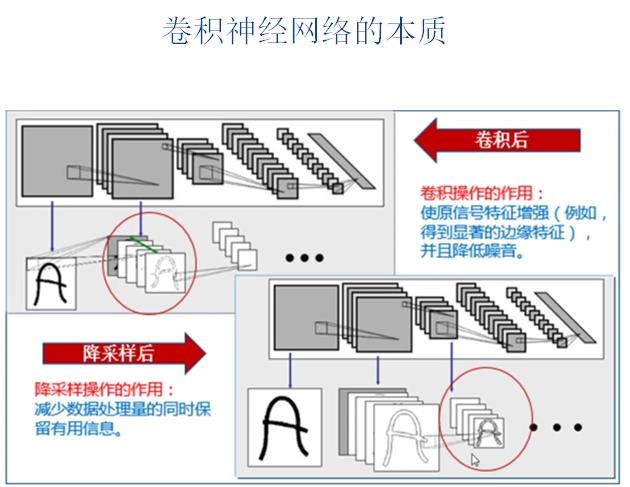

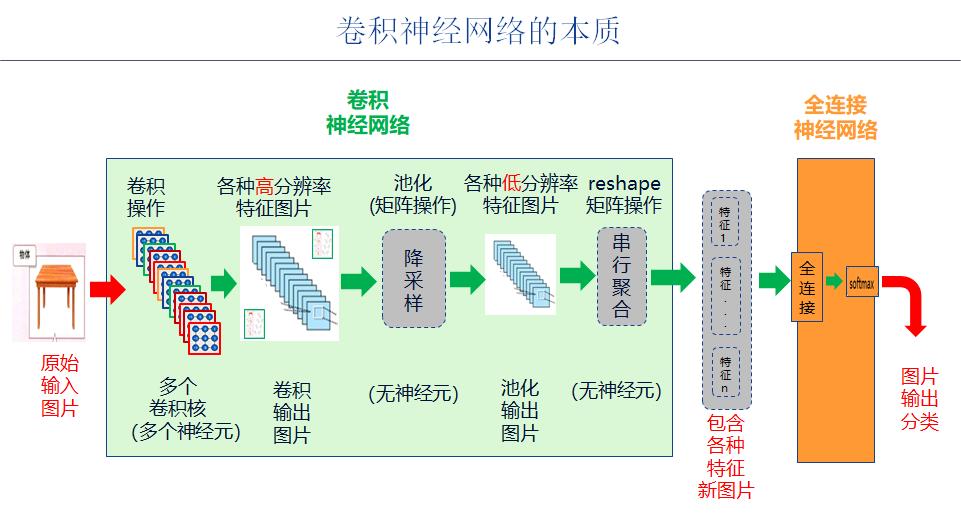

第3章 卷积神经网络的本质

第4章卷积神经网络的发展与常见类型与分类

作者主页(文火冰糖的硅基工坊):文火冰糖(王文兵)的博客_文火冰糖的硅基工坊_CSDN博客

本文网址:https://blog.csdn.net/HiWangWenBing/article/details/120806599

以上是关于[人工智能-深度学习-28]:卷积神经网络CNN - 网络架构与描述方法的主要内容,如果未能解决你的问题,请参考以下文章