英特尔发布首个7nm芯片Loihi 2,用于神经拟态计算,可模拟100万神经元

Posted QbitAl

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了英特尔发布首个7nm芯片Loihi 2,用于神经拟态计算,可模拟100万神经元相关的知识,希望对你有一定的参考价值。

晓查 发自 凹非寺

量子位 报道 | 公众号 QbitAI

今天,英特尔发布了第二代神经拟态芯片Loihi 2。

神经拟态芯片是一种模拟生物神经元的芯片。

与普通芯片不同的是,神经拟态芯片的计算任务是由许多小单元进行的,单元之间通过类似生物神经的尖峰信号相互通信,并通过尖峰调整其行为。

目前,英特尔已经将这种芯片用于机械臂、神经拟态皮肤、机器嗅觉等场景。

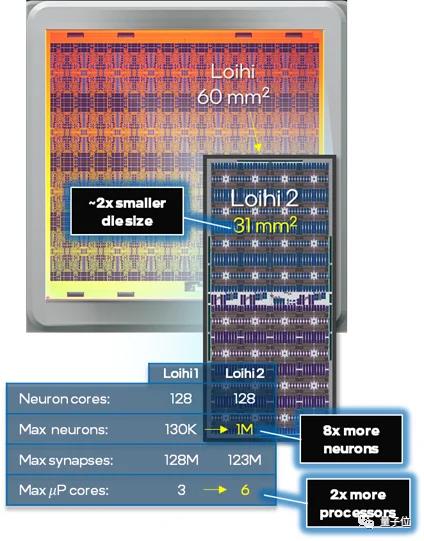

2018年初,英特尔推出了其首款神经拟态芯片Loihi,采用14nm制程。

英特尔表示,Loihi 2是对第一代的重大升级,也是使用英特尔第一个EUV工艺节点Intel 4制造的芯片,意为等效于4nm,实际为7nm工艺。

由于使用了全新工艺,Loihi 2相比前代面积缩小了一半,但仍然包含100万个神经元,数量是前代的8倍,处理速度是前代的10倍。

Loihi 2共有128个神经拟态核心,这128个内核每一个都有192KB的灵活内存,每个神经元可以根据模型分配多达4096个状态,而之前的限制只有24个。

与普通的CPU和GPU不同,神经拟态没有外部内存。每个神经元都有一小部分内存供其专用。主要作用是分配给不同神经元输入的权重、最近活动的缓存以及峰值发送到的所有其他神经元的列表。

Loihi 2可以根据用途选择各种不同连接选项,这一点上有些类似于FPGA。

除了硬件产品外,英特尔还发布了用于Loihi芯片的软件,一个名为Lava的新开发框架。

该框架以及相关库都用Python编写,并在GitHub上开源,开发人员无需访问硬件即可为Loihi开发程序。

与神经网络有何不同

生物神经元包含树突和轴突。

Loihi芯片上执行单元的一部分充当“树突”,根据过去行为的权重处理来自通信网络的传入信号。

然后它使用数学公式来确定活动何时越过临界阈值,并在超过临界阈值时触发其自身的尖峰信号。之后执行单元的“轴突”查找与哪些其他执行单元通信,并向每个执行单元发送尖峰信号。

为何要研究这种类型芯片?神经拟态计算的倡导者认为,这种方法更接近地模拟大脑功能的实际特征,例如大脑传输信号超高的能效比。

而研究深度学习学者,批评神经形态方法没有取得实际成果,像ResNet等深神经网络已经在计算机视觉上取得了巨大的成功

Yann LeCun曾在2019年的一次会议上驳斥了神经拟态计算方法。

虽然神经拟态计算的研究热度远不及神经网络,但神经拟态芯片的优点在于其能效远高于传统处理器。

IBM于2014年推出了TrueNorth芯片,尽管其运行频率只有几kHz,但它所模拟大脑尖峰神经网络所需的计算资源,只传统处理器0.0001%。

英特尔神经形态计算实验室主任Mike Davies表示,Loihi在某些特定工作负载上,可以比传统处理器效率高出2000倍。

此外,神经拟态计算还能实现动态学习行为。

神经网络非常善于识别训练过的失误,但不够灵活,无法识别他们没有训练的东西。Davies曾展示了神经拟态计算根据视频输入学会识别新的手势,同时不损坏之前训练的能力。

Davies认为,神经拟态芯片在机器人学中有很多潜在的应用。当移动机器人发现自己面临新环境时,它们必须足够灵活,以识别和适应新环境。

参考链接:

[1]https://www.intel.com/content/www/us/en/newsroom/news/intel-unveils-neuromorphic-loihi-2-lava-software.html

[2]https://www.anandtech.com/show/16960/intel-loihi-2-intel-4nm-4

[3]https://www.zdnet.com/article/intel-rolls-out-second-gen-loihi-neuromorphic-chip/

以上是关于英特尔发布首个7nm芯片Loihi 2,用于神经拟态计算,可模拟100万神经元的主要内容,如果未能解决你的问题,请参考以下文章