字节博士搞的AI火了,一键完美分离人声和伴奏 | 在线可玩

Posted QbitAl

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了字节博士搞的AI火了,一键完美分离人声和伴奏 | 在线可玩相关的知识,希望对你有一定的参考价值。

博雯 发自 凹非寺

量子位 报道 | 公众号 QbitAI

写歌填词、改换风格、续写音乐的AI,今天又来做编曲人了!

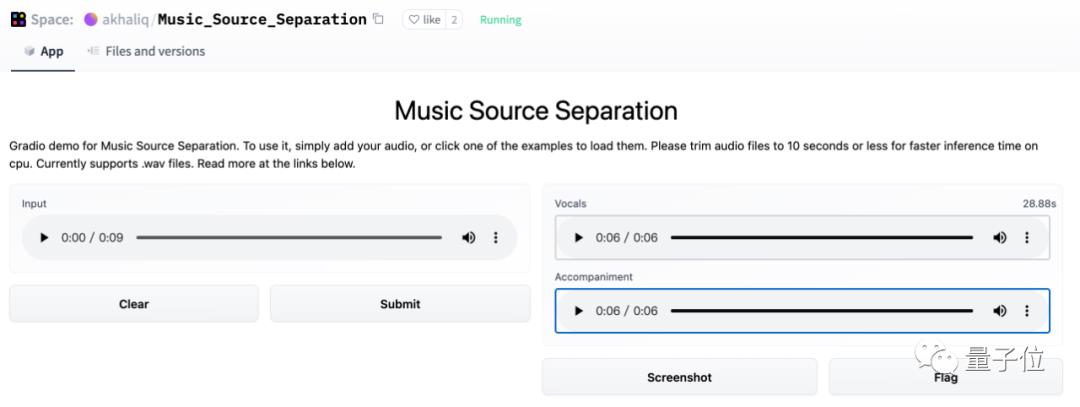

上传一段《Stay》,一键按下:

伴奏和人声就轻松分离。

人声颇有种在空旷地带清唱的清晰感,背景乐都能直接拿去做混剪了!

这样惊人的效果也引发了Reddit热议:

这项研究的主要负责人孔秋强来自字节跳动,全球最大的古典钢琴数据集GiantMIDI-Piano,也是由他在去年牵头发布的。

那么今天,他又带来了怎样的一个AI音乐家呢?

一起来看看。

基于深度残差网络的音源分离

这是一个包含了相位估计的音乐源分离(MSS)系统。

首先,将幅值(Magnitude)与相位(Phase)解耦,用以估计复数理想比例掩码(cIRM)。

其次,为了实现更灵活的幅值估计,将有界掩码估计和直接幅值预测结合起来。

最后,为MSS系统引入一个143层的深度残差网络(Deep Residual UNets),利用残差编码块(REB)和残差解码块(RDB)来增加其深度:

残差编码块和残差卷积块中间还引入了中间卷积块(ICB),以提高残差网络的表达能力。

其中每个残差编码块由4个残差卷积块(RCB)组成,残差卷积块又由两个核大小为3×3的卷积层组成。

每个残差解码块由8个卷积层和1个反卷积层组成。

实验结果

接下来,将这一系统在MUSDB18数据集上进行实验。

MUSDB18中的训练/验证集分别包含100/50个完整的立体声音轨,包括独立的人声、伴奏、低音、鼓和其他乐器。

在训练时,利用上述系统进行并行的混合音频数据增强,随机混合来自同一来源的两个3秒片段,然后作为一个新的3秒片段进行训练。

以信号失真率(SDR)作为评判标准,可以看到ResUNetDecouple系统在分离人声、低音、其他和伴奏方面明显优于以前的方法:

在消融实验中,143层残差网络的表现也证实了,结合有界掩码估计和直接幅值预测确实能够改善声音源分离系统的性能。

作者介绍

这项研究的论文一作为孔秋强,本硕都毕业于华南理工大学,博士则毕业于英国萨里大学的电子信息工程专业。

他在2019年加入字节跳动的Speech, Audio and Music Intelligence研究小组,主要负责音频信号处理和声音事件检测等领域的研究。

论文:

https://arxiv.org/abs/2109.05418

试玩:

https://huggingface.co/spaces/akhaliq/Music_Source_Separation

开源地址:

https://github.com/bytedance/music_source_separation

参考链接:

https://www.reddit.com/r/MachineLearning/comments/pqpl7m/r_decoupling_magnitude_and_phase_estimation_with/

以上是关于字节博士搞的AI火了,一键完美分离人声和伴奏 | 在线可玩的主要内容,如果未能解决你的问题,请参考以下文章