基于Transformers入门自然语言处理!

Posted Datawhale

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了基于Transformers入门自然语言处理!相关的知识,希望对你有一定的参考价值。

前言

读者朋友们好,我是多多,许久未见,甚是想念。

我最近忙了1件自己感觉有意义的事情,特来分享。我将之前零零散散的Transformer博客、讲解文章进行了整理,形成了一个完整的教程叫做:learn nlp with transformers,翻译过来是:基于Transformers入门自然语言处理。在这个Transformer横行的时间点,我也希望这个开源教程能够帮助到刚刚接触Transformers、刚刚接触NLP的同学们!

教程网站是:https://datawhalechina.github.io/learn-nlp-with-transformers

教程Github是:https://github.com/datawhalechina/learn-nlp-with-transformers (截止目前165 Stars 欢迎点Star支持)

先特别感谢以下个人,组织的大力支持,再对Transformer教程进行介绍。感谢:张帆,张贤,李泺秋,蔡杰,hlzhang,台运鹏, 张红旭,文睿,开源组织Datawhale,Datawhale热心的组队学习成员们以及内测的全部同学们!

写教程的出发点

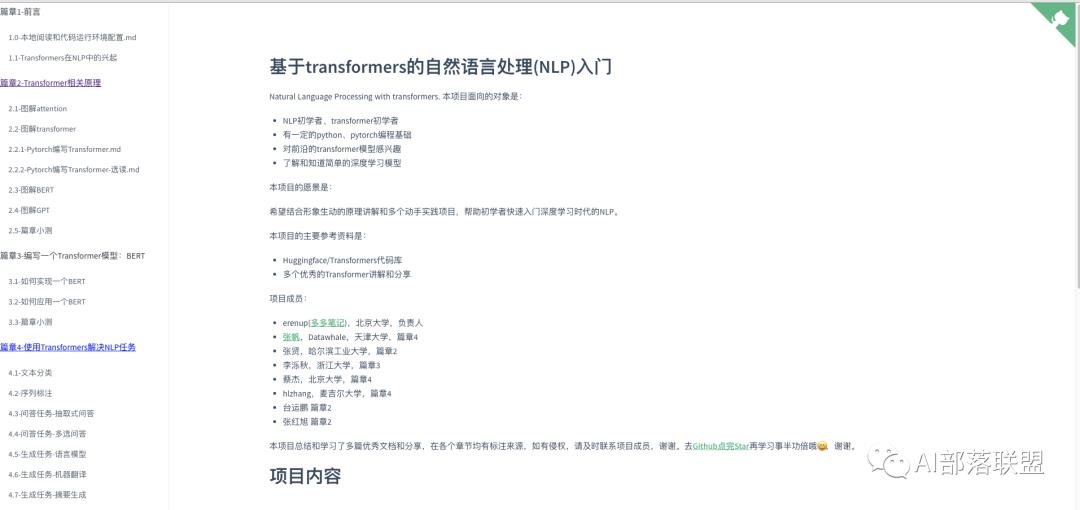

写这个教程的初衷是:当初自己入门NLP的时候,受到了很多大佬博客的帮助,所以也希望自己在力所能及的范围内帮助一下未来的NLP、Transformer初学者。所以我在参考了网上诸多大佬的文章、代码讲解后,结合一些个人的理解,整理了这个教程。希望这个教程能帮助到以下特点的学习者:

NLP初学者、transformer初学者

有一定的python、pytorch编程基础

对前沿的transformer、NLP模型感兴趣

了解和知道简单的深度学习模型

教程主要内容

教程从Attention、注意力机制出发,讲解Transformer模型结构,然后详解BERT、GPT原理和预训练方法,再深入实现一个BERT,最后基于流行的Huggingface/Transformers代码库调用各种Transformer模型来解决4大类经典NLP任务。

教程的主要章节和内容是:

篇章1-前言

1.0-本地阅读和代码运行环境配置

1.1-Transformers在NLP中的兴起

篇章2-Transformer相关原理

2.1-图解attention

2.2-图解transformer

2.2.1-Pytorch编写Transformer

2.2.2-Pytorch编写Transformer-选读

2.3-图解BERT

2.4-图解GPT

2.5-篇章小测

篇章3-编写一个Transformer模型:BERT

3.1-如何实现一个BERT

3.2-如何应用一个BERT

3.3-篇章小测

篇章4-使用Transformers解决NLP任务

4.0-前言

4.1-文本分类

4.2-序列标注

4.3-问答任务-抽取式问答

4.4-问答任务-多选问答

4.5-生成任务-语言模型

4.6-生成任务-机器翻译

4.7-生成任务-摘要生成

4.8-篇章小测

感兴趣的读者朋友们可以在github中查看更多细节,也欢迎点Star支持哦!

结语

由于本人水平有限,所撰写的内容难免出现错误,希望读者朋友们在发现错误或者歧义的表述时能够不吝指出,也可以提交pull request帮忙修正和改进,感谢!

觉得不错帮点赞、转发、在看支持吧~~谢谢。

欢迎关注公众号后回复“交流”,进入Transformer学习群。

以上是关于基于Transformers入门自然语言处理!的主要内容,如果未能解决你的问题,请参考以下文章