docker私有仓库registry和资源控制cgroup

Posted 遙遙背影暖暖流星

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了docker私有仓库registry和资源控制cgroup相关的知识,希望对你有一定的参考价值。

私有仓库registry和资源控制cgroup

一、私有镜像的建立

1、下载,并修改daemon文件

[root@docker ~]# docker pull registry

[root@docker ~]# vim /etc/docker/daemon.json

{

"insecure-registries": ["192.168.100.21:5000"], #添加本行,本地ip

"registry-mirrors": ["https://xxxxx.mirror.aliyuncs.com"] #自己阿里云的镜像加速器

}

[root@docker ~]# systemctl restart docker

2、修改镜像标签,并上传到registry

[root@docker ~]# docker run -d -p 5000:5000 -v /data/registry:/tmp/registry registr y

2792c5e1151a50f6a1131ac3b687f5f4314fe85d9f6f7ba2c82f96a964135dc4

#启动registry并挂载目录

[root@docker ~]# docker tag nginx:v1 192.168.100.21:5000/nginx

#打上本地标签

[root@docker ~]# docker push 192.168.100.21:5000/nginx

#上传到本地仓库

Using default tag: latest

The push refers to repository [192.168.100.21:5000/nginx]

[root@docker ~]# curl -XGET http://192.168.100.21:5000/v2/_catalog

#查看镜像列表

{"repositories":["nginx"]}

[root@docker ~]# docker rmi 192.168.100.21:5000/nginx:latest

#测试删除镜像

[root@docker ~]# docker images

REPOSITORY TAG IMAGE ID CREATED SIZE

nginx v1 8ac85260ea00 2 hours ago 205MB

centos 7 8652b9f0cb4c 9 months ago 204MB

[root@docker ~]# docker pull 192.168.100.21:5000/nginx:latest

#下载

latest: Pulling from nginx

Digest: sha256:ccb90b53ff0e11fe0ab9f5347c4442d252de59f900c7252660ff90b6891c3be4

Status: Downloaded newer image for 192.168.100.21:5000/nginx:latest

192.168.100.21:5000/nginx:latest

[root@docker ~]# docker images

REPOSITORY TAG IMAGE ID CREATED SIZE

192.168.100.21:5000/nginx latest 8ac85260ea00 2 hours ago 205MB

nginx v1 8ac85260ea00 2 hours ago 205MB

centos 7 8652b9f0cb4c 9 months ago 204MB

二、cgroup资源配置

Cgroup概述

Cgroup是control groups的缩写,是linux内核提供的一种可以限制、记录、隔离进程组所使用的物理资源的机制

物理资源如CPU、内存、磁盘IO等等

Cgroup被LXC、docker等很多项目用于实现进程资源控制。cgroup本身是提供将进程进行分组化管理的功能和接口的基础结构,IO或内存的分配控制等具体的资源管理是通过该方式

这些具体的资源管理功能成为cgroup子系统,有以下几大子系统实现:

blkio:设置限制每个块设备的输入输出控制,例如磁盘、光盘及USB等

CPU:使用调度程序为cgroup任务提供CPU的访问

cpuacct:产生cgroup任务的cpu资源报告

cpuset:如果是多核心的cpu,这个子系统会为cgroup任务分配单独的cpu和内存

devices:允许或拒绝cgroup任务对设备的访问

freezer:暂停和恢复cgroup任务

memory:设置每个cgroup的内存限制以及产生内存资源报告

net_cls:标记每个网络包以供cgroup方便使用

ns:命名空间子系统

perf_event:增加了对每个group的监测跟踪的能力,可以监测属于某个特定的group的所有线程以及运行在特定CPU的线上

1、docker资源控制cpu

利用stress压力测试工具来测试CPU和内存使用状况。

使用Dockerfile 来创建一个基于centos 的stress工具镜像

[root@docker ~]# mkdir /opt/stress

[root@docker ~] # vim /opt/stress/Dockerfile

FROM centos:7

RUN yum install -y wget

RUN wget -O /etc/yum.repos.d/epel.repo http://mirrors.aliyun.com/repo/epel-7.repo

RUN yum install -y stress

[root@docker ~]# cd /opt/stress/

[root@docker ~]# docker build -t centos:stress .

[root@docker stress]# docker images

REPOSITORY TAG IMAGE ID CREATED SIZE

centos stress cc9f380c2556 About a minute ago 520MB

(1)、cpu-shares参数

创建容器时,命令中的–cpu-shares参数值不能保证可以获得 1个vcpu或者多少GHz的CPU资源,它仅是一个弹性的加权值

[root@docker stress]# docker run -itd --cpu-shares 100 centos:stress

3d423eabad883fa1001c21a506d899a0c5060aca32080a69f2f9a715d9e357c5

说明:默认情况下,每个Docker容器的CPU份额都是1024。单独一个容器的份额是没有意义的。只有在同时运行多个容器时,容器的CPU加权的效果才能体现出来。

例如,两个容器A、B的CPU份额分别为1000和500,在CPU进行时间片分配的时候,容器A比容器B多一倍的机会获得CPU的时间片。

但分配的结果取决于当时主机和其他容器的运行状态,实际上也无法保证容器A一定能获得CPU时间片。比如容器A的进程一直是空闲的,

那么容器B是可以获取比容器A更多的CPU时间片的。极端情况下,例如主机上只运行了一个容器,即使它的CPU份额只有50,它也可以独占整个主机的CPU资源。

Cgroups只在容器分配的资源紧缺时,即在需要对容器使用的资源进行限制时,才会生效。因此,无法单纯根据某个容器的CPU份额来确定有多少CPU资源分配给它,资源分配结果取决于同时运行的其他容器的CPU分配和容器中进程运行情况。

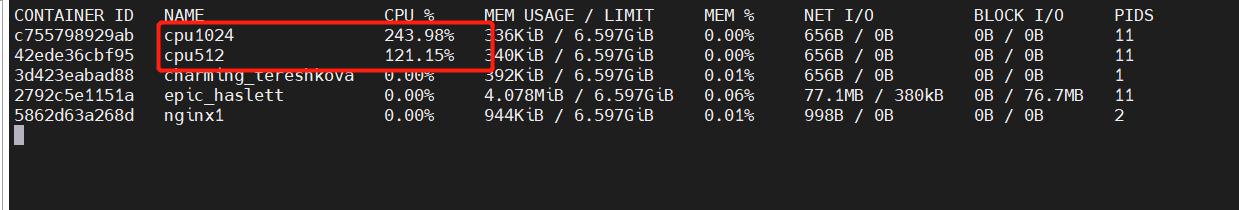

可以通过cpu share可以设置容器使用CPU的优先级,比如启动了两个容器及运行查看cPU使用百分比。

[root@docker stress]# docker run -tid --name cpu512 --cpu-shares 512 centos:stress stress -c 10

# 容器产生10个子函数进程

#再开启一个容器做比较

[root@docker stress]# docker run -tid --name cpu1024 --cpu-shares 1024 centos:stress stress -c 10

[root@docker stress]# docker stats

总结:多个容器时,参数–cpu-shares 相当与对cpu的使用权进行加权,一般权越大获得的cpu资源越多

(2)、cpu的周期限制

–cpu-quota是用来指定在这个周期内,最多可以有多少时间用来跑这个容器。

与–cpu-shares不同的是,这种配置是指定一个绝对值,容器对CPU资源的使用绝对不会超过配置的值。

cpu-period和 cpu-quota 的单位为微秒(us)。cpu-period的最小值为1000微秒,最大值为1秒(10^6us ) ,默认值为0.1 秒( 100000 us) 。

cpu-quota 的值默认为–1,表示不做控制。cpu-period和 cpu-quota 参数一般联合使用。

例如:容器进程需要每1秒使用单个CPU的0.2秒时间,可以将cpu-period 设置为1000000 (即1秒) , cpu-quota设置为200000(0.2 秒)。

当然,在多核情况下,如果允许容器进程完全占用两个CPU,则可以将cpu-period 设置为10000(即 0.1秒),cpu-quota设置为200000 (0.2秒)。

cat /sys/fs/cgroup/cpu/docker/容器ID/cpu.cfs period_us

cat /sys/fs/cgroup/cpu/docker/容器ID/cpu.cfs_quota_us

-1代表cpu资源使用是不受限制的,上限是硬件

[root@docker ~]# cd /sys/

[root@docker sys]# ls

block bus class dev devices firmware fs hypervisor kernel module power

[root@docker sys]# cd fs/

[root@docker fs]# ls

bpf cgroup pstore xfs

[root@docker fs]# cd cgroup/

[root@docker cgroup]# ls

blkio cpu,cpuacct freezer net_cls perf_event

cpu cpuset hugetlb net_cls,net_prio pids

cpuacct devices memory net_prio systemd

[root@docker cgroup]# cd cpu

[root@docker cpu]# ls

cgroup.clone_children cpuacct.usage cpu.rt_runtime_us release_agent

cgroup.event_control cpuacct.usage_percpu cpu.shares system.slice

cgroup.procs cpu.cfs_period_us cpu.stat tasks

cgroup.sane_behavior cpu.cfs_quota_us docker user.slice

cpuacct.stat cpu.rt_period_us notify_on_release

[root@docker cpu]# cd docker/

[root@docker docker]# ls

2792c5e1151a50f6a1131ac3b687f5f4314fe85d9f6f7ba2c82f96a964135dc4 cpu.cfs_period_us

5862d63a268dde038555f211afed8bde87f72ccdbf2d7c157737dfd7f1dac9fd cpu.cfs_quota_us

cgroup.clone_children cpu.rt_period_us

cgroup.event_control cpu.rt_runtime_us

cgroup.procs cpu.shares

cpuacct.stat cpu.stat

cpuacct.usage notify_on_release

cpuacct.usage_percpu tasks

[root@docker docker]# cat cpu.cfs_quota_us

-1

[root@docker docker]# cd 2792c5e1151a50f6a1131ac3b687f5f4314fe85d9f6f7ba2c82f96a9641 35dc4/

[root@docker 2792c5e1151a50f6a1131ac3b687f5f4314fe85d9f6f7ba2c82f96a964135dc4]# ls

cgroup.clone_children cpuacct.stat cpu.cfs_period_us cpu.rt_runtime_us notify_on_release

cgroup.event_control cpuacct.usage cpu.cfs_quota_us cpu.shares tasks

cgroup.procs cpuacct.usage_percpu cpu.rt_period_us cpu.stat

[root@docker 2792c5e1151a50f6a1131ac3b687f5f4314fe85d9f6f7ba2c82f96a964135dc4]# cat cpu.cfs_period_us

1000000 #cpu分片,单位微秒um,=1秒

[root@docker 2792c5e1151a50f6a1131ac3b687f5f4314fe85d9f6f7ba2c82f96a964135dc4]# cat cpu.cfs_quota_us

-1

备注:

cpu周期 1s =100000微秒

按照cpu时间周期分配

cpu在一个瞬间时刻,只能给一个进程占用

在这里插入代码片

(2.1) 对容器cpu的限制方法

假如以20%为例

[root@docker cpu]# docker run -itd --name centos_quota --cpu-period 100000 --cpu-quota 200000 centos:stress

[root@docker cpu]# docker inspect centos_quota

(3)、CPU Core控制

对多核CPU的服务器,Docker还可以控制容器运行使用哪些CPU内核,即使用–cpuset-cpus 参数。这对具有多CPU的服务器尤其有用,可以对需要高性能计算的容器进行性能最优的配置。

[root@docker ~]# docker run -itd --name cpu1 --cpuset-cpus 0-1 centos:stress

#执行以上命令需要宿主机为双核,表示创建的容器只能用0、1两个内核。

7b97035a0750aadd848769f7f5049d5f001eef48d5eb068ec9a6c3774ebece5d

[root@docker ~]# cat /sys/fs/cgroup/cpuset/docker/7b97035a0750aadd848769f7f5049d5f001eef48d5eb068ec9a6c3774ebece5d/cpuset.cpus

0-1

通过下面指令可以看到容器中进程与CPU内核的绑定关系,达到绑定CPU内核的目的。

[ root@localhost stress]# docker exec 容器ID taskset -c -p 1

#容器内部第一个进程号pid为1被绑定到指定CPU上运行

小结:

容器限制资源的方式:

1、创建容器时直接使用参数指定资源限制

2、创建容器后,指定资源分配

修改宿主机对应容器资源控制的文件/sys/fs/cgroup/中的文件

CPU配额控制参数的混合使用

通过cpuset-cpus参数指定容器A使用CPU内核0,容器B只是用CPU内核1。

在主机上只有这两个容器使用对应CPU内核的情况,它们各自占用全部的内核资源,cpu-shares没有明显效果。

cpuset-cpus、cpuset-mems

参数只在多核、多内存节点上的服务器上有效,并且必须与实际的物理配置匹配,否则也无法达到资源控制的目的。

在系统具有多个CPU内核的情况下,需要通过cpuset-cpus参数为设置容器CPU内核才能方便地进行测试。

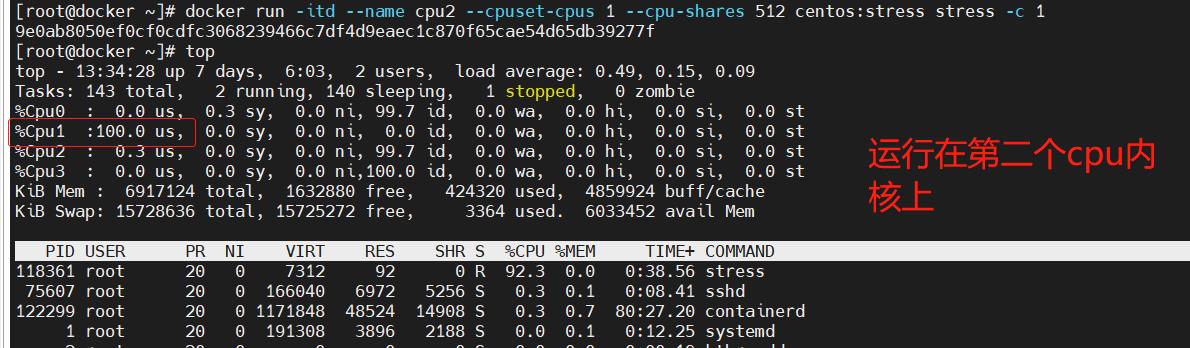

docker run -itd --name cpu2 --cpuset-cpus 1 --cpu-shares 512 centos:stress stress -c 1

#--cpuset-cpus指定运行的cpu

9e0ab8050ef0cf0cdfc3068239466c7df4d9eaec1c870f65cae54d65db39277f

[root@docker ~]# top

(4)内存限额

与操作系统类似,容器可使用的内存包括两部分:物理内存和 Swap

Docker 通过下面两组参数来控制容器内存的使用量。

-m或–memory:设置内存的使用限额,例如100M、1024M。

–memory-swap:设置内存+swap 的使用限额。

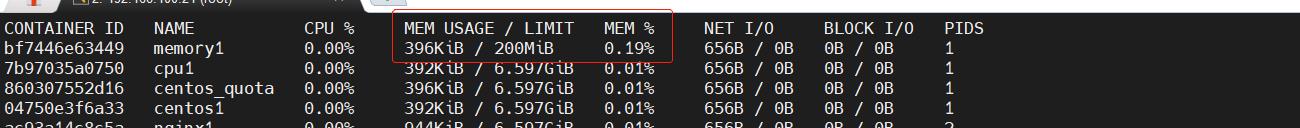

执行如下命令允许该容器最多使用200M的内存和 300M 的swap

[root@docker ~]# docker run -itd --name memory1 -m 200M --memory-swap=300M centos:stress

#默认情况下,容器可以使用主机上的所有空闲内存。

#与CPU的cgroups 配置类似,Docker 会自动为容器在目录 /sys/fs/cgroup/memory/docker/<容器的完整长 ID>

中创建相应cgroup配置文件

docker stats

(5)、Block IO的限制

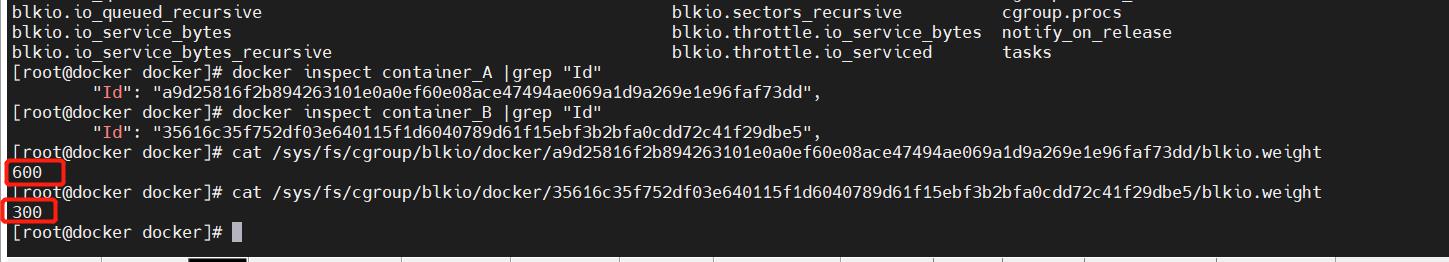

默认情况下,所有容器能平等地读写磁盘,可以通过设置–blkio-weight参数来改变容器 block io 的优先级。–blkio-weight 与–cpu-shares类似,设置的是相对权重值,默认为500。

在下面的例子中,容器A读写磁盘的带宽是容器B的两倍。

root@docker ~]# docker run -itd --name container_A --blkio-weight 600 centos:stress

[root@docker ~]# docker run -itd --name container_B --blkio-weight 300 centos:stress

(6)bps和iops 的限制

bps 是byte per second,每秒读写的数据量。

iops 是io per second,每秒IO的次数。可通过以下参数控制容器的bps 和iops:

--device-read-bps,限制读某个设备的bps

--device-write-bps,限制写某个设备的bps。--device-read-iops,限制读某个设备的iops

--device-write-iops,I限制写某个设备的iops

下面的示例是限制容器写/dev/sda 的速率为5 MB/s .

通过 dd 命令测试在容器中写磁盘的速度。因为容器的文件系统是在host /dev/sda 上的,在容器中写文件相当于对 host /dev/sda进行写操作。另外,oflag=direct 指定用direct Io 方式写文件,这样 --device-write-bps 才能生效。

限速5MB/S,10MB/S,不限速,结果如下:

[root@docker ~]# docker run -it --device-write-bps /dev/sda:5MB centos:stress

[root@26fdd492da03 /]# dd if=/dev/zero of=test bs=1M count=10 oflag=direct

10+0 records in

10+0 records out

10485760 bytes (10 MB) copied, 2.00582 s, 5.2 MB/s

[root@26fdd492da03 /]# exit

exit

[root@docker ~]# docker run -it --device-write-bps /dev/sda:10MB centos:stress

[root@da528f6758bb /]# dd if=/dev/zero of=test bs=1M count=10 oflag=direct

10+0 records in

10+0 records out

10485760 bytes (10 MB) copied, 0.95473 s, 11.0 MB/s

[root@da528f6758bb /]# exit

exit

[root@docker ~]# docker run -it centos:stress

[root@02a55b38d0fa /]# dd if=/dev/zero of=test bs=1M count=10 oflag=direct

10+0 records in

10+0 records out

10485760 bytes (10 MB) copied, 0.00934216 s, 1.1 GB/s

[root@02a55b38d0fa /]# exit

exit

构建镜像时指定资源限制

--build-arg=[] : 设置镜像创建时的变量;

--cpu-shares : 设置cpu使用权重;

--cpu-period : 限制CPU CFS周期;

--cpu-quota : 限制CPU CFS配额;

--cpuset-cpus : 指定使用的CPU id;

--cpuset-mems : 指定使用的内存id;

--disable-content-trust : 忽略校验,默认开启;

-f : 指定要使用的Dockerfile路径;

--force-rm : 设置镜像过程中删除中间容器;

--isolation : 使用容器隔离技术;

--label=[] : 设置镜像使用的元数据;

-m : 设置内存最大值;

--memory-swap : 设置Swap的最大值为内存swap, "-1"表示不限swap;

--no-cache : 创建镜像的过程不使用缓存;

--pull : 尝试去更新镜像的新版本;

--quiet, -q : 安静模式,成功后只输出镜像ID;

--rm : 设置镜像成功后删除中间容器;

--shm-size : 设置/dev/shm的大小,默认值是64M;

--ulimit : Ulimit配置;

--squash : 将Dockerfile 中所有的操作压缩为一层;

--tag, -t: 镜像的名字及标签,通常name:tag或者name格式;可以在一次构建中为一个镜像设置多个标签。

--network : 默认default;在构建期间设置RUN指令的网络模式

以上是关于docker私有仓库registry和资源控制cgroup的主要内容,如果未能解决你的问题,请参考以下文章