多模态情感识别数据集和模型(下载地址+最新综述2021.8)

Posted 鬼扯子

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了多模态情感识别数据集和模型(下载地址+最新综述2021.8)相关的知识,希望对你有一定的参考价值。

引用论文:Zhao, Sicheng, et al. “Emotion Recognition from Multiple Modalities: Fundamentals and Methodologies.” arXiv preprint arXiv:2108.10152 (2021).

PDF链接:Emotion Recognition from Multiple Modalities: Fundamentals and Methodologies.

新鲜出炉的赵思成和杨巨峰大佬的论文哦(情感识别领域的专家),全面的梳理了多模态情感识别(Multi-modal Emotion Recognition, MER)的多个关键方面,是一篇日期新鲜(2021.08),内容详实,高质量的综述,非常适合入门的同学入手和老司机们回顾总结。翻译和整理了一上午,有用请帮我点个赞再走吧,谢谢Thanks♪(・ω・)ノ~

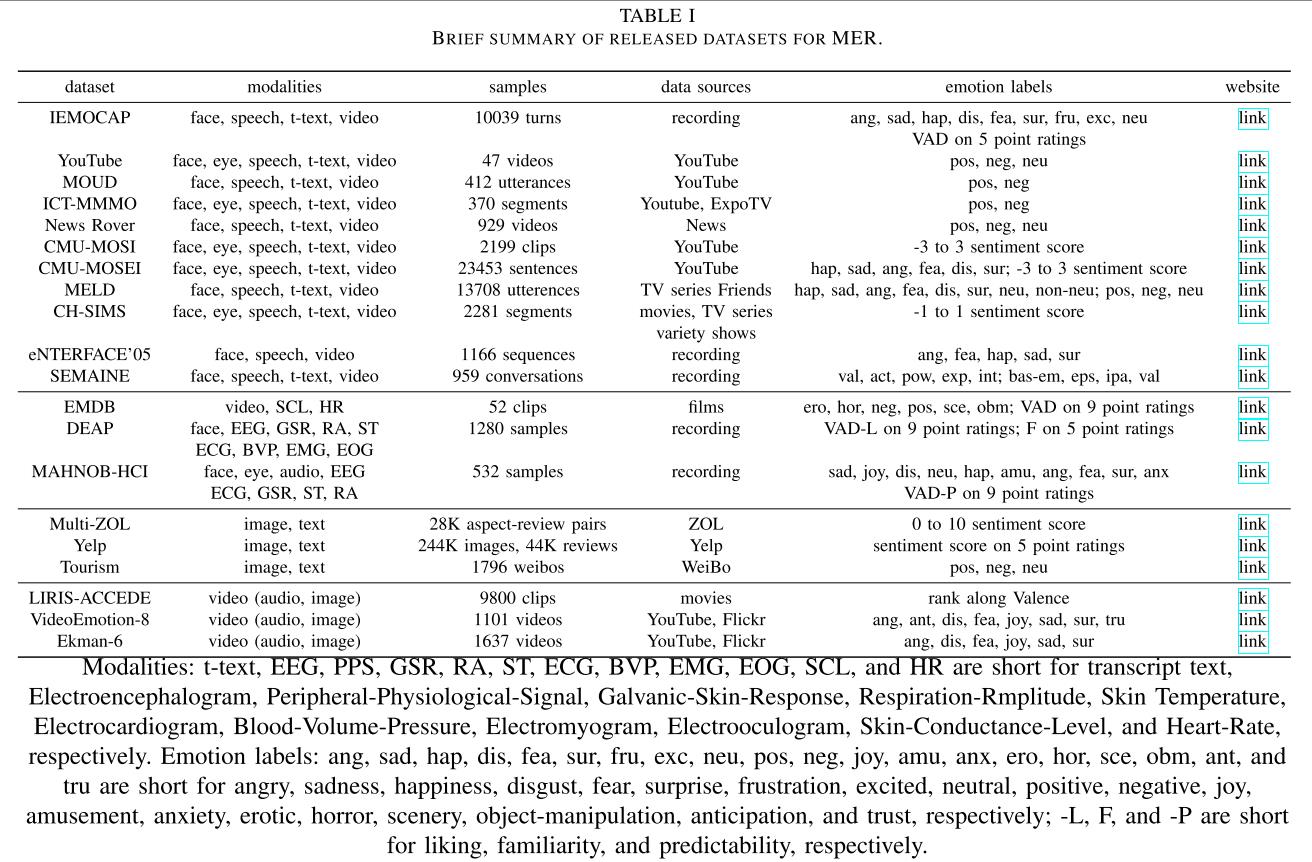

一、多模态数据集

下表为多模态数据集,可以看到最后一列给出了下载地址,需要数据集的朋友们可以点上面链接地址进入文章下载,如果除了数据集还想了解多模态情感识别(MER)的其他章节内容(模型,难点,挑战,任务,方法,应用),请继续往下阅读哦~

二、广泛使用的情感表达模型

目前,学术界对情绪分类并没有统一的定义,一般的情绪分类主要有两大基本观点:离散模式(categorical emotion states (CES))和连续模式( dimensional emotion space (DES))。离散模式认为情绪具有完全不同的结构,连续模式认为不同情绪之间有着过渡阶段。

1、CES情感模型定义情感通过几个基本分类,包括以下:

binary sentiment :positive and negative, sometimes including neutral;

Ekman’s six basic emotions: positive happiness, surprise and negative anger, disgust, fear, sadness;

Mikels’s eight emotions: positive amusement, awe, contentment, excitement, and negative anger, disgust, fear, sadness;

Plutchik’s emotion wheel :eight basic emotion categories by three intensities;

Parrott’s tree hierarchical grouping :primary, secondary and tertiary categories.

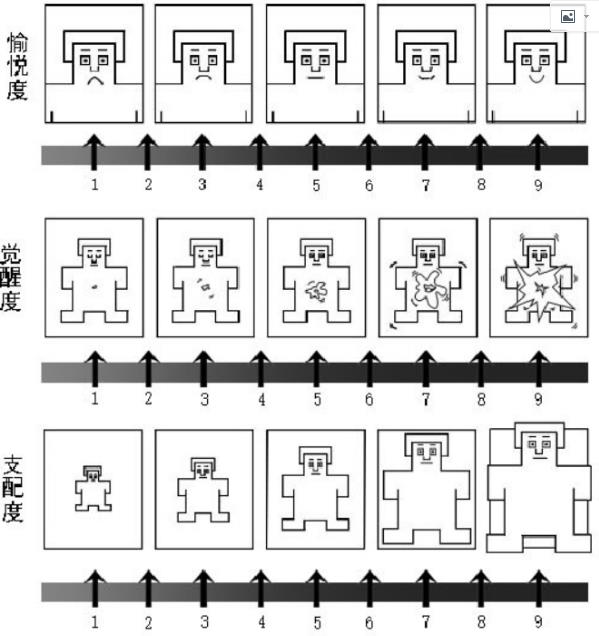

2、DES定义情感通过连续空间的2D,3D或更高维度的的卡尔坐标系,包括以下:

valence-arousal-dominance (VAD):where valence, measure all emotions as different coordinate points in the continuous Cartesian space, but the absolute continuous values are beyond users’ understanding.

- PAD情感三维理论是由Mehrabian 和Russell 于1974年提出的维度观测量模型 ,该模型认为情感具有愉悦度 、激活度和优势度3个维度,其中P代表愉悦度(Pleasure-displeasure),表示主体情感状态的正负性;A代表觉醒度(Arousal-nonarousal),表示主体的神经生理激活水平;D代表优势度(Dominance-submissiveness),表示主体对情景和他人的控制状态,是个体情绪被控制和主导的状态,由内而外的自发情绪就是支配性的情绪如愤怒,由外而内的被动情绪就是服从性的情绪如害怕。同时也可以用这3个维度的值来代表具体的情绪和情感。研究表明,利用 PDA的3 个维度可有效地解释人类的情感。Mehrabian 等人利用这3个维度可解释其他42种情感量表中的绝大部分变异 ,而且这3个维度并不限于描述情感的主观体验,它与情感的外部表现、生理唤醒有较好的映射关系。前人研究表明:PAD三维情感模型可以充分地表达和量化人类情绪和情感,是情感计算研究的基础 。

- 情绪自我评价等级系统(SAM)

佛罗里达大学情绪和注意研究中心教授 Bradley 和 Lang,以 PAD 模型为基础设计了一种测量被试情绪反应的情绪自我评价等级系统 SAM。SAM 通过抽象的卡通人物绘图表示愉悦度、觉醒度、支配度,如下图所示。其中,皱眉噘嘴的头像到微笑的图像代表愉悦度从低到高;从放松昏睡的图像到兴奋睁眼的图像表示觉醒度从弱到强;从小人到大人的图像表示支配度从小到大。

These two types of definitions of emotions are related, with possible transformation from CES to DES. For example, anger relates to negative valence, high arousal, and high dominance. Besides emotion, there are several other widely used concepts in affective computing, such as mood, affect, and sentiment. Emotions can be expected, induced, or perceived. We do not aim distinguishing them in this article. Please refer to [11] for more details on the differences or correlations between these concepts.(两种模型之间可以想换转换)

三、多模态情感诱发方式

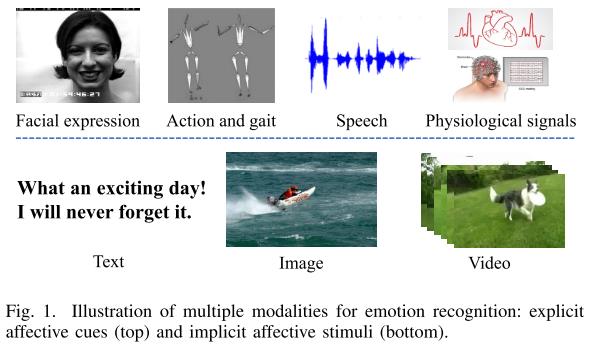

在MER(多模态情感识别)领域,多种模式(multi-modal)被用于识别和预测人类情绪。根据情感是来自人体的身体变化还是来自外部数字媒体,MER中的情感模态可以大致分为两类:

显性情感线索:包括面部表情、眼球运动、语言、动作、步态和脑电图,所有这些都可以直接观察、记录或从个人身上收集。

隐性情感刺激:后者表示常用的数字媒体类型,如文本、音频、图像和视频。我们使用这些数据类型来存储信息和知识,以及在数字设备之间传输信息和知识。通过这种方式,情感可能会含蓄地参与和唤起。虽然单一模式作为情感表达的可靠渠道的有效性无法保证,但联合考虑多种模式将显著提高[12]的可靠性和稳健性。

四、多模态情感识别任务

对于多模态情感信号,我们可以进行不同的MER任务,包括分类、回归、检测和检索。

1、 Emotion Classification(分类)

在情感分类任务中,我们假设样本只能属于一个或固定数量的情感类别,其目标是发现数据空间[16]中的类边界或类分布。目前的工作主要集中在多模态特征和分类器的手工设计或以端到端方式使用深度神经网络。

MER定义为单标签学习(SLL)问题,为每个样本分配一个显性情绪标签。然而,情感可能是来自不同区域或序列的所有成分的混合物,而不是一个单一的代表性情感。与此同时,不同的人可能有对同一刺激产生不同的情绪反应,这是由性格等多种因素引起的。因此,多标签学习(MLL)被用来研究一个实例与多个情绪标签关联的问题。

最近,为了解决MLL不能很好地适应实际应用的问题,不同标签重要性的总体分布很重要,标签分布学习(LDL)被提出,覆盖一定数量的标签,代表每个情绪标签描述实例[20]的程度。

2、 Emotion Regression(回归)

情感回归的目的是学习一种映射函数可以有效地将一个实例与笛卡尔空间中的连续情感值联系起来。最常用的MER回归算法旨在将平均维数值分配给源数据。为了解决情绪固有的主观性,研究者提出了预测在维价唤起空间中表现的情绪的连续概率分布的方法。具体地说,可以用高斯混合模型(GMM)来表示情感标签,然后将情感分布预测形式化为参数学习问题[21]。

3、Emotion Detection

由于原始数据不能保证承载情绪,或者只有部分数据能够引起情绪反应,所以情绪检测的目的是找出源数据中哪一种情绪在哪里。例如,Yelp上的餐厅评论可能是“这家餐厅就在我工作的街对面,非常方便,步行对我来说是一个巨大的加分!” 在食物方面,那里和我去过的几乎所有地方都一样,所以没什么可说的。我不得不说,客户服务是命中注定或错过。”同时,总体评分是3星(满分5星)。这篇评论包含了不同的情绪和态度:第一句是积极的,第二句是中立的,最后一句是消极的。因此,系统检测哪个句子对应哪个情绪是至关重要的。另一个例子是图像[22]中的情感区域检测。

4、 Emotion Retrieval

如何基于人的感知来搜索情感内容是另一个有意义的任务。现有框架首先检测查询和候选数据源中的局部兴趣块或序列。然后,通过确定两个patch或序列之间的距离是否小于给定的固定阈值来发现所有匹配的对。查询与每个候选项之间的相似度得分被计算为匹配组件的数量,然后对该查询的可候选项进行相应的排名。尽管情感检索系统有助于从海量存储库[10]中获取具有所需情感的在线内容,但抽象和主观特征使任务具有挑战性和难以评估。

五、该领域存在的挑战和困难

1、Affective Gap(情感鸿沟/差距)

情感鸿沟是MER的主要挑战之一,它衡量的是提取的特征和感知到的高级情绪之间的不一致性。在客观多媒体分析中,情感鸿沟比语义鸿沟更具挑战性。即使语义上的鸿沟被弥合了,情感上的鸿沟仍然可能存在。例如,一朵盛开的玫瑰和一朵凋谢的玫瑰都含有玫瑰,但却能唤起不同的情感。对于同一个句子,不同的语调可能对应着完全不同的情绪。提取具有区别性的高级特征,特别是与情绪相关的特征,有助于弥合情感鸿沟。主要难点在于如何评价所提取的特征是否与情绪相关。

2、Perception Subjectivity(情感主观性)

有的人可能会因为巨大的雷声而感到恐惧,有的人可能会因为捕捉到这样罕见的场景而感到兴奋;即使相同的情绪(如兴奋),也会有不同的反应,如面部表情、步态、动作和语言。对于主观性的挑战,一个直接的解决方案是学习每个受试者的个性化的MER模型。从刺激的角度,我们也可以预测一定数量被试参与时的情绪分布。除了刺激内容和直接的生理和心理变化外,上述个人因素、情境因素和心理因素的联合建模也有助于MER任务的完成。

3、Data Incompleteness(数据缺失)

由于在数据采集中存在许多不可避免的因素,如传感器设备故障,特定形式的信息可能会被破坏,从而导致数据丢失或不完整。数据不完整是现实世界MER任务中常见的现象。例如,对于明确的情感线索,脑电图耳机可能会记录受污染的信号,甚至无法记录任何信号;在晚上,摄像机无法捕捉到清晰的面部表情。对于内隐情感刺激,一个用户可能只发布包含图像(没有文本)的tweet;对于一些视频,音频通道变化不大。在这种情况下,最简单的特征融合方法,即早期融合,是行不通的,因为在没有捕获信号的情况下,我们无法提取任何特征。设计能够处理数据不完整性的有效融合方法是一种广泛采用的策略。

4、Cross-modality Inconsistency(模态间不一致性)

同一样本的不同模态可能会相互冲突,从而表达不同的情绪。例如,面部表情和言语可以很容易地被抑制或掩盖,以避免被发现,但脑电图信号是由中枢神经系统控制的,可以反映人类无意识的身体变化。当人们在社交媒体上发布推文时,图像与文本在语义上不相关的现象非常普遍。在这种情况下,一种有效的MER方法有望自动评估哪些模式更可靠,例如通过为每个模式分配权重。

5、Cross-modality Imbalance(模态间不平衡性)

在一些MER应用中,不同的模式对唤起的情绪的贡献可能是不平等的。例如,网络新闻在我们的日常生活中扮演着重要的角色,除了了解读者的偏好,预测他们的情绪反应在各种应用中都有很大的价值,比如个性化广告。然而,一篇网络新闻通常包含不平衡的文字和图片,即文章可能很长,有很多详细的信息,而新闻中只有一两个插图。可能更有问题的是,新闻编辑可能会为一篇带有明显情绪的文章选择一幅中性的图像。

6、Label Noise And Absence(标签问题)

现有的MER方法,特别是基于深度学习的MER方法需要大量的标记数据进行训练。然而,在实际应用中,在生成ground-truth给情绪贴标签不仅花费昂贵和时间,而且高度不一致,这导致数据量大,但很少或甚至没有情绪标签。随着情感需求的日益多样化和细粒度化,我们可能有足够的训练数据来处理某些情感类别,而不是其他类别。手动注释的另一种解决方案是利用社交推文的标签或关键字作为情感标签,但这样的标签是不完整的和嘈杂的。因此,为无监督/弱监督学习和少/零次学习设计有效的算法可以提供潜在的解决方案。

同时,我们可能在一个领域有足够的标记情感数据,如合成面部表情和语音。问题是如何有效地将经过训练的MER模型在有标记的源域转移到另一个未标记的目标域。当使用直接传输[23]时,畴移的存在导致显著的性能下降。多模态域自适应和域泛化有助于缓解这种域间隙。还应该考虑实际的设置,例如多源域。

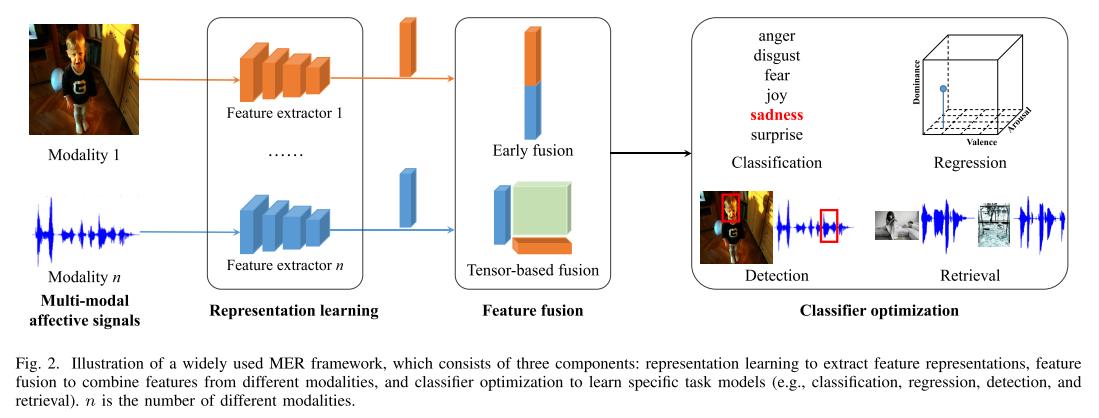

六、该领域的方法论

一般而言,在目标域具有足够标记训练数据的MER框架中,有三个组成部分:表示学习、特征融合和分类器优化,如上图2所示。在本节中,我们将介绍这些部分。进一步,我们将描述在目标域没有标记训练数据和在另一个相关源域有足够标记数据时的域自适应。

1、Representation Learning of Each Affective Modality (表征学习)

- 为了将文本表示为计算机能够理解的形式:文本特征可以通过简单的平均词向量得到。采用**循环神经网络(RNN)**对文本中单词的顺序关系进行建模。**卷积神经网络(CNN)**在计算机视觉界得到了广泛的应用,它也被用来提取单词之间的上下文关系。

- 为了提取音频中情感刺激的代表性特征[13,14]:研究发现,音调、对数能量、过零率、频谱特征、语音质量和抖动等音频特征在情感识别中很有用。随着深度学习的发展,CNN在处理自然数据的许多领域中实现了最先进的大规模任务性能,当然也包括音频情感识别。音频通常被转换成图形表示,如声谱图,然后输入CNN。由于CNN使用共享权重过滤器和池给模型更好的频谱和时间不变属性,它通常产生更好的泛化和更健壮的情感识别模型。

- 为了图像中情感刺激的信息性表征:一般来说,图像可以分为两种类型,非限制性图像和面部表情图像。对于前者,例如自然图像,早期开发了各种手工特征,包括颜色、纹理、形状、构图等,来代表图像情感[10]。这些低级特征是在心理学和艺术理论的启发下发展起来的。在此基础上,提出了基于视觉概念的中级特征,以弥补图像像素与情感标签之间的差距。最具代表性的引擎是SentiBank,它由1200对形容词-名词组合而成,在所有的手工工程特征中,它的识别性能非常出色。在深度学习时代,CNN被认为是端到端的强特征提取器。具体来说,为了整合不同层次的各种表示,从CNN的多层提取特征。同时,采用注意机制更好地学习特定局部情绪区域[22]的情绪表征。

- 为了人脸识别图像:首先检测人脸并对其进行对齐,然后对人脸地标进行编码进行识别。注意,对于那些偶然包含人脸的非限制性图像,面部表情可以作为一个重要的中间线索。

- 为了构建视频的表示,人们提出了各种各样的方法。早期的方法主要利用手工制作的局部表示,包括颜色、运动和镜头切割率。随着深度学习的出现,最近的方法提取有区别的表示,采用3D CNN捕捉多个相邻帧编码的时间信息。在提取视频中特定模态特征后,对不同类型的特征进行整合,可以获得更有效的结果,提高性能。

- 对步态[24]表征的学习主要有两方面的方法来感知情绪:一方面,我们可以明确地建立与情绪相关的姿势和动作信息的模型。为了对这些信息进行建模,我们首先提取一个人的骨骼结构,然后用三维坐标系表示人体的每个关节。在得到这些坐标后,可以很容易地提取不同关节之间的角度、距离或面积(姿态信息)、速度/加速度(运动信息)和它们的协方差描述符等。另一方面,高水平的情绪表征可以通过长短期记忆(LSTM)、深度卷积神经网络或图卷积网络来模拟步态。一些方法从步态视频中提取光流,然后利用这些网络提取序列表示。其他方法学习步态的骨骼结构,然后将它们输入多个网络,以提取不同表示。

- 脑电信号可以从大脑对情绪刺激的反应中获取情绪的频带、电沉积、时间等信息,因此脑电信号在情绪分析中得到了广泛的应用。 为了提取EEG情绪识别的鉴别特征,从频带或电沉积关系中提取微分熵特征是目前常用的方法。 除了手工制作特征外,我们还可以直接将CNN、RNN等端到端深度学习神经网络应用于原始脑电图信号,获得强大的深度特征[25]。 受人类学习模式的启发,我们成功地应用了面向空间的注意机制来提取更有分辨力的空间信息。 此外,考虑到脑电图信号包含多个通道,还可以在CNN中集成通道注意机制,利用特征图之间的通道间关系。

2、 Feature Fusion of Different Affective Modalities(特征融合)

Model-free fusion(不直接依赖于特定的无模型融合)

- 早期融合,也称为特征级融合,直接连接不同形式的特征表示作为一个单一的表示。 它是在早期利用不同模式之间的相互作用来融合不同表征的最直观的方法,只需要训练一个单一的模型。 但由于不同形式的表示形式可能存在显著差异,我们必须考虑时间同步问题,以便在融合之前将这些表示转换为相同的格式。 当一个或多个模式缺失时,这种早期融合就会失败。

- 后期融合,又称决策级融合,是对每个模态的预测结果进行集成。 一些流行的机制包括平均、投票和信号方差。 后期融合的优点包括:(1)灵活性和优越性——可以针对不同的模式选择最优分类器; (2)稳健性——当某些模式缺失时,晚期融合仍然可以工作。 然而,在做决定之前,不同模式之间的相关性被忽略了。

- 混合融合将早期融合和晚期融合结合在一个统一的框架内发挥各自的优势,但计算成本较高。

Model-based fusion(基于模型的融合)

基于模型的融合在构建学习模型的过程中进行了明确的融合,因此受到了更多的关注[7,9]。近年来,基于神经网络的深度模型、基于注意力的深度模型和基于张量的深度模型被广泛应用。

- Kernel-based fusion:基于核的融合是基于包含核的分类器的扩展,如支持向量机。对于不同的模式,使用不同的核。核选择的灵活性和损失函数的凸性使得多核学习融合在包括MER在内的许多应用中很受欢迎。然而,在测试过程中,这些融合方法依赖于训练数据中的支持向量,导致存储成本大,参考效率低。基于图的融合为每个模态构造单独的图或超图,将这些图合并成一个融合图,并通过基于图的学习来学习不同边和模态的权值。它可以很好地处理数据不完全性问题,简单地根据可用数据构造图。除了提取特征表示外,我们还可以通过相应的边缘将人类先验知识融合到模型中。然而,当有更多的训练样本时,计算成本将呈指数增长。

- Neural network-based fusion:基于神经网络的融合采用一种直接、直观的策略,通过神经网络融合不同模式的特征表征或预测结果。基于注意的融合利用一些注意机制来获得一组具有标量权的特征表示的加权和,这些特征表示由注意模块动态学习。不同的注意机制对应于融合不同的组件。例如,空间图像注意力衡量的是不同图像区域的重要性。图像和文本共同注意采用对称注意机制生成视觉和文本表征。平行共注意法和交替共注意法可分别对不同模态同时逐个产生注意。最近,多模态自适应门(Multimodal Adaptation Gate, MAG)被设计用于使基于Transformer的上下文词表示,如BERT和XLNet,接受多模态非语言数据[17]。基于基于非语言行为的注意,MAG本质上可以将信息的多种形式映射到一个具有轨迹和大小的向量上。基于张量的融合试图通过一些特定的张量运算,如外积和多项式张量池,来挖掘不同表示的相关性。这些深度模型融合方法能够从大量数据中以端到端方式学习,性能较好,但可解释性较差。

- 上述特征融合方法的一个重要特性是是否支持视频中MER的时间建模。很明显,早期融合可以,而晚期融合和混合融合不能,因为在晚期融合之前,基于各模态的预测结果已经已知。对于基于模型的融合,除了基于核的融合,其他的都可以用于时间建模,如基于图的融合方法可以使用隐马尔可夫模型(HMM)和条件随机场(CRF),基于神经网络的融合方法可以使用RNN和LSTM网络。

3、 Classifier Optimization for Multi-modal Emotion Recognition(分类器优化)

- 文本情感:对于以单词嵌入序列表示的文本,最流行的利用单词之间语义的方法是RNN和CNN。LSTM是一种典型的RNN,它包含一系列具有相同结构的单元。每个单元格以一个单词嵌入和上一个单元格的隐藏状态作为输入,计算输出,并更新下一个单元格的隐藏状态。隐藏的状态记录了之前单词的语义。CNN通过卷积运算计算连续单词之间的局部上下文特征。利用平均池层或最大池层进一步整合得到的特征,进行后续的情感分类。最近,研究人员开始使用基于Transformer的方法,如BERT和GPT-3。transformer是由一系列模块组成的,其中包括一个多头自注意层,然后是标准化层、前馈网络和另一个标准化层。文本中单词的顺序也由另一个位置嵌入层表示。与RNN相比,Transformer不需要对单词进行顺序处理,提高了并行性。与CNN相比,transformer可以模拟更长距离的单词之间的关系。

- 音频情感: 目前用于音频情感识别的分类方法一般有传统方法和基于深度学习的方法两种。在传统方法中,HMM具有捕获序列数据动态特征的能力,是一种具有代表性的方法。支持向量机在音频情感识别中也得到了广泛的应用。基于深度学习的方法由于不受HMM模型经典独立性假设的限制而越来越受欢迎。在这些方法中,有关注的序列到序列模型以端到端方式显示了成功。最近,一些方法通过开发深度混合卷积和循环模型[14]显著地扩展了该领域的技术水平。

- 图像情感:早期将多个手工提取的图像特征集成并输入到支持向量机中来训练分类器。然后,基于深度学习,通过交叉熵损失[26]等相应的损失函数,对分类器和特征提取器进行端到端连接优化。此外,常用的度量损耗如三重损耗和n对损耗也参与到网络优化中,以获得更多的鉴别特征。在上述学习范式下,每一幅图像都被预测为一个单一的主导情绪类别。然而,根据心理学的理论,一个图像可能会引起观众的多种情绪,从而导致一个模棱两可的问题。为了解决这个问题,使用标签分布学习来预测每个情绪类别的具体相对程度,其中Kullback-Leibler分歧是最流行的损失函数。图像中某些信息丰富、吸引人的区域总是决定着图像的情感。因此,构建了一系列具有额外关注或检测分支的体系结构。通过对包括注意和原始任务在内的多个任务进行优化,得到了一个更健壮、更具辨识性的模型。

- 视频情感:现有的方法大多采用两阶段pipeline来识别视频情感,即提取视觉/音频特征并训练分类器。对于分类器的训练,研究了许多机器学习方法来建模视频特征和离散情感类别之间的映射,包括SVM、GMM、HMM、动态贝叶斯网络(DBM)和条件随机时(CRF)。尽管上述方法对视频情感识别的发展做出了贡献,但基于深度神经网络的情感识别方法由于其卓越的能力[27]而被提出以端到端方式进行视频情感识别。基于CNN的方法首先利用三维卷积神经网络提取包含情感信息的高级时空特征,然后利用完全连接层对情感进行分类。最后,用损失函数对模型进行跟踪,对整个网络进行优化。受人类感知情绪过程的启发,cnn使用注意机制来强调每个视频帧或片段中的情绪相关区域。此外,考虑到极性-情绪层次的约束,最近的方法提出极性一致交叉熵损失来指导注意力的生成。

- 步态情感:人的步态可以表示为步行视频中每一帧的2D或3D关节坐标序列。为了利用关节坐标中固有的情感线索,许多分类器或结构被用来提取步态中的情感特征。LSTM网络包含许多特殊的单元,即记忆单元,可以存储长时间数据序列中特定时间步长的联合坐标信息。因此,它被用于步态情绪识别的早期工作中。LSTM的隐藏特征可以进一步与手工制作的情感特征连接,然后送入分类器(如SVM或随机森林(RF))来预测情感。近年来,另一种流行的用于步态情绪预测的网络是时空图卷积网络(ST-GCN)。ST-GCN最初被提出用于人体骨骼图的动作识别。“空间”代表骨骼结构的空间边缘,即连接身体关节的四肢。“颞边”指的是颞边,它们连接着不同框架中每个关节的位置。ST-GCN可以很容易地实现为空间卷积,然后是节奏卷积,类似于深度卷积网络。

- 脑电情感:基于EEG的情感识别在早期阶段通常使用支持向量机、决策树、k-最近邻等多种分类器对手工特征进行分类。其次,由于CNN和RNN分别擅长提取脑电图信号的空间信息和时间信息,因此采用级联卷积递归网络(将CNN和RNN结合起来)、LSTM-RNN、并成功地设计了并行卷积递归神经网络,并将其应用于情绪识别任务。

4、Domain Adaptation for Multi-modal Emotion Recognition(自适应域)

域自适应的目的是从标记的源域学习一个可迁移的MER模型,该模型可以很好地应用于未标记的目标域[23]。最近致力于深度无监督域自适应[23],它采用了两流架构。一个流用于在标记的源域上训练MER模型,而另一个流用于对齐源域和目标域。基于对齐策略,现有的单模态域自适应方法可分为基于差异、对抗判别、对抗生成和基于自我监督的方法[23]。(更多请阅读原文,没翻译完)

七、相关应用

从多种外显线索和内隐刺激中识别情绪具有广泛的现实应用意义。一般来说,情感是我们存在的质量和意义的最重要的方面,它使生活有价值。数字数据的情感影响在于它可以改善现有技术的用户体验,进而加强人与计算机之间的知识转移[18]。

1、情感挖掘

许多人倾向于在社交网络上发布文字、图片和视频来表达他们的日常生活感受。受此启发,我们可以挖掘人们对现实世界中发生的话题和事件的看法和情感。例如,Facebook或Instagram上的用户生成内容可以用来获取来自不同国家和地区的人们在面对COVID-19[29]等流行病时的态度。研究人员还试图检测社交网络中的情绪,并将结果应用于预测政治选举。注意,当个体的个性化情绪被发现时,我们可以进一步将这些情绪分组,这可能有助于预测社会趋势。

2、消费者分析

多模态情感识别的另一个重要应用是商业智能,特别是营销和消费者行为分析[30]。如今,大多数服装电子零售商都使用人体模型来展示产品。模型的面部呈现对消费者接近行为有显著影响。具体来说,对于情绪接受度高的参与者,微笑的面部表情更容易导致最高接近行为。此外,研究人员在刺激-机体-反应框架的基础上,考察了网上商店专业化如何影响消费者的愉悦和唤起。情绪识别也可以应用于呼叫中心,其目的是检测呼叫者和接线员的情绪状态。该系统通过语调和节奏识别相关的情绪,以及从相应的讲话中翻译出来的文本。在此基础上,我们可以收到关于服务质量的反馈。

3、医疗/心理健康

同时,情感识别在医疗和心理健康领域具有重要作用。随着社交媒体的普及,一些人更喜欢在互联网上分享他们的情绪而不是与他人。如果用户被观察到频繁且持续地分享负面信息(如悲伤),就有必要跟踪其心理状态,防止心理疾病甚至自杀的发生。情绪状态还可以用来监测和预测各种人的疲劳状态,如司机、飞行员、装配线上的工人和教室里的学生。这种方法既能防止危险情况的发生,又有利于工作/学习效率的评估。此外,情绪状态可以被整合到各种安全应用中,例如监控公共空间(如公交/火车/地铁站,足球场)的系统,以防范潜在的攻击行为。最近,在儿童自闭症谱系障碍(ASD)的诊断和治疗过程中引入了一种有效的辅助系统,以辅助收集患儿的病理信息。为了帮助专业临床医生更好、更快地对ASD患者进行诊断和治疗,该系统将面部表情和眼睛注视注意力作为自闭症早期筛查的显著指标。

4、沉浸式体验

采用多模态情感识别提高个人娱乐体验。例如,最近的一项脑电波-音乐界面的研究将脑电图特征映射到音乐结构(音符、强度和音高)。同样,人们也在努力理解不同模式之间以情感为中心的相关性,这对各种应用至关重要。情感图像-音乐匹配提供了一个很好的机会,将音乐序列附加到给定的图像,在那里它们可能唤起相同的情感。这有助于从移动设备上的个人相册照片中生成能感知情感的音乐播放列表。

八、未来趋势预测

现有的方法在视觉-音频、面部-文本-语音和文本-视觉任务等各种MER设置上取得了很好的性能。然而,所有概括的挑战都没有得到充分处理。例如,如何提取与情绪关系更密切的鉴别特征,如何平衡普通情绪反应和个性化情绪反应,以及如何强调更重要的表现形式等,仍是开放的。为提高MER方法的性能,使其适应现实世界的特殊要求,本文提出了一些潜在的发展方向。

1、New Methodologies for MER

- 上下文和先验知识建模。用户的体验情绪会受到语境信息(如会话环境和社会环境)的显著影响。用户的性格、年龄等先验知识也有助于情感感知。例如,乐观的用户和悲观的观众可能看到相同刺激的不同方面。综合考虑这些重要的背景知识和先验知识,有望提高MER绩效。图相关方法,如图卷积网络,是建模因素和情绪之间关系的可能解决方案。

- 从未标记、不可靠和不匹配的情感信号中学习。在大数据时代,情感数据可能被稀疏标注甚至未标注,原始数据或标签可能是可靠的,测试和训练数据可能是不匹配的。探索先进的机器学习技术,如无监督表示学习、动态数据选择和平衡、领域适应,以及嵌入情感的特殊属性,可以帮助解决这些挑战。

- 可解释、健壮和安全的MER深度学习。由于黑盒子的特性,很难理解为什么现有的深度神经网络在MER中表现良好,而经过训练的深度网络容易受到对抗性攻击和不可避免的噪声的影响,这些噪声可能会导致不稳定。从本质上解释深度学习的决策过程可以帮助设计健壮和安全的MER系统。

- 显性和隐性信号的结合。显性和隐性信号都被证明对MER是有用的,但它们也有一些局限性。例如,明确的信号很容易被抑制或难以捕捉,而隐含的信号可能不会实时反映情绪。将它们联合起来,在观众-多媒体交互过程中探索互补的信息,可以提高MER的性能。

- 将情绪理论融入MER。心理学、生理学、神经学和认知科学都提出了不同的理论。这些理论可以帮助我们理解人类是如何产生情感的,但还没有被应用于计算机的MER任务中。我们相信这样的结合对识别情绪更有意义。

2、More Practical MER Settings

- MER in wild。目前的MER方法主要侧重于整洁的实验室设置。然而,现实世界中的MER问题要复杂得多。例如,收集的数据可能包含许多与情绪无关的噪音;测试集中的用户与训练集中的用户来自不同的文化和语言,导致了不同的情感表达方式;在不同的设置中使用不同的情感标签空间;培训数据逐渐可用。设计一个有效的可推广到这些实际环境的MER模型是值得研究的。

- MER on the edge。在移动电话和安全摄像头等边缘设备上部署MER模型时,必须考虑计算限制和数据隐私问题。自动剪枝、神经结构搜索、可逆神经网络和软硬件协同设计等技术被认为有助于设备上的有效训练。

- Personalized and group MER。由于情感的主观性,单纯地认识不同个体的主导情感是不够的。为每个人收集足够的数据来训练个性化的MER模型是理想的,但不切实际。一个可能的替代方案是,用少量标记数据将训练有素的主要情绪的MER模型调整到每个个体。另一方面,如果一群人有着相似的品味、兴趣和背景,那么预测他们的情绪就更有意义了。群体情感识别在推荐系统等许多应用中都是非常重要的,但如何将用户划分到不同的群体仍然是一个挑战。

3、Real Applications Based on MER

- Implementation of MER in real-world applications:尽管几十年来人们一直强调情绪识别的重要性,但由于其相对较低的表现,很少将其应用到真实场景中。随着最近MER的快速发展,我们可以开始将情感融入到营销、教育、医疗和服务领域的不同应用中。来自应用程序的反馈可以反过来促进MER的开发。伴随着情感的产生,我们相信人工情感智能的时代正在到来。

- Wearable, simple, and accurate affective data collection:可穿戴、简单、准确的情感数据采集。进行MER任务的第一步是收集准确的情感数据。开发可穿戴、简单甚至非接触式的传感器来捕捉这些数据,将会让用户更容易接受。

- Security, privacy, ethics, and fairness of MER. During:MER的安全性、隐私性、伦理性和公平性。在数据收集过程中,可以提取用户的机密信息,如身份、年龄等。必须考虑到保护用户的安全和隐私,避免任何滥用的机会。在实际应用中,情绪识别可能会对一个人产生负面甚至危险的影响,比如情绪压力。消除这种影响的方法也应该从伦理和公平的角度考虑。

以上是关于多模态情感识别数据集和模型(下载地址+最新综述2021.8)的主要内容,如果未能解决你的问题,请参考以下文章