从0教你用Python写网络爬虫,内容详细代码清晰,适合入门学习

Posted 编程界的小胖子

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了从0教你用Python写网络爬虫,内容详细代码清晰,适合入门学习相关的知识,希望对你有一定的参考价值。

爬虫是入门Python最好的方式之一,掌握Python爬虫之后再去学习Python其他知识点,会更加地得心应手。当然,用Python爬虫对于零基础的朋友来说还是有一定难度的,那么朋友,你真的会Python爬虫吗?

下面就给大家简单阐述一下Python爬虫那些事儿,对于想提升实战的朋友,也准备了《用Python写网络爬虫》教程,共212页,内容详细代码清晰,很适合入门学习。

【文末有资料领取方式!!】

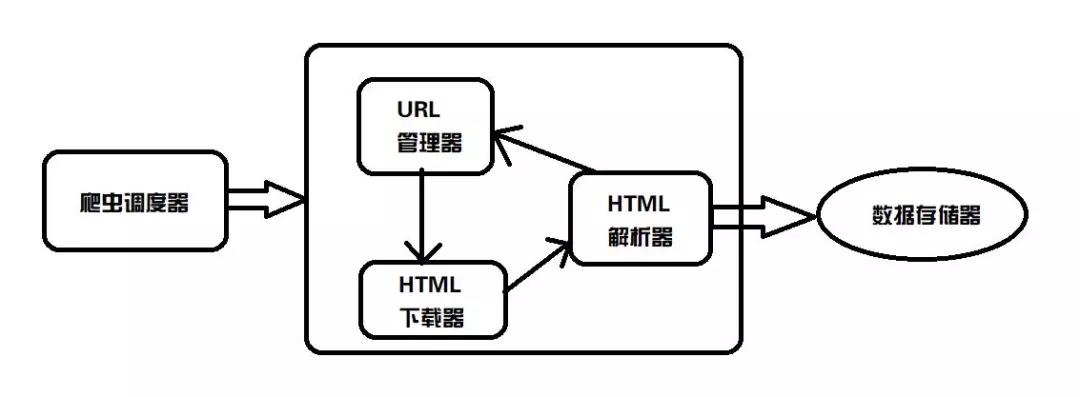

基础爬虫架构

从上图可以看出,基础的爬虫架构大致分为5类:爬虫调度器、URL管理器、html下载器、HTML解析器、数据存储器。

对于这5类的功能,给大家简单解释一下:

- 爬虫调度器,主要是配合调用其他四个模块,所谓调度就是取调用其他的模板

- URL管理器,就是负责管理URL链接的,URL链接分为已经爬取的和未爬取的,这就需要URL管理器来管理它们,同时它也为获取新URL链接提供接口。

- HTML下载器,就是将要爬取的页面的HTML下载下来

- HTML解析器,就是将要爬取的数据从HTML源码中获取出来,同时也将新的URL链接发送给URL管理器以及将处理后的数据发送给数据存储器。

- 数据存储器,就是将HTML下载器发送过来的数据存储到本地

Python爬虫是否违法?

对于Python是否违法的说法是众说纷纭,不过至今,Python网络爬虫还在法律允许范围内,当然,如果被抓取的数据被用于个人或商业用途,并造成一定的负面影响,那么是会被谴责的。所以还请大家合理使用Python爬虫。

为何选择Python来进行爬虫?

1、抓取网页本身的接口

相比与其他静态编程语言,python抓取网页文档的接口更简洁;此外,抓取网页有时候需要模拟浏览器的行为,很多网站对于生硬的爬虫抓取都是封杀的。这是我们需要模拟user agent的行为构造合适的请求,在python里都有非常优秀的第三方包帮你搞定。

2、网页抓取后的处理

抓取的网页通常需要处理,比如过滤html标签,提取文本等。python的beautifulsoap提供了简洁的文档处理功能,能用极短的代码完成大部分文档的处理。

其实以上功能很多语言和工具都能做,但是用python能够干得最快,最干净。Life is short, u need python.

NO.1 快速开发,语言简洁,没那么多技巧,所以读起来很清楚容易。

NO.2 跨平台(由于python的开源,它比java更能体现"一次编写到处运行"

NO.3 解释性( 无需编译,直接运行/调试代码)

NO.4 构架选择太多(GUI构架方面 主要的就有 wxPython, tkInter, PyGtk, PyQt 。

如何用Python进行网络爬虫?

《用Python写网络爬虫》共有212页全9章,从基础到实践应用全部涵盖,内容详细又简洁,代码清晰可复制,十分适合有意一定Python编程经验和对爬虫有兴趣的朋友学习。

9大章分别从以下内容阐述:

第 1 章:网络爬虫简介,介绍了什么是网络爬虫,以及如何爬取网站。

第 2 章:数据抓取,展示了如何使用几种库从网页中抽取数据。

第 3 章:下载缓存,介绍了如何通过缓存结果避免重复下载的问题。

第 4 章:并发下载,教你如何通过并行下载网站加速数据抓取。

第 5 章:动态内容,介绍了如何通过几种方式从动态网站中抽取数据。

第 6 章:表单交互,展示了如何使用输入及导航等表单进行搜索和登录。

第 7 章:验证码处理,阐述了如何访问被验证码图像保护的数据。

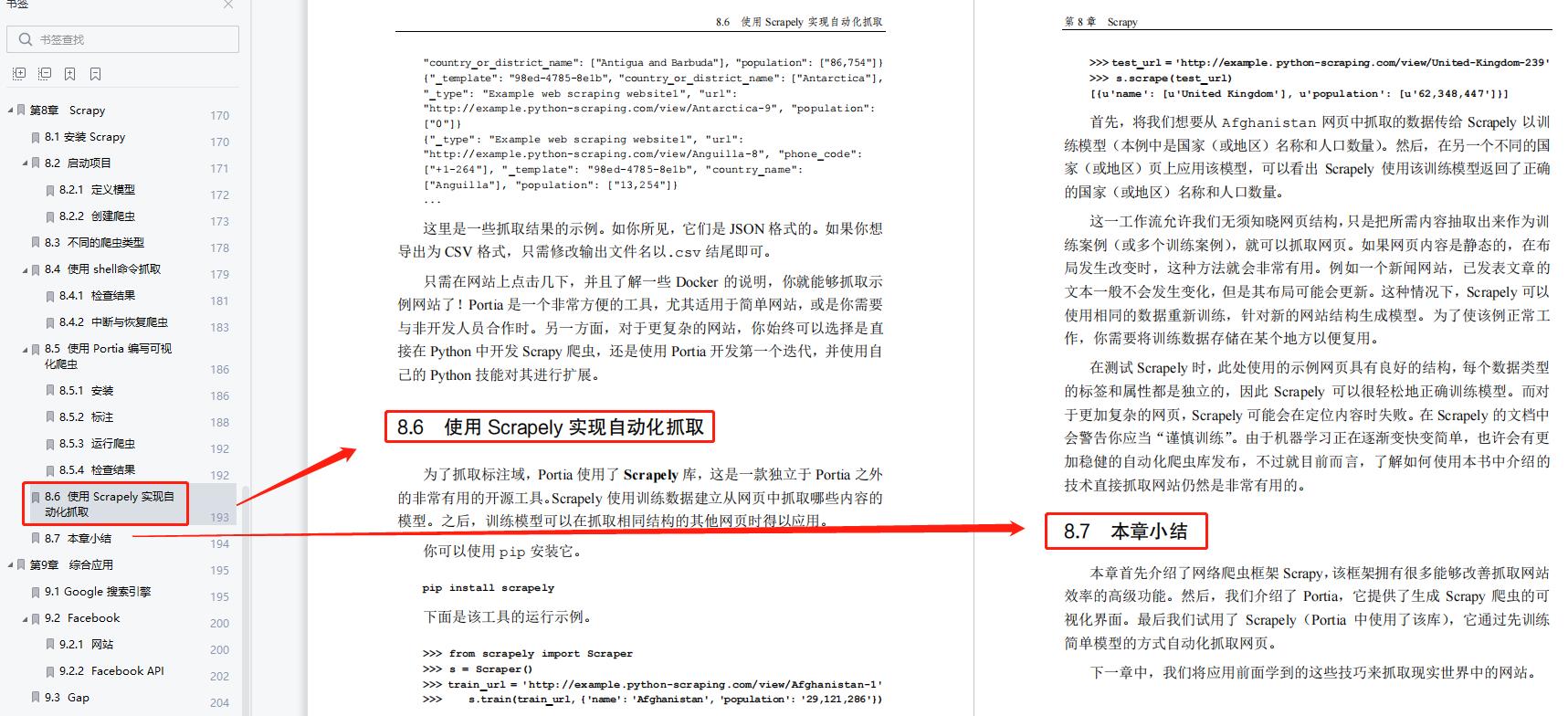

第 8 章:Scrapy,介绍了如何使用 Scrapy 进行快速并行的抓取,以及使用 Portia 的 Web 界面构建网络爬虫。

第 9 章:综合应用,对你在本书中学到的网络爬虫技术进行总结。

部分内容展示:

【领取方式见下图!!】

以上是关于从0教你用Python写网络爬虫,内容详细代码清晰,适合入门学习的主要内容,如果未能解决你的问题,请参考以下文章