机器学习笔记:梯度下降

Posted UQI-LIUWJ

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了机器学习笔记:梯度下降相关的知识,希望对你有一定的参考价值。

1 梯度下降介绍

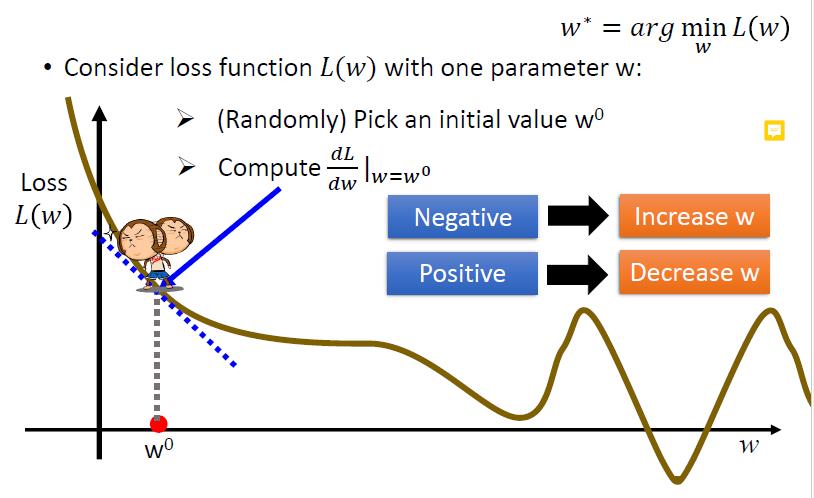

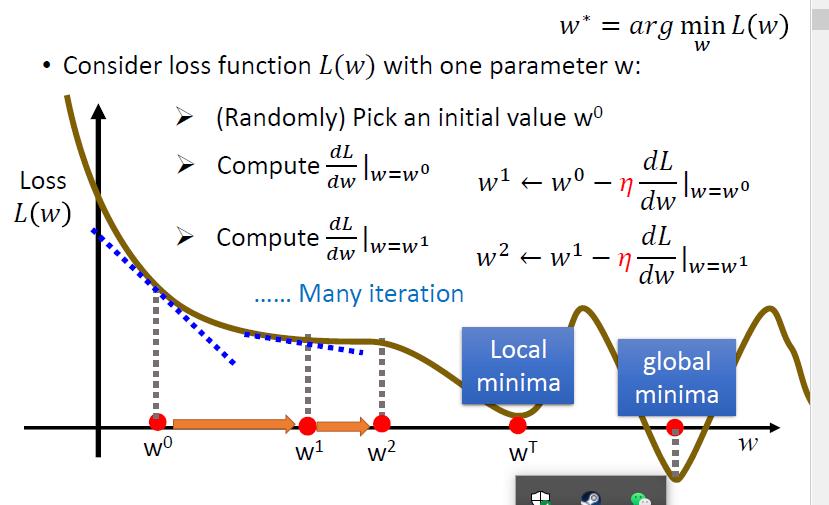

我们首先随机一个点,然后沿着梯度方向的反方向寻找最低点

迭代多次,直到找到局部最优(也有可能是全局最优)【线性回归问题里面,局部最优就是全局最优了】

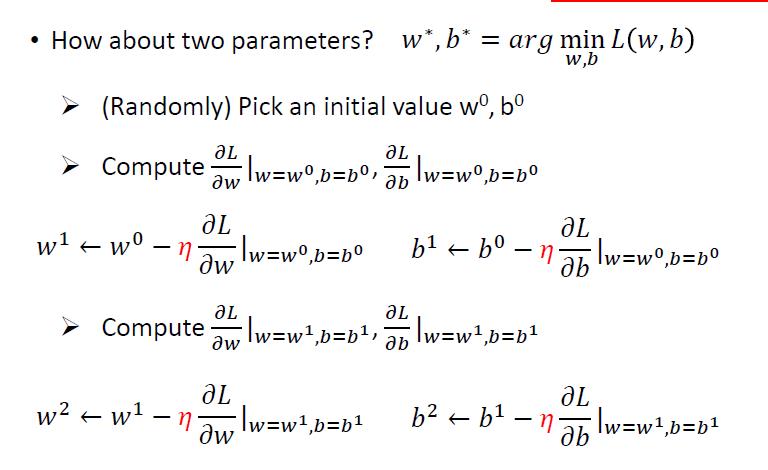

多个参数同理,分别进行梯度下降

2 梯度下降可能存在的问题

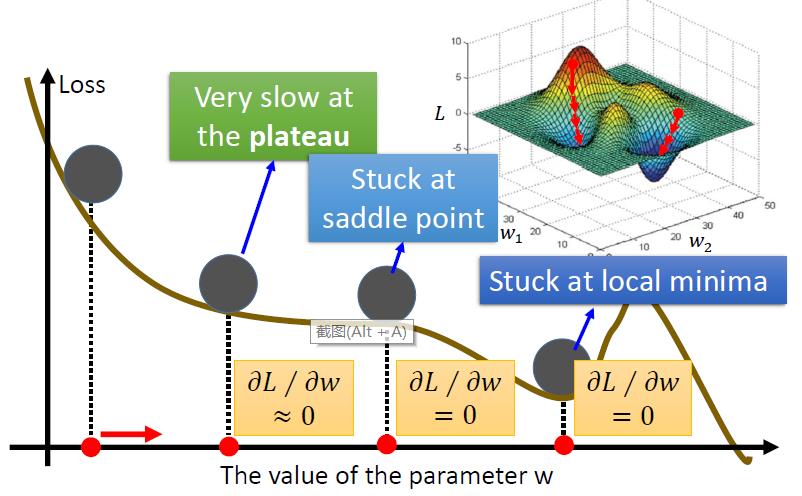

我们可能会找到鞍点,可能会找到局部最优,而且从不同位置出发,可能最终梯度下降的结果会有很大的区别

3 梯度下降小tips

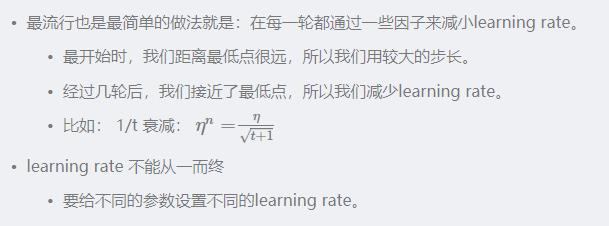

3.1 合理调整学习率

pytorch笔记:调整学习率(torch.optim.lr_scheduler)_UQI-LIUWJ的博客-CSDN博客

3.2 特征缩放

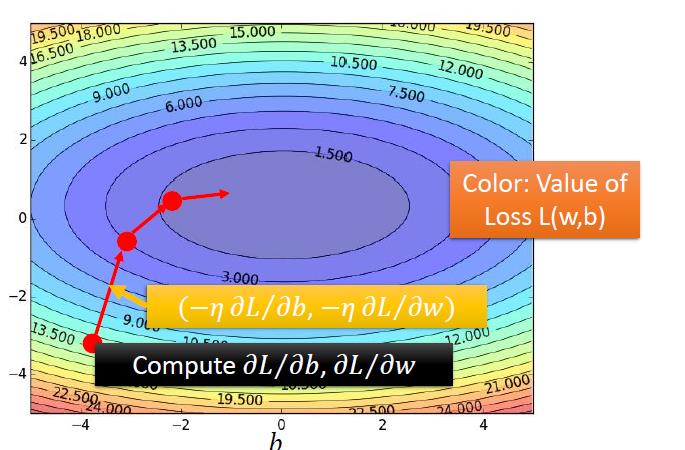

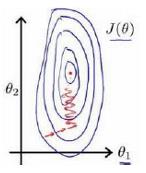

当我们面对多维度特征问题的时候,我们需要保证这些特征都有相近的尺度,这样会帮助梯度下降更快地收敛。

以上图为例,图像非常扁平,梯度下降算法需要非常多次的迭代才能够收敛

为了更快地收敛,我们将所有特征的尺度放缩到-1~1之间:

以上是关于机器学习笔记:梯度下降的主要内容,如果未能解决你的问题,请参考以下文章