HDFS解决小文件

Posted 神龙龙

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了HDFS解决小文件相关的知识,希望对你有一定的参考价值。

一、har回档(存储方向)

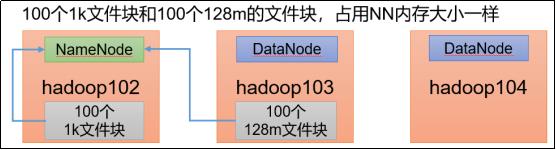

每个文件均按块存储,每个块的元数据存储在NameNode的内存中,因此HDFS存储小文件会非常低效。因为大量的小文件会耗尽NameNode中的大部分内存。但注意,存储小文件所需要的磁盘容量和数据块的大小无关。例如,一个1MB的文件设置为128MB的块存储,实际使用的是1MB的磁盘空间,而不是128MB。

HDFS存档文件或HAR文件,是一个更高效的文件存档工具,它将文件存入HDFS块,在减少NameNode内存使用的同时,允许对文件进行透明的访问。具体说来,HDFS存档文件对内还是一个一个独立文件,对NameNode而言却是一个整体,减少了NameNode的内存。

归档过程:

1)启动yarn进程

start-yarn.sh2)归档文件

把/input目录下里面的所有文件归档成一个叫input.har的归档文件,并把归档后文件存储到/output路径下

hadoop archive -archiveName input.har -p /input /output3)查看归档文件:

hadoop fs -ls /output/input.har

hadoop fs -ls har://output/input.har4)解归档文件

hadoop fs -cp

har://output/input.har/* /二、CombineTextInputFormat(计算方向)

CombineTextInputFormat用于将多个小文件在切片过程中生成的一个单独切片或者少量的切片

三、开启uber模式,实现JVM重用(计算方向)

默认情况下,每个Task任务都需要启动一个JVM来运行,如果Task任务计算的数据量很小,可以让同一个JOB的多个Task运行在一个JVM中,不必为每个Task都开启一个JVM

以上是关于HDFS解决小文件的主要内容,如果未能解决你的问题,请参考以下文章