阿里安全新研究:给图片打“马赛克”就能骗过 AI 视觉系统

Posted AI科技大本营

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了阿里安全新研究:给图片打“马赛克”就能骗过 AI 视觉系统相关的知识,希望对你有一定的参考价值。

阿里安全人工智能 AAIG 实验室等机构的研究者提出了一个新的机制来生成对抗样本,即与增加对抗扰动相反,他们通过扔掉一些不可察觉的图像细节来生成对抗样本。这项研究成果已被 AI 顶会 ICCV 2021 收录。

不久前,某知名品牌汽车被曝其自动驾驶系统无法识别白色货车箱体这样类似于“一堵墙”的障碍物。在自动驾驶中,行人、车辆被漏检或者未能及时被检测到,都可能导致交通事故的产生。此外,安防漏检危险人物与物品也可能导致安全隐患。这些风险都提示,AI视觉的安全性值得重视。

在研究AI视觉稳定性的过程中,阿里安全图灵实验室的研究人员札奇发现,AI视觉还有一个盲区:利用算法自动鉴别图片关键信息,并巧妙删除,就像给图片“打码”一样,AI视觉系统就会无法识别该图片。

札奇的研究源于逛商场看到乐高玩具迸发的灵感,当时,她有一个疑问:“人眼如何识别‘马赛克’式样的玩具?还有早期的超级马里奥,虽然只是由几个简单像素组成,人却可以正确识别这种抽象的表达。但相反的,如果从对抗样本的角度来考虑:去掉图片中一些对模型来说关键而微小的特征,模型有没有可能就无法再正确识别这些图片?

图1:乐高与像素马里奥

什么是对抗样本?

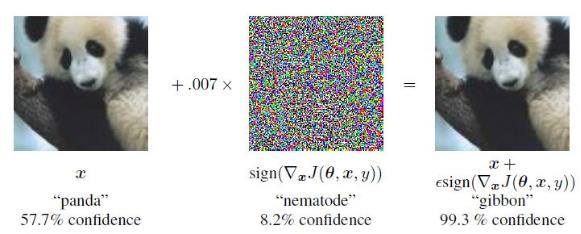

对抗样本一开始由 Szegedy 等人在 2013 年定义:给定一张原始图片x及其标签y,以及模型

。对抗样本是指在原图x上加一些刻意制造的微小的扰动,从而让结果图像无法被正确识别(如下图所示)。通常来说,对抗扰动被限制在一定阈值内, 定义为

,从而保证结果图对人来说与原图几乎不可区分。后续有很多相关工作在当前设定下进一步探索了更多 生成对抗样本的攻击方式,以及其他性质,例如迁移性等。

生成对抗样本的攻击方式,以及其他性质,例如迁移性等。

图2:对抗攻击

对抗样本可能是特征

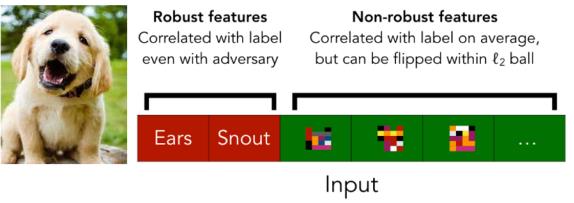

在对抗样本提出后,有各种各样的防御工作提出,其中尤其是对抗训练最为有效的防御方式之一,但是对抗训练有非常明显的问题是:在稳健性(robustness)和准确率(accuracy)之间始终有一个平衡,即对抗训练提升模型稳健型的同时也导致的模型的准确率下降。为了解释这一现象,Ilyas等人给对抗样本的存在提出了一个假设:对抗样本不是 bug ,而是一组对人来说不可感知的特征。以人类感知为中心,人类所能察觉的特征就是 robust feature ,其他的特征则是 non-robust 。例如图3的狗狗,人类只会注意到其中的耳朵鼻子等显著特征(robust feature)。

图3:鲁棒特征与非鲁棒特征

Ilyas 等人通过一组巧妙的实验说明对抗样本其实是模型从数据中学习到一部分特征,尽管对人来说不可感知,但是对于模型来说是具有预测意义的。受 Ilyas 等人 工作启发,试图从一个相反的角度来讨论一个潜在的攻击机制:可否去掉一些对人来说微小而不可感知但是对于模型决策又重要的特征,从而形成对抗样本呢?

AdvDrop, 通过丢信息来制造对抗样本

图4:左侧AdvDrop,信息丢失越来越多,右侧 PGD,对抗噪声越来越大

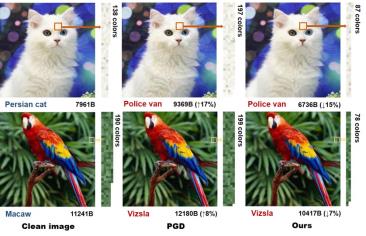

该研究在这个工作中提出一个新的机制来生成对抗样本:与增加对抗扰动相反,通过扔掉一些不可察觉的图像细节来生成对抗样本。关于两种相反机制的说明如图,当AdvDrop放宽丢掉的信息量的阈值epsilon,产生的对抗样本越来越趋近于一张灰色图片,伴随着图像存储量的降低。而相反的,PGD生成的对抗样本,随着干扰幅度的增大,越来越接近于无序噪音。

一张更细节的对比图5所示, 从局部区域来看,PGD在图片的局部生成了更多的细节,表现为更丰富的色彩。而相反的,AdvDrop生成的对抗样本与原图相比失去了一些局部细节,表现在色彩精度的降低。

图5:PGD与AdvDrop 局部色彩丰富度

3.1 方法

但是该如何选择区域去丢图片的信息呢?以及如何保证扔掉的细节对人来说依然是不可感知的呢?

来阿里安全人工智能治理与可持续发展实验室(AAIG)等机构的研究者提出一种通过优化量化表的方式来选择丢掉信息的区域以及丢掉的信息量。此外, 为了保证丢掉的细节对于人来说依然不可感知,先将图像通过离散傅里叶变换从RGB转换到频域,再用量化表去量化一些频域的信息。频域操作相比于RGB的优点是,能更好的分离图像的细节信息(高频信息)和结构信息(低频信息),因此可以保证扔掉的细节对人来说不可感知。

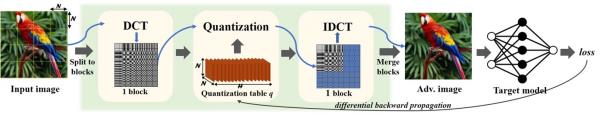

图6:AdvDrop 算法流程

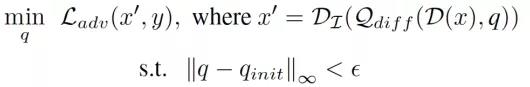

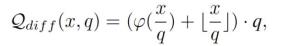

整个流程如图6所示,从优化上,可以被定义为:

其中 D 和

分别表示的是离散余弦变环及反变换,

表示的是一个可微分的量化过程。

通常的量化,可以定义为:

但是因为量化函数不可微分,极大影响优化过程。因此,参考了 Gong 等人的工作,通过引入可控 tanh 函数来渐进的逼近阶梯式的量化函数,所以:

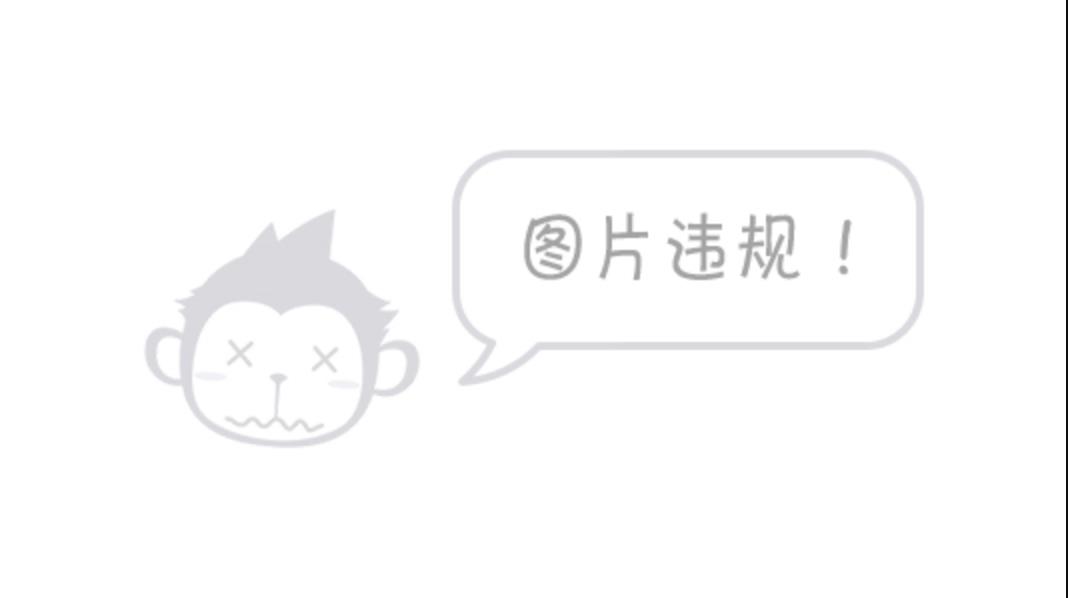

其斜度可以由 α调整,如下图所示,经过量化函数可微处理,可以更准确的反向传播梯度从而更准确的估计出应该丢失信息的位置及量化的大小。

图7:不同alpha 下tanh函数对量化函数的逼近层度

3.2 结果评估

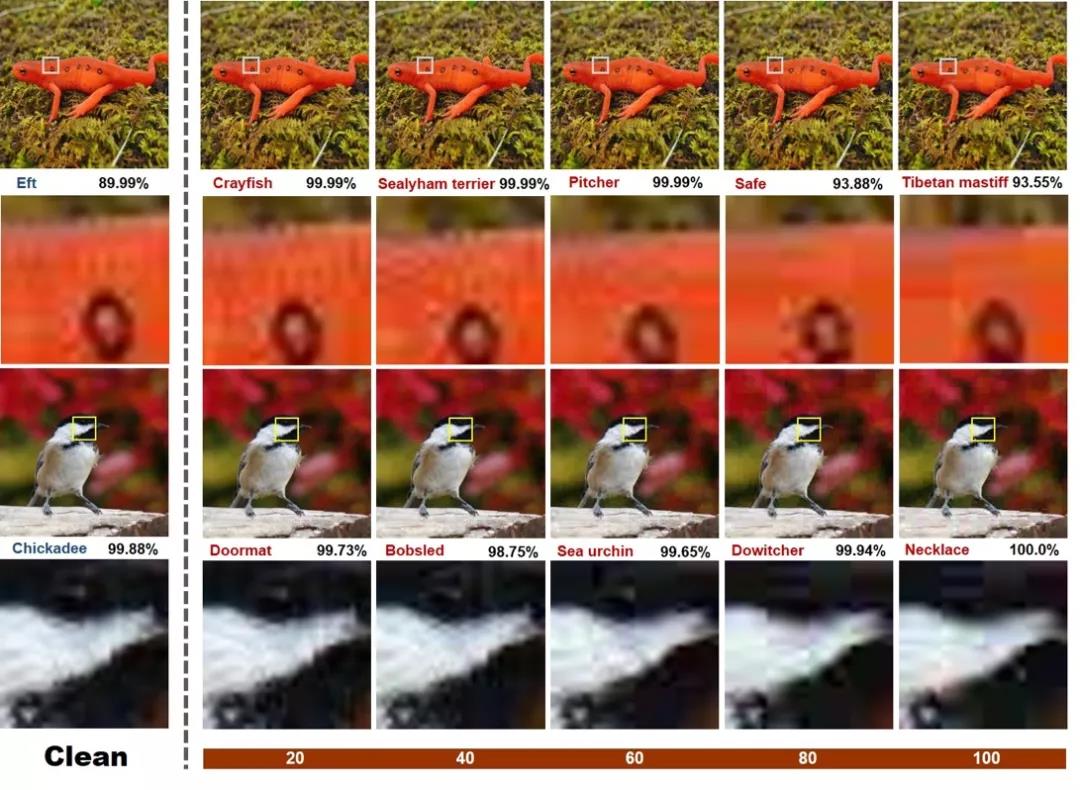

该研究用 lpips 比较了 AdvDrop 及 PGD 在相同信息量变化下的视觉得分: 从对抗样本的不可感知角度来说,在同样的感知得分下,丢信息操作允许操作的信息量要比加干扰允许的更大。从人类视觉上来说,相比于加噪,人眼对于局部平滑其实更为不敏感,从图8可见,随着量化表阈值的增大,AdvDrop 生成的对抗样本的局部细节越少,例如蜥蜴鳞片的纹理。

图8:不同预知下的攻击结果展示

图8:不同预知下的攻击结果展示

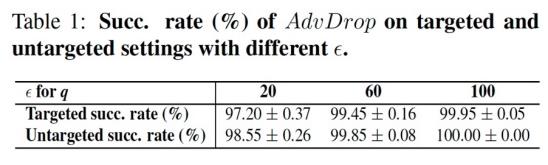

从成功率上来说,无论是在目标攻击还是无目标攻击的设定下, AdvDrop 有相当高的成功率来生成一个对抗样本。在目标攻击下,最高可以达到一个 99.95% 成功率。但相比于传统加噪的对抗攻击生成方式 (例如PGD,BIM) 可以轻易达到 100% 的成功率来说,依然是强度较弱的。该研究认为 AdvDrop 强度方面的局限可能来自于两方面:一方面是由于量化这样的方式,另一方面,“减信息”可以操作的空间相比于“加信息”的空间来说要小很多。

该研究也评估了 AdvDrop 在不同防御下的表现。目前主流防御方式主要分为两种,一种是对抗训练 ,另一种是基于去噪的防御方式。发现 AdvDrop 生成的对抗样本对于现阶段防御方式来说仍是一个挑战,尤其是基于去噪的防御方式。

具体来说,在一定扰动阈值下,基于制造对抗扰动的对抗样本生成方式经过去噪后,图片有很大概率恢复成原始图片。但是对于用 AdvDrop 生成的 对抗样本来说,其本身就是由于部分特征丢失而导致的错误识别,而去噪操作甚至会加剧这种由于丢失而无法识别的问题。

图9:AdvDrop和PGD在Denoise操作下的细节展示

除了防御的角度,考虑到很多数据都是从网上收集而来,而网络传输中往往存在数据压缩过程,所以通过 AdvDrop 生成的对抗样本可能“更耐传输”。当然,另一个角度来想,也有可能对于正常图像数据来说,一些正常的数据压缩(例如jpeg)也许不经意间就引入了对抗样本。

讨论及总结

该研究提出了一个新的生成对抗样本的机制,讨论了与之前加噪方式相反的一个角度来生成对抗样本。这一类型的对抗样本相比于传统加干扰生成的对抗样本来说,更难以防御。

该工作也展示了模型另一个角度的局限性:对重要细节丢失的稳健性。

在这个工作中,研究人员仅仅探索了在频域上丢信息的操作,通过其他丢信息方式来生成对抗样本都是可以值得尝试的未来工作。

Benchmark

AI 模型的对抗攻防是一个相互相互博弈的过程,模型的对抗攻击与防御层出不穷,以上提出的攻击算法也仅仅是一种攻击形态。为了更加客观、公平地衡量AI模型的鲁棒性, 清华大学,阿里安全,瑞莱智慧联合发布的业内最新的基于深度学习模型的对抗攻防基准平台 Adversarial Robustness Benchmark,此次推出 AI 对抗安全基准基本上包括了目前主流的AI对抗攻防模型,涵盖了数十种典型的攻防算法。不同算法比测的过程中尽量采用了相同的实验设定和一致的度量标准,从而在最大限度上保证了比较的公平性和客观性。

地址:https://ml.cs.tsinghua.edu.cn/adv-bench/#/

图10:Adversarial Robustness Benchmark

以上是关于阿里安全新研究:给图片打“马赛克”就能骗过 AI 视觉系统的主要内容,如果未能解决你的问题,请参考以下文章

信安早八点丨面部识别安全吗?研究发现3D打印的脸能骗过安卓机

码蹄集 - MT3149 · AND - 数据不是很强,暴力剪枝就能骗AC