深度学习与图神经网络核心技术实践应用高级研修班-Day3去噪自编码器(Denoising)

Posted ZSYL

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了深度学习与图神经网络核心技术实践应用高级研修班-Day3去噪自编码器(Denoising)相关的知识,希望对你有一定的参考价值。

去噪自编码器(Denoising)

1. 问题背景

简介

自编码器(AutoEncoder)是深度学习中的⼀类无监督学习模型,由encoder 和decoder 两部分组成。

- encoder 将原始表示编码成隐层表示;

- decoder 将隐层表示解码成原始表示;

- 训练目标为最小化重构误差;

- 隐层特征维度⼀般低于原始特征维度,降维的同时学习更稠密更有意义的表示。

2. 问题定义

去噪自动编码器(DAE)是在传统自动编码器的基础上,通过向输入中注入噪声,然后利用含噪声的“腐坏”的样本去重构不含噪声的“干净”输入。

3. 实验方案

3.1 数据来源

数据是MNIST,手写数字识别数据集,Keras 中自带。

训练集5万条,测试集1万 条,都是28×28 的灰度图。

3.2 获取带噪声图片

-

加载 MNIST 数据,不需要对应的标签,将像素值归⼀化到 0 至 1,重塑 为 N × 1 × 28 × 28 的四维张量,其中1 表示颜色通道,即灰度图。

-

添加随机白噪声,并限制加噪后像素值仍处于 0 至1 之间。

3.3 获取带噪声图片

引入高斯噪声,噪声的均值为0,方差为1

3.4 模型实现

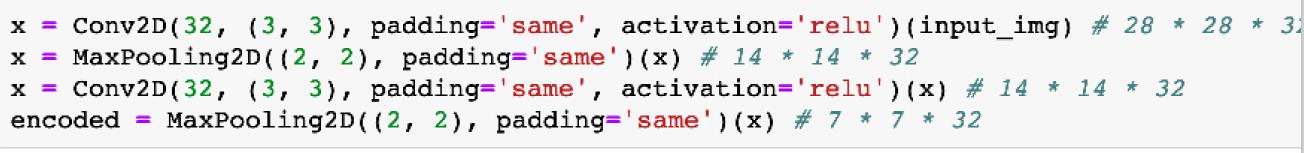

- 实现encoder 部分,由两个3×3×32 的卷积和两个2×2 的最大池化组成。

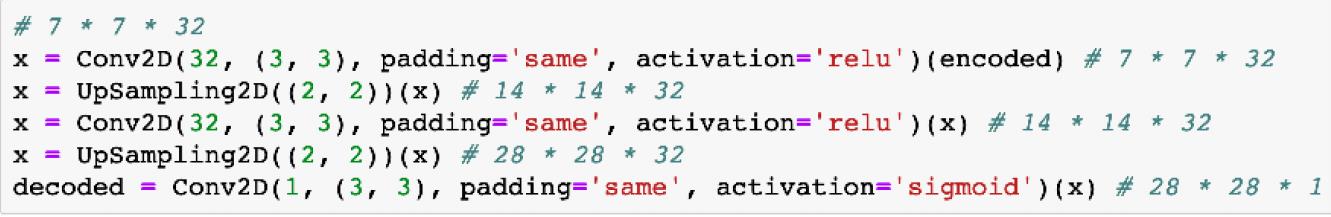

- 实现decoder 部分,由两个3×3×32 的卷积和两个2×2 的上采样组成。

3.5 Encoder实现

- 卷积(卷积核3×3,步长为1,填充为1)

- 最大值池化(池化核2×2,步长为2)

- 卷积(卷积核3×3,步长为1,填充为1)

- 最大值池化(池化核2×2,步长为2)

3.6 Encoder实现

- 上采样(上采样因子2×2)

- 卷积(卷积核3×3,步长为1,填充为1)

- 上采样(上采样因子2×2)

- 卷积(卷积核3×3,步长为1,填充为1)

4. 实验效果

以上是关于深度学习与图神经网络核心技术实践应用高级研修班-Day3去噪自编码器(Denoising)的主要内容,如果未能解决你的问题,请参考以下文章