深度学习与图神经网络核心技术实践应用高级研修班-Day1卷积神经网络和循环神经网络

Posted ZSYL

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了深度学习与图神经网络核心技术实践应用高级研修班-Day1卷积神经网络和循环神经网络相关的知识,希望对你有一定的参考价值。

深度学习的常用模型及方法-卷积神经网络和循环神经网络

1. 卷积神经网络(CNN)

每一个Convolution layer(卷积层)都跟有一个activation layer(激活层)

1.1 CNN的生物学基础

Hubel&Wisel在1960年左右做了一系列关于猫的视觉神经元的研究。

有以下三个主要成果:

-

猫的大脑中第一层的视觉神经元(V1),只处理局部视觉中的简单基础结构信息(如某一方向的直线、点),且一类神经元只对一种特定的基础结构做出反应(对应于CNN中的感受野和权值共享)。

-

而且V1神经元是会保留拓扑结构信息的,即相邻的神经元的感受野在图像中也相邻(对应于中的滑动窗口) 。

- 视觉神经元是有层次的,高层神经元处理更加复杂的特征(对应于CNN的层次化结构和降采样)。

1.2 CNN的历史

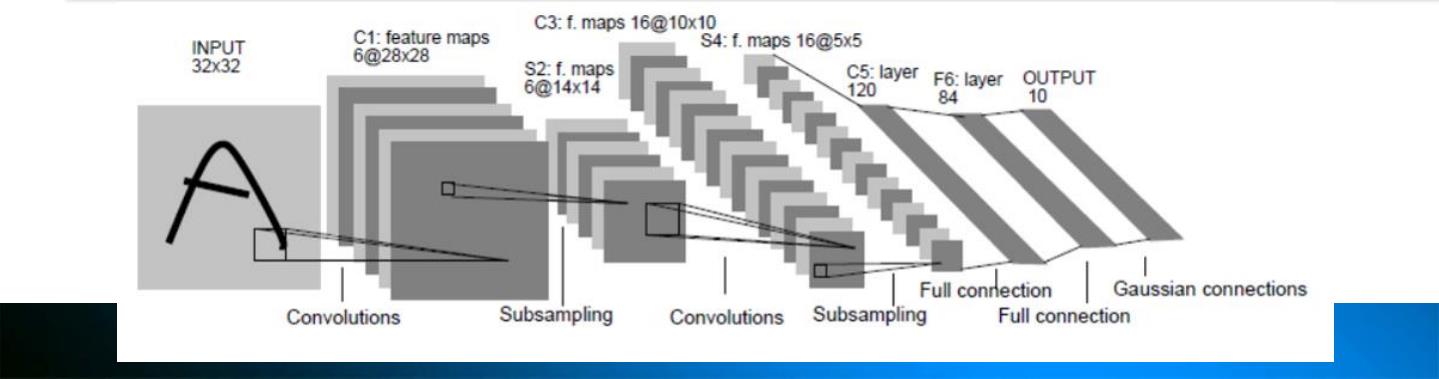

1980年, Fukushima最早提出并使用CNN的核心

思想。首次提出并使用了“三明治” 结构、局部感受野、池化层等思想。

在工业界,Lecun在1998年提出的LeNet-5,这个网络可以很好地识别手写数字,甚至可以识别手写字母。之后,神经网络方法的研究陷入低谷。由于当时计算能力和数据量的不足,经网络难以训练收敛

2012年,AlexNet在ImageNet数据集上打败了当时所有的传统图像处理方法,基于卷积神经网络的方法流行 。

2. 循环神经网络(RNN)

- 传统神经网络模型中层与层之间是全连接的,每层之间的节点是无连接的。但是这种普通的神经网络对于很多依赖序列信息的问题却无能无力。

- RNN输入序列当前数据的输出与前面的输出也相关。隐藏层之间的节点不再无连接而是有连接的,并且隐藏层的输入不仅包括输入层的输出还包括上一时刻隐藏层的输出。RNN更改有效的捕捉有序数据的序列信息。

2.1 网络结构

加油!

感谢!

努力!

以上是关于深度学习与图神经网络核心技术实践应用高级研修班-Day1卷积神经网络和循环神经网络的主要内容,如果未能解决你的问题,请参考以下文章