入门kafka,2021新鲜出炉阿里巴巴面试真题

Posted 程序员超时空

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了入门kafka,2021新鲜出炉阿里巴巴面试真题相关的知识,希望对你有一定的参考价值。

Kafka 的底层使用 Zookeeper 储存元数据,确保一致性,所以安装 Kafka 前需要先安装 Zookeeper,Kafka 的发行版自带了 Zookeeper ,可以直接使用脚本来启动,不过安装一个 Zookeeper 也不费劲

Zookeeper 单机搭建

Zookeeper 单机搭建比较简单,直接从 https://www.apache.org/dyn/closer.cgi/zookeeper/官网下载一个稳定版本的 Zookeeper ,这里我使用的是 3.4.10,下载完成后,在 Linux 系统中的 /usr/local 目录下创建 zookeeper 文件夹,使用xftp 工具(xftp 和 xshell 工具都可以在官网 https://www.netsarang.com/zh/xshell/ 申请免费的家庭版)把下载好的 zookeeper 压缩包放到 /usr/local/zookeeper 目录下。

如果下载的是一个 tar.gz 包的话,直接使用 tar -zxvf zookeeper-3.4.10.tar.gz解压即可

如果下载的是 zip 包的话,还要检查一下 Linux 中是否有 unzip 工具,如果没有的话,使用 yum install unzip 安装 zip 解压工具,完成后使用 unzip zookeeper-3.4.10.zip 解压即可。

解压完成后,cd 到 /usr/local/zookeeper/zookeeper-3.4.10 ,创建一个 data 文件夹,然后进入到 conf 文件夹下,使用 mv zoo_sample.cfg zoo.cfg 进行重命名操作

然后使用 vi 打开 zoo.cfg ,更改一下dataDir = /usr/local/zookeeper/zookeeper-3.4.10/data,保存。

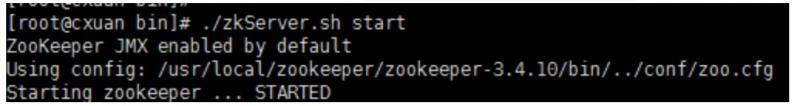

进入bin目录,启动服务输入命令./zkServer.sh start 输出下面内容表示搭建成功

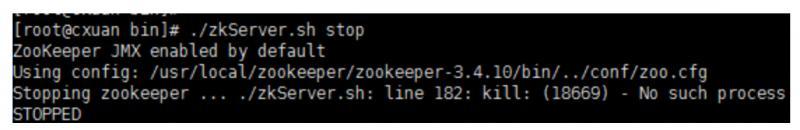

关闭服务输入命令,./zkServer.sh stop

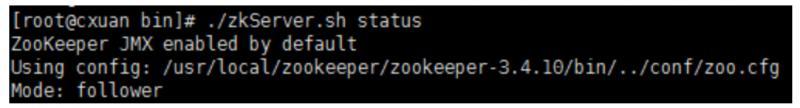

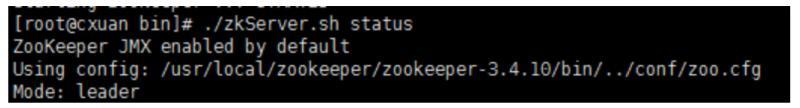

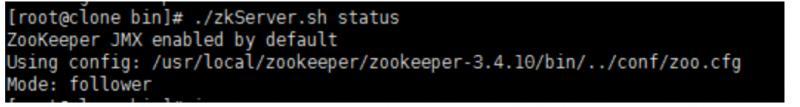

使用 ./zkServer.sh status 可以查看状态信息。

Zookeeper 集群搭建

准备条件

准备条件:需要三个服务器,这里我使用了CentOS7 并安装了三个虚拟机,并为各自的虚拟机分配了1GB的内存,在每个 /usr/local/ 下面新建 zookeeper 文件夹,把 zookeeper 的压缩包挪过来,解压,完成后会有 zookeeper-3.4.10 文件夹,进入到文件夹,新建两个文件夹,分别是 data 和log文件夹

注:上一节单机搭建中已经创建了一个data 文件夹,就不需要重新创建了,直接新建一个 log 文件夹,对另外两个新增的服务需要新建这两个文件夹。

设置集群

新建完成后,需要编辑 conf/zoo.cfg 文件,三个文件的内容如下

tickTime=2000

initLimit=10

syncLimit=5

dataDir=/usr/local/zookeeper/zookeeper-3.4.10/data

dataLogDir=/usr/local/zookeeper/zookeeper-3.4.10/log

clientPort=12181

server.1=192.168.1.7:12888:13888

server.2=192.168.1.8:12888:13888

server.3=192.168.1.9:12888:13888

server.1 中的这个 1 表示的是服务器的标识也可以是其他数字,表示这是第几号服务器,这个标识要和下面我们配置的 myid 的标识一致可以。

192.168.1.7:12888:13888 为集群中的 ip 地址,第一个端口表示的是 master 与 slave 之间的通信接口,默认是 2888,第二个端口是leader选举的端口,集群刚启动的时候选举或者leader挂掉之后进行新的选举的端口,默认是 3888

现在对上面的配置文件进行解释

tickTime: 这个时间是作为 Zookeeper 服务器之间或客户端与服务器之间维持心跳的时间间隔,也就是每个 tickTime 时间就会发送一个心跳。

initLimit:这个配置项是用来配置 Zookeeper 接受客户端(这里所说的客户端不是用户连接 Zookeeper 服务器的客户端,而是 Zookeeper 服务器集群中连接到 Leader 的 Follower 服务器)初始化连接时最长能忍受多少个心跳时间间隔数。当已经超过 5个心跳的时间(也就是 tickTime)长度后 Zookeeper 服务器还没有收到客户端的返回信息,那么表明这个客户端连接失败。总的时间长度就是 5*2000=10 秒

syncLimit: 这个配置项标识 Leader 与Follower 之间发送消息,请求和应答时间长度,最长不能超过多少个 tickTime 的时间长度,总的时间长度就是5*2000=10秒

dataDir: 快照日志的存储路径

dataLogDir: 事务日志的存储路径,如果不配置这个那么事务日志会默认存储到dataDir指定的目录,这样会严重影响zk的性能,当zk吞吐量较大的时候,产生的事务日志、快照日志太多

clientPort: 这个端口就是客户端连接 Zookeeper 服务器的端口,Zookeeper 会监听这个端口,接受客户端的访问请求。

创建 myid 文件

在了解完其配置文件后,现在来创建每个集群节点的 myid ,我们上面说过,这个 myid 就是 server.1 的这个 1 ,类似的,需要为集群中的每个服务都指定标识,使用 echo 命令进行创建

# server.1

echo "1" > /usr/local/zookeeper/zookeeper-3.4.10/data/myid

# server.2

echo "2" > /usr/local/zookeeper/zookeeper-3.4.10/data/myid

# server.3

echo "3" > /usr/local/zookeeper/zookeeper-3.4.10/data/myid

启动服务并测试

配置完成,为每个 zk 服务启动并测试,我在 windows 电脑的测试结果如下

启动服务(每台都需要执行)

cd /usr/local/zookeeper/zookeeper-3.4.10/bin

./zkServer.sh start

检查服务状态

使用 ./zkServer.sh status 命令检查服务状态

192.168.1.7 — follower

192.168.1.8 — leader

192.168.1.9 — follower

zk集群一般只有一个leader,多个follower,主一般是相应客户端的读写请求,而从主同步数据,当主挂掉之后就会从follower里投票选举一个leader出来。

Kafka 集群搭建

准备条件

-

搭建好的 Zookeeper 集群

-

Kafka 压缩包 (https://www.apache.org/dyn/closer.cgi?path=/kafka/2.3.0/kafka_2.12-2.3.0.tgz)

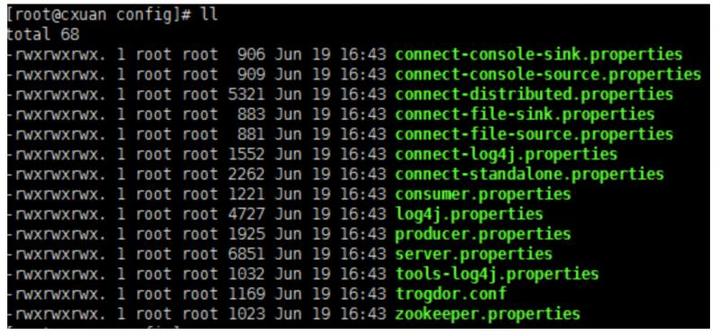

在 /usr/local 下新建 kafka 文件夹,然后把下载完成的 tar.gz 包移到 /usr/local/kafka 目录下,使用 tar -zxvf 压缩包 进行解压,解压完成后,进入到 kafka_2.12-2.3.0 目录下,新建 log 文件夹,进入到 config 目录下

我们可以看到有很多 properties 配置文件,这里主要关注 server.properties 这个文件即可。

kafka 启动方式有两种,一种是使用 kafka 自带的 zookeeper 配置文件来启动(可以按照官网来进行启动,并使用单个服务多个节点来模拟集群http://kafka.apache.org/quickstart#quickstart_multibroker),一种是通过使用独立的zk集群来启动,这里推荐使用第二种方式,使用 zk 集群来启动

修改配置项

需要为每个服务都修改一下配置项,也就是server.properties, 需要更新和添加的内容有

broker.id=0 //初始是0,每个 server 的broker.id 都应该设置为不一样的,就和 myid 一样 我的三个服务分别设置的是 1,2,3

log.dirs=/usr/local/kafka/kafka_2.12-2.3.0/log

#在log.retention.hours=168 下面新增下面三项

message.max.byte=5242880

default.replication.factor=2

replica.fetch.max.bytes=5242880

#设置zookeeper的连接端口

zookeeper.connect=192.168.1.7:2181,192.168.1.8:2181,192.168.1.9:2181

配置项的含义

broker.id=0 #当前机器在集群中的唯一标识,和zookeeper的myid性质一样

port=9092 #当前kafka对外提供服务的端口默认是9092

host.name=192.168.1.7 #这个参数默认是关闭的,在0.8.1有个bug,DNS解析问题,失败率的问题。

num.network.threads=3 #这个是borker进行网络处理的线程数

num.io.threads=8 #这个是borker进行I/O处理的线程数

log.dirs=/usr/local/kafka/kafka_2.12-2.3.0/log #消息存放的目录,这个目录可以配置为“,”逗号分割的表达式,上面的num.io.threads要大于这个目录的个数这个目录,如果配置多个目录,新创建的topic他把消息持久化的地方是,当前以逗号分割的目录中,那个分区数最少就放那一个

socket.send.buffer.bytes=102400 #发送缓冲区buffer大小,数据不是一下子就发送的,先回存储到缓冲区了到达一定的大小后在发送,能提高性能

socket.receive.buffer.bytes=102400 #kafka接收缓冲区大小,当数据到达一定大小后在序列化到磁盘

socket.request.max.bytes=104857600 #这个参数是向kafka请求消息或者向kafka发送消息的请请求的最大数,这个值不能超过java的堆栈大小

num.partitions=1 #默认的分区数,一个topic默认1个分区数

log.retention.hours=168 #默认消息的最大持久化时间,168小时,7天

message.max.byte=5242880 #消息保存的最大值5M

default.replication.factor=2 #kafka保存消息的副本数,如果一个副本失效了,另一个还可以继续提供服务

replica.fetch.max.bytes=5242880 #取消息的最大直接数

log.segment.bytes=1073741824 #这个参数是:因为kafka的消息是以追加的形式落地到文件,当超过这个值的时候,kafka会新起一个文件

log.retention.check.interval.ms=300000 #每隔300000毫秒去检查上面配置的log失效时间(log.retention.hours=168 ),到目录查看是否有过期的消息如果有,删除

log.cleaner.enable=false #是否启用log压缩,一般不用启用,启用的话可以提高性能

zookeeper.connect=192.168.1.7:2181,192.168.1.8:2181,192.168.1.9:2181 #设置zookeeper的连接端口

启动 Kafka 集群并测试

- 启动服务,进入到 /usr/local/kafka/kafka_2.12-2.3.0/bin 目录下

# 启动后台进程

./kafka-server-start.sh -daemon ../config/server.properties

- 检查服务是否启动

# 执行命令 jps

6201 QuorumPeerMain

7035 Jps

6972 Kafka

-

kafka 已经启动

-

创建 Topic 来验证是否创建成功

# cd .. 往回退一层 到 /usr/local/kafka/kafka_2.12-2.3.0 目录下

bin/kafka-topics.sh --create --zookeeper 192.168.1.7:2181 --replication-factor 2 --partitions 1 --topic cxuan

对上面的解释

–replication-factor 2 复制两份 --partitions 1 创建1个分区 --topic 创建主题

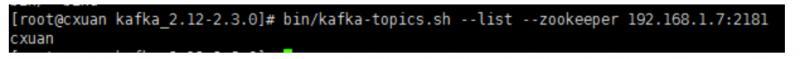

查看我们的主题是否出创建成功

bin/kafka-topics.sh --list --zookeeper 192.168.1.7:2181

启动一个服务就能把集群启动起来

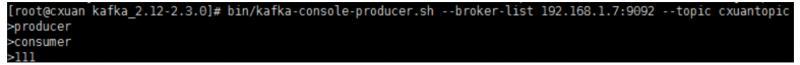

在一台机器上创建一个发布者

# 创建一个broker,发布者

./kafka-console-producer.sh --broker-list 192.168.1.7:9092 --topic cxuantopic

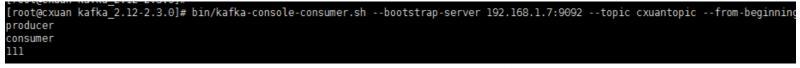

在一台服务器上创建一个订阅者

# 创建一个consumer, 消费者

bin/kafka-console-consumer.sh --bootstrap-server 192.168.1.7:9092 --topic cxuantopic --from-beginning

注意:这里使用 --zookeeper 的话可能出现 zookeeper is not a recognized option 的错误,这是因为 kafka 版本太高,需要使用 --bootstrap-server 指令

测试结果

发布

消费

其他命令

显示 topic

bin/kafka-topics.sh --list --zookeeper 192.168.1.7:2181

# 显示

cxuantopic

查看 topic 状态

bin/kafka-topics.sh --describe --zookeeper 192.168.1.7:2181 --topic cxuantopic

# 下面是显示的详细信息

Topic:cxuantopic PartitionCount:1 ReplicationFactor:2 Configs:

Topic: cxuantopic Partition: 0 Leader: 1 Replicas: 1,2 Isr: 1,2

# 分区为为1 复制因子为2 主题 cxuantopic 的分区为0

# Replicas: 0,1 复制的为1,2

Leader 负责给定分区的所有读取和写入的节点,每个节点都会通过随机选择成为 leader。

Replicas 是为该分区复制日志的节点列表,无论它们是 Leader 还是当前处于活动状态。

Isr 是同步副本的集合。它是副本列表的子集,当前仍处于活动状态并追随Leader。

至此,kafka 集群搭建完毕。

验证多节点接收数据

刚刚我们都使用的是 相同的ip 服务,下面使用其他集群中的节点,验证是否能够接受到服务

在另外两个节点上使用

bin/kafka-console-consumer.sh --bootstrap-server 192.168.1.7:9092 --topic cxuantopic --from-beginning

最后

即使是面试跳槽,那也是一个学习的过程。只有全面的复习,才能让我们更好的充实自己,武装自己,为自己的面试之路不再坎坷!今天就给大家分享一个Github上全面的Java面试题大全,就是这份面试大全助我拿下大厂Offer,月薪提至30K!

我也是第一时间分享出来给大家,希望可以帮助大家都能去往自己心仪的大厂!为金三银四做准备!

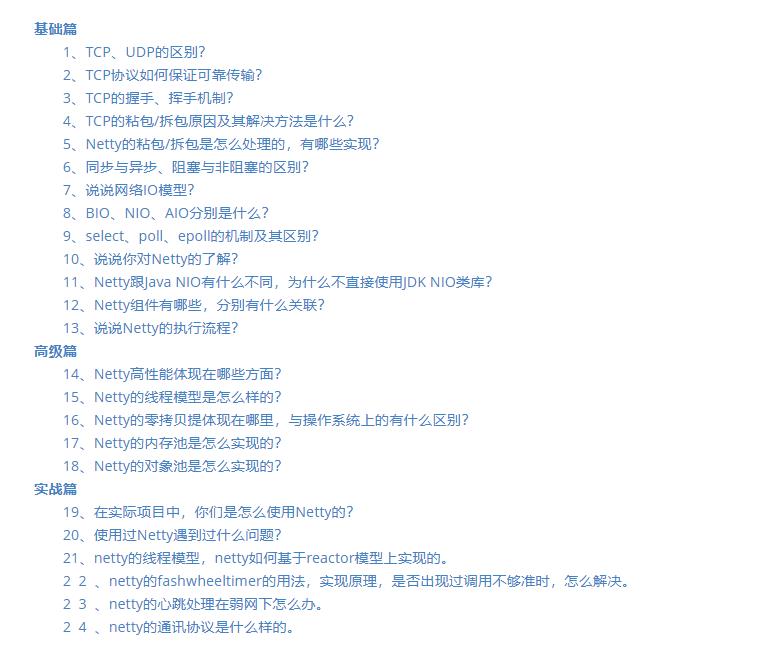

一共有20个知识点专题,分别是:

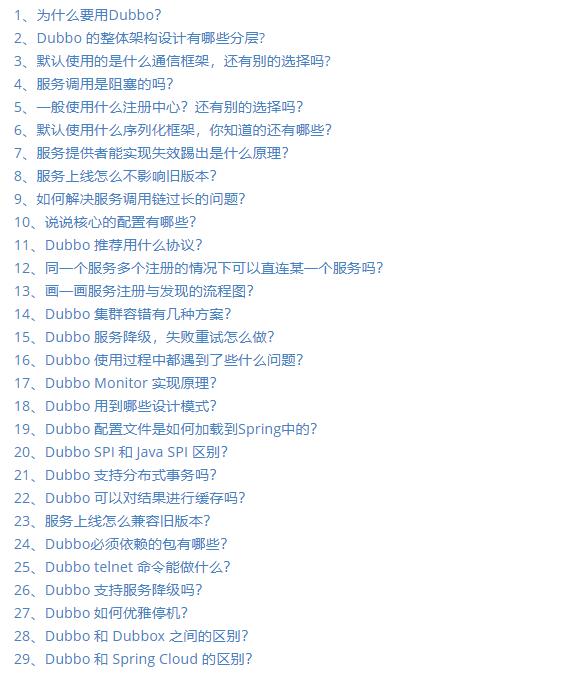

Dubbo面试专题

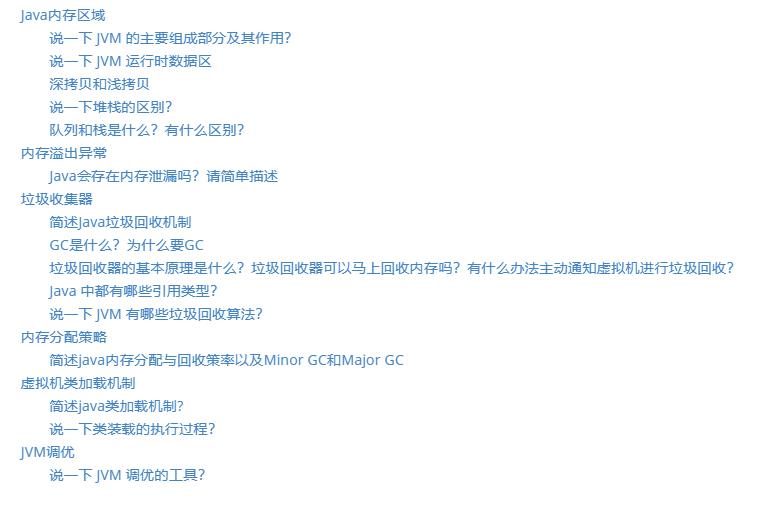

JVM面试专题

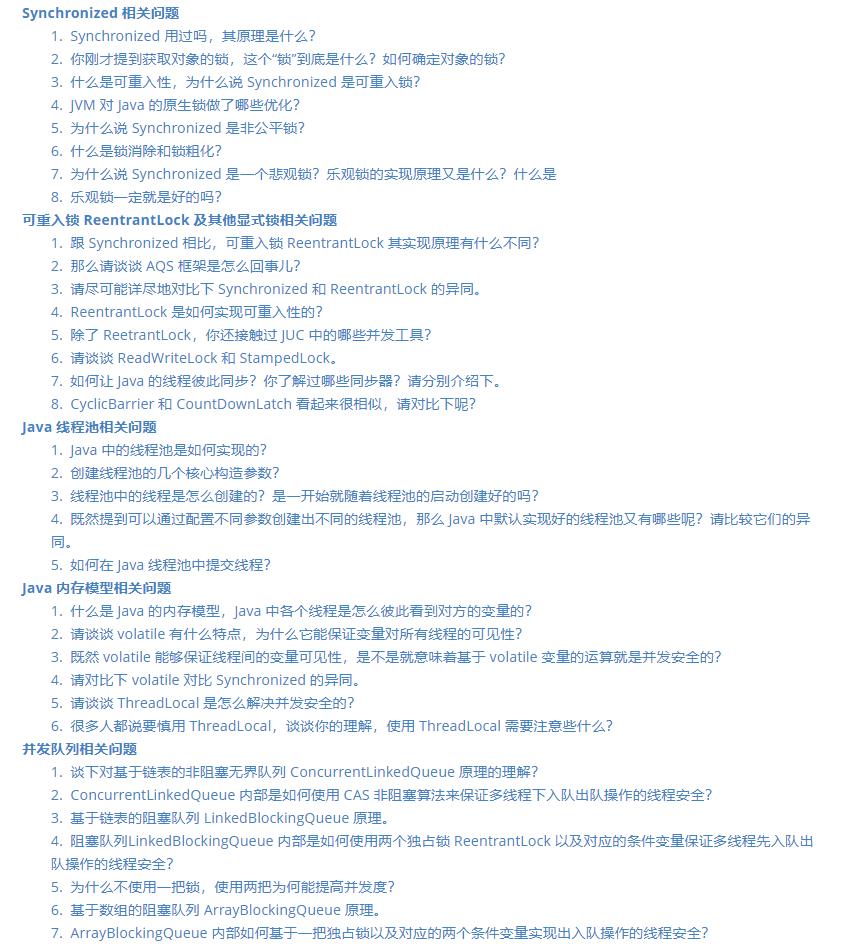

Java并发面试专题

Kafka面试专题

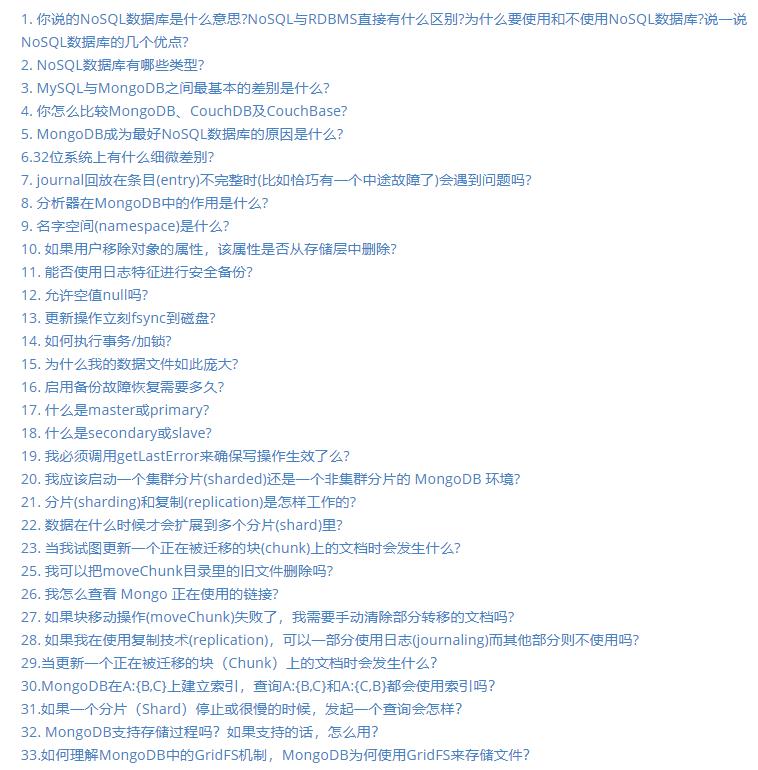

MongDB面试专题

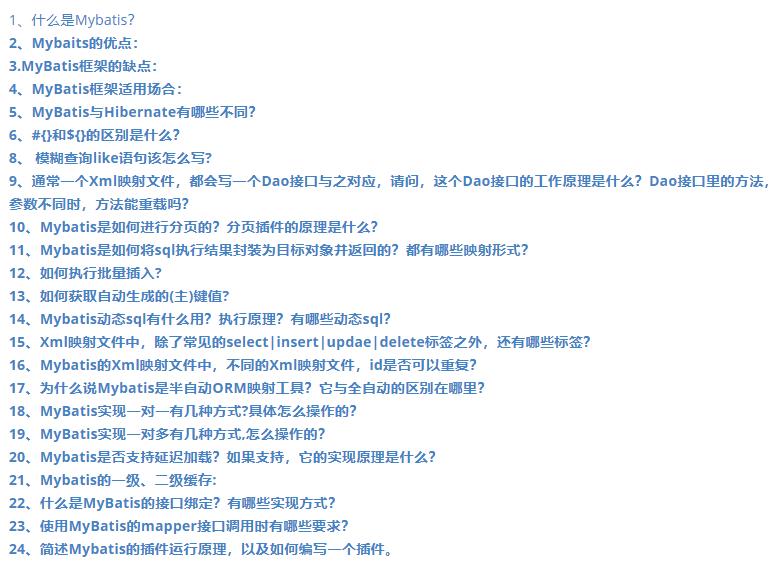

MyBatis面试专题

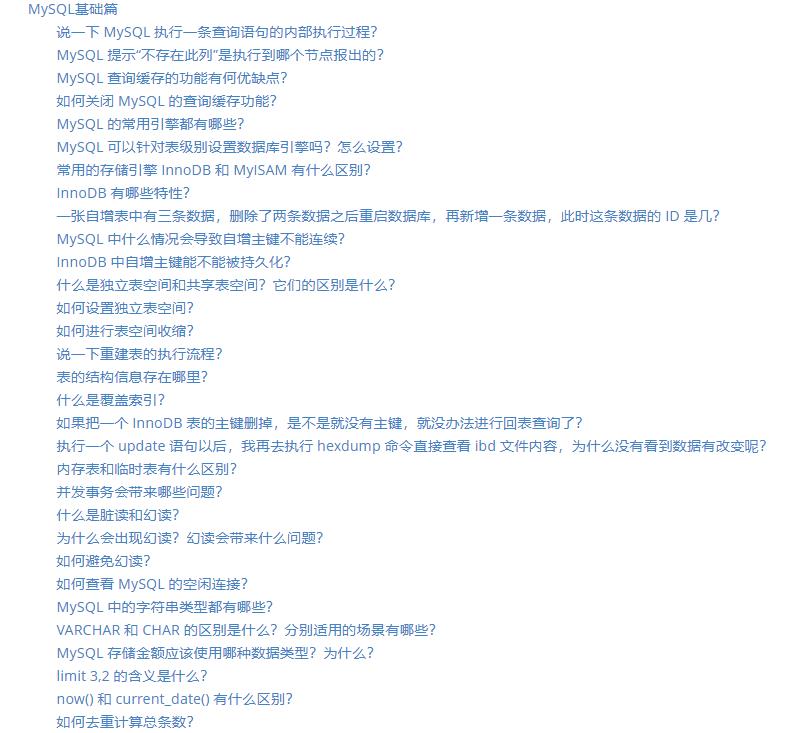

MySQL面试专题

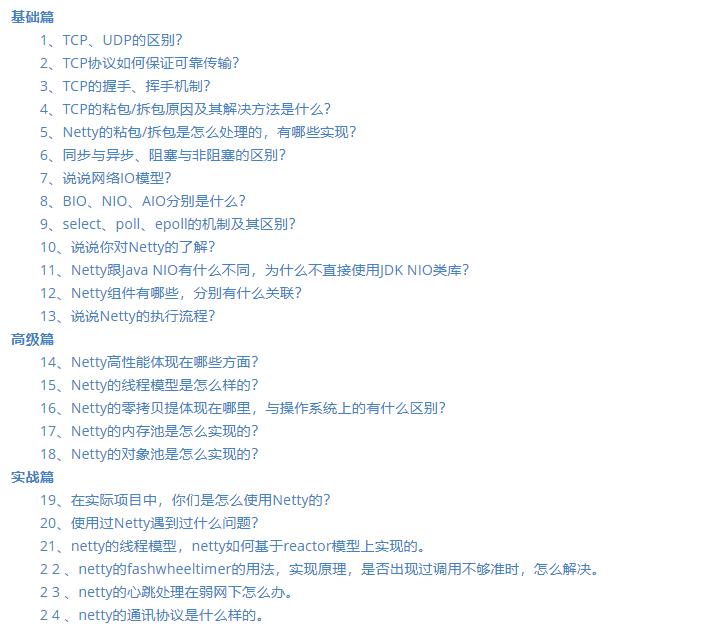

Netty面试专题

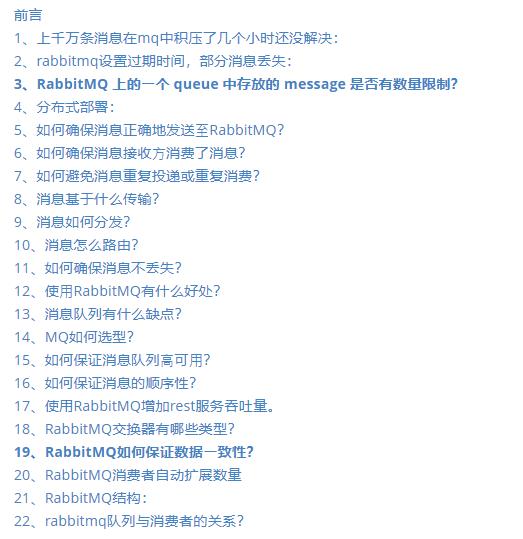

RabbitMQ面试专题

Redis面试专题

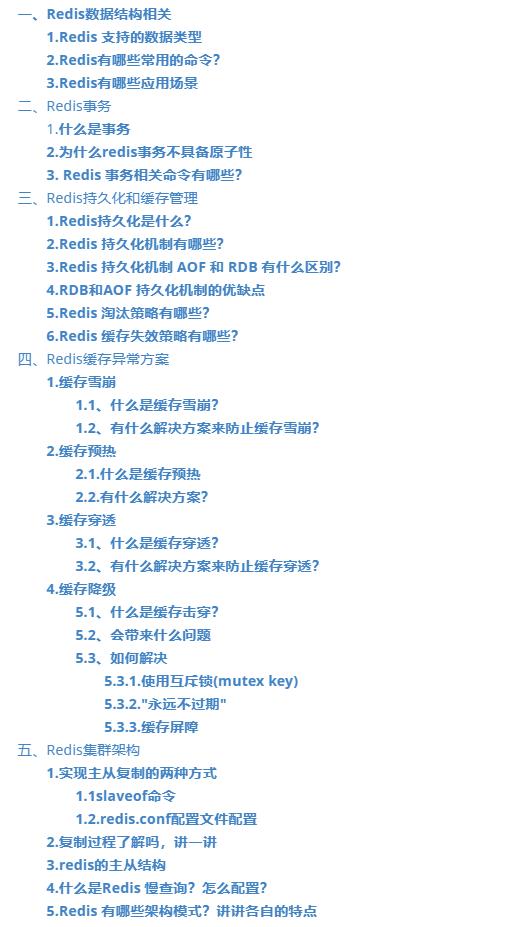

Spring Cloud面试专题

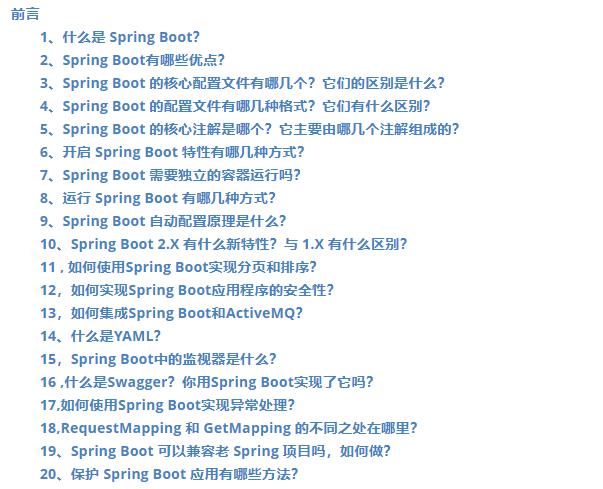

SpringBoot面试专题

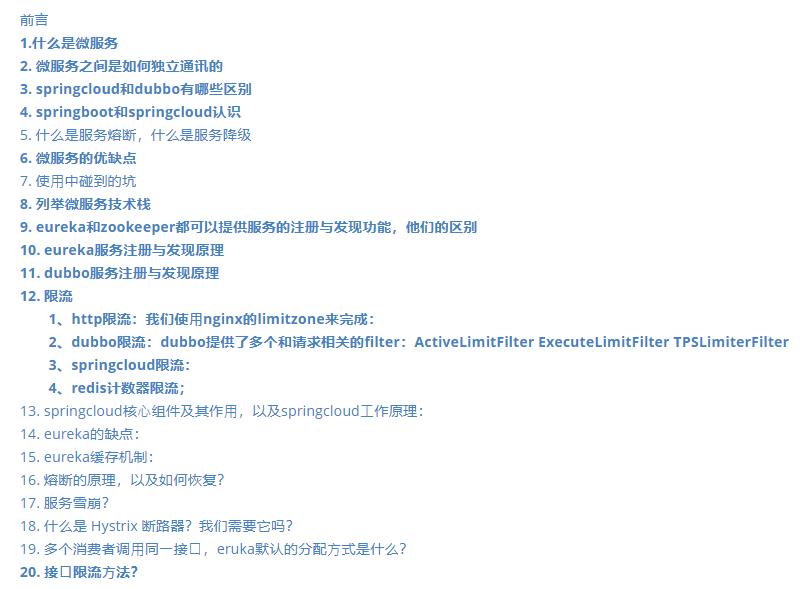

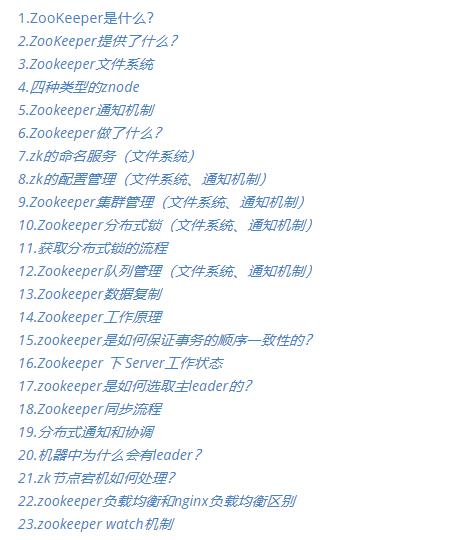

zookeeper面试专题

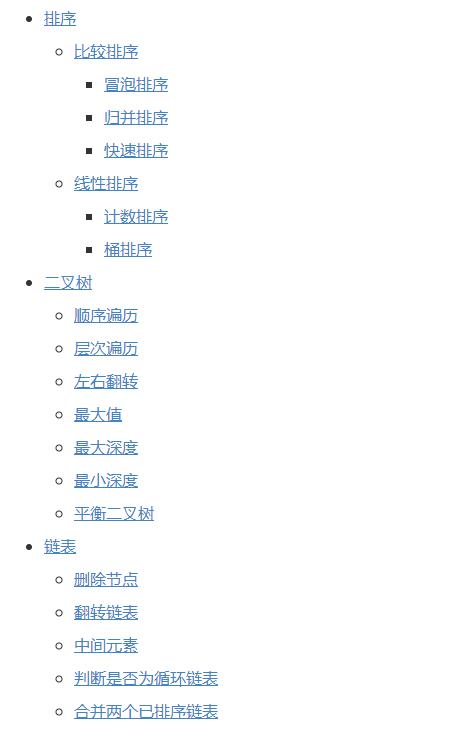

常见面试算法题汇总专题

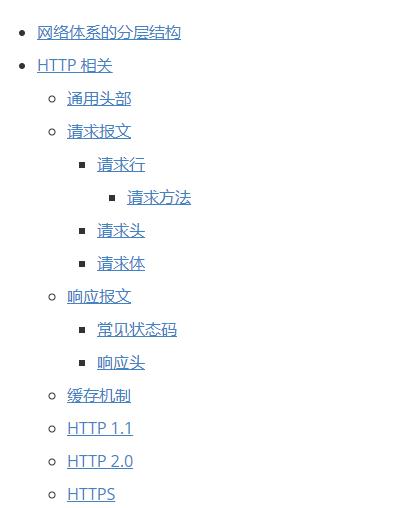

计算机网络基础专题

设计模式专题

)]

Spring Cloud面试专题

[外链图片转存中…(img-pEN1dwgI-1628435206956)]

SpringBoot面试专题

[外链图片转存中…(img-DQzubMMw-1628435206957)]

zookeeper面试专题

[外链图片转存中…(img-rhUV96jA-1628435206958)]

常见面试算法题汇总专题

[外链图片转存中…(img-zVHvKsp2-1628435206959)]

计算机网络基础专题

[外链图片转存中…(img-9m4KjnKB-1628435206960)]

设计模式专题

[外链图片转存中…(img-pEJRXyEt-1628435206961)]

以上是关于入门kafka,2021新鲜出炉阿里巴巴面试真题的主要内容,如果未能解决你的问题,请参考以下文章

2021 备战秋招新鲜出炉的美团字节阿里腾讯等大厂综合 Java 岗面试题

新鲜出炉:腾讯Android开发笔记+2022Android十一位大厂面试真题+音视频60道面试题