Python爬虫之协程,异步协程和多任务异步协程

Posted 汤米先生

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Python爬虫之协程,异步协程和多任务异步协程相关的知识,希望对你有一定的参考价值。

一. 协程

协程,英文叫做 Coroutine,又称微线程,纤程,协程是一种用户态的轻量级线程。

协程拥有自己的寄存器上下文和栈。协程调度切换时,将寄存器上下文和栈保存到其他地方,在切回来的时候,恢复先前保存的寄存器上下文和栈。因此协程能保留上一次调用时的状态,即所有局部状态的一个特定组合,每次过程重入时,就相当于进入上一次调用的状态。

协程本质上是个单进程,协程相对于多进程来说,无需线程上下文切换的开销,无需原子操作锁定及同步的开销,编程模型也非常简单。

我们可以使用协程来实现异步操作,比如在网络爬虫场景下,我们发出一个请求之后,需要等待一定的时间才能得到响应,但其实在这个等待过程中,程序可以干许多其他的事情,等到响应得到之后才切换回来继续处理,这样可以充分利用 CPU 和其他资源,这就是异步协程的优势。

二. 异步协程

对于异步协程的一些概念:

- event——loop:时间循环,相当于一个无限循环,我们可以把一些函数注册到这个事件循环上,当满足某些条件的时候,函数就会被循环执行。

- coroutine:协程对象,我们可以将携程对象注册到事件循环中,它会被事件循环调用。我们可以使用asyps 关键字来定义一个方法,这个 方法在调用时不会被立即执行,而是返回一个携程对象。

- task: 任务,它是对携程对象的进一步封装,包含了任务的各个状态。

- future: 代表将来执行或还没有执行的任务,实际上和task没有本质区别。

- async :定义一个协程。

- await:用来挂起阻塞方法的执行。

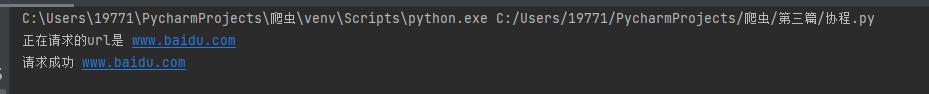

创建一个协程对象并使用

import asyncio

async def request(url):

print('正在请求的url是',url)

print('请求成功',url)

#async修饰的函数,调用之后返回的一个协程对象

c = request('www.baidu.com')

#创建一个事件循环对象

loop = asyncio.get_event_loop()

#将协程对象注册到loop中,然后启动loop

loop.run_until_complete(c)

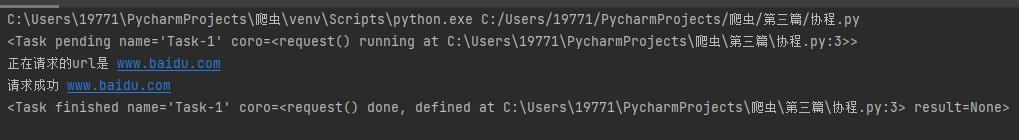

task的创建与使用

import asyncio

async def request(url):

print('正在请求的url是',url)

print('请求成功',url)

#async修饰的函数,调用之后返回的一个协程对象

c = request('www.baidu.com')

loop = asyncio.get_event_loop()

#基于loop创建了一个task对象

task = loop.create_task(c)

print(task)

loop.run_until_complete(task)

print(task)

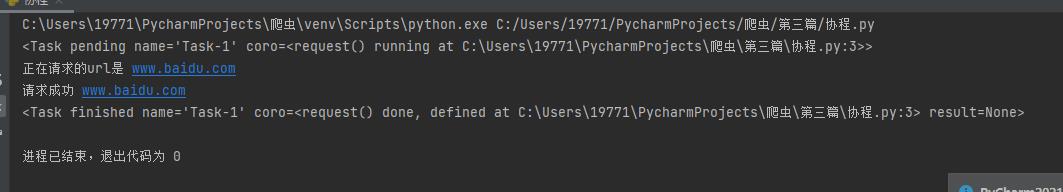

future的使用

import asyncio

async def request(url):

print('正在请求的url是',url)

print('请求成功',url)

#async修饰的函数,调用之后返回的一个协程对象

c = request('www.baidu.com')

loop = asyncio.get_event_loop()

task = asyncio.ensure_future(c)

print(task)

loop.run_until_complete(task)

print(task)

task 与 future 本质上没有区别

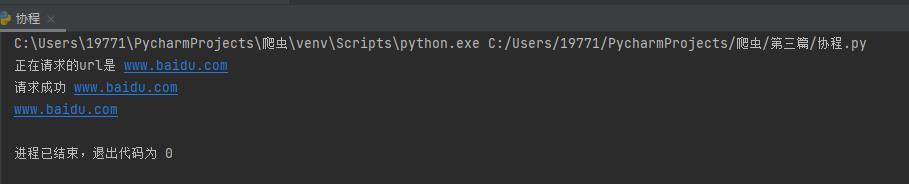

绑定回调

import asyncio

async def request(url):

print('正在请求的url是',url)

print('请求成功',url)

return url

#async修饰的函数,调用之后返回的一个协程对象

c = request('www.baidu.com')

def callback_func(task):

print(task.result())

loop = asyncio.get_event_loop()

task = asyncio.ensure_future(c)

#将回调函数绑定到任务对象中

task.add_done_callback(callback_func)

loop.run_until_complete(task)

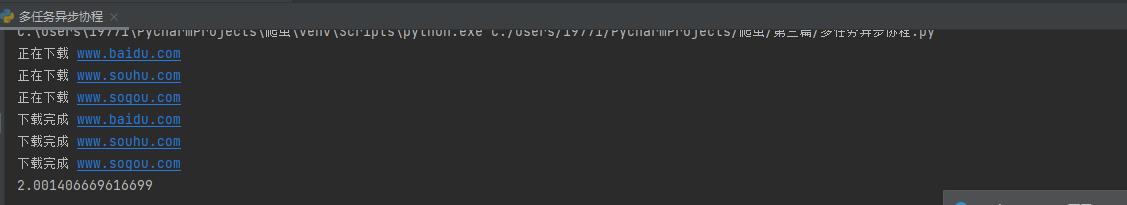

三. 多任务异步协程

下面用代码来展示一下.多任务异步协程的用法和作用

import asyncio

import time

async def request(url):

print('正在下载',url)

#当在asyncio中遇到阻塞操作必须进行手动挂起

await asyncio.sleep(2)

print('下载完成',url)

start = time.time()

urls = [

'www.baidu.com',

'www.souhu.com',

'www.sogou.com'

]

#任务列表:存放多个任务对象

stasks = []

for url in urls:

c=request(url)

task= asyncio.ensure_future(c)

stasks.append(task)

loop= asyncio.get_event_loop()

#需要将任务列表封装到wait中

loop.run_until_complete(asyncio.wait(stasks))

print(time.time()-start)

本该执行6秒的程序,变成了2秒,大大节约了运行时间。

注意:异步时不能使用request模块,可以用aiohttp模块取而代之

例:

import asyncio

import time

import aiohttp

import requests

start = time.time()

urls = [

'url1','url2','url3'

]

async def get_page(url):

async with aiohttp.ClientSession() as session:

async with session.get(url) as response:

#text()返回字符串形式的相应数据

#read()返回二进制形式的响应数据

#ison()返回的就是json对象

#注意:获取相应数据操作之前一定要使用await进行手动挂起

page_text = await response.text()

print(page_text)

tasks = []

for url in urls:

c = get_page(url)

tasks =asyncio.ensure_future(c)

tasks.append(task)

loop = asyncio.get_event_loop()

loop.run_until_complete(asyncio.wait(tasks))

end = time.time()

print("总耗时:",end-start)

以上是关于Python爬虫之协程,异步协程和多任务异步协程的主要内容,如果未能解决你的问题,请参考以下文章

Python异步IO之协程:从yield from到async的使用

python爬虫--多任务异步协程, 快点,在快点......