Python爬虫从0到1 | 爬取酷我音乐信息并下载 ——requests库之GET方法(能省钱!!!)

Posted H_612

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Python爬虫从0到1 | 爬取酷我音乐信息并下载 ——requests库之GET方法(能省钱!!!)相关的知识,希望对你有一定的参考价值。

上一篇教程:Python爬虫从0到1 | 入门实战:360翻译 ——requests库之POST方法

读完本文,你将收获:

- Python的requests库爬虫之get方法

- 省钱

前言

首先我们来说说 http请求中 post 和 get 方式的异同。

post 方法,就是在你进入一个网页后,你发送的新的请求以进行一些操作。post 方法需要两个重要的参数 url 和 data,url 表示要发送请求的网址,data 则是提交的数据和信息。网页根据新得到的信息,再渲染加载出新的页面。比如360翻译,在进入翻译界面后,通过填写翻译内容、点击翻译按钮,网页返回翻译的结果。这就是 post 请求。

get 方法,一般是直接通过发送请求,来获取网页信息。比如,直接通过 get 方法获取网页上的豆瓣电影排行榜等。当然,也有时候 get 方法使用的情况和 post 方法相似。这时候就要看网页所规定的请求方式了。就如下面这个例子:搜索酷我音乐并获取音乐基本信息。

准备

安装 requests 库:

快捷键 Windows+r 打开运行控制框,输入 cmd,进入命令行,输入:

pip install requests

导入:

import requests

网页分析

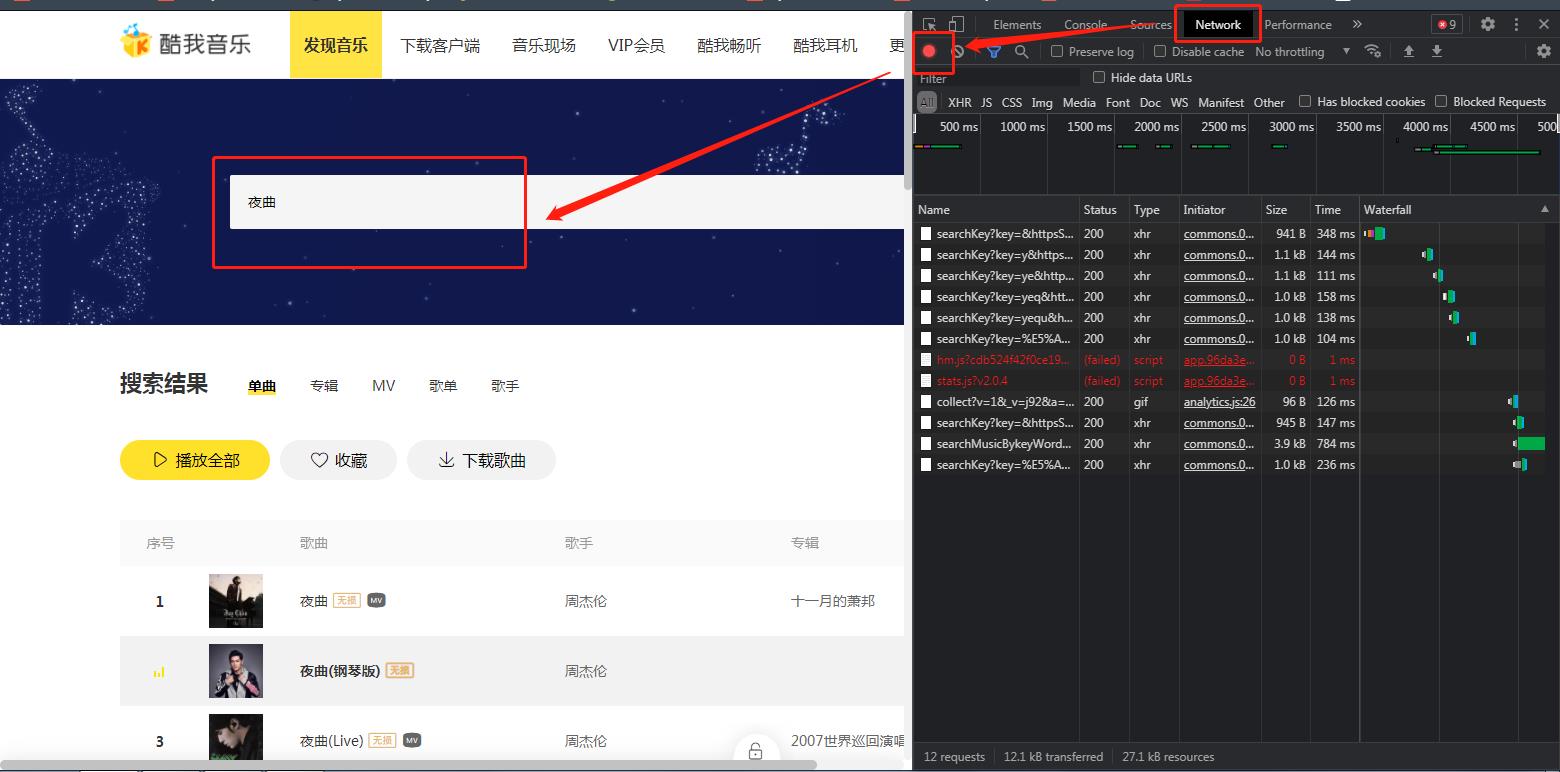

首先进入酷我音乐主页,右键,点击检查元素,调出开发者模式,点击Network(网络),开始录制。我们在搜索栏里输入“夜曲”:

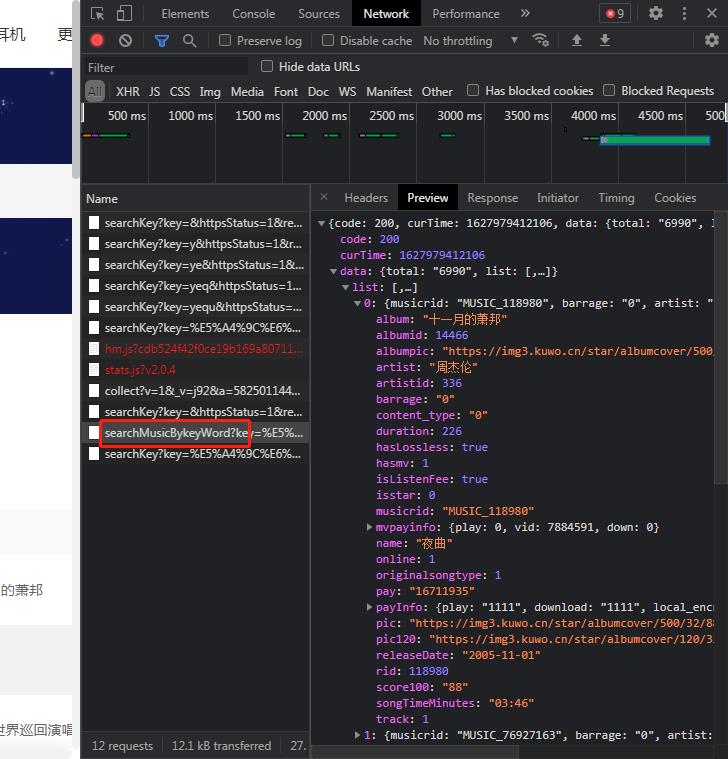

之后,我们可以看到一个以searchMusicBykeyWord开头的链接,点进去,Preview里有我们需要的信息,位置为data > list:

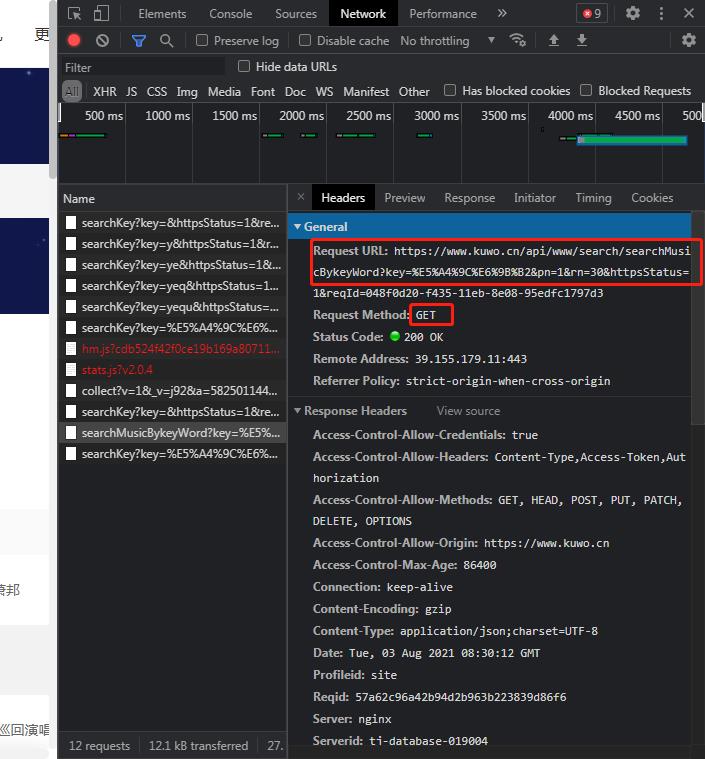

接下来切到 Headers一栏,看到请求的信息。

可以看到,这次请求需要用到的是 get 方法。一般格式为:

requests.get(url=<url地址>, headers=<请求头>, params=<信息>)

url 地址和请求头这里就不赘述了。详细介绍见上一篇教程。其中 url 只取问号前面的,Headers 必要的参数是 Cookie、csrf、Referer。如果缺少会报错。详情见文章:Python的requests爬取酷我音乐的一些坑。

url = 'https://www.kuwo.cn/api/www/search/searchMusicBykeyWord'

headers = {

'Cookie': '...kw_token=IR4PF56LDX',

'csrf': 'IR4PF56LDX',

'Referer': 'https://www.kuwo.cn/search/list'

}

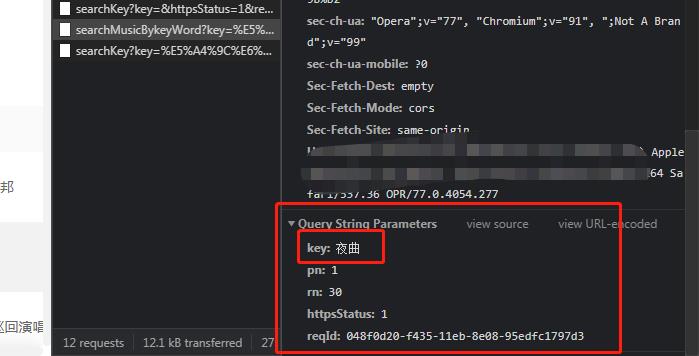

接下来看到 params。与 post 方法的 data 相似,它表示的是发送的信息。我们将 Headers 栏滑到底部,看到 params:

类似地,我们把 params 复制下来:

params = {'key': '夜曲',

'pn': '1',

'rn': '30',

'httpsStatus': '1'

}

这样,我们就有了完成一次 get 请求所需要的信息。

发送请求

接下来我们可以发送请求获取请求结果:

respond = requests.post(url=url, params=params, headers=headers)

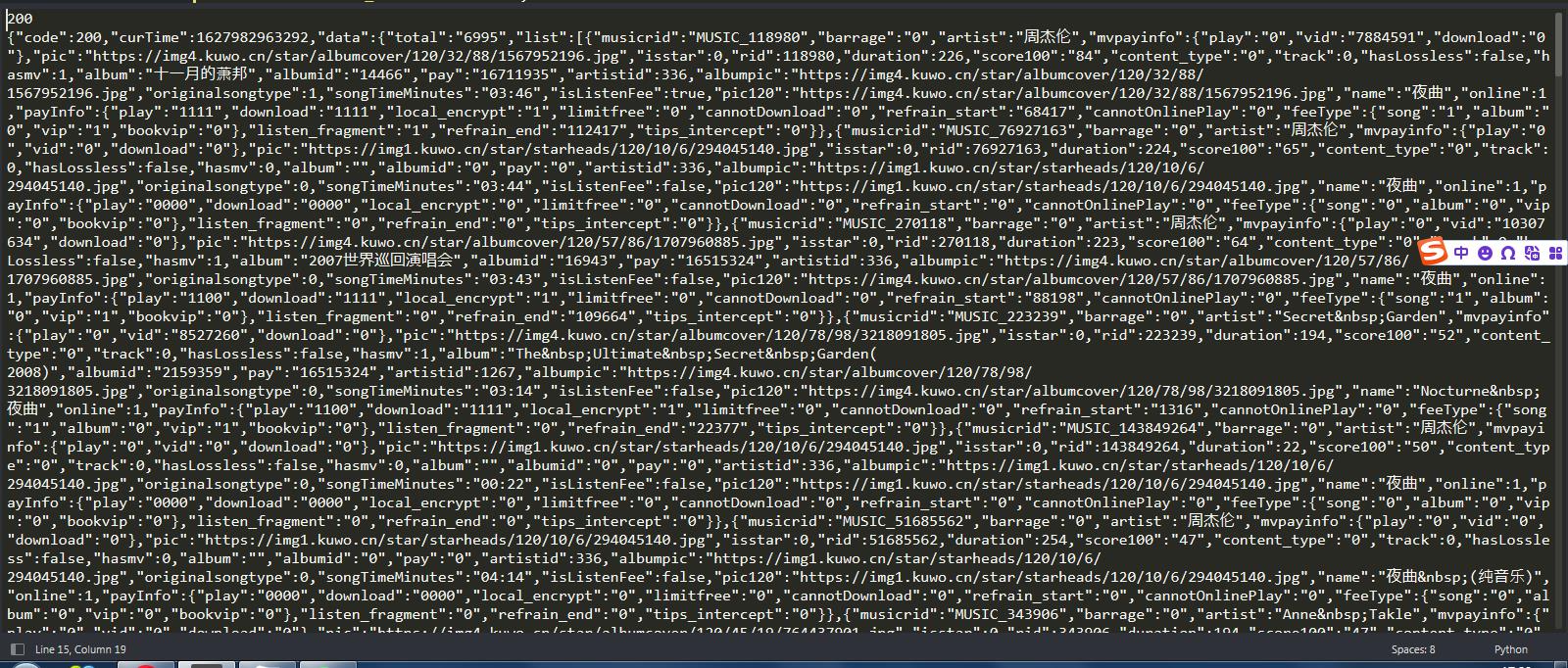

接下来看看请求结果:

print(respond.status_code) # 打印状态码

print(respond.text) # 打印返回文本

print(respond.json()['data']) # 打印返回文本经json解码后的data部分

输出:

……额 返回内容过长,不建议细读。

最后我们根据歌曲信息所在的位置获取列表:

list_music = respond.json()['data']['list']

列表的内容过长,这是因为其中有大量我们不需要的信息。这时候我们对信息来一次筛选:

list_music = [{'name':i['name'], 'artist':i['artist'], 'time':i['songTimeMinutes'], 'id':i['rid'], 'album': i['album'], 'picture':i['pic']} for i in list_music]

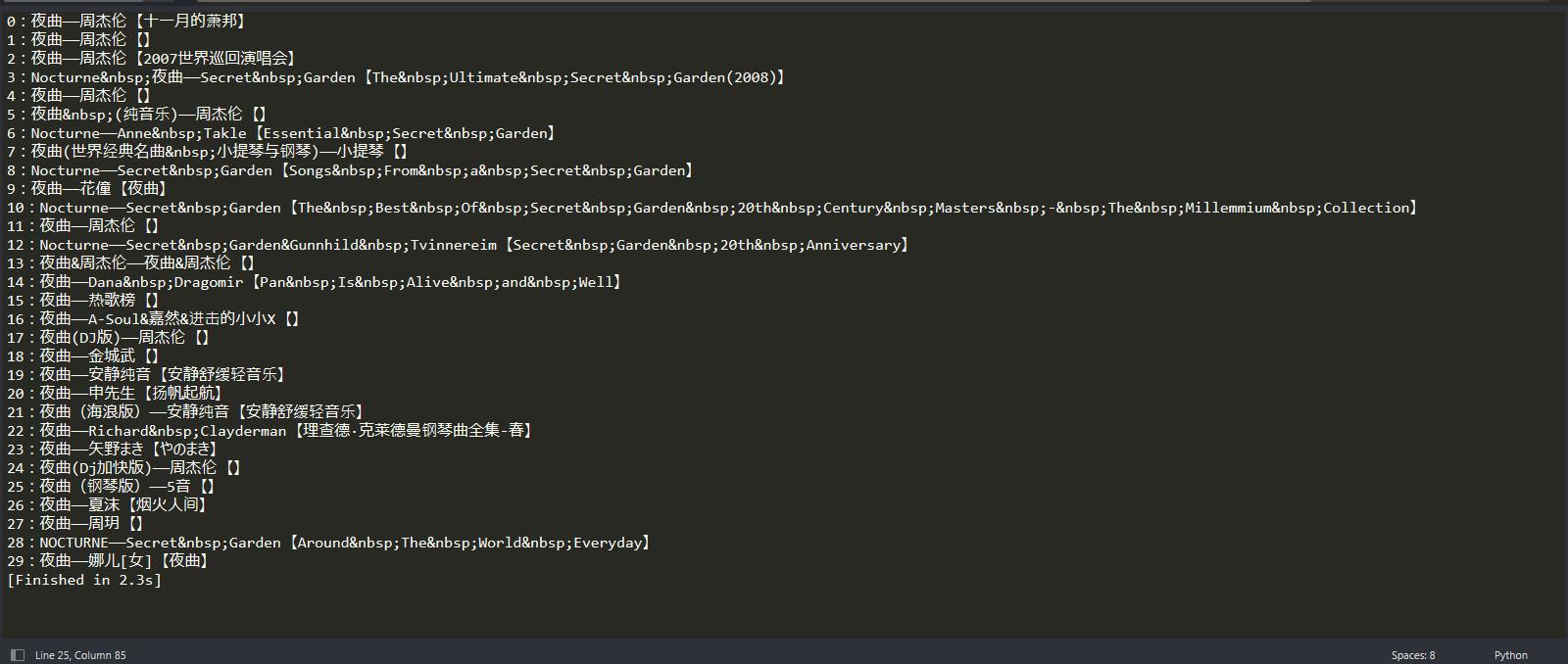

然后打印结果:

for i, n in enumerate(list_music):

print(str(i) + ':' + n['name'] + '——' + n['artist'] + ' 【' + n['album'] + '】')

就这样,我们成功地搜索到了相关音乐并打印出了音乐信息。

当然,仅仅这样还不能够下载音乐。若要下载音乐,我们需要到另一个链接发送 get 请求。

下载音乐

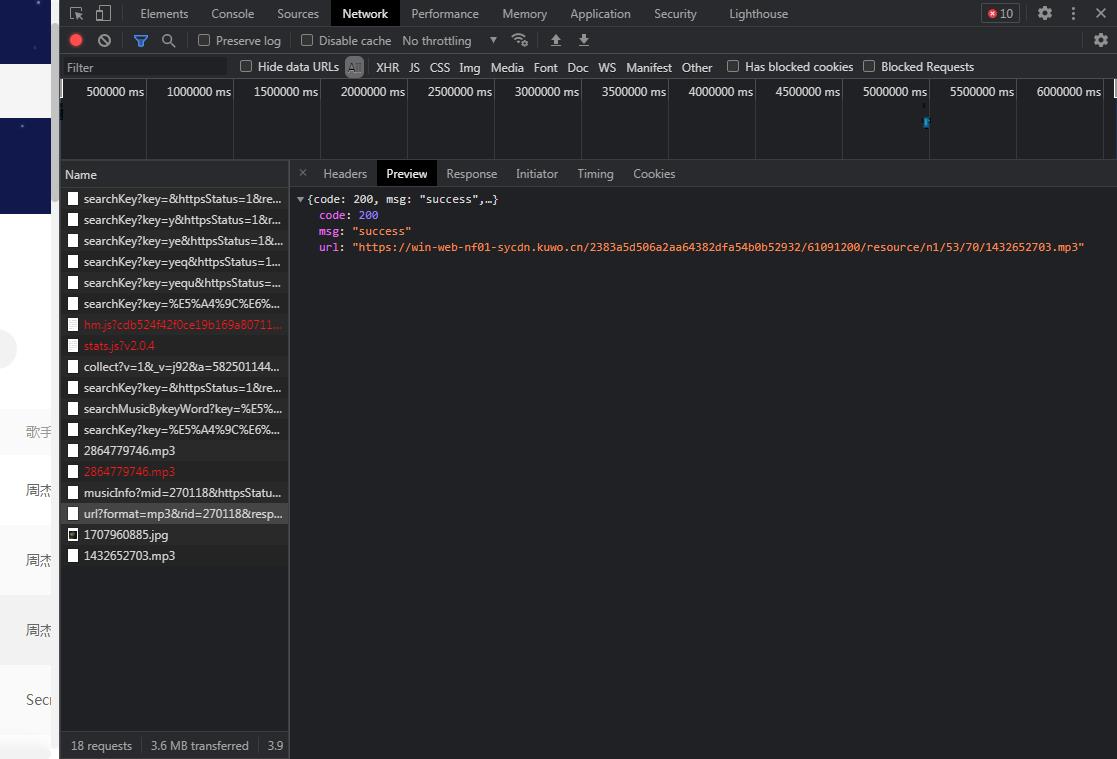

首先选定一首音乐,在列表里找到它的 id(就在上面列表中)。然后点击播放,这时候我们可以发现这边多了一个以 url 开头的文件,文件内容就是我们需要的链接:

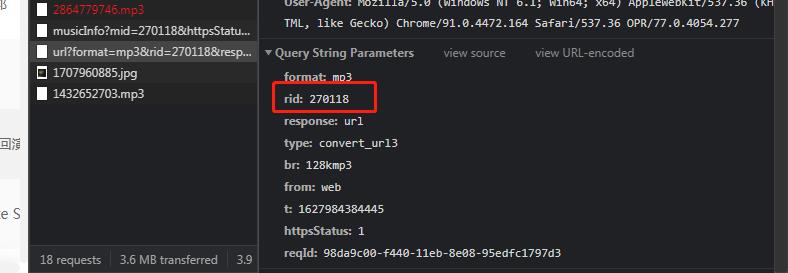

看它的 params:

照样用 get 方法,在 params 中的 rid 后放入音乐的 id,然后就能够获得该音乐的链接。再以这个链接为地址,发送一次 get 请求,获得它的二进制文件后写入本地的 mp3 文件,看下面:

用法2

这时候我们直接通过发送请求,来获取网页信息。

在上面我们已经获得了音乐的链接,进入链接地址进入网页:

这时候网页的内容就是音频文件。我们直接发送一个 get 请求来获取:

respond2 = requests.get(url='https://win-web-nf01-sycdn.kuwo.cn/2383a5d506a2aa64382dfa54b0b52932/61091200/resource/n1/53/70/1432652703.mp3')

mp3 = respond2.content # 获取二进制文件

然后写入本地 mp3 文件:

with open ('夜曲.mp3','wb') as i:

i.write(mp3)

打开就能够顺利播放。大功告成!

成功爬取酷我音乐!

the End

这篇文章就到这里了,点个赞支持一下吧!

本文收录于专栏:Python爬虫

关注作者,持续阅读作者的文章,学习更多Python知识!

https://blog.csdn.net/weixin_52132159

2021/8/3

推荐阅读

- Python爬虫 | 爬取b站北京奥运会开幕式弹幕,有多少人从东京奥运会跑过来的?

- 绝密!Python爬虫告诉你刷分机器人背后的原理!这篇文章差点没过审

- Python每天一道题:昆虫繁殖问题?我把密密麻麻的幼虫和成虫搞定了

- Python爬虫从0到1 | 入门实战:360翻译 ——requests库之POST方法(新手必看,保姆级别教学)

- 没想到我连五年级的题目都解不出来?可不能被人小看,让万能的Python登场

- Python:程序猿怎么追女生?教你短短几行代码表白,告别表白尴尬!

- 想学Python不知从何入手?学习Python必备秘籍,附地址,速拿!

- Python标准库:datetime 时间和日期模块 —— 时间的获取和操作详解

以上是关于Python爬虫从0到1 | 爬取酷我音乐信息并下载 ——requests库之GET方法(能省钱!!!)的主要内容,如果未能解决你的问题,请参考以下文章