2020小迪培训(第10天 信息收集-资产监控拓展)

Posted 是阿明呐

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了2020小迪培训(第10天 信息收集-资产监控拓展)相关的知识,希望对你有一定的参考价值。

信息收集-资产监控拓展

Github 监控

-

便于收集整理最新 exp 或 poc

-

便于发现相关测试目标的资产

-

如何使用(为什么用这个技术?一是官方的ctms是需要收费的,我们可以通过监控github来找到类似的源码,二是在github官网上有着最新的检测漏洞报告)

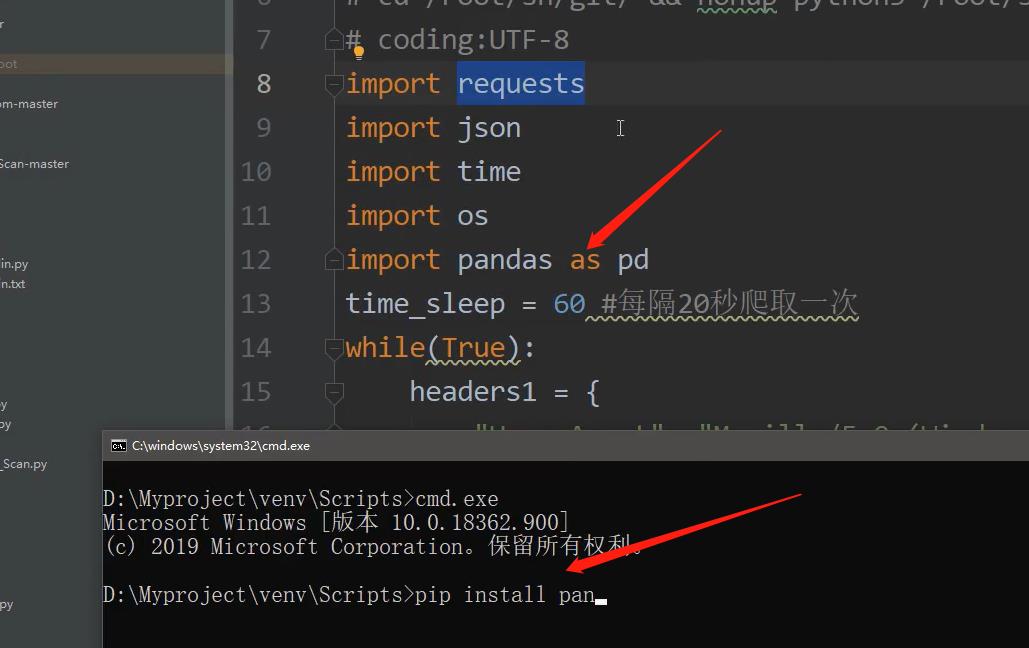

- 首先将下面的内部接口放在 PyCharm中,安装所对应的脚本所需的库,即import后面的东西

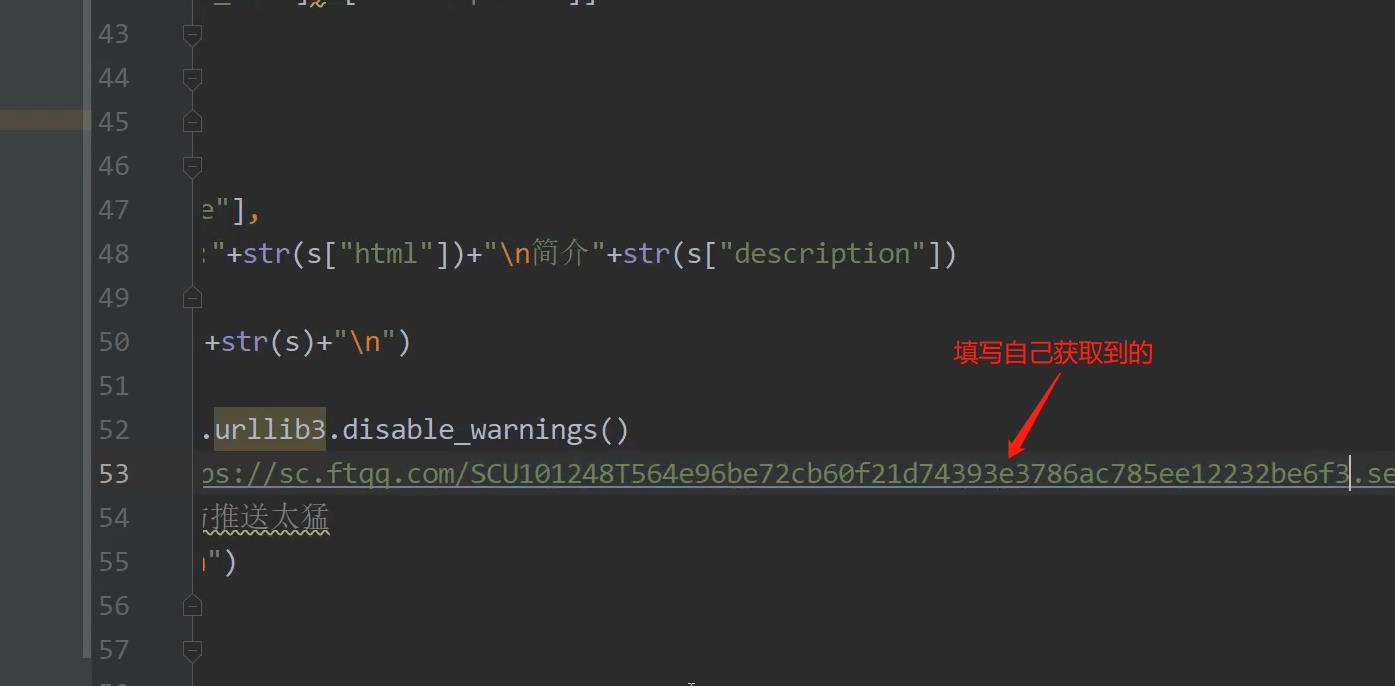

- 接着在github注册、在https://sct.ftqq.com/ 微信登录后获取SendKey,在脚本中进行更改

- 绑定微信,运行脚本,就可以获取到监控的内容,以下是监控内容的填写位置

- 网站只能绑定企业微信,不能做到手机上也收到推送,后续继续处理这个问题

- 首先将下面的内部接口放在 PyCharm中,安装所对应的脚本所需的库,即import后面的东西

各种子域名查询

DNS,备案,证书

全球节点请求 cdn

枚举爆破或解析子域名对应

便于发现管理员相关的注册信息

黑暗引擎相关搜索fofa,shodan,zoomeye

微信公众号接口获取

内部群内部应用内部接口

# Title: wechat push CVE-2020

# Date: 2020-5-9

# Exploit Author: weixiao9188

# Version: 4.0

# Tested on: Linux,windows

# cd /root/sh/git/ && nohup python3 /root/sh/git/git.py &

# coding:UTF-8

import requests

import json

import time

import os

import pandas as pd

time_sleep = 60 #每隔 20 秒爬取一次

while(True):

headers1 = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (Khtml, like Gecko)

Chrome/70.0.3538.25 Safari/537.36 Core/1.70.3741.400 QQBrowser/10.5.3863.400"}

#判断文件是否存在

datas = []

response1=None

response2=None

if os.path.exists("olddata.csv"):

#如果文件存在则每次爬取 10 个

df = pd.read_csv("olddata.csv", header=None)

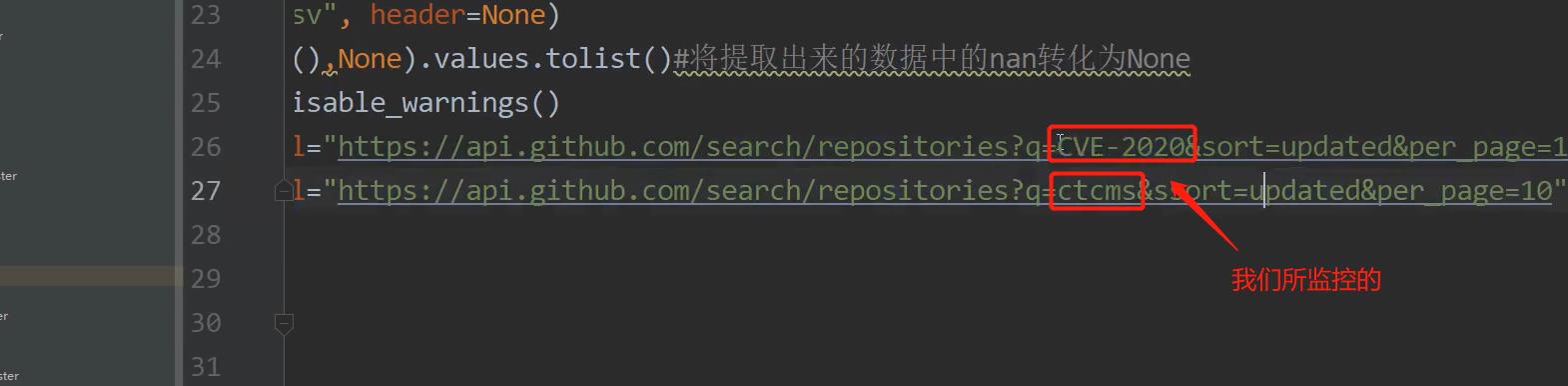

datas = df.where(df.notnull(),None).values.tolist()#将提取出来的数据中的 nan 转化为 None

requests.packages.urllib3.disable_warnings()

response1 = requests.get(url="https://api.github.com/search/repositories?q=CVE-

2020&sort=updated&per_page=10",headers=headers1,verify=False)

response2 =

requests.get(url="https://api.github.com/search/repositories?q=RCE&ssort=updated&per_page=10",hea

ders=headers1,verify=False)

else:

#不存在爬取全部

datas = []

requests.packages.urllib3.disable_warnings()

response1 = requests.get(url="https://api.github.com/search/repositories?q=CVE-2020&sort=updated&order=desc",headers=headers1,verify=False)

response2 =

requests.get(url="https://api.github.com/search/repositories?q=ctcms&ssort=updated&order=desc",headers=headers1,verify=False)

data1 = json.loads(response1.text)

data2 = json.loads(response2.text)

for j in [data1["items"],data2["items"]]:

for i in j:

s = {"name":i['name'],"html":i['html_url'],"description":i['description']}

s1 =[i['name'],i['html_url'],i['description']]

if s1 not in datas:

#print(s1)

#print(datas)

params={

"text":s["name"],

"desp":"链接:"+str(s["html"])+"\\n简介"+str(s["description"])

}

print("当前推送为"+str(s)+"\\n")

#print(params)

request.packages.urllib3.disable_warnings()

request.get("https://sct.ftqq.com/SendKey填写处.send", params=params,headers=headers1,timeout=10,verify=False)

time.sleep(1)#以防推送太快

print("推送成功!\\n")

datas.append(s1)

else:

pass

print("数据已经存在!")

pd.DataFrame(datas).to_csv("olddata.csv",header=Nonne,Index=None)

time.sleep(time_sleep)

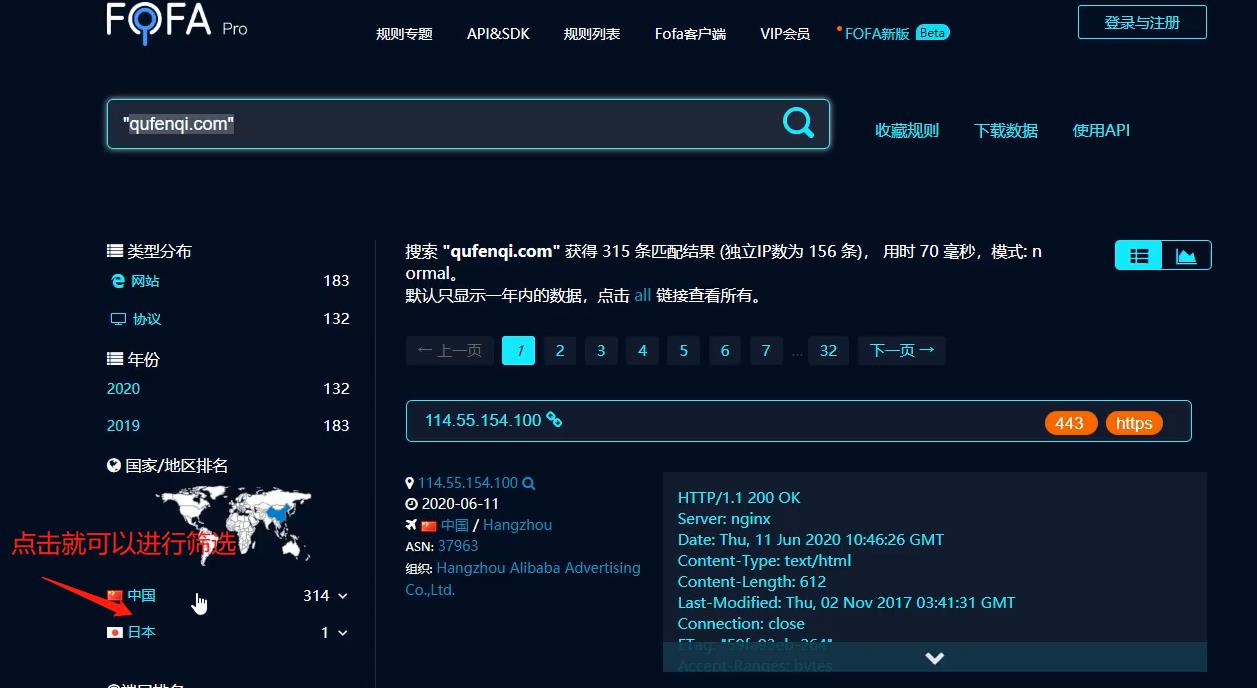

黑暗引擎实现域名端口等收集

- https://fofa.so/

- https://www.shodan.io/

全自动域名收集枚举优秀脚本使用(teemo)

以xxxx为例,从标题,域名等收集

以xxxx为例,全自动脚本使用收集

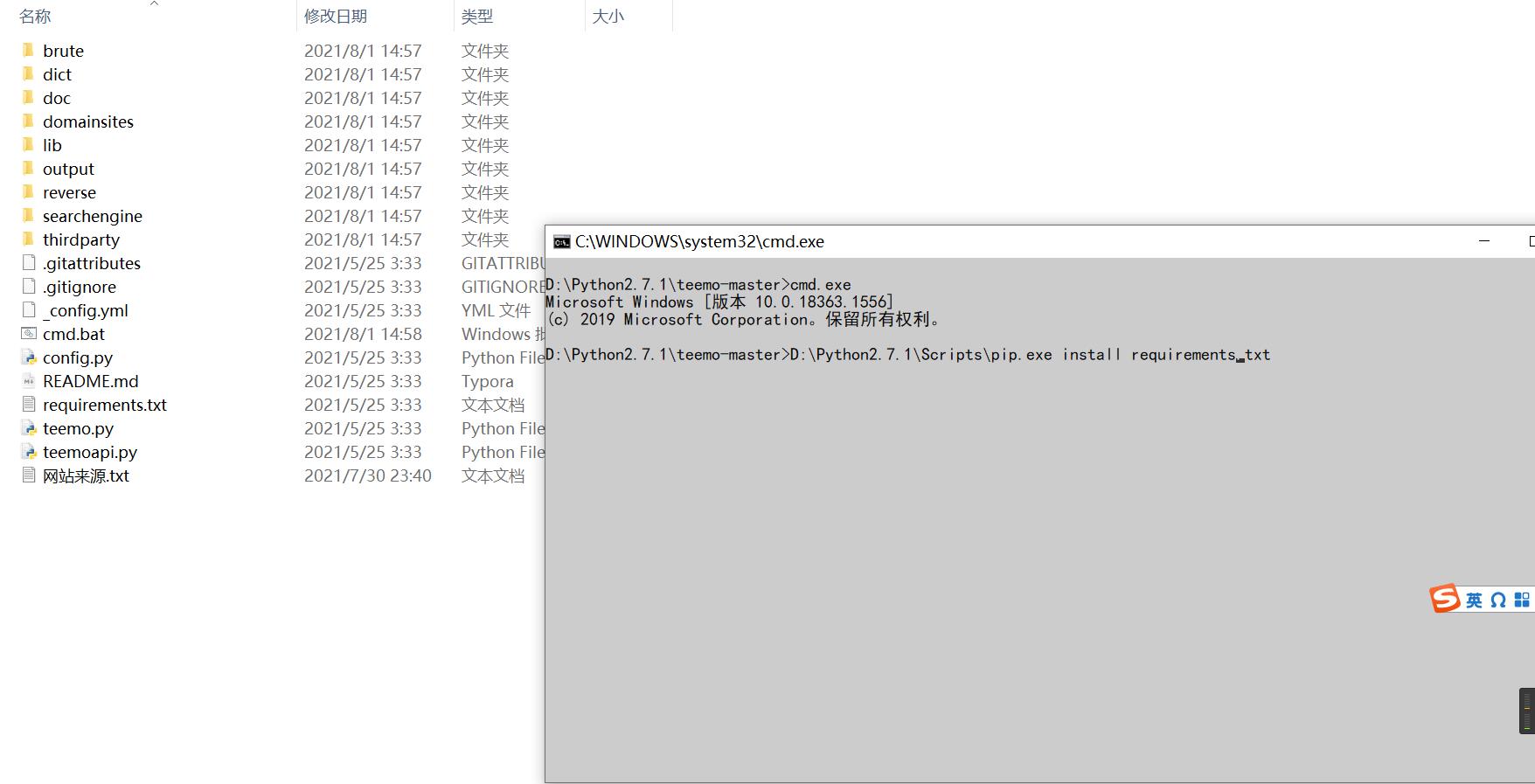

配置过程

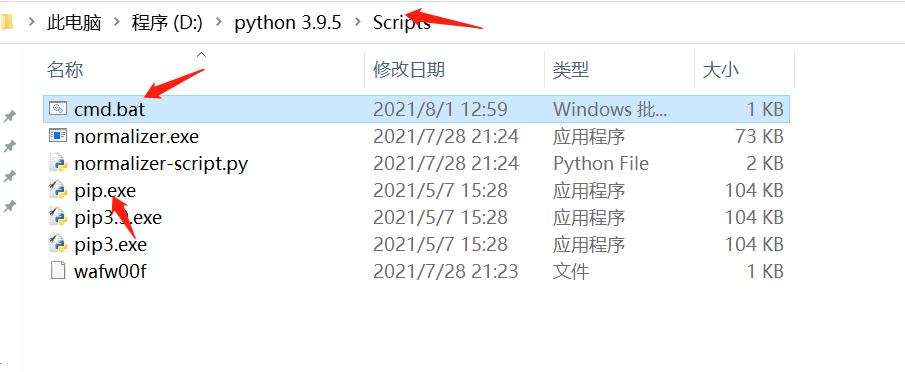

- 首先,我们需要在github下载后,解压文件后将文件放进python里面,然后在teemo这个文件下新建cmd.bat(里面的内容是cmd.exe)

- 接着我们找到python2(过期了?导致后续配置还未完成,以下截图来源小迪视频)中的script文件夹,将其中的pip.exe拉入命令行中,输入以下命令

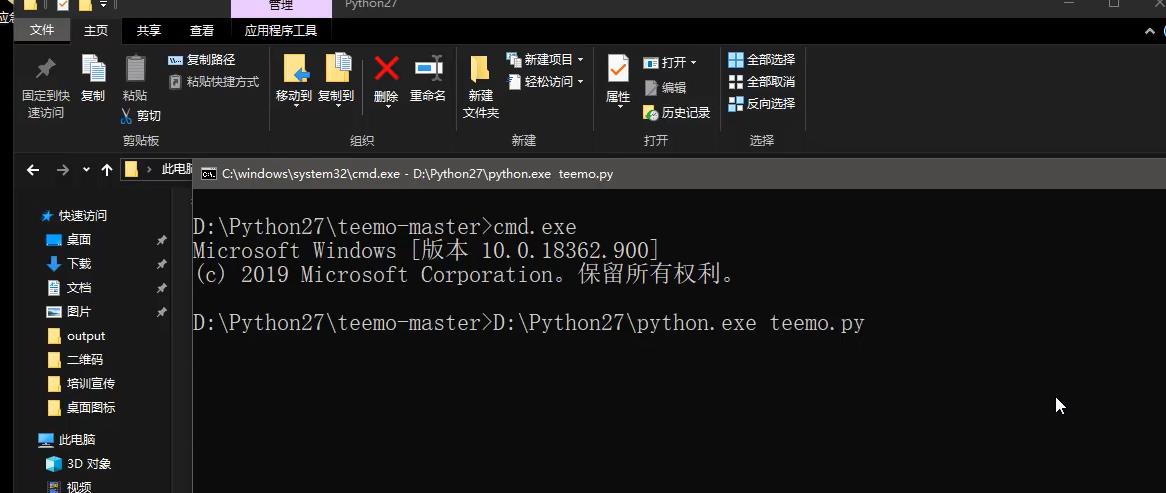

- 接着将python拖入命令行界面,输入以下命令,开启teemo

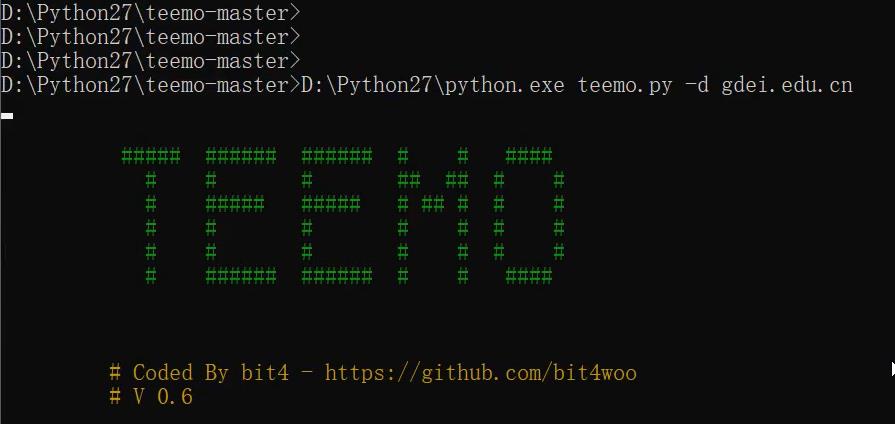

- 输入以下命令(-d + 域名),进行子域名查询

- 查询的结果放在以下文件夹中,以其名称命名

或使用layer子域名挖掘机直接进行扫描

SRC目标中的信息收集全覆盖

补天上专属SRC简易测试

利用其他第三方接口获取更多信息

涉及资源

https://crt.sh/ (查网站证书的)

https://sct.ftqq.com/

https://dnsdb.io/zh-cn/ (详细的DNS解析记录)

https://sct.ftqq.com/3.version

https://tools.ipip.net/cdn.php (国外访问国内地址获取网站真实IP地址,之前cdn的知识)

https://github.com/bit4woo/teemo

https://securitytrails.com/domain/www.baidu.com/history/a (详细的DNS解析记录)

https://www.opengps.cn/Data/IP/LocHighAcc.aspx (IP地址定位)

前cdn的知识)

https://github.com/bit4woo/teemo

https://securitytrails.com/domain/www.baidu.com/history/a (详细的DNS解析记录)

https://www.opengps.cn/Data/IP/LocHighAcc.aspx (IP地址定位)

最后感谢小迪师傅的视频!!

笔记来源视频:点击这里

以上是关于2020小迪培训(第10天 信息收集-资产监控拓展)的主要内容,如果未能解决你的问题,请参考以下文章