Docker-----三剑客:machinecomposeswarm 及Docker集群管理

Posted S4061222

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Docker-----三剑客:machinecomposeswarm 及Docker集群管理相关的知识,希望对你有一定的参考价值。

doceker-machine解决docker运行环境的问题

docker-compose解决容器编排的问题

docker-swarm解决多主机多个容器的部署调度的问题

一 docker-machine

1.简介

Docker Machine 是 Docker 官方编排(Orchestration)项目之一,负责在多种平台上快速安装 Docker环境。

Docker Machine支持在常规Linux操作系统、虚拟化平台、openstack、公有云等不同环境下安装配置docker host。

Docker Machine 项目基于 Go 语言实现,目前在 Github 上的维护地址:

https://github.com/docker/machine/

2. docker machine实践

实验环境:

server1: 172.25.28.1(之前的实验中已存在)

server2: 172.25.28.2(之前的实验中已存在)

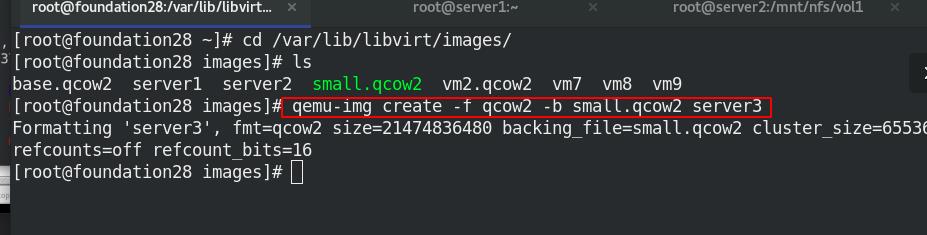

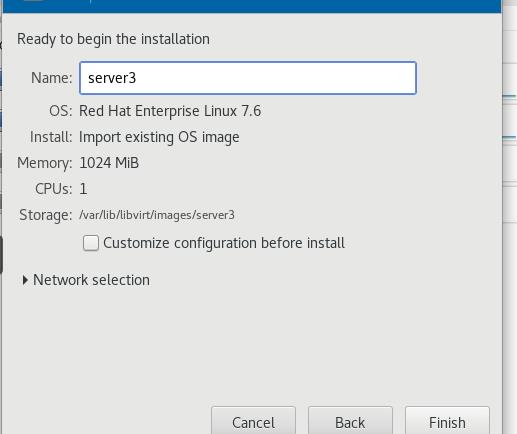

server3: 172.25.28.3(新建)

2.1docker Machine安装

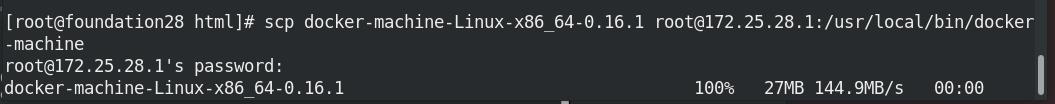

下载好docker-machine-Linux-x86_64-0.16.1包,server1安装docker-machine

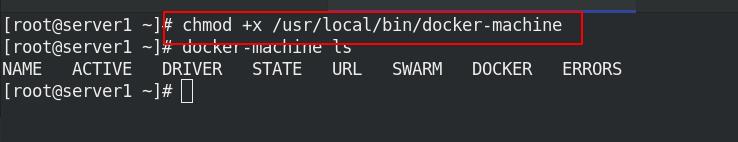

将docker-machine-Linux-x86_64-0.16.1移动到/usr/local/bin/下,修改名臣为docker-machine,赋予执行权限(二进制文件)

mv docker-machine-Linux-x86_64-0.16.1 /usr/local/bin/docker-machine

chmod +x /usr/local/bin/docker-machine

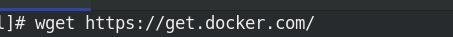

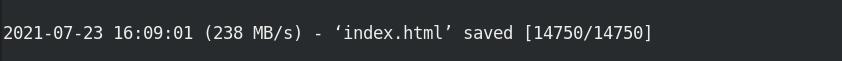

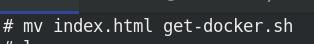

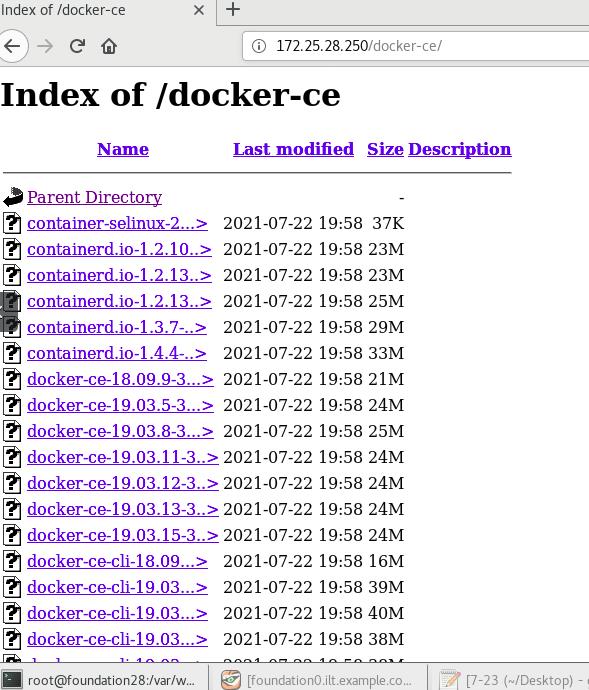

真机上,下载get-docker脚本默认发布目录下,会产生index.html文件,修改名为get-docker.sh

wget https://get.docker.com/

mv index.html get-docker.sh

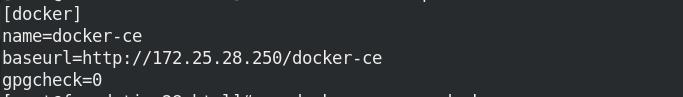

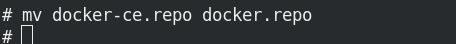

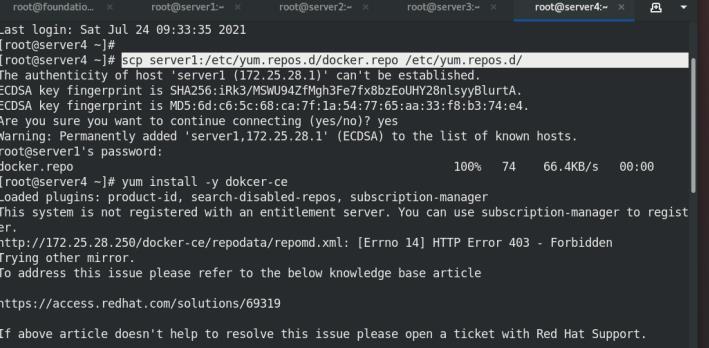

server1的仓库文件名为docker.repo

网站访问进行测试:

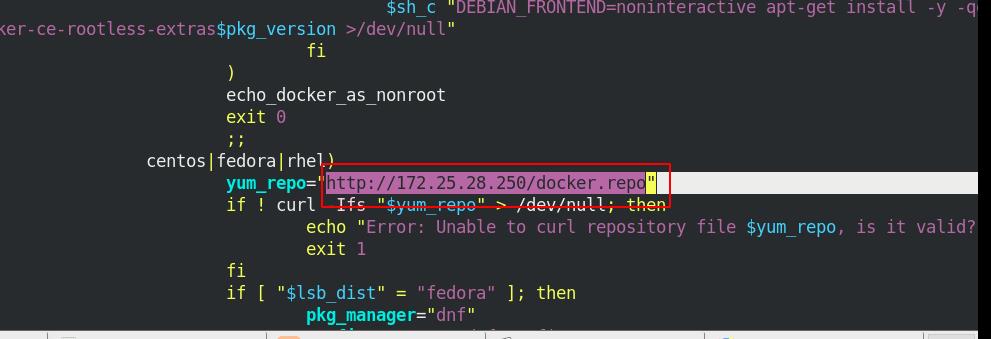

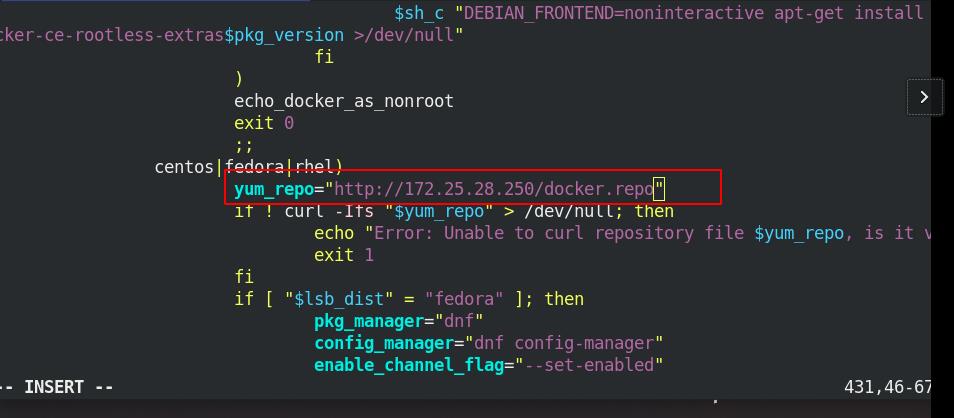

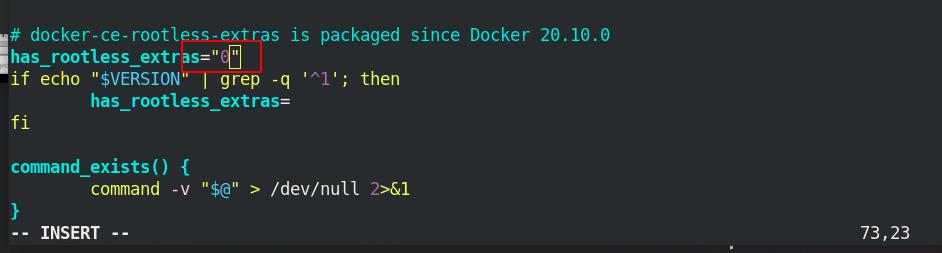

server1中修改get-docker.sh文件中的内容,修改docker仓库指向

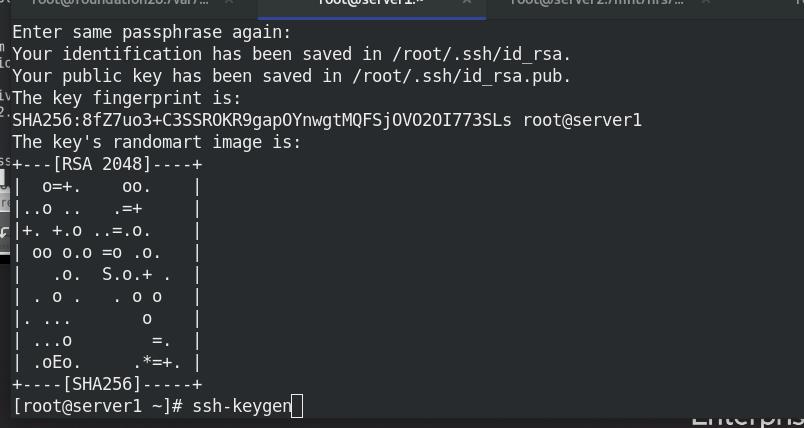

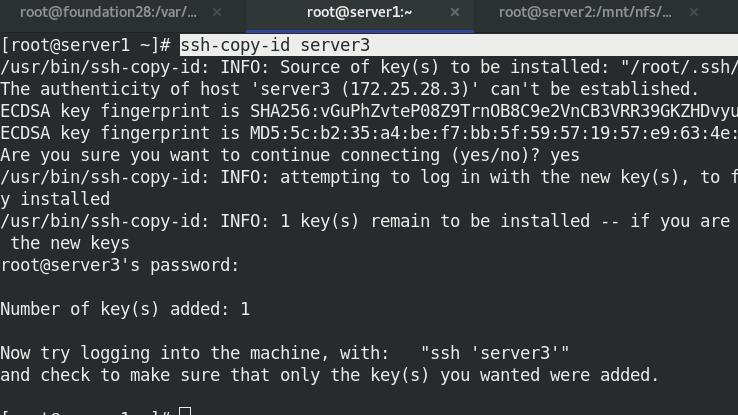

server1登陆server3进行免密认证

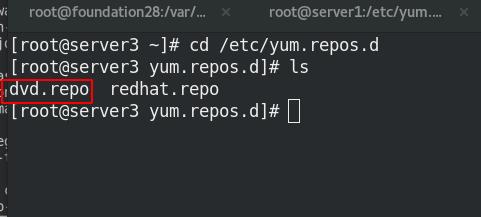

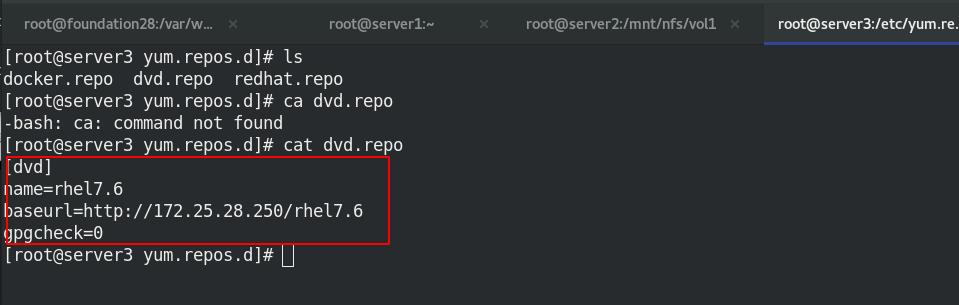

server3配置docker仓库

使用get-docker.sh脚本为ip是给server3安装docker

保证server3上有docker.repo文件

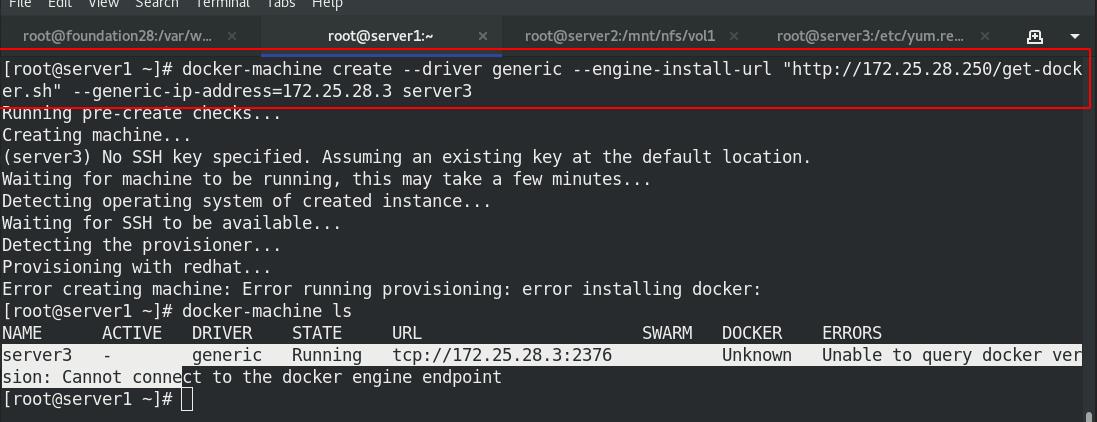

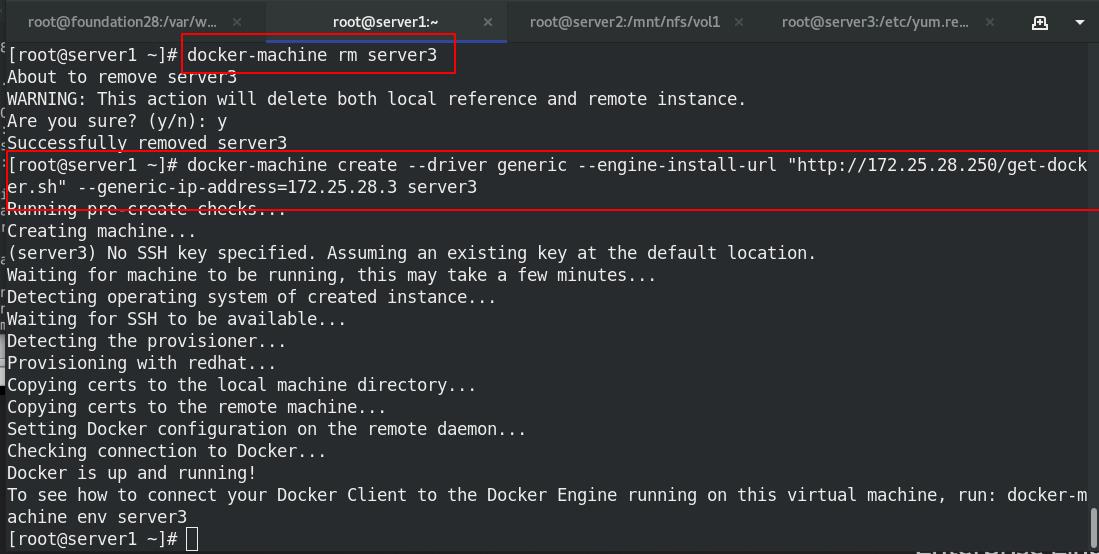

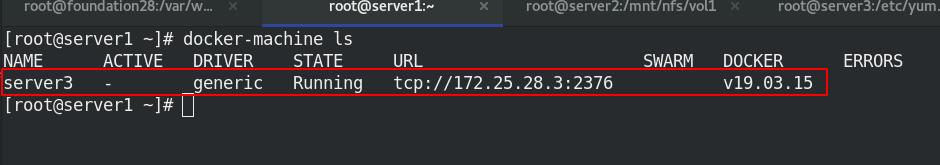

server1使用create创建

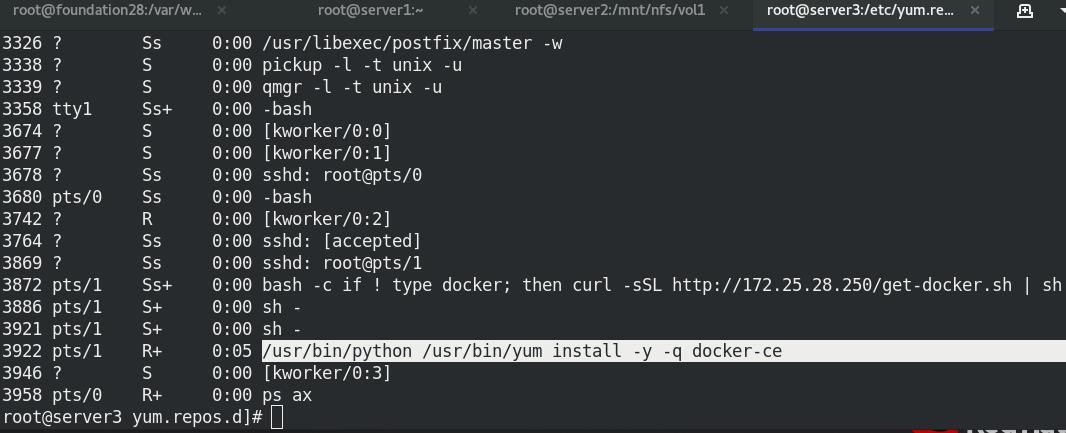

列出所有docker-machine的操作进程

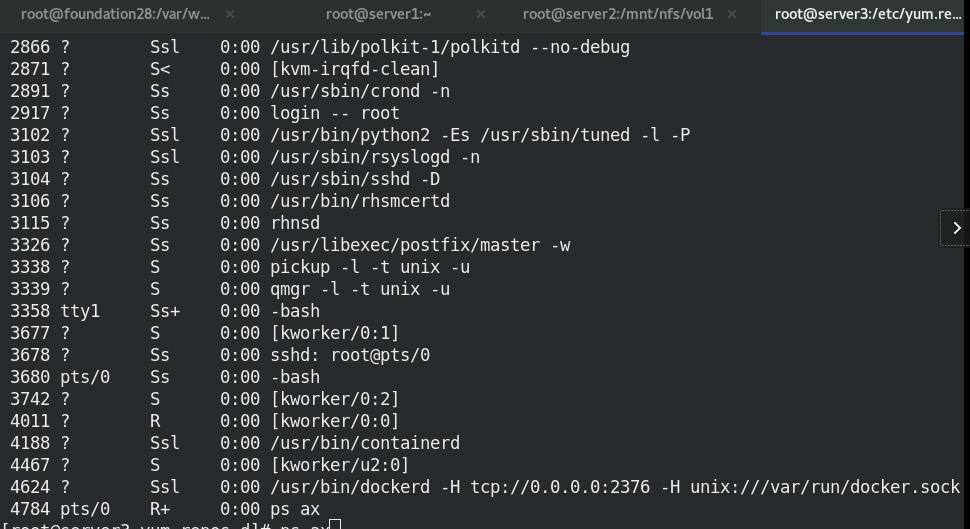

server3上ps ax查看到已经有执行动作了

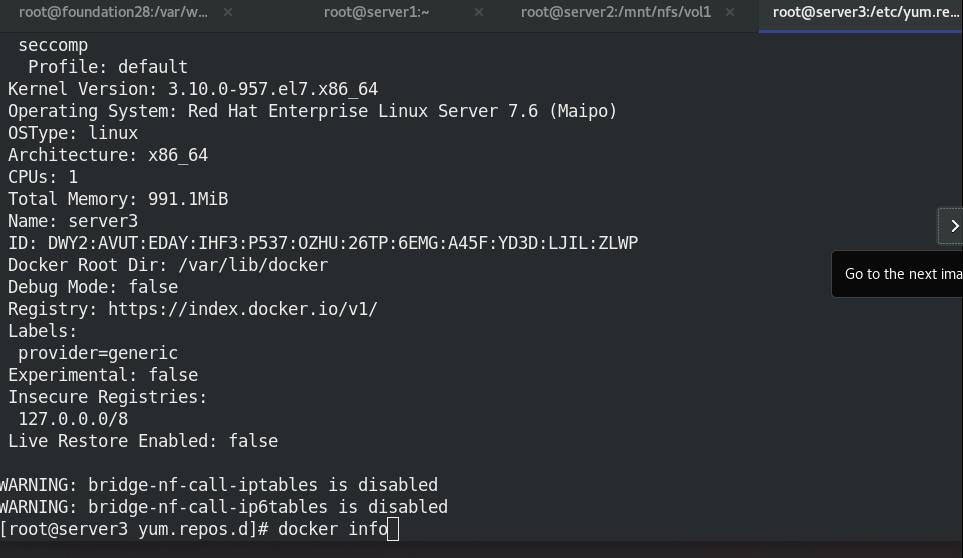

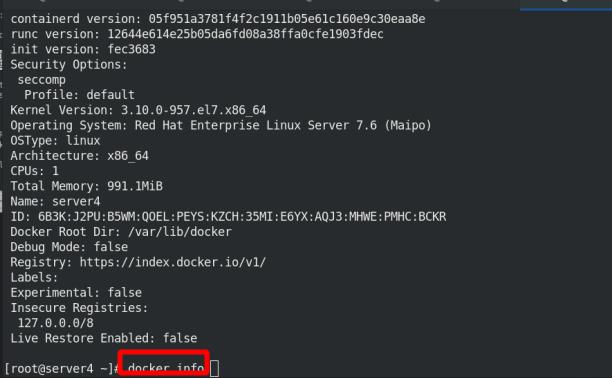

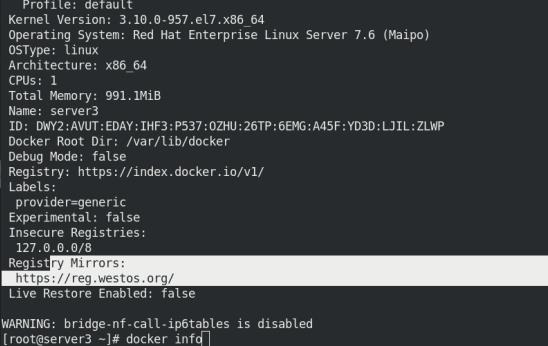

docker info的warning报错的解决方法:

vim /etc/sysctl.conf

net.bridge.bridge-nf-call-iptables = 1

net.bridge.bridge-nf-call-ip6tables = 1

sysctrl --system

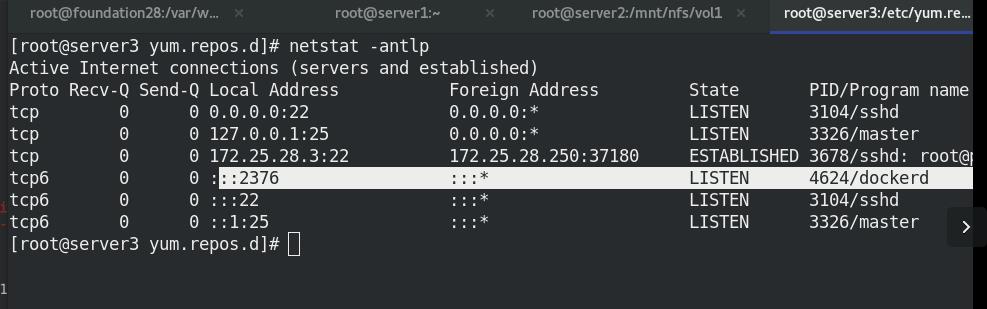

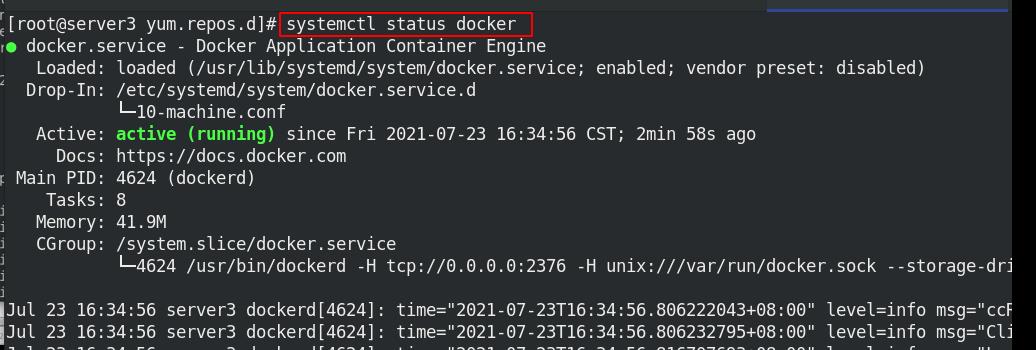

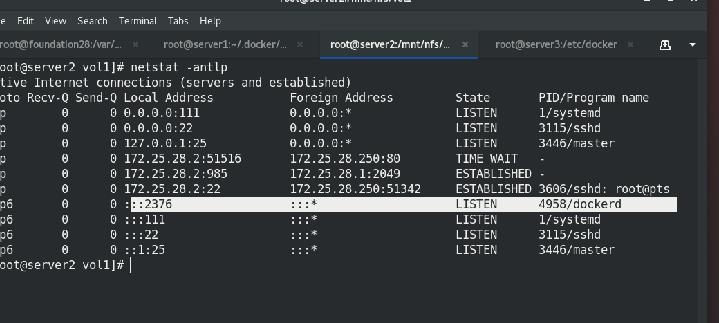

server3查看2376端口已开放

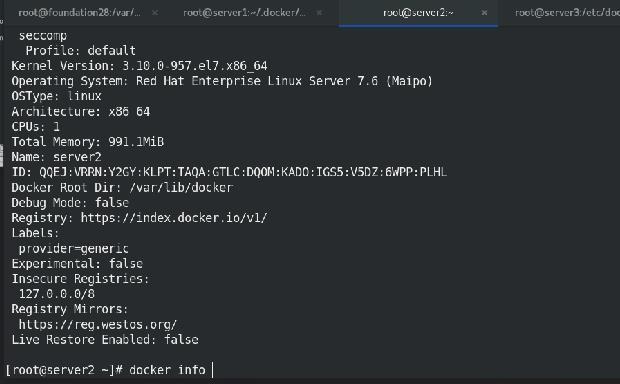

查看docker状态

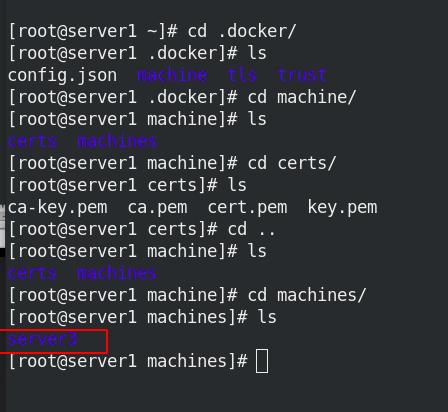

可以看到server1中有server3的证书

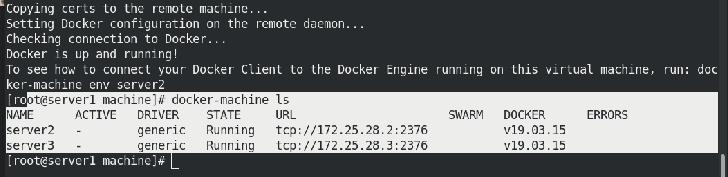

server2需要安装的话,与server3的操作相同

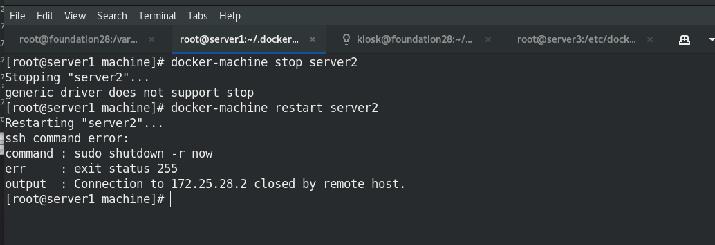

server1上关闭后启动server2的docker-machine

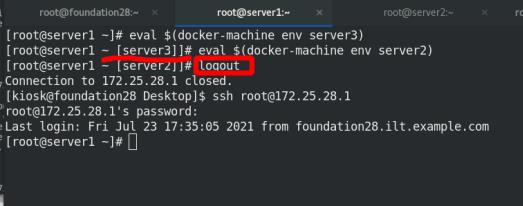

2.2 远程登陆及优化

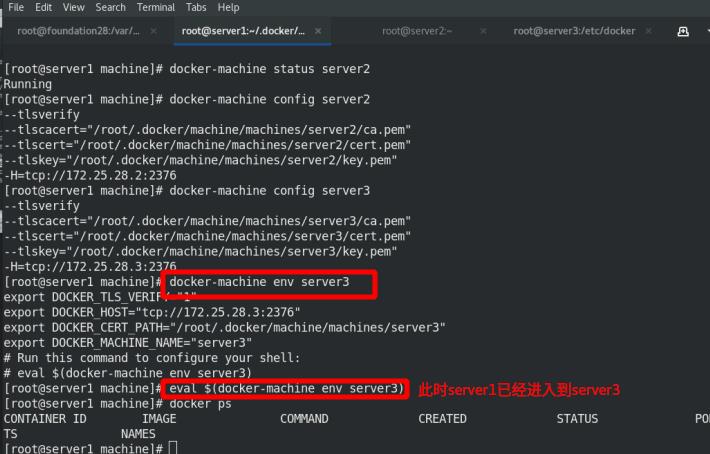

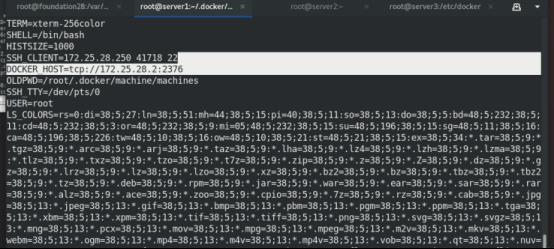

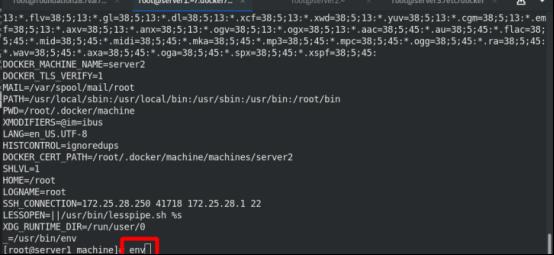

访问server3所需的环境变量

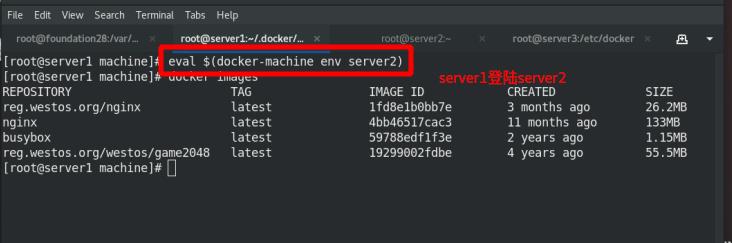

需要logout后,访问server2所需的环境变量

env可以查看到server1进去的那台主机

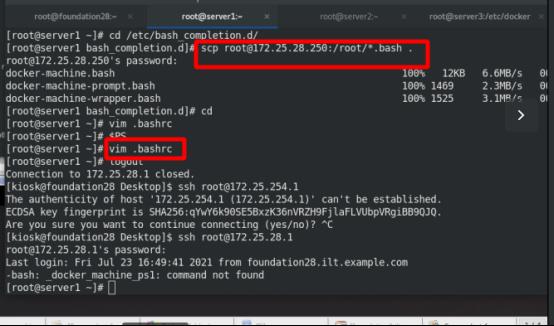

优化

下载需要的bash文件

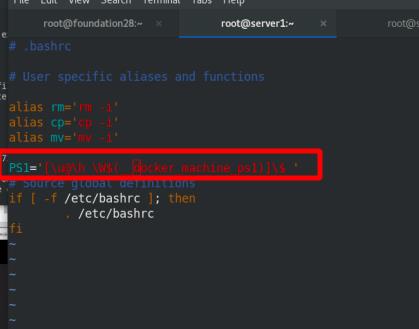

修改环境变量,显示进入的docker主机名称

此时会有行提示符,必须logout重新登陆

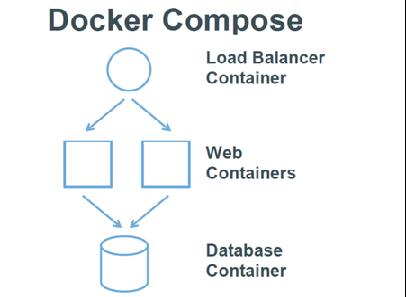

二 docker-compose

1. docker-compose简介

(1)微服务架构的应用系统一般包含若干个微服务,每个微服务一般都会部署多个实例,如果每个微服务都要手动启停,那么效率之低,维护量之大可想而知。

(2)Docker Compose是一种编排服务,基于pyhton语言实现,是一个用于在 Docker上定义并运行复杂应用的工具,可以让用户在集群中部署分布式应用。

(3)用户可以很容易地用一个配置文件定义一个多容器的应用,然后使用一条指令安装这个应用的所有依赖,完成构建。

(4)解决了容器与容器之间如何管理编排的问题。

Docker Compose 中有两个重要的概念:

服务 (service) :一个应用的容器,实际上可以包括若干运行相同镜像的容器实例。

项目 (project) :由一组关联的应用容器组成的一个完整业务单元,在 docker-compose.yml 文件中定义。

2.docker-compose实践( docker-compose配置haproxy+nginx负载均衡)

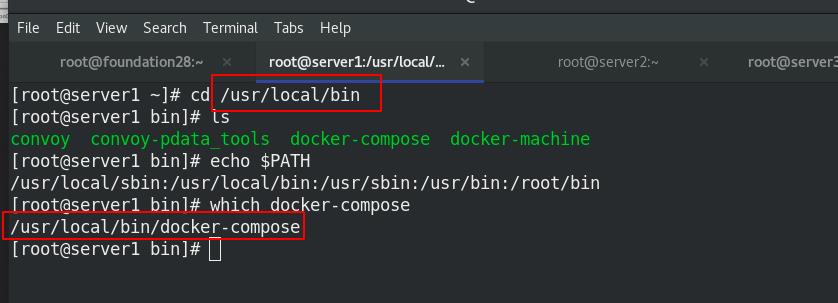

直接使用docker-compose指令来操作,需要在系统的/usr/local/bin目录下有compose的二进制文件!因为用户在命令行输入命令后,系统会在环境变量$PATH内找命令。(与docker-machine类似)

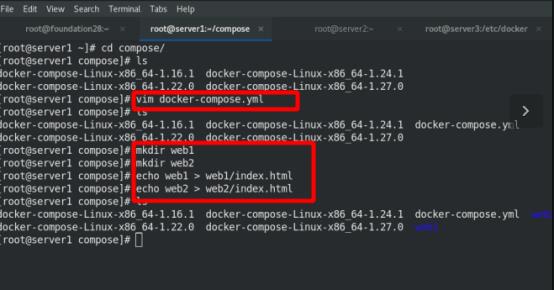

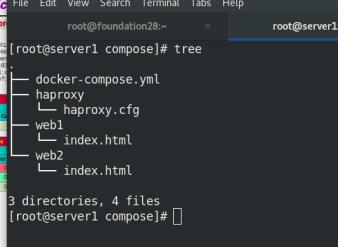

家目录下创建compose目录,编写主配置文件docker-compose.yml,docker-compose在up的时候会自动读取;

在当前路径下创建web1,web2目录,修改默认发布文件内容

Image:指定为镜像名称或镜像 ID,如果镜像在本地不存在,Compose 将会尝试拉取这个镜像

Build:指定 Dockerfile 所在文件夹的路径。 Compose 将会利用它自动构建这个镜像,然后使用这个镜像

Command:覆盖容器启动后默认执行的命令

Links:链接到其它服务中的容器

Ports:端口映射

Expose::暴露端口信息

Volumes:卷挂载路径设置

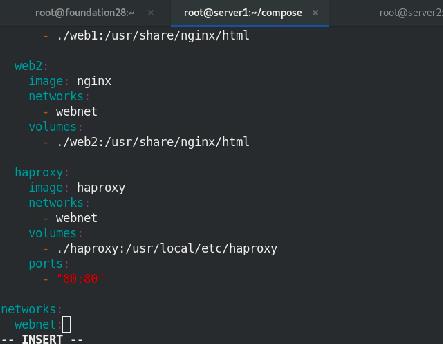

内容如下:

version: "3.8"

services:

web1:

image: nginx

networks:

- webnet

volumes:

- ./web1:/usr/share/nginx/html

web2:

image: nginx

networks:

- webnet

volumes:

- ./web2:/usr/share/nginx/html

haproxy:

image: haproxy

networks:

- webnet

volumes:

- ./haproxy:/usr/local/etc/haproxy

ports:

- "80:80"

networks:

webnet:

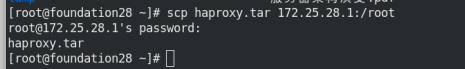

下载haproxy镜像

本地方式导入haproxy镜像

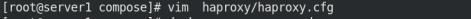

创建haproxy目录并编辑修改haproxy.cfg的主配置文件

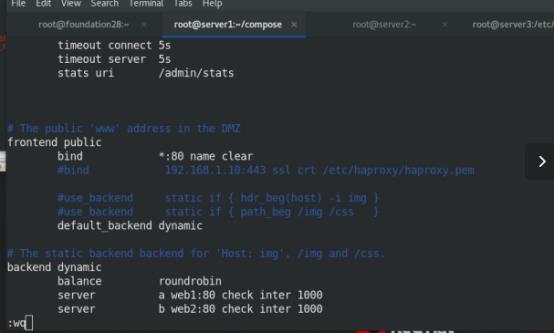

内容如下:

global

maxconn 65535

stats socket /var/run/haproxy.stat mode 600 level admin

log 127.0.0.1 local0

uid 200

gid 200

daemon

defaults

mode http

log global

option httplog

option dontlognull

monitor-uri /monitoruri

maxconn 8000

timeout client 30s

retries 2

option redispatch

timeout connect 5s

timeout server 5s

stats uri /admin/stats

# The public 'www' address in the DMZ

frontend public

bind *:80 name clear #监听所有ip的80端口

#bind 192.168.1.10:443 ssl crt /etc/haproxy/haproxy.pem

#use_backend static if { hdr_beg(host) -i img }

#use_backend static if { path_beg /img /css }

default_backend dynamic

# The static backend backend for 'Host: img', /img and /css.

backend dynamic

balance roundrobin

server a web1:80 check inter 1000

server b web2:80 check inter 1000

查看~/compose结构:tree

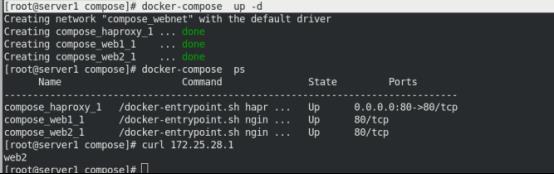

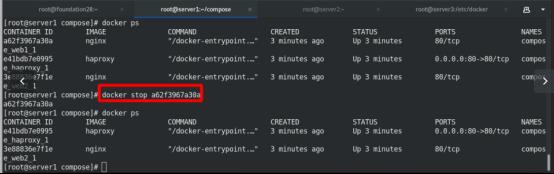

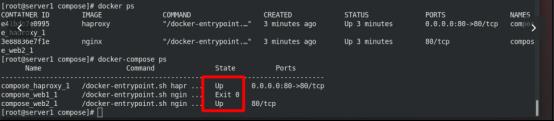

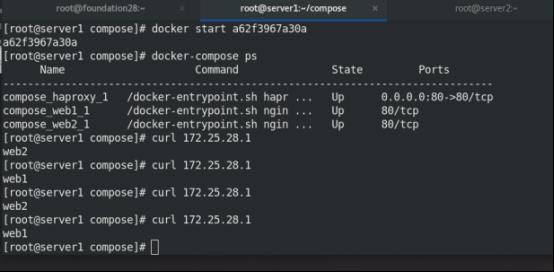

启动服务,-d打入后台,ps查看,发现都是up

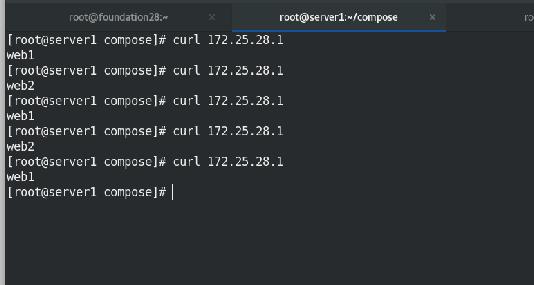

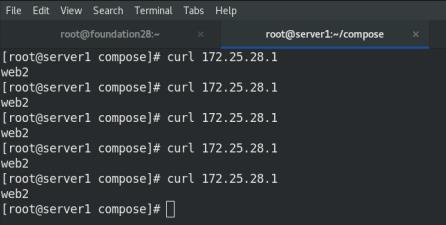

测试:

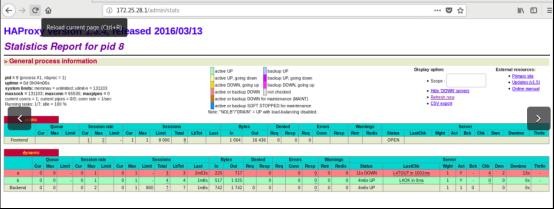

在网页或者在虚拟机上(实现负载均衡)

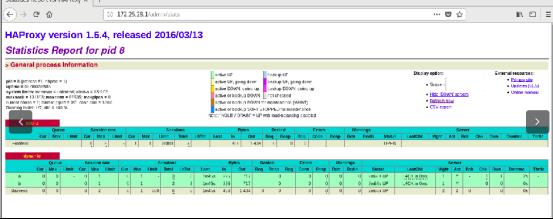

进行监控查看

停掉server1

恢复server1,又实现负载均衡

三 docker-swarm

1.docker swarm简介

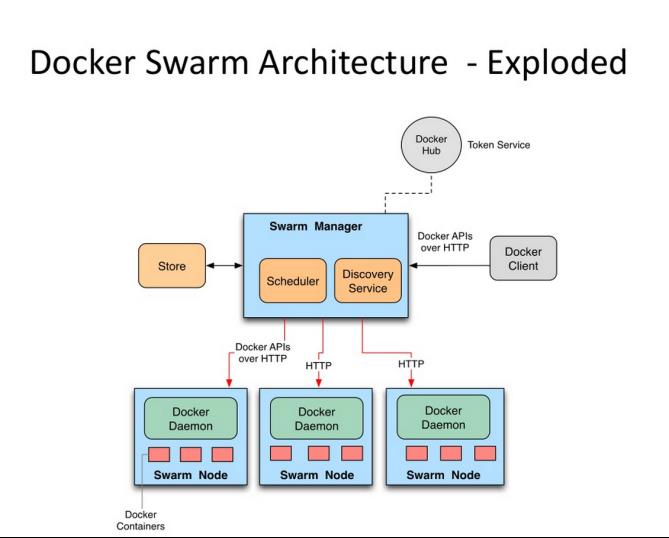

与docker捆绑,docker自带,内嵌(1.12版本后),多个dicker组建为集群,一种编排工具,Scheduler**为调度,单点,接收外部资源,仓库,docker的客户端。swarm在生产环境中缺乏一些东西,轻量级。

(1)Swarm 在 Docker 1.12 版本之前属于一个独立的项目,在 Docker 1.12 版本发布之后,该项目合并到了 Docker中,成为 Docker 的一个子命令。

(2)Swarm 是 Docker 社区提供的唯一一个原生支持 Docker 集群管理的工具。

(3)Swarm可以把多个 Docker 主机组成的系统转换为单一的虚拟 Docker 主机,使得容器可以组成跨主机的子网网络。

(4)Docker Swarm 是一个为 IT 运维团队提供集群和调度能力的编排工具。

Docker Swarm 优点:

任何规模都有高性能表现

灵活的容器调度

服务的持续可用性

和 Docker API 及整合支持的兼容性

Docker Swarm 为Docker 化应用的核心功能(诸如多主机网络和存储卷管理)提供原生支持。

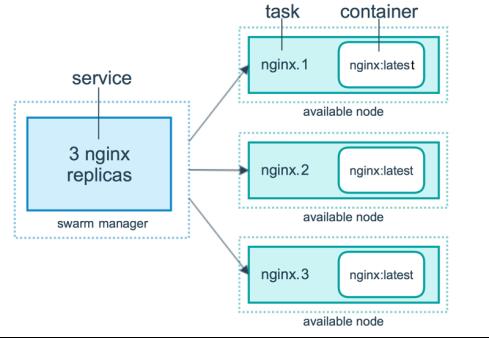

docker swarm 相关概念

节点分为管理 (manager) 节点和工作 (worker) 节点

任务 (Task)是 Swarm 中的最小的调度单位,目前来说就是一个单一的容器。

服务 (Services) 是指一组任务的集合,服务定义了任务的属性。

2.docker swarm实践

2.1 创建Swarm集群

实验环境:

四台虚拟机(server2,server3,servcer4为集群,server2集群中manager,server1有harbor仓库),让server1作调度,不参与节点部署

yum 源,免密,解析已经完成

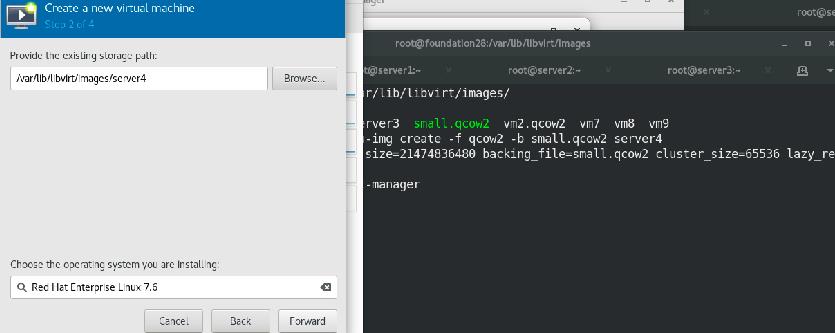

原有环境基础上,新建server4

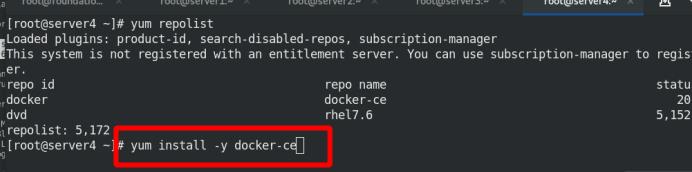

安装docker

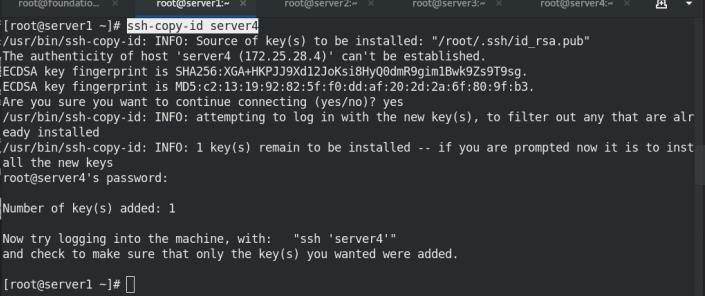

server1免密登陆server4

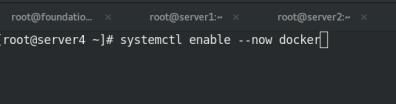

启动docker服务

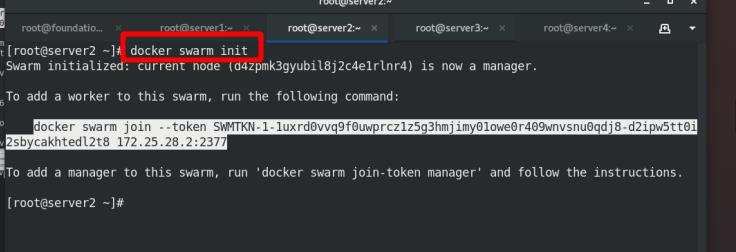

初始化server2,init:初始化集群

server3加入集群

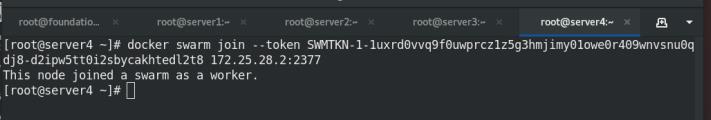

server4加入集群

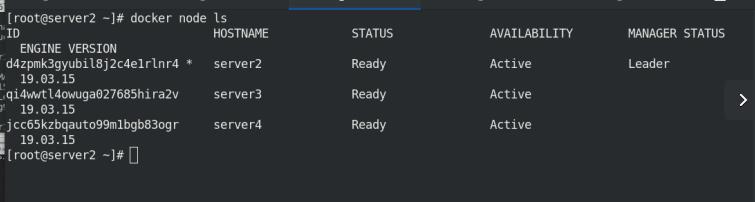

集群节点查看,server2为leader

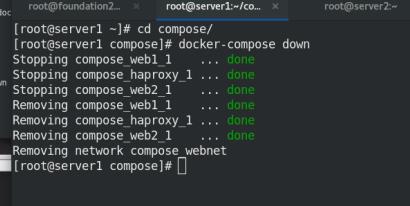

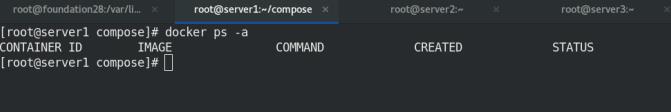

compose目录下,docker-compose down掉(上个实验中的环境)

docker ps -a 查看不到

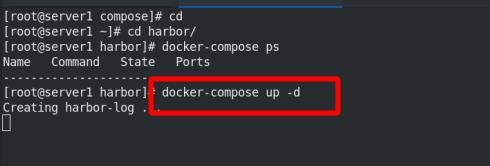

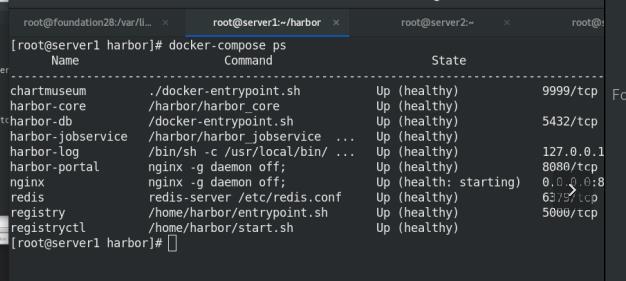

harbor目录下,docker-compose 启动,-d打入后台

docker-compose ps可以查看到全部up,启动成功

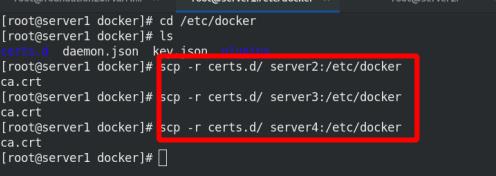

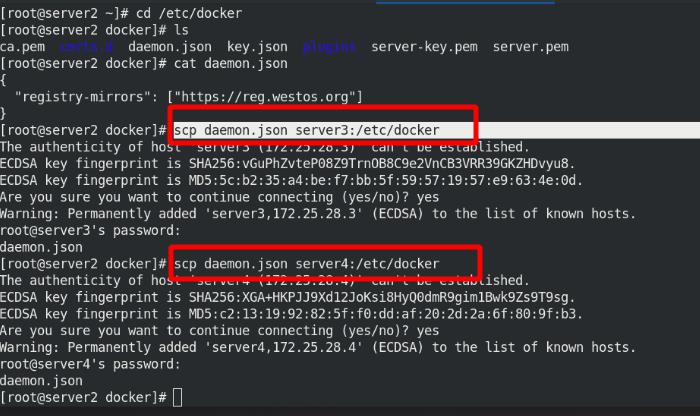

server2,3,4介入仓库(匿名只要证书)

server2,3,4可以访问到reg.westos.org仓库地址,需要在/etc/docker中写入daemon.json文件

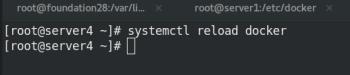

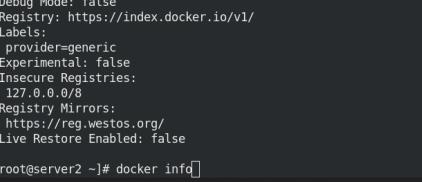

server2,3,4重启docker服务,查看仓库地址为reg.westos.org仓库

2.2 实现小规模集群负载均衡

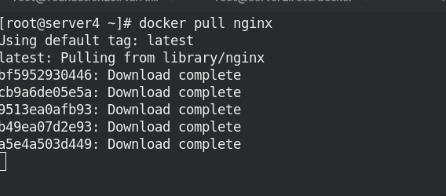

server4拉取景象nginx(从reg.westos.org仓库)

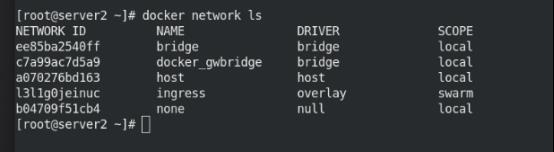

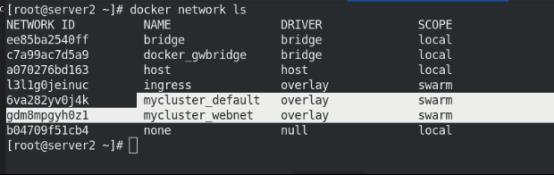

Server2网路查看有swarm

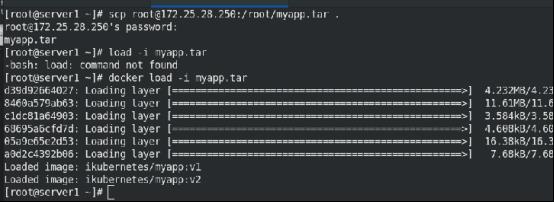

导入myapp.tar景象

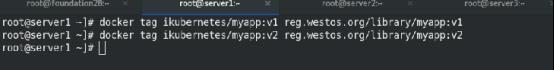

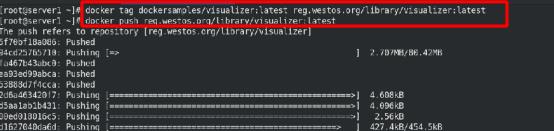

修改标签

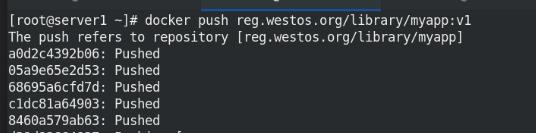

上传至reg.westos.org仓库(不加library也是默认至此项目)

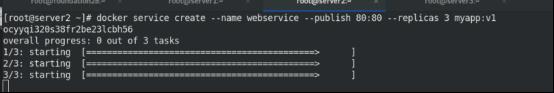

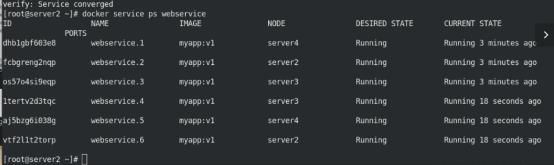

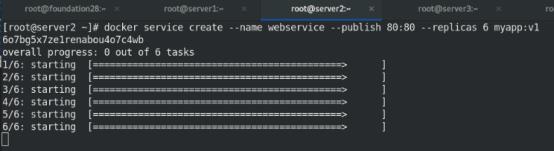

创建集群服务,名为webservice,端口映射80:80 ,开启三个节点, 镜像为myapp:v1

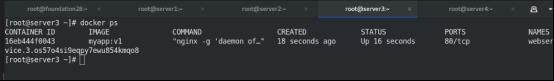

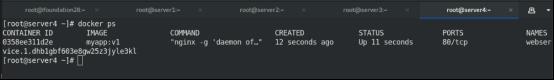

server2,3,4上分别查看

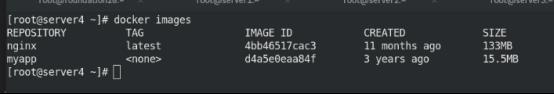

worker主机中查看镜像myapp已经pull到本地,此处无tag

查看集群节点服务,每个节点各1个,负载均衡

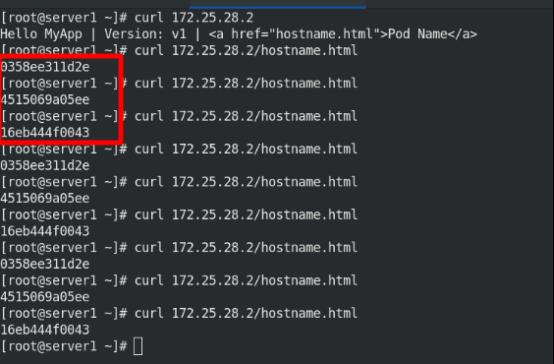

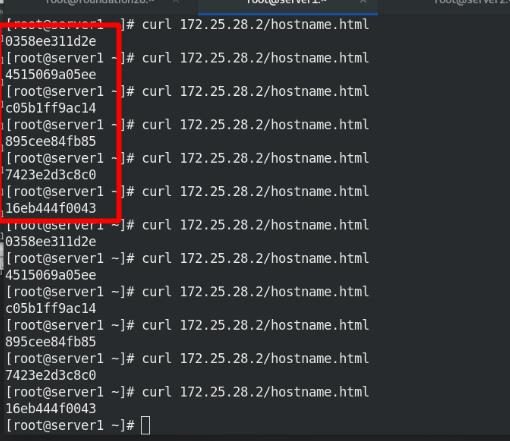

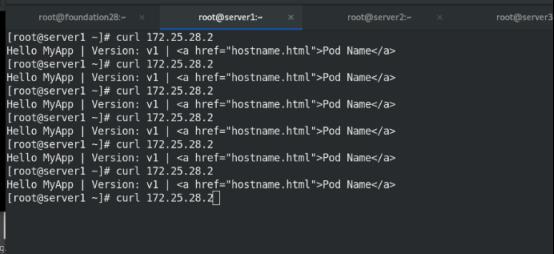

curl 172.25.28.2/hostname.html 可查看,已实现负载均衡,3个不同的节点

2.3 集群负载均衡的服务扩容

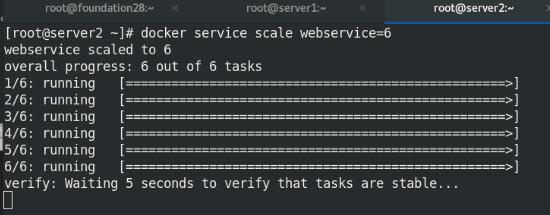

添加集群数量到6个

启动容器就是起来进程,只是起来容器,没有给流量

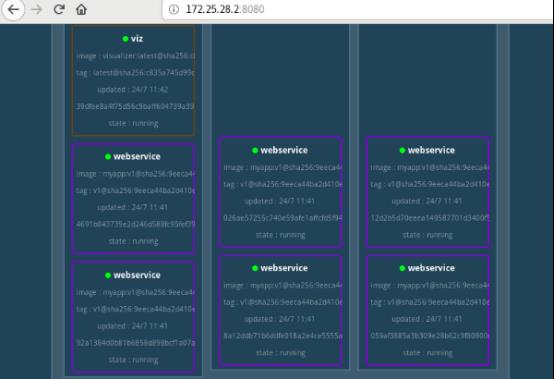

查看集群节点服务,3个节点各有2个容器,实现负载均衡

curl 172.25.28.2/hostname.html 可查看,已实现负载均衡,3个不同的节点,每个节点2个服务,公6个不同的id(采用算法为默认的rr轮询)

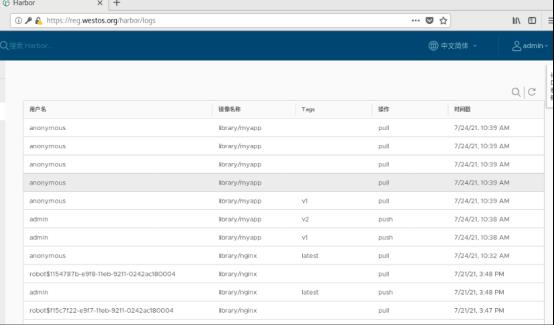

查看仓库中的拉取记录

仓库中景象查看

2.3 监控 + 更新景象版本

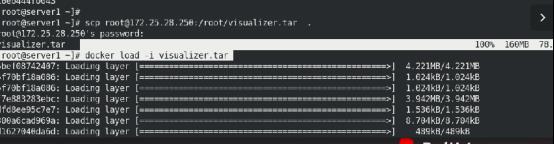

本地拉取监控景象

修改标签,上传至仓库

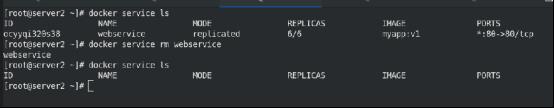

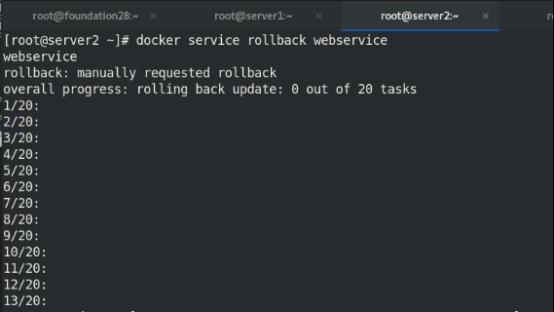

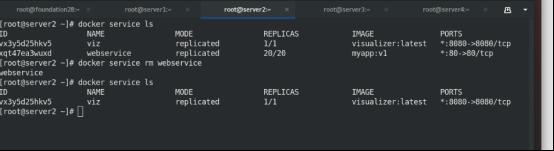

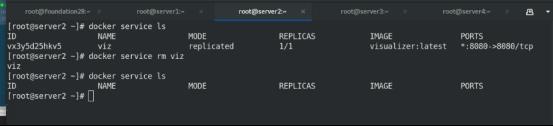

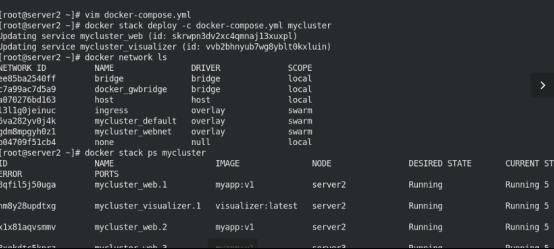

删除刚才的webservice集群服务

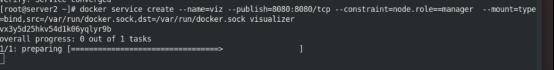

创建监控服务

创建webservice集群服务

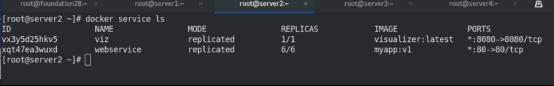

查看服务

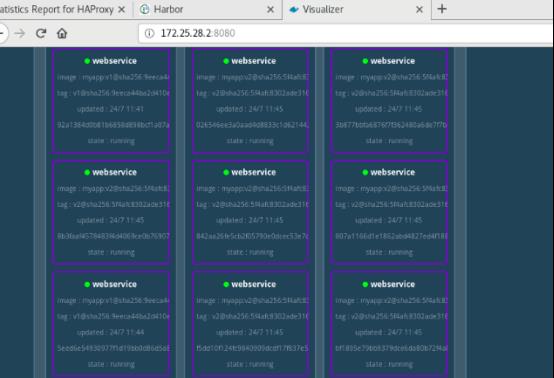

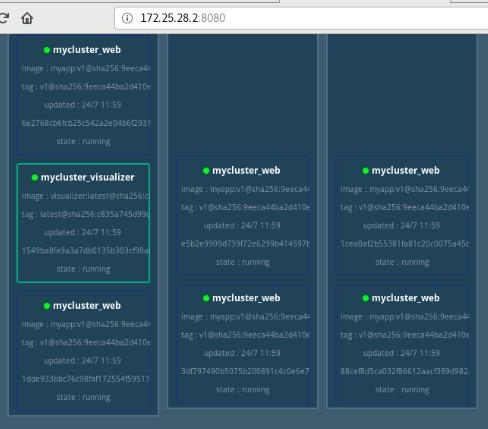

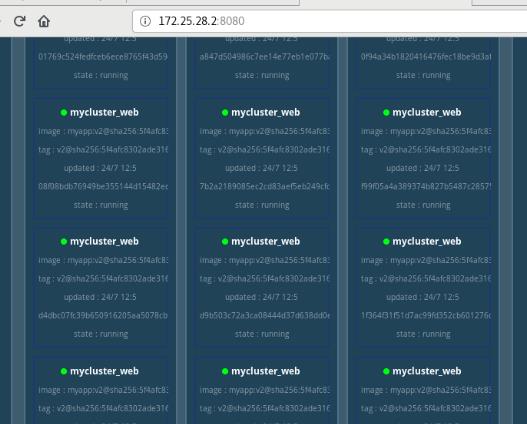

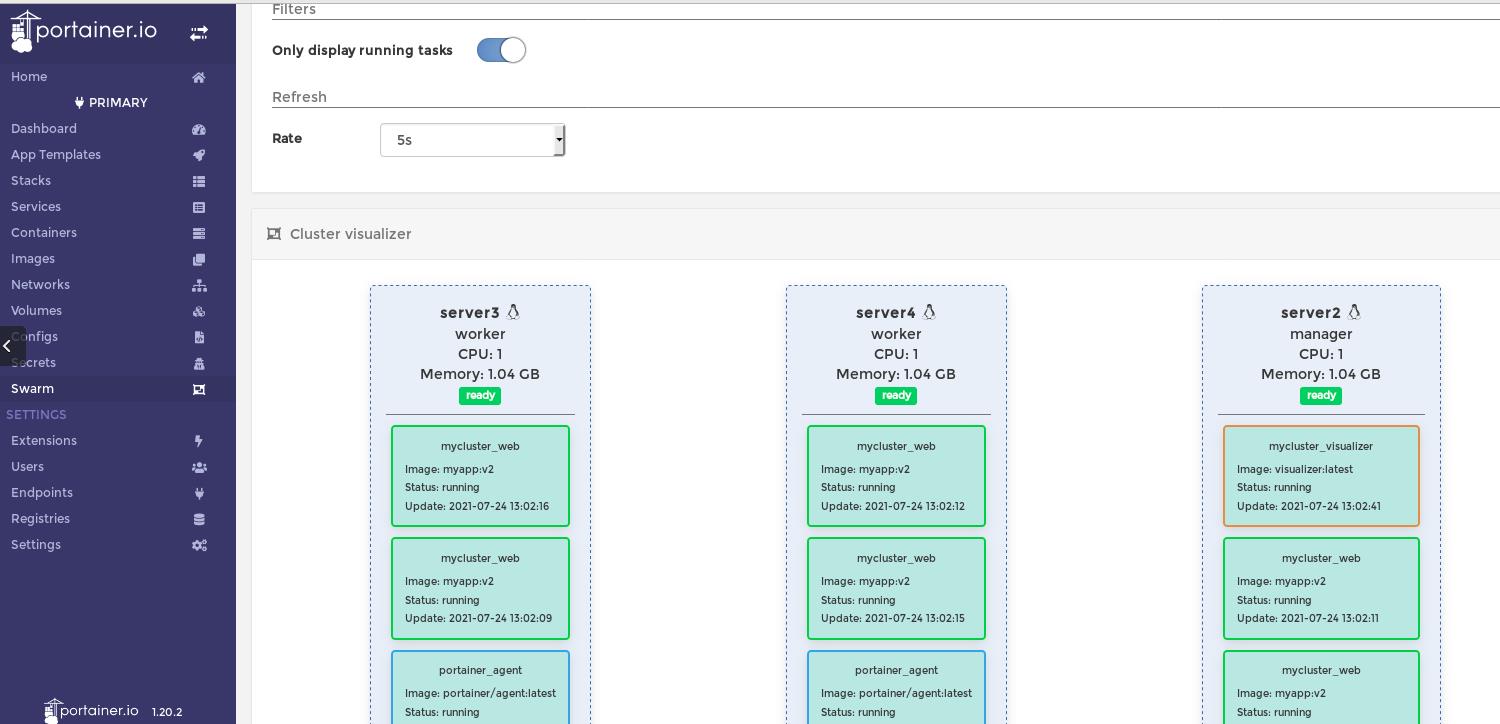

网页访问监控visualizer,映射端口到主机的8080

firefox:172.25.28.2:8080

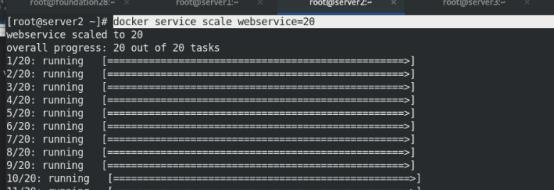

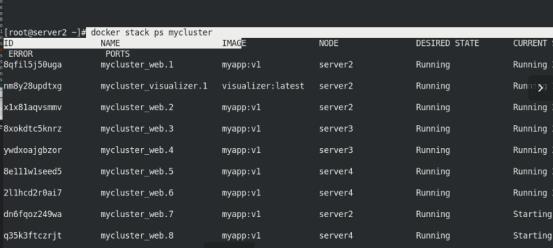

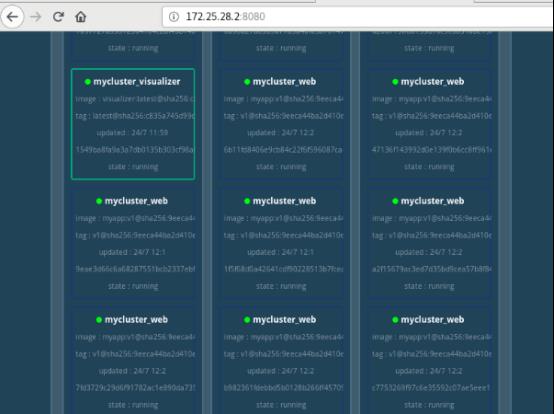

添加集群数量到20个

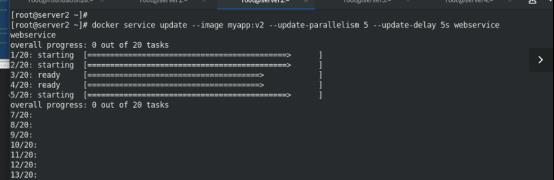

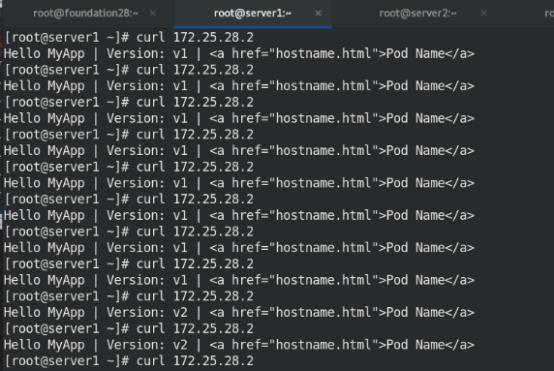

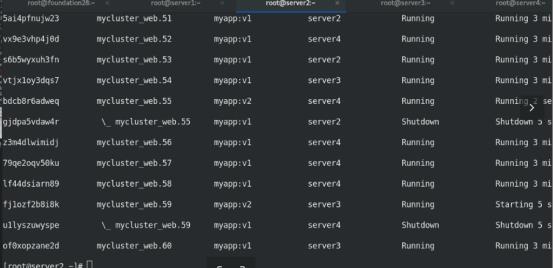

版本更新:每隔5s起来,一次起来5个(v1-v2)

网页访问监控visualizer,映射端口到主机的8080

curl 172.25.28.2可以看到版本更新过程

滚动更新,默认每次更新一个

删除监控和webservice

四 Docker集群管理

基于 Docker Swarm 之上来完成应用的部署,面向大规模场景下的多服务部署和管理。

1. docker stack部署

1.1 docker stack与docker-compose的区别:

(1)Docker stack不支持“build”指令,它是需要镜像是预先已经构建好的, 所以docker-compose更适合于开发场景;

(2)Docker Compose是一个Python项目,使用Docker API规范来操作容器。

(3)Docker Stack功能包含在Docker引擎中,是swarm mode的一部分;

(4)Docker stack不支持基于第2版写的docker-compose.yml ,也就是version版本至少为3。然而Docker Compose对版本为2和3的 文件仍然可以处理;

(5)docker stack把docker compose的所有工作都做完了,因此docker stack将占主导地位。

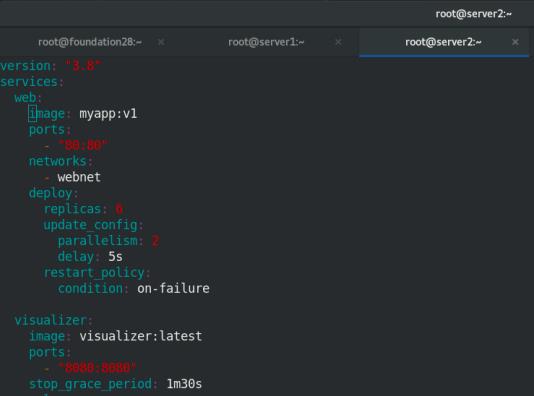

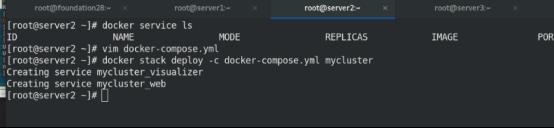

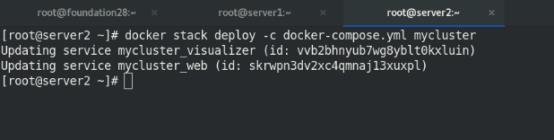

1.2 创建服务,扩容,版本更新

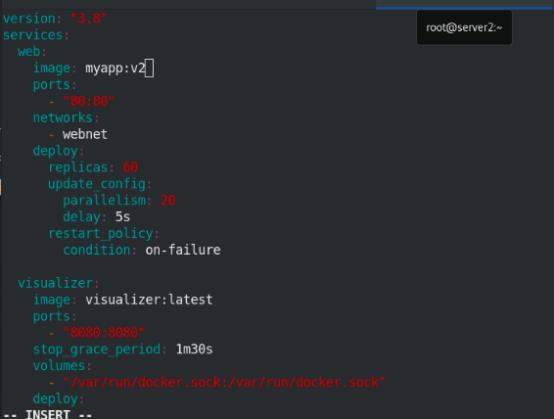

修改yaml脚本,-c 指定文件

(1)创建监控和webservice服务,6个容器,3个节点,一次起来2个容器,实现负载均衡

(2)扩容:创建监控和webservice服务,60个容器,3个节点,实现负载均衡,一次起来20个容器

(3)版本更新:v1-v2

stack会自己创建网络:defalus

2. 图像化集群管理–Portainer可视化

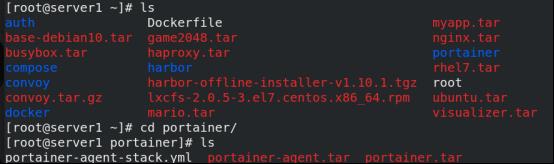

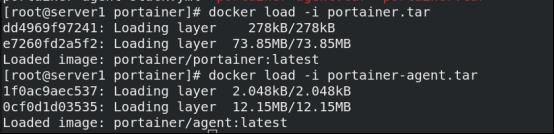

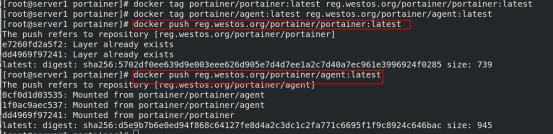

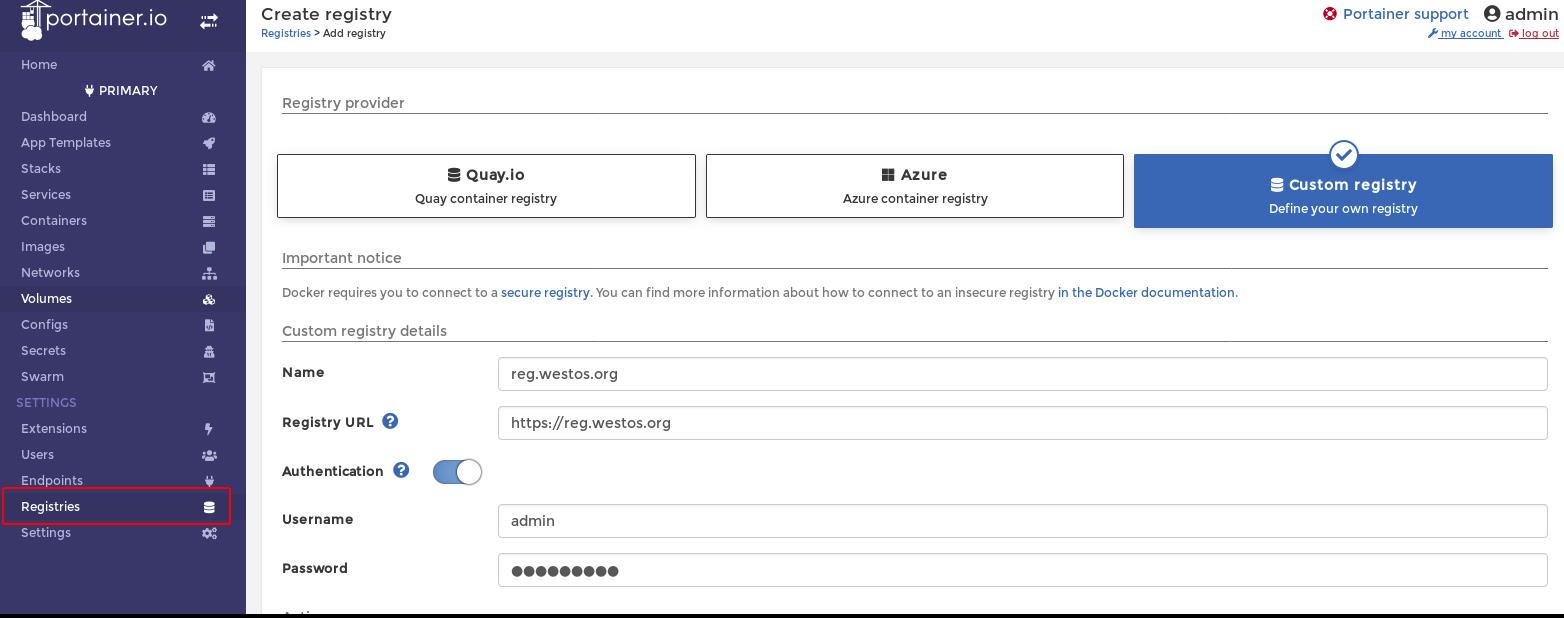

本地拉取portainer和portainer-agent镜像

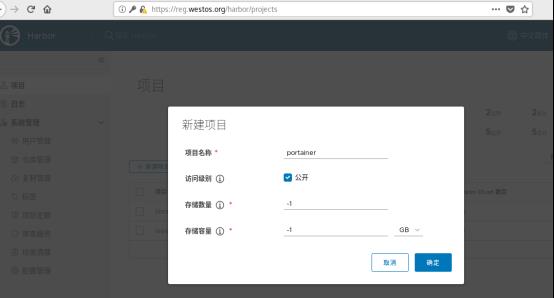

创建portainer项目

修改标签,将镜像上传至reg.westos.org仓库下的protainer项目中

查看仓库

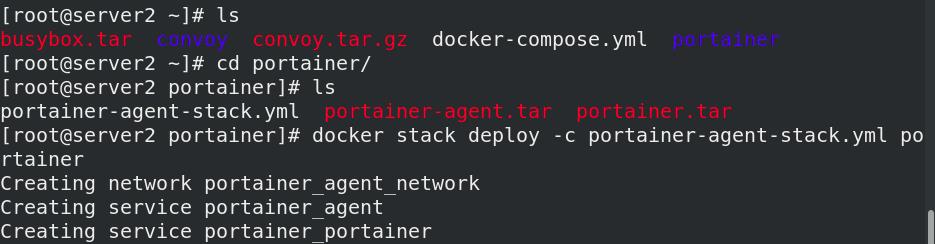

编写portainer-agent-stack.yml文件,在manager(server2)主机中执行脚本

version: '3.2'

services:

agent:

image: portainer/agent

environment:

# REQUIRED: Should be equal to the service name prefixed by "tasks." when

# deployed inside an overlay network

AGENT_CLUSTER_ADDR: tasks.agent

# AGENT_PORT: 9001

# LOG_LEVEL: debug

volumes:

- /var/run/docker.sock:/var/run/docker.sock

- /var/lib/docker/volumes:/var/lib/docker/volumes

networks:

- agent_network

deploy:

mode: global

placement:

constraints: [node.platform.os == linux]

portainer:

image: portainer/portainer

command: -H tcp://tasks.agent:9001 --tlsskipverify

ports:

- "9000:9000"

volumes:

- portainer_data:/data

networks:

- agent_network

deploy:

mode: replicated

replicas: 1

placement:

constraints: [node.role == manager]

networks:

agent_network:

driver: overlay

attachable: true

volumes:

portainer_data:

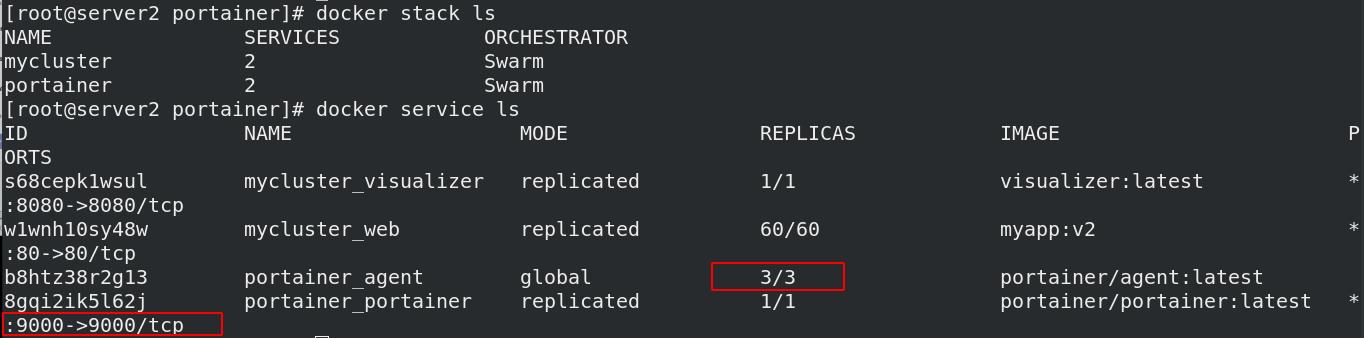

拉起服务后查看服务状态

firefox:

172.25.28.2:9000

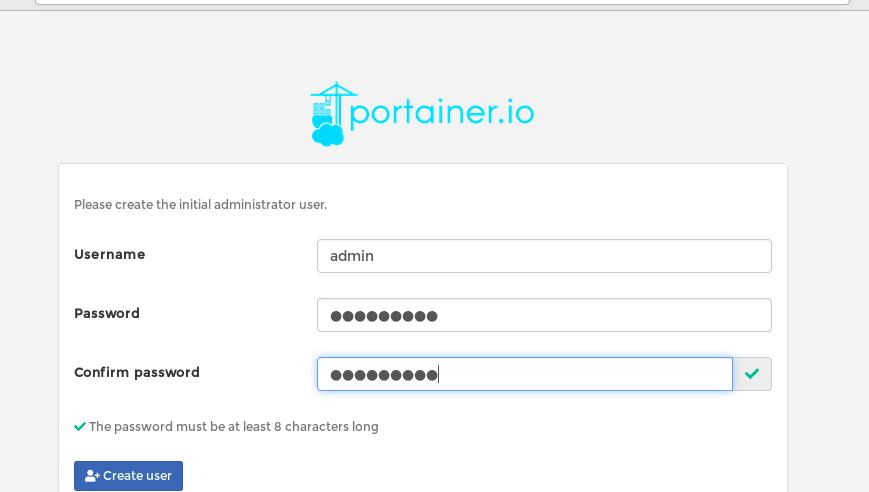

输入账户密码,进入管理界面,首次进入需要设定管理账户和密码

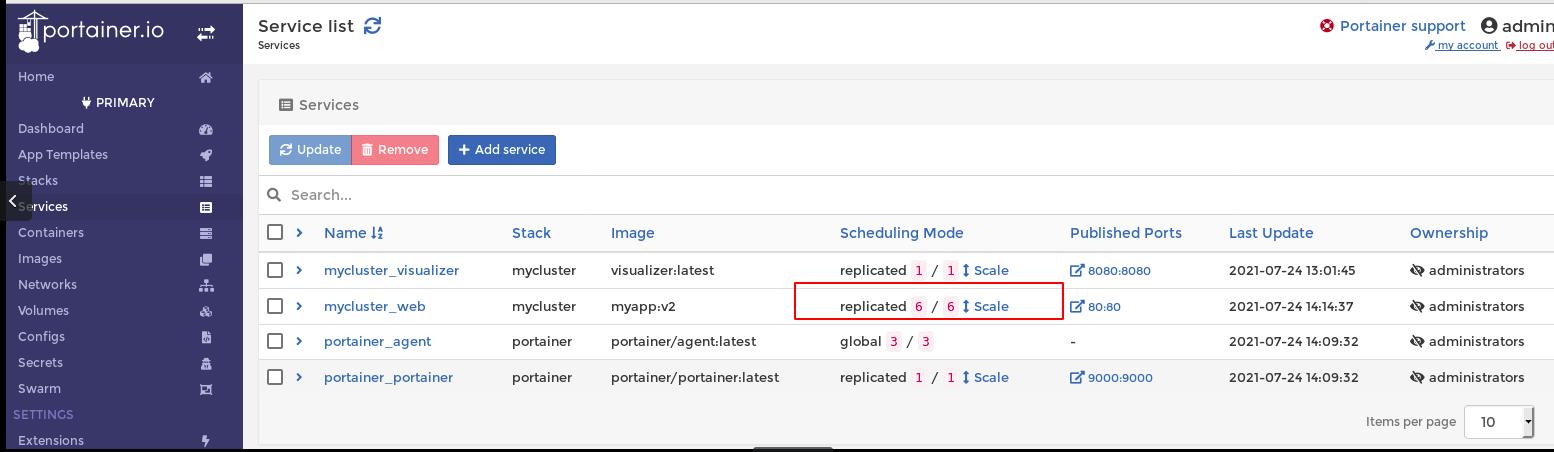

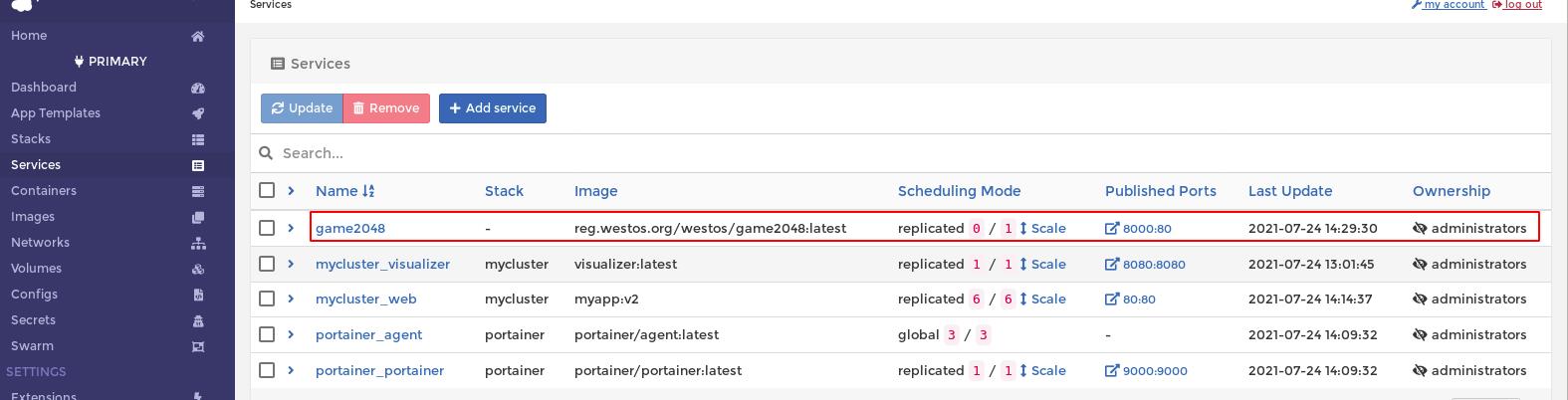

进入service进行查看

swarm中查看,看到我们创建的容器

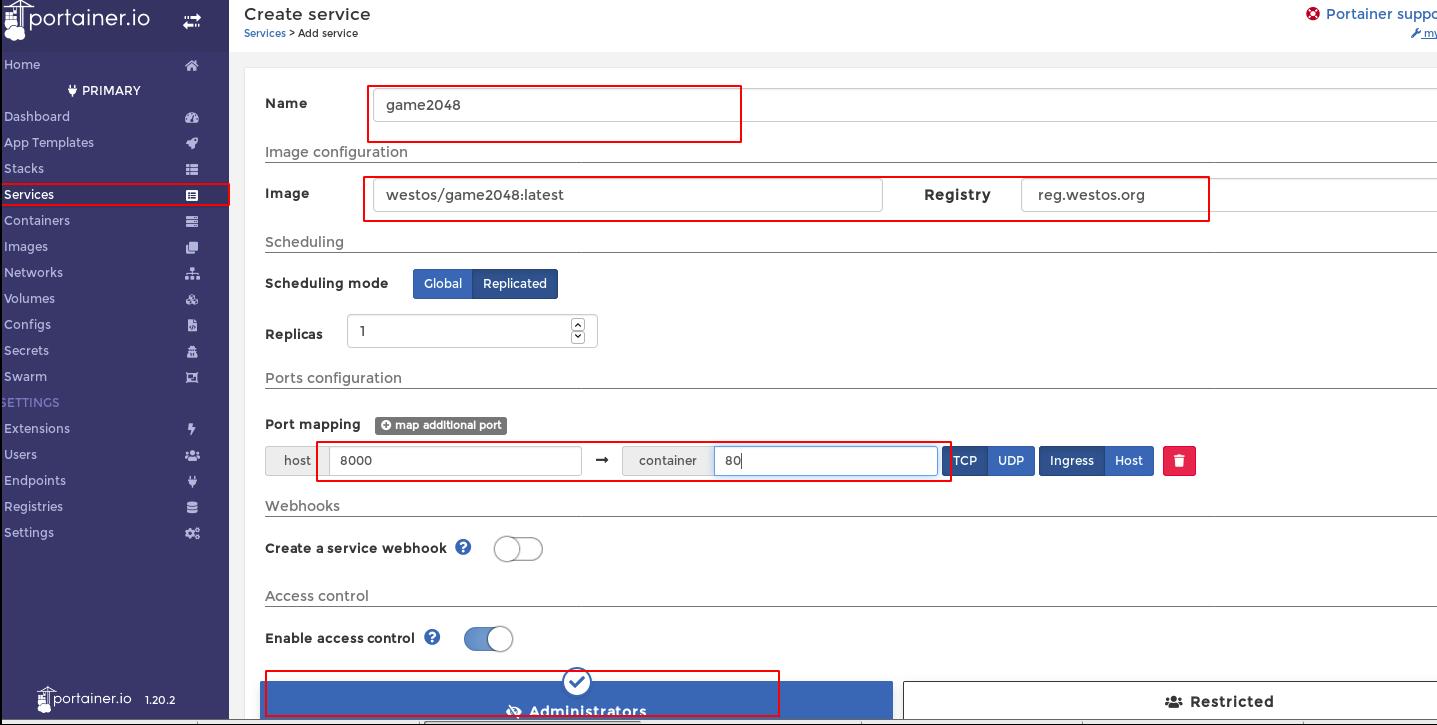

将仓库中westos项目下的game2048镜像

选定仓库:reg.westos.org

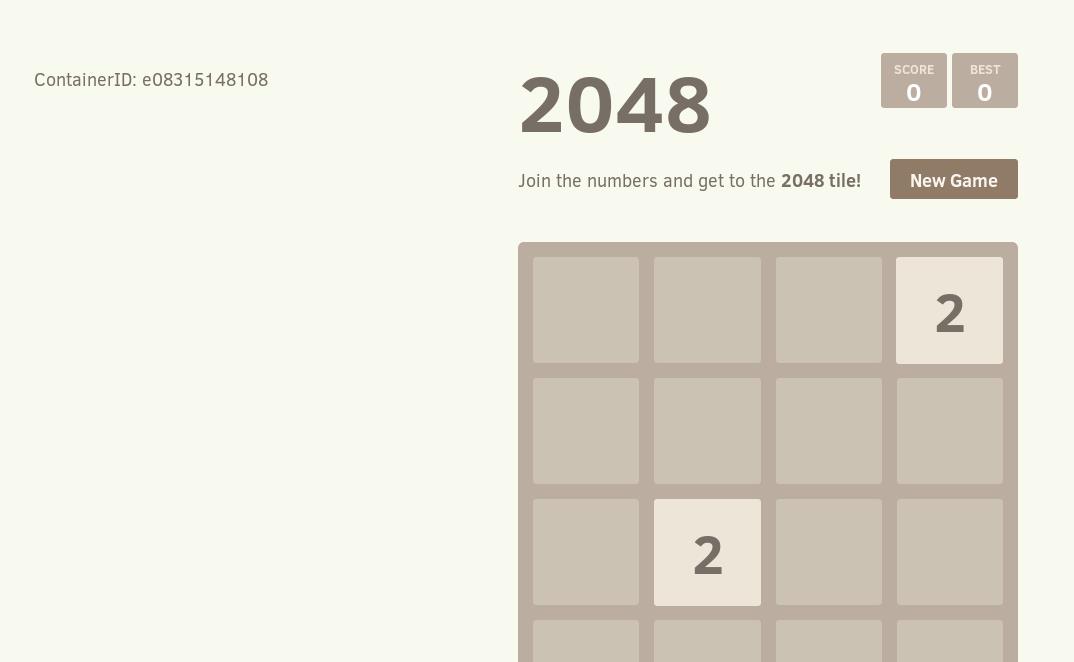

portainer界面中手动创建服务, su主机的8000端口映射为容器的80端口

服务查看

firefox:172.25.282:8000

以上是关于Docker-----三剑客:machinecomposeswarm 及Docker集群管理的主要内容,如果未能解决你的问题,请参考以下文章