逻辑回归分类中解决类别不平衡问题

Posted ZSYL

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了逻辑回归分类中解决类别不平衡问题相关的知识,希望对你有一定的参考价值。

分类中解决类别不平衡问题

1. 类别不平衡数据集基本介绍

前⾯我们已经初步认识了,什么是类别不平衡问题。其实,在现实环境中,采集的数据(建模样本)往往是比例失衡

的。比如网贷数据,逾期人数的比例是极低的(千分之几的比例);奢侈品消费人群鉴定等。

在这⼀节中,我们⼀起看⼀下,当遇到数据类别不平衡的时候,我们该如何处理。在Python中,有Imblearn包,它就是为处理数据比例失衡而生的。

- 安装Imblearn包

pip3 install imbalanced-learn

第三方包链接:https://pypi.org/project/imbalanced-learn/

- 创造数据集

from sklearn.datasets import make_classification

import matplotlib.pyplot as plt

#使⽤make_classification⽣成样本数据

X, y = make_classification(n_samples=5000,

n_features=2, # 特征个数= n_informative() + n_redundant + n_repeated

n_informative=2, # 多信息特征的个数

n_redundant=0, # 冗余信息,informative特征的随机线性组合

n_repeated=0, # 重复信息,随机提取n_informative和n_redundant 特征

n_classes=3, # 分类类别

n_clusters_per_class=1, # 某⼀个类别是由⼏个cluster构成的

weights=[0.01, 0.05, 0.94], # 列表类型,权重⽐

random_state=0)

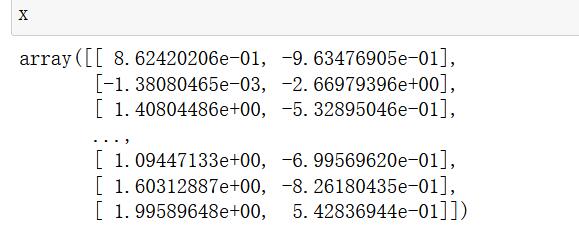

- 查看各个标签的样本

#查看各个标签的样本量

from collections import Counter

Counter(y)

# Counter({2: 4674, 1: 262, 0: 64})

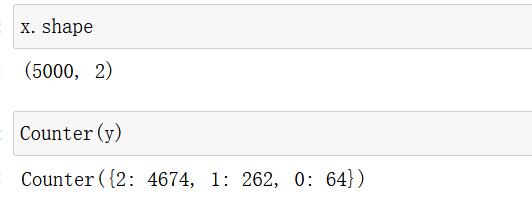

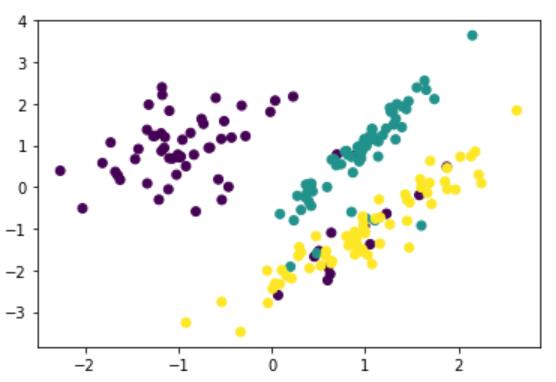

- 数据集可视化

# 数据可视化

plt.scatter(x[:, 0],x[:, 1], c=y)

plt.show()

可以看出样本的三个标签中,1,2的样本量极少,样本失衡。下面使用imblearn进行过采样。 接下来,我们就要基于以上数据,进行相应的处理。

关于类别不平衡的问题,主要有两种处理方式:

- 过采样方法

- 增加数量较少那⼀类样本的数量,使得正负样本比例均衡。

- 欠采样方法

- 减少数量较多那⼀类样本的数量,使得正负样本比例均衡。

2. 解决类别不平衡数据方法介绍

2.1 过采样方法

2.1.1 什么是过采样方法

对训练集里的少数类进行“过采样”(oversampling),即增加⼀些少数类样本使得正、反例数目接近,然后再进行学习。

2.1.2 随机过采样方法

随机过采样是在少数类中随机选择⼀些样本,然后通过复制所选择的样本生成样本集。

- 通过代码实现随机过采样方法:

# 使⽤imblearn进⾏随机过采样

from imblearn.over_sampling import RandomOverSampler

ros = RandomOverSampler(random_state=0)

X_resampled, y_resampled = ros.fit_resample(X, y)

#查看结果

Counter(y_resampled)

#过采样后样本结果

# Counter({2: 4674, 1: 4674, 0: 4674})

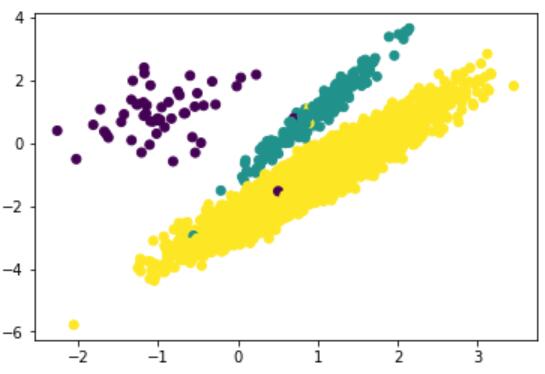

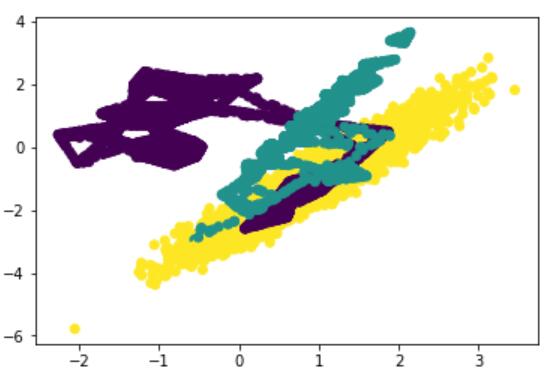

# 数据集可视化

plt.scatter(X_resampled[:, 0], X_resampled[:, 1], c=y_resampled)

plt.show()

- 缺点:

- 对于随机过采样,由于需要对少数类样本进⾏复制来扩⼤数据集,造成模型训练复杂度加大。

- 另一方面也容易造成模型的过拟合问题,因为随机过采样是简单的对初始样本进行复制采样,这就使得机器学习学得的规则过于具体化,不利于学习器的泛化性能,造成过拟合问题。

为了解决随机过采样中造成模型过拟合问题,又能保证实现数据集均衡的目的,出现了过采样法代表性的算法SMOTE 算法。

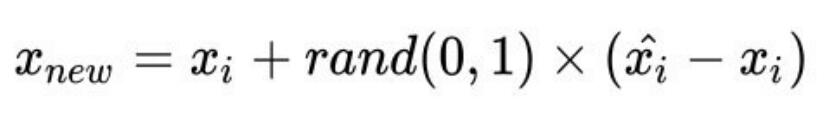

SMOTE算法合成新少数类样本的算法描述如下:

-

对于少数类中的每⼀个样本,以欧式距离为标准计算它到少数类样本集中所有样本的距离,得到其k近邻。

-

根据样本不平衡比例设置⼀个采样比例以确定采样倍率N,对于每⼀个少数类样本,从其k近邻中随机选择若干个样本,假设选择的是。

-

对于每⼀个随机选出来的近邻,分别与按照如下公式构建新的样本。

SMOTE算法摒弃了随机过采样复制样本的做法,可以防⽌随机过采样中容易过拟合的问题,实践证明此方法可以提高分类器的性能。

- 代码实现:

# SMOTE过采样

from imblearn.over_sampling import SMOTE

X_resampled, y_resampled = SMOTE().fit_resample(X, y)

Counter(y_resampled)

# 采样后样本结果

# [(0, 4674), (1, 4674), (2, 4674)]

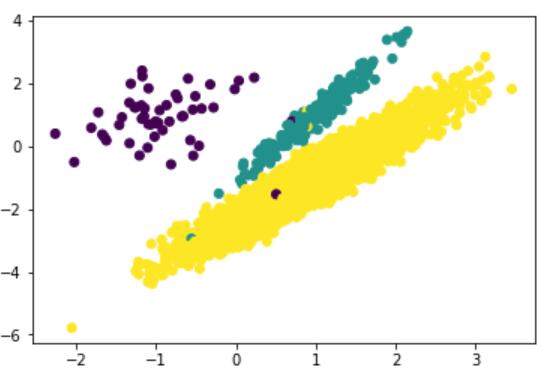

# 数据集可视化

plt.scatter(X_resampled[:, 0], X_resampled[:, 1], c=y_resampled)

plt.show()

2.2 欠采样方法

2.2.1 什么是欠采样方法

直接对训练集中多数类样本进行“欠采样”(undersampling),即去除⼀些多数类中的样本使得正例、反例数目接近,然后再进行学习。

2.2.2 随机欠采样方法

随机欠采样顾名思义即从多数类中随机选择⼀些样样本组成样本集。

- 代码实现:

# 随机⽋采样

from imblearn.under_sampling import RandomUnderSampler

rus = RandomUnderSampler(random_state=0)

X_resampled, y_resampled = rus.fit_resample(X, y)

Counter(y_resampled)

# 采样后结果

[(0, 64), (1, 64), (2, 64)]

# 数据集可视化

plt.scatter(X_resampled[:, 0], X_resampled[:, 1], c=y_resampled)

plt.show()

- 缺点:

- 随机欠采样方法通过改变多数类样本比例以达到修改样本分布的目的,从而使样本分布较为均衡,但是这也存 在⼀些问题。对于随机⽋采样,由于采样的样本集合要少于原来的样本集合,因此会造成⼀些信息缺失,即将 多数类样本删除有可能会导致分类器丢失有关多数类的重要信息。

官网链接:https://imbalanced-learn.readthedocs.io/en/stable/ensemble.html

加油!

感谢!

努力!

以上是关于逻辑回归分类中解决类别不平衡问题的主要内容,如果未能解决你的问题,请参考以下文章