0610 每日文献阅读 打卡

Posted Lf&x&my

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了0610 每日文献阅读 打卡相关的知识,希望对你有一定的参考价值。

|

Read Data: 0610 |

Publication: CVPR 2021 |

||

|

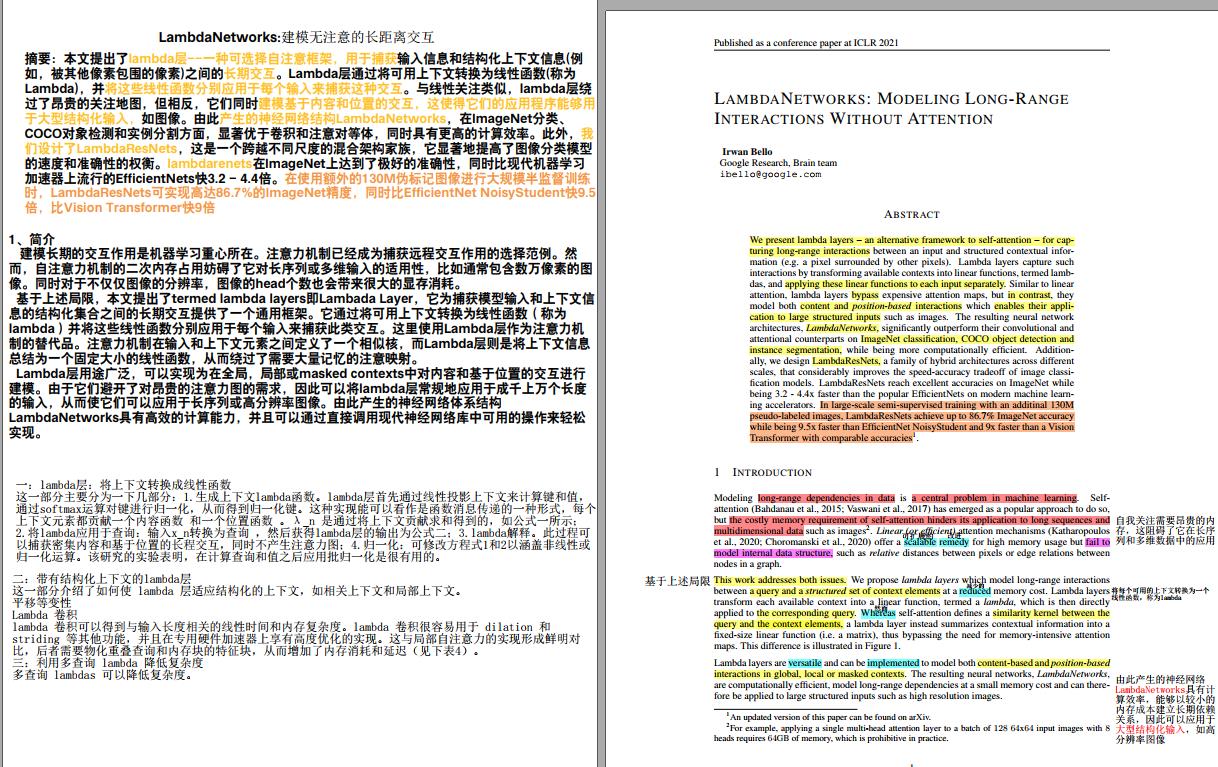

Title: LambdaNetworks: Modeling long-range Interactions without Attention Participants: Irwan Bello |

|||

|

Aim: 为了捕获输入信息和结构化上下文信息(例如,被其他像素包围的像素)之间的长距离交互。 |

Research Question: 1、 为了长距离交互作用,自注意力机制需要大量内存,阻碍了其在长序列和多数据等大内存方面的应用。 2、 线性注意力为高内存使用提供一个可伸缩的改进方案,但不能对内部数据结构建模,如像素之间的相对距离或图中节点之间的边缘关系。 |

||

|

Method:

|

|||

|

Results: 在使用额外的130M伪标记图像进行大规模半监督训练时,LambdaResNets可实现高达86.7%的ImageNet精度,同时比EfficientNet NoisyStudent快9.5倍,比Vision Transformer快9倍。 |

Discussion: |

||

|

Conclusion: 我们提出了一类新的层,称为lambda层,它提供了一个可伸缩的框架,用于捕获输入及其上下文之间的结构化交互。Lambda层将可用上下文概括为固定大小的线性函数(称为lambdas),这些函数直接应用于其关联的查询。由此产生的神经网络LambdaNetworks在计算上是高效的,能够以较小的内存成本捕获长期依赖关系,使其应用于大型结构化输入,如高分辨率图像。大量关于计算机视觉任务的实验显示了它们的多功能性和优于卷积和注意网络。我们介绍了LambdaResNets,一个混合LambdaNetworks系列,可以达到优秀的ImageNet精度,并在流行的EfficientNets和Vision transformer上实现高达9.5倍的加速,显著提高了图像分类模型的速度和精度的折衷。 |

Further: |

||

|

Ref: 本文提出新层:Lambda Layers!由其衍生出的LambdaResNets,极大地改善了图像分类模型的速度与准确性权衡。在ImageNet上表现SOTA,同时比EfficientNets快约4.5倍!并在检测和分割任务中性能提升明显,代码开源。 |

|||

以上是关于0610 每日文献阅读 打卡的主要内容,如果未能解决你的问题,请参考以下文章