时序差分学习(temporary learning, TD)

Posted 郁郁园中柳

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了时序差分学习(temporary learning, TD)相关的知识,希望对你有一定的参考价值。

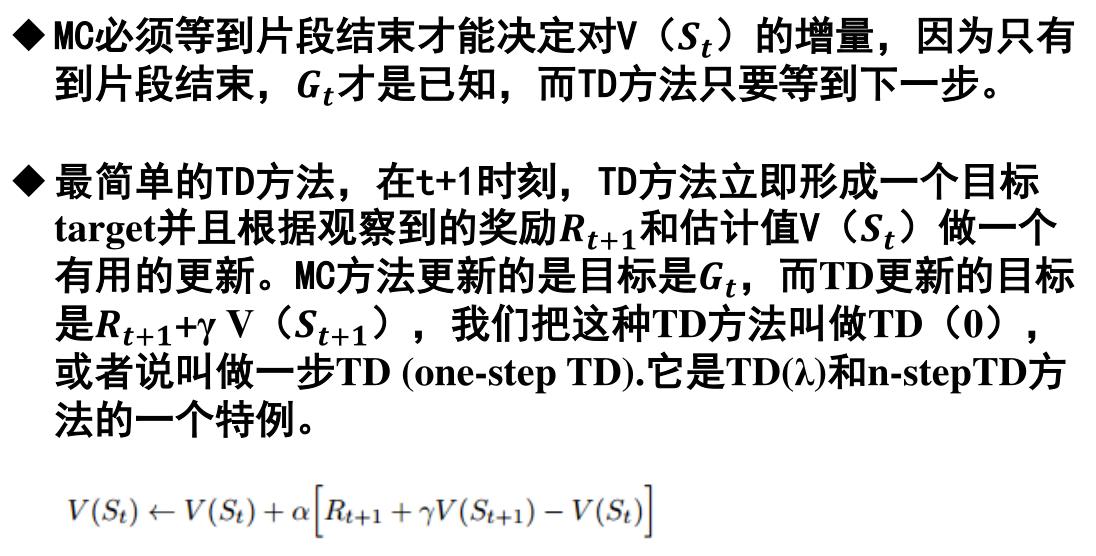

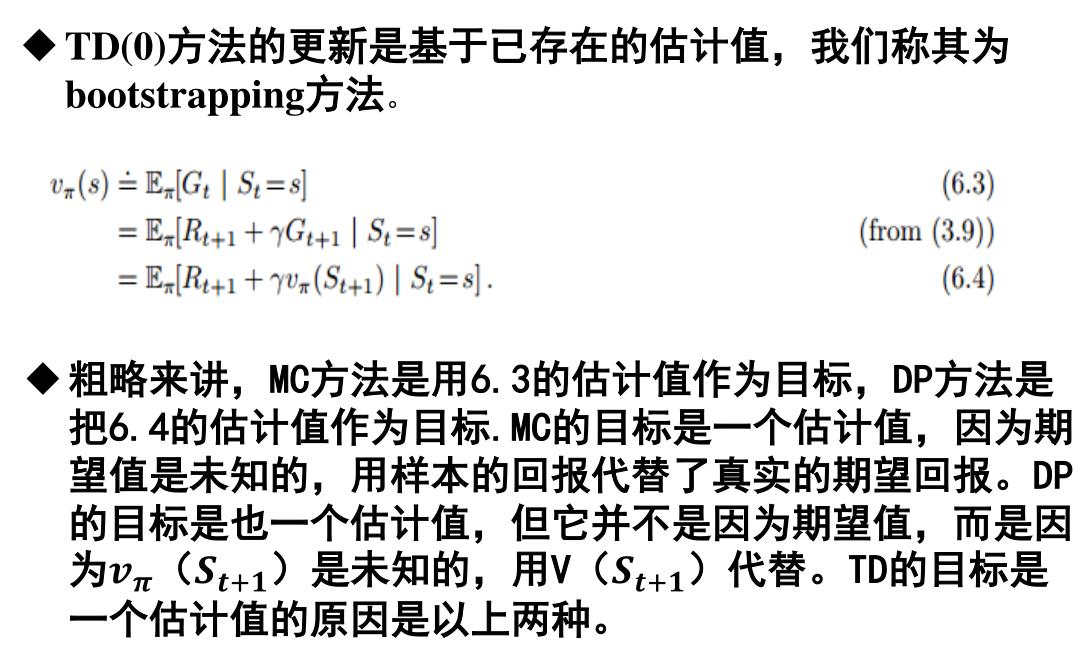

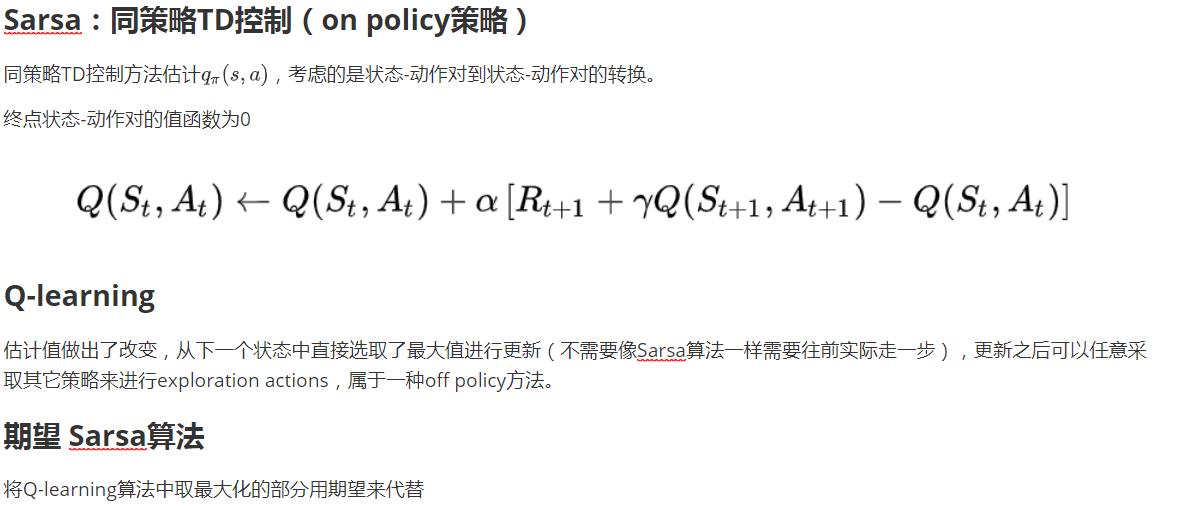

蒙特卡罗方法在没有环境模型的基础上,直接从经验中学习,无需获知环境的全部信息。动态规划从其它的已经学习到的估计值去更新估计值。TD则结合了这两种方法的优点,且不需要等到片段结束。

对于控制问题,也就是寻找一个最优策略,DP、TD和蒙特卡罗方法都是用一些GPI的变量。不同之处在于它们对于预测问题的求解方法不同。

蒙特卡罗要等到真个片段结束之后才可以更新估计值。TD结合了下一状态的信息,只要有下一状态就可以对当前的估计值进行更新。TD通过在线的、完全实时的方式来进行增量更新。如果一次任务结束周期太长,或者面对连续型任务,MC方法可能会有很严重的延迟问题,TD方法则很好地避免了这种问题。

当然,在实际中还可以采用批量更新的方法,每一步都按照原来的步骤计算,求出增量,先不执行更新,而是将增量累积起来。当一整批训练数据都处理完毕后,将增量统一更新到目标值上。

以上是关于时序差分学习(temporary learning, TD)的主要内容,如果未能解决你的问题,请参考以下文章