学生课程分数的 Spark SQL 分析

Posted 快乐翔哥

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了学生课程分数的 Spark SQL 分析相关的知识,希望对你有一定的参考价值。

学生课程分数的 Spark SQL 分析

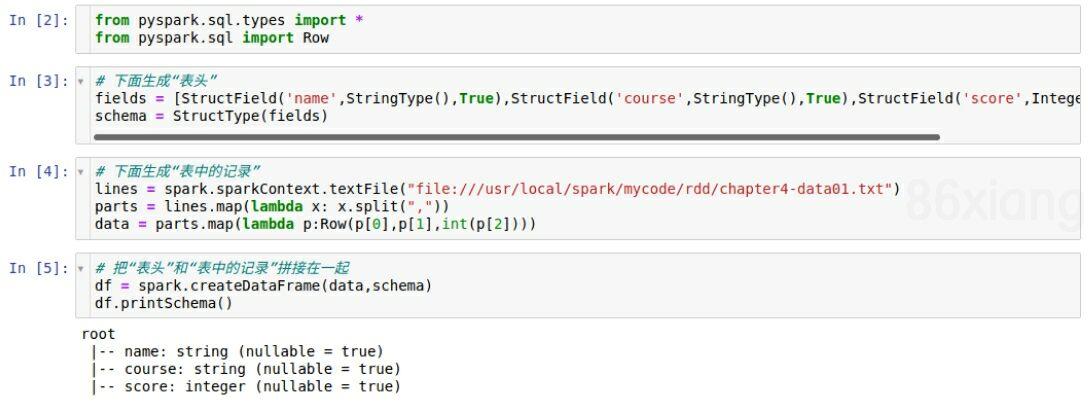

读学生课程分数文件 chapter4-data01.txt,创建 DataFrame

from pyspark.sql.types import *

from pyspark.sql import Row

# 下面生成“表头”

fields = [StructField(\'name\',StringType(),True),StructField(\'course\',StringType(),True),StructField(\'score\',IntegerType(),True)]

schema = StructType(fields)

# 下面生成“表中的记录”

lines = spark.sparkContext.textFile("file:///usr/local/spark/mycode/rdd/chapter4-data01.txt")

parts = lines.map(lambda x: x.split(","))

data = parts.map(lambda p:Row(p[0],p[1],int(p[2])))

# 把“表头”和“表中的记录”拼接在一起

df = spark.createDataFrame(data,schema)

df.printSchema()

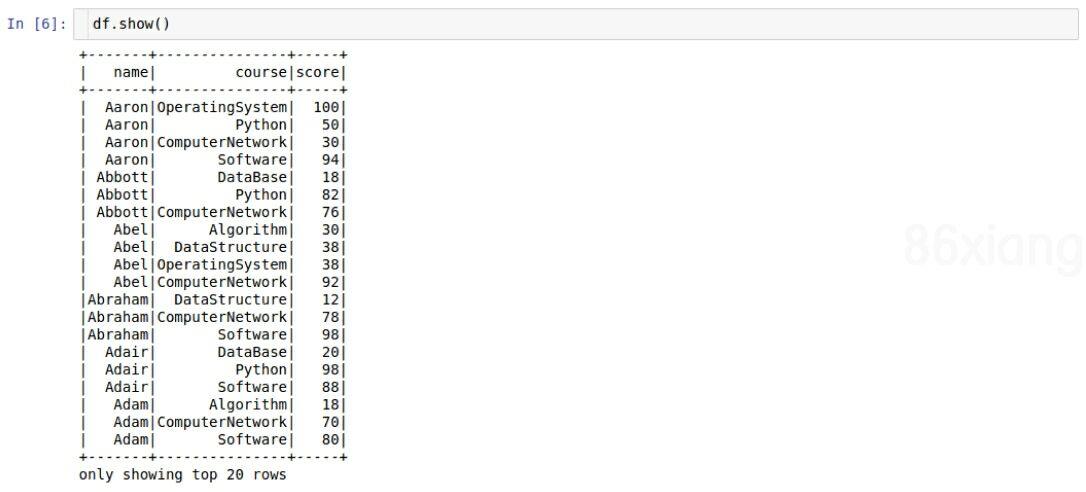

df.show()

用 DataFrame 的操作或 SQL 语句完成以下数据分析要求,并和用 RDD 操作的实现进行对比:

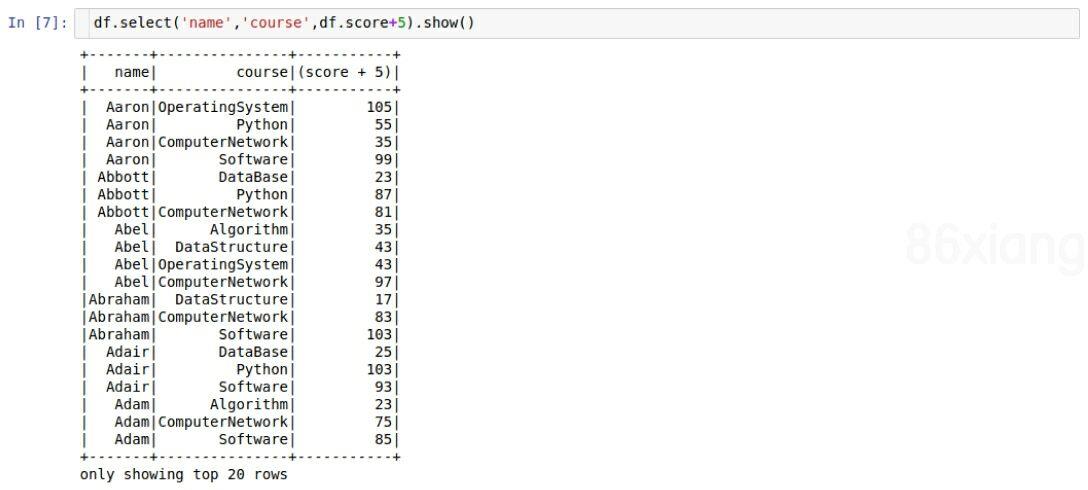

- 每个分数+5分。

df.select(\'name\',\'course\',df.score+5).show()

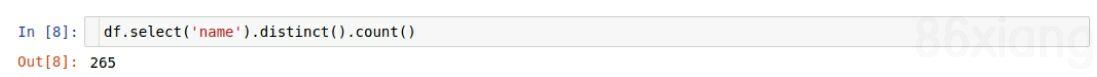

- 总共有多少学生?

df.select(\'name\').distinct().count()

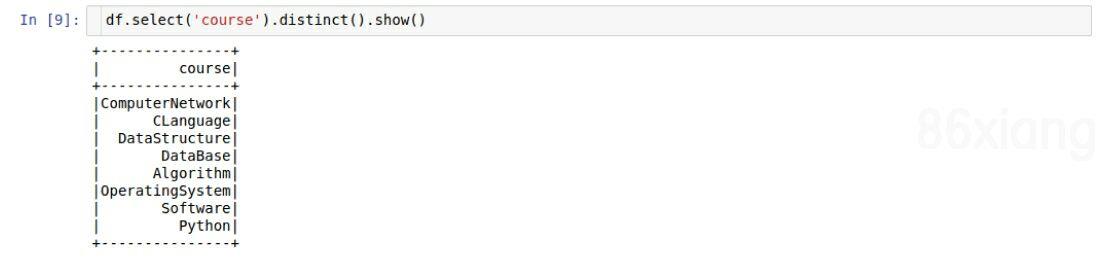

- 总共开设了哪些课程?

df.select(\'course\').distinct().show()

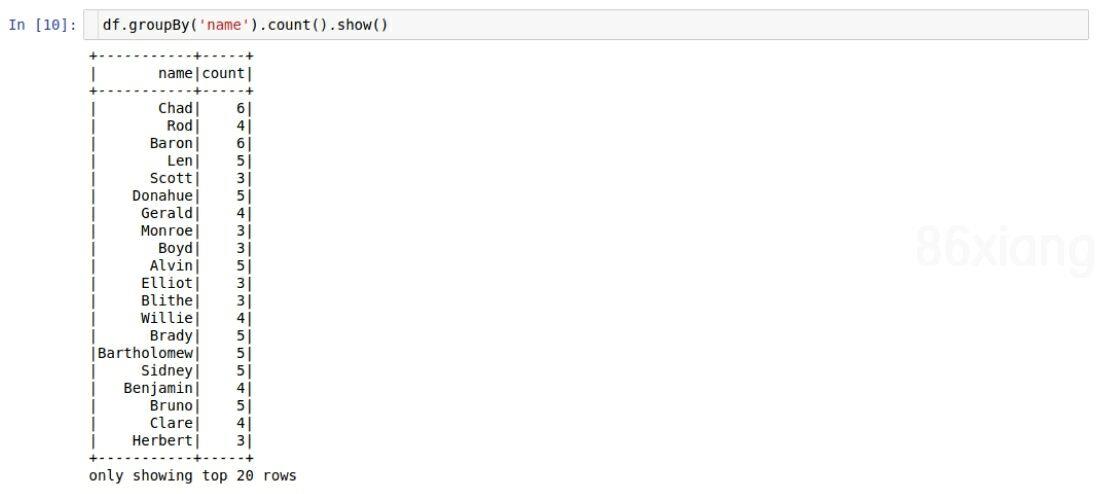

- 每个学生选修了多少门课?

df.groupBy(\'name\').count().show()

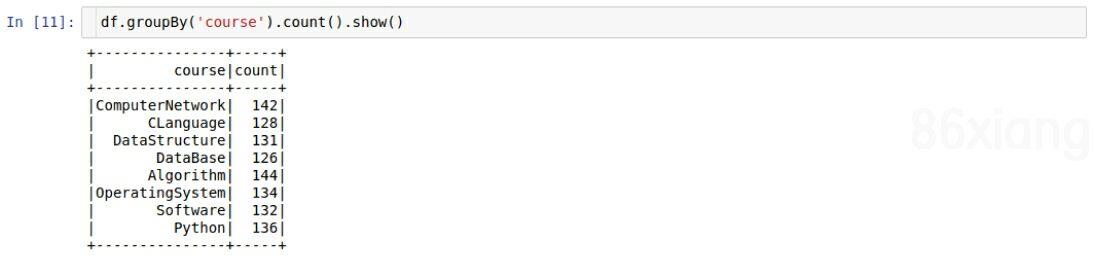

- 每门课程有多少个学生选?

df.groupBy(\'course\').count().show()

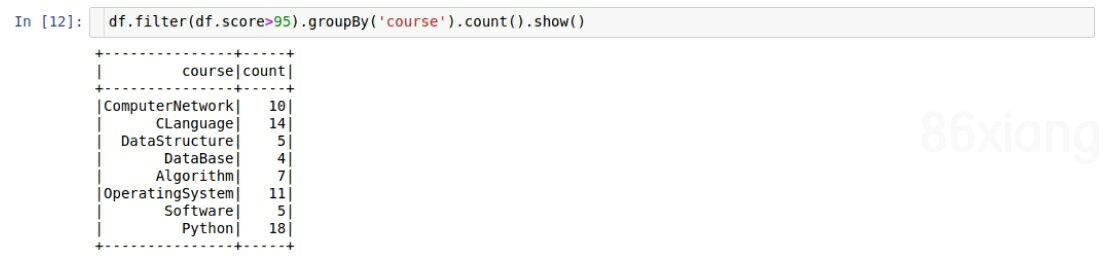

- 每门课程大于95分的学生人数?

df.filter(df.score>95).groupBy(\'course\').count().show()

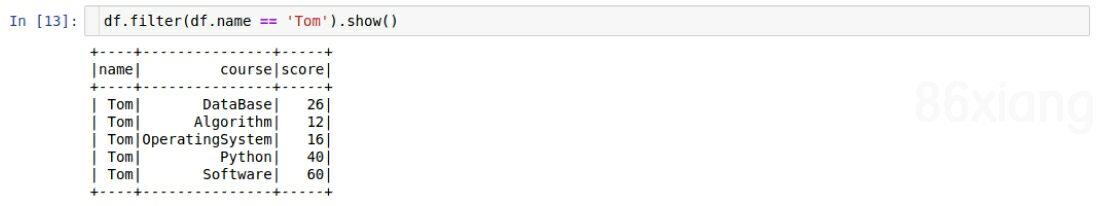

- Tom选修了几门课?每门课多少分?

df.filter(df.name == \'Tom\').show()

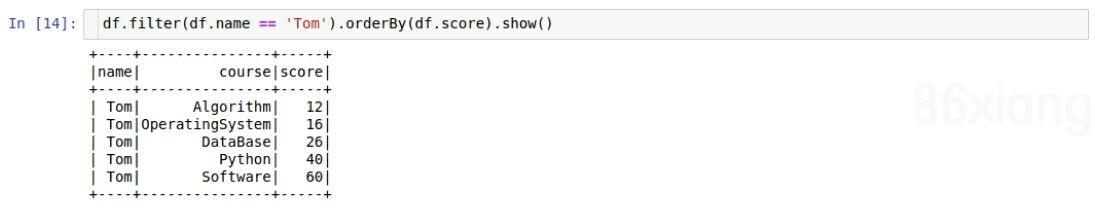

- Tom的成绩按分数大小排序。

df.filter(df.name == \'Tom\').orderBy(df.score).show()

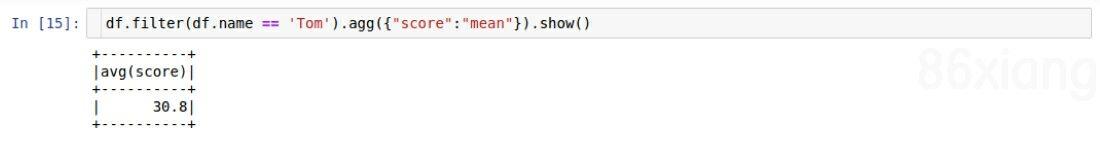

- Tom的平均分。

df.filter(df.name == \'Tom\').agg({"score":"mean"}).show()

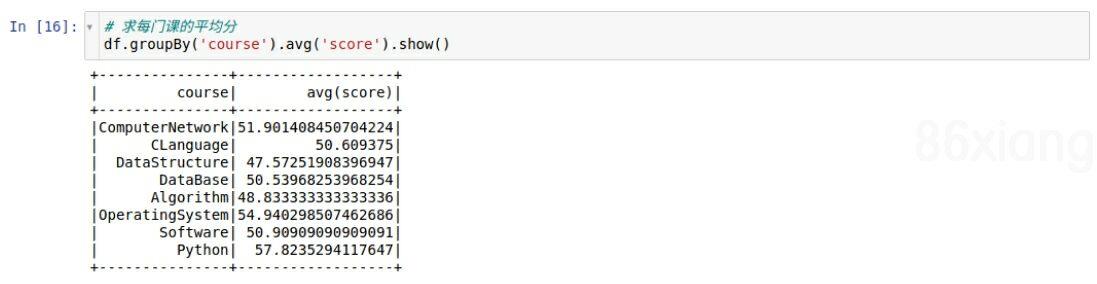

- 求每门课的平均分,最高分,最低分。

# 求每门课的平均分

df.groupBy(\'course\').avg(\'score\').show()

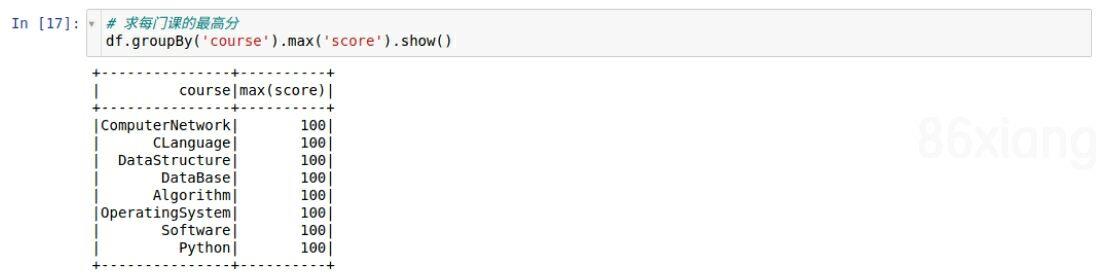

# 求每门课的最高分

df.groupBy(\'course\').max(\'score\').show()

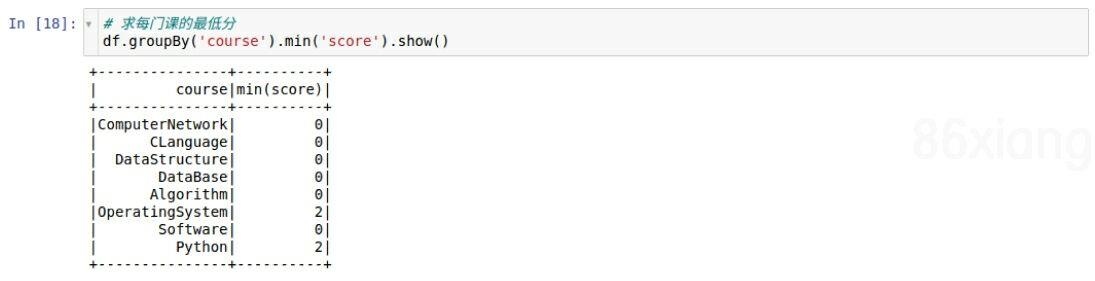

# 求每门课的最低分

df.groupBy(\'course\').min(\'score\').show()

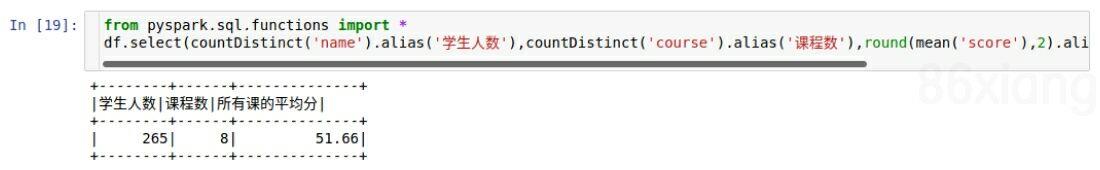

- 求每门课的选修人数及平均分,精确到2位小数。

from pyspark.sql.functions import *

df.select(countDistinct(\'name\').alias(\'学生人数\'),countDistinct(\'course\').alias(\'课程数\'),round(mean(\'score\'),2).alias(\'所有课的平均分\')).show()

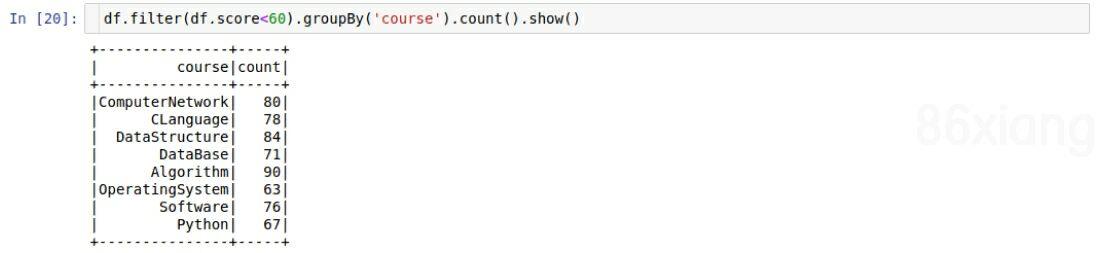

- 每门课的不及格人数,通过率

df.filter(df.score<60).groupBy(\'course\').count().show()

- 结果可视化。

以上是关于学生课程分数的 Spark SQL 分析的主要内容,如果未能解决你的问题,请参考以下文章