scrapydweb 安装部署

Posted AngDH

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了scrapydweb 安装部署相关的知识,希望对你有一定的参考价值。

https://blog.csdn.net/xyb1206/article/details/89395316?depth_1-utm_source=distribute.pc_relevant.none-task&utm_source=distribute.pc_relevant.none-task

https://blog.csdn.net/iodjSVf8U1J7KYc/article/details/83189770

官网

https://github.com/my8100/files/blob/master/scrapydweb/README_CN.md

1.

pip install scrapydweb

2.

scrapydweb

会在 运行 指令的文件夹 下 新建 配置文件

3.

vim

scrapydweb配置文件在第一次执行`scrapydweb`命令的当前目录生成,文件名scrapydweb_settings_v8.py

1.启用HTTP基本认证(可选):

ENABLE_AUTH = True

USERNAME = \'username\'

PASSWORD = \'password\'

nohup scrapydweb >> log_scweb.out &

pip install logparser

按 装 后 用命令 logparser 启动

如果 scrapyd 的 log 目录 修改了 用 logparser -dir /scrapyd/logs/ 启动

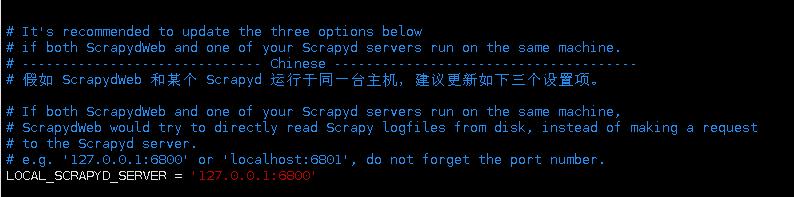

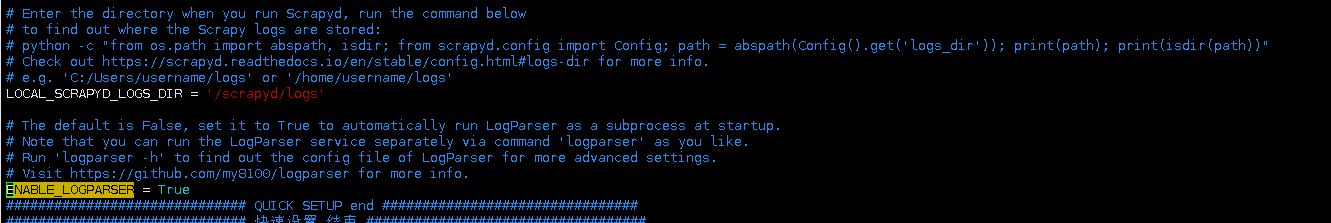

- 如果在同一台主机运行 Scrapyd 和 ScrapydWeb,建议设置

SCRAPYD_LOGS_DIR和ENABLE_LOGPARSER,则启动 ScrapydWeb 时将自动运行 LogParser,该子进程通过定时增量式解析指定目录下的 Scrapy 日志文件以加快 Stats 页面的生成,避免因请求原始日志文件而占用大量内存和网络资源。

- Set \'ENABLE_LOGPARSER = True\' to run LogParser as a subprocess at startup

启动

nohup logparser -dir /scrapyd/logs/ >> log_logparser.out &

以上是关于scrapydweb 安装部署的主要内容,如果未能解决你的问题,请参考以下文章

如何通过 Scrapyd + ScrapydWeb 简单高效地部署和监控分布式爬虫项目

LogParser v0.8.0 发布:一个用于定期增量式解析 Scrapy 爬虫日志的 Python 库,配合 ScrapydWeb 使用可实现爬虫进度可视化