看阿里云 CIPU 的 10 大能力

Posted 范桂飓

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了看阿里云 CIPU 的 10 大能力相关的知识,希望对你有一定的参考价值。

目录

文章目录

CIPU

与传统的 SmartNIC 厂家比,云计算巨头完全是为了满足自身云计算需求。在他们看来,SmartNIC 就是一个完整的计算、存储、网络一体化处理单元,只视乎于想把如何具体的业务卸载下来,而具体业务只有使用云厂商自己最清楚了。

因此,对云厂商来说,自研 SmartNIC 似乎是一条正确的道路,其 “智能网卡” 的概念已经很薄弱了,它不仅仅是个 NIC 这么简单,它已经深深的融入他们的血液里了。

2017 年,阿里云开始部署完全自研的 X-Dragon MOC 卡。

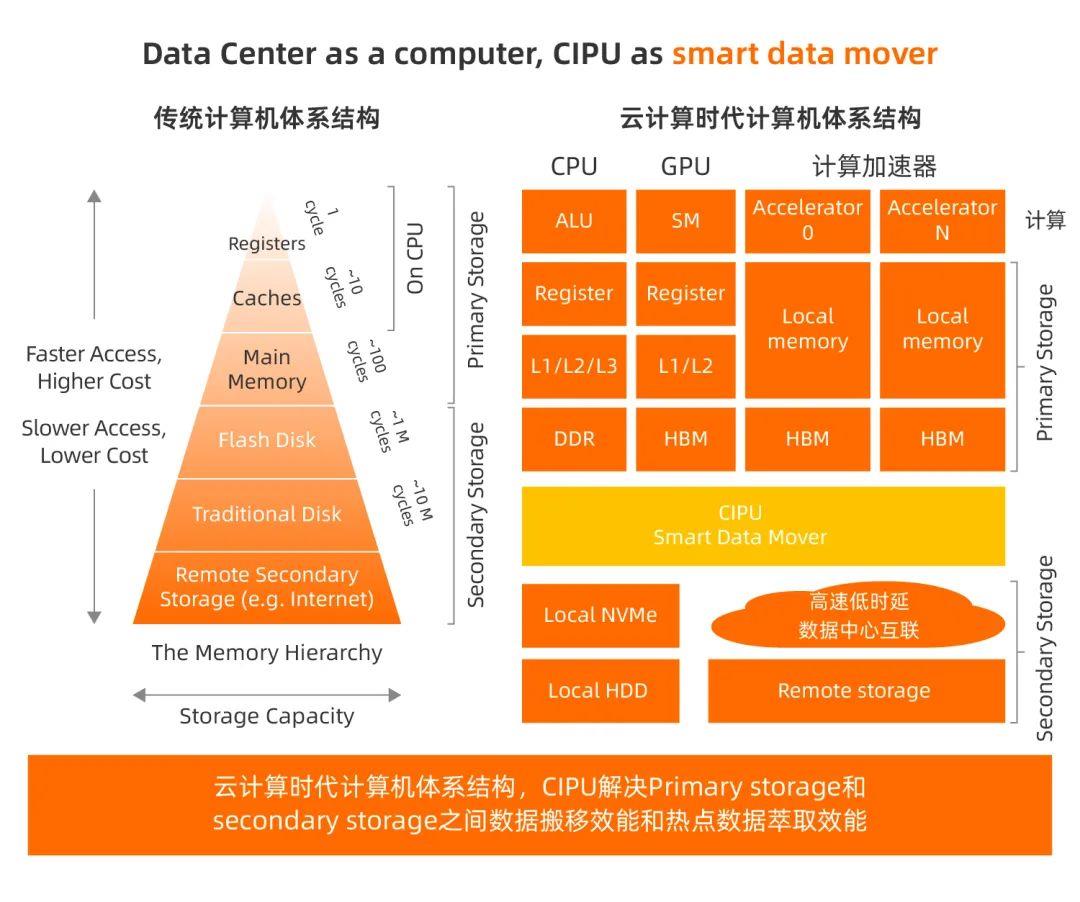

在 2022 年阿里云峰会上,发布了一款云数据中心专用处理器 CIPU(Cloud infrastructure Processing Units,云基础设施处理器)。把 IDC 计算、存储、网络基础设施云化并且硬件加速的专用业务处理器。

CIPU 的定位

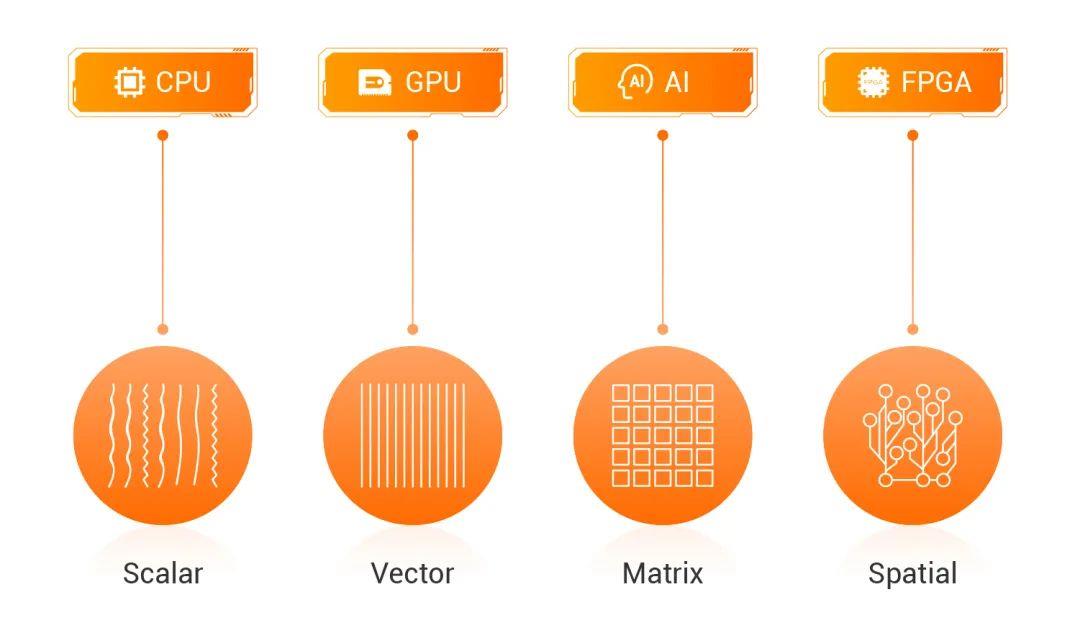

CIPU 要在通用标量计算和 AI 矢量计算等业务领域,去完成 XEON ALU 算力和 GPU stream processor 的 offloading 显然不现实。CIPU 适合的业务类型的共同业务特征:在数据流动(移动)过程中,通过深度垂直软硬件协同设计,尽最大可能减少数据移动,以此提升计算效率。

因此,CIPU 在计算机体系架构视角的主要工作是:优化云计算服务器之间和服务器内部的数据层级化 cache、内存和存储的访问效率。

CIPU 随路异构计算(位于网络和存储必经之路) = 近网络计算(in networking computing)+ 近存储计算(in storage computing)

CIPU 的 10 大能力

IO 硬件设备虚拟化

通过 VT-d 的前置支撑技术,实现高性能的 IO 硬件设备虚拟化。

同时考虑公有云 OS 生态兼容,设备模型应该尽最大努力做到兼容。因此实现基于 virtio-net、virtio-blk、NVMe 等业界标准的 IO 设备模型,成为了必须。

同时注意到 IO 设备的高性能,那么在 PCIe 协议层面的优化则至关重要。如何减少 PCIe TLP 通信量、降低 Guest OS 中断数量(同时平衡时延需求),实现灵活的硬件队列资源池化,新 IO 业务的可编程和可配置的灵活性等方面,是决定 IO 硬件设备虚拟化实现优劣的关键。

VPC overlay network 硬件加速

网络虚拟化的业务需求有:

- 需求 1:带宽线速处理能力;

- 需求 2:极致 E2E 低时延和低时延抖动;

- 需求 3:不丢包条件下的高 pps 转发能力。

目前传统方案遇到的挑战:

- 100Gbps+ 大带宽数据移动,导致 “冯诺依曼内存墙” 问题突出;

- CPU 标量处理网络虚拟化业务,并行性瓶颈明显;

- 基于软件的数据路径处理,时延抖动难以克服。

此时,基于硬件转发加速的业务需求诞生,技术实现层面可以分为:

- 类似于 MNLX ASAP、Intel FXP、Broadcom trueflow 等基于可配置的 ASIC 转发技术:具备最高的性瓦比和最低的转发时延,但是业务灵活性就比较捉襟见肘;

- 基于 many core 的 NPU 技术:具备一定的转发业务灵活性,但是 PPA(power-performance-area)效率和转发时延无法和可配置 ASIC 竞争。

- FPGA 可重配置逻辑实现转发技术:time to market 能力有很大优势,但是对于 400Gbps/800Gbps 转发业务,挑战很大。

EBS 分布式存储接入硬件加速

公有云存储要实现 9 个 9 的数据持久性,且计算和存储要满足弹性业务需求,必然导致存算分离。EBS(阿里云块存储)必须在机头 Initiator 高性能、低时延地接入机尾的分布式存储 Target。

具体需求层面:

- EBS 作为实时存储,必须实现 E2E 极致低时延和极致 P9999 时延抖动;

- 实现线速存储 IO 转发,诸如 200Gbps 网络环境下实现 6M IOPS;

- 新一代 NVMe 硬件 IO 虚拟化,满足共享盘业务需求的同时,解决 PV NVMe 半虚拟化 IO 性能瓶颈。

本地存储虚拟化硬件加速

本地存储,虽然不具备诸如 EBS 9 个 9 的数据持久性和可靠性,但是在低成本、高性能、低时延等方面仍然具备优势,对计算 Cache、大数据等业务场景而言是刚需。

如果做到本地盘虚拟化之后,带宽、IOPS、时延的零衰减,同时兼具一虚多、QoS 隔离能力、可运维能力,是本地存储虚拟化硬件加速的核心竞争力。

弹性 RDMA

RDMA 网络在 HPC、AI、大数据、数据库、存储等 Data centric 业务中,扮演愈来愈重要的技术角色。可以说,RDMA 网络已经成为了 Data centric 业务差异化能力的关键。

具体需求:

- 基于云上 Overlay 网络大规模部署,Overlay 网络可达的地方,RDMA 网络可达;

- RDMA verbs 生态 100% 兼容,IaaS 零代码修改是业务成败的关键;

- 超大规模部署,传统 RoCE 技术基于 PFC 等 Data center bridging 技术,在网络规模和交换网络运维等诸多方面,已经难以为继。云上弹性 RDMA 技术需要摆脱 PFC 和无损网络依赖。

安全硬件加速

持续加强硬件可信技术、VPC 东西向流量全加密、EBS 和本地盘虚拟化数据全量加密,基于硬件的 Enclave 技术等,是云厂商持续提升云业务竞争力的关键。

云可运维能力支撑

云计算的核心是 Service(服务化),从而实现用户对 IT 资源的免运维。而 IaaS 弹性计算可运维能力的核心是:

- 全业务组件的无损热升级能力

- 虚拟机的无损热迁移能力。

弹性裸金属支持

弹性裸金属在具体定义层面必须实现如下八项关键业务特征。同时,云计算弹性业务必然要求弹性裸金属、虚拟机、安全容器等计算资源的并池生产和调度。

CIPU 池化能力

考虑到通用计算和 AI 计算在网络、存储和算力等方面的需求差异巨大,CIPU 必须具备池化能力。通用计算通过 CIPU 池化技术,显著提升 CIPU 资源利用率,从而提升成本层面的核心竞争力;同时又能够在一套 CIPU 技术架构体系下,满足 AI 等高带宽业务需求。

计算虚拟化支撑

计算虚拟化和内存虚拟化的业务特性增强,云厂商均会对 CIPU 有不少核心需求定义。

以上是关于看阿里云 CIPU 的 10 大能力的主要内容,如果未能解决你的问题,请参考以下文章

阿里云发布云数据中心专用处理器CIPU, 构建新一代云计算架构体系