每天5分钟玩转Kubernetes | Health Check在滚动更新中的应用

Posted COCOgsta

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了每天5分钟玩转Kubernetes | Health Check在滚动更新中的应用相关的知识,希望对你有一定的参考价值。

书籍来源:cloudman《每天5分钟玩转Kubernetes》

一边学习一边整理老师的课程内容及试验笔记,并与大家分享,侵权即删,谢谢支持!

Health Check另一个重要的应用场景是Rolling Update。试想一下,现有一个正常运行的多副本应用,接下来对应用进行更新(比如使用更高版本的image),Kubernetes会启动新副本,然后发生了如下事件:

(1)正常情况下新副本需要10秒钟完成准备工作,在此之前无法响应业务请求。

(2)由于人为配置错误,副本始终无法完成准备工作(比如无法连接后端数据库)。

先别继续往下看,现在请花一分钟思考这个问题:如果没有配置Health Check,会出现怎样的情况?

因为新副本本身没有异常退出,默认的Health Check机制会认为容器已经就绪,进而会逐步用新副本替换现有副本,其结果就是:当所有旧副本都被替换后,整个应用将无法处理请求,无法对外提供服务。如果这是发生在重要的生产系统上,后果会非常严重。

如果正确配置了Health Check,新副本只有通过了Readiness探测才会被添加到Service;如果没有通过探测,现有副本不会被全部替换,业务仍然正常进行。

下面通过例子来实践Health Check在Rolling Update中的应用。

使用如下配置文件app.v1.yml模拟一个10副本的应用,如下所示。

[root@k8s-master ~]# cat app.v1.yml

apiVersion: apps/v1

kind: Deployment

metadata:

name: app

spec:

replicas: 10

selector:

matchLabels:

run: app

template:

metadata:

labels:

run: app

spec:

containers:

- name: app

image: busybox

args:

- /bin/sh

- -c

- sleep 10; touch /tmp/healthy; sleep 30000

readinessProbe:

exec:

command:

- cat

- /tmp/healthy

initialDelaySeconds: 10

periodSeconds: 5

[root@k8s-master ~]#

10秒后副本能够通过Readiness探测,如图所示。

接下来滚动更新应用,配置文件app.v2.yml,如图下所示。

[root@k8s-master ~]# cat app.v2.yml

apiVersion: apps/v1

kind: Deployment

metadata:

name: app

spec:

replicas: 10

selector:

matchLabels:

run: app

template:

metadata:

labels:

run: app

spec:

containers:

- name: app

image: busybox

args:

- /bin/sh

- -c

- sleep 3000

readinessProbe:

exec:

command:

- cat

- /tmp/healthy

initialDelaySeconds: 10

periodSeconds: 5

[root@k8s-master ~]#

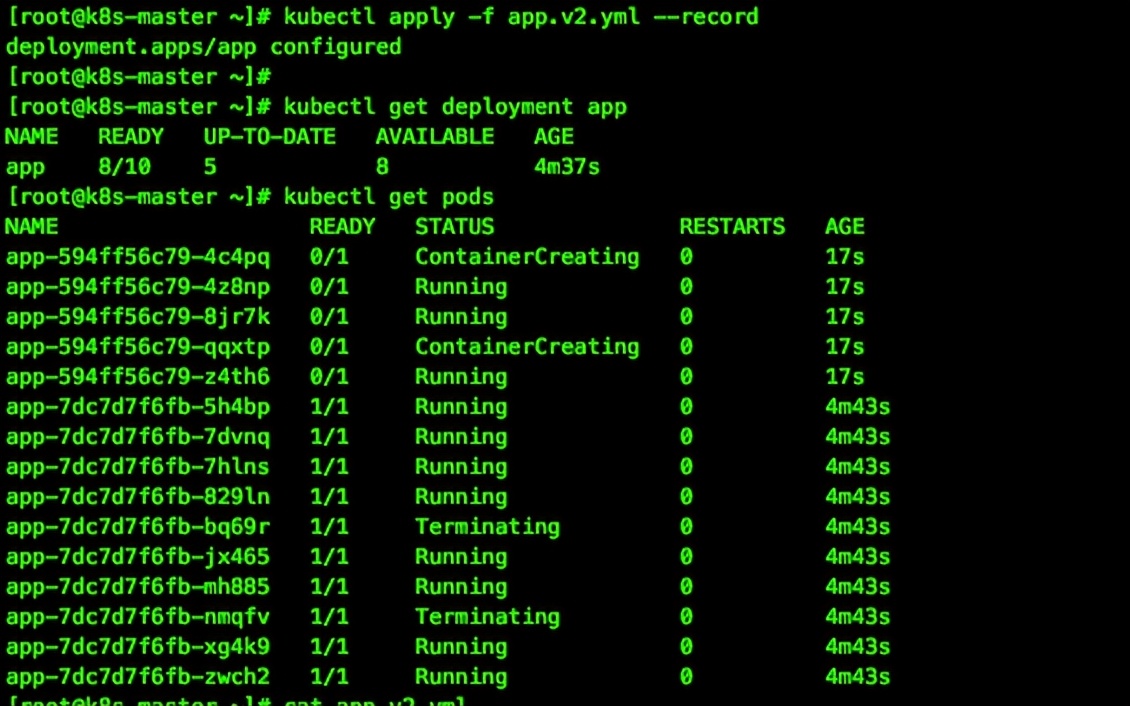

很显然,由于新副本中不存在/tmp/healthy,因此是无法通过Readiness探测的,验证如图所示。

这个截图包含了大量的信息,值得我们详细分析。

先关注kubectl get pod输出:

(1)从Pod的AGE栏可判断,前面5个Pod是新副本,目前处于NOT READY状态。

(2)旧副本从最初10个减少到8个。

再来看kubectl get deployment app的输出:

(1)READY /10表示期望的状态是10个READY的副本。

(2)READY 8/表示当前副本的总数,即8个副本。

(2)UP-TO-DATE 5表示当前已经完成更新的副本数,即5个新副本。

(3)AVAILABLE 8表示当前处于READY状态的副本数,即8个旧副本。

在我们的设定中,新副本始终都无法通过Readiness探测,所以这个状态会一直保持下去。

上面我们模拟了一个滚动更新失败的场景。不过幸运的是:Health Check帮我们屏蔽了有缺陷的副本,同时保留了大部分旧副本,业务没有因更新失败受到影响。

接下来我们要回答:为什么新创建的副本数是5个,同时只销毁了2个旧副本?

原因是:滚动更新通过参数maxSurge和maxUnavailable来控制副本替换的数量。

1. maxSurge

此参数控制滚动更新过程中副本总数超过DESIRED的上限。maxSurge可以是具体的整数(比如3),也可以是百分百,向上取整。maxSurge默认值为25%。

在上面的例子中,DESIRED为10,那么副本总数的最大值为roundUp(10 + 10 * 25%) =13,所以我们看到CURRENT就是13(8+5)。

2. maxUnavailable

此参数控制滚动更新过程中,不可用的副本相占DESIRED的最大比例。maxUnavailable可以是具体的整数(比如3),也可以是百分百,向下取整。maxUnavailable默认值为25%。

在上面的例子中,DESIRED为10,那么可用的副本数至少要为10 - roundDown(10 * 25%)= 8,所以我们看到AVAILABLE是8。

maxSurge值越大,初始创建的新副本数量就越多;

maxUnavailable值越大,初始销毁的旧副本数量就越多。

理想情况下,我们这个案例滚动更新的过程应该是这样的:

(1)创建3个新副本使副本总数达到13个。

(2)销毁2个旧副本使可用的副本数降到8个。

(3)当2个旧副本成功销毁后,再创建2个新副本,使副本总数保持为13个。

(4)当新副本通过Readiness探测后,会使可用副本数增加,超过8。

(5)进而可以继续销毁更多的旧副本,使可用副本数回到8。

(6)旧副本的销毁使副本总数低于13,这样就允许创建更多的新副本。

(7)这个过程会持续进行,最终所有的旧副本都会被新副本替换,滚动更新完成。

而我们的实际情况是在第4步就卡住了,新副本无法通过Readiness探测。这个过程可以在kubectl describe deployment app的日志部分查看,如图所示。

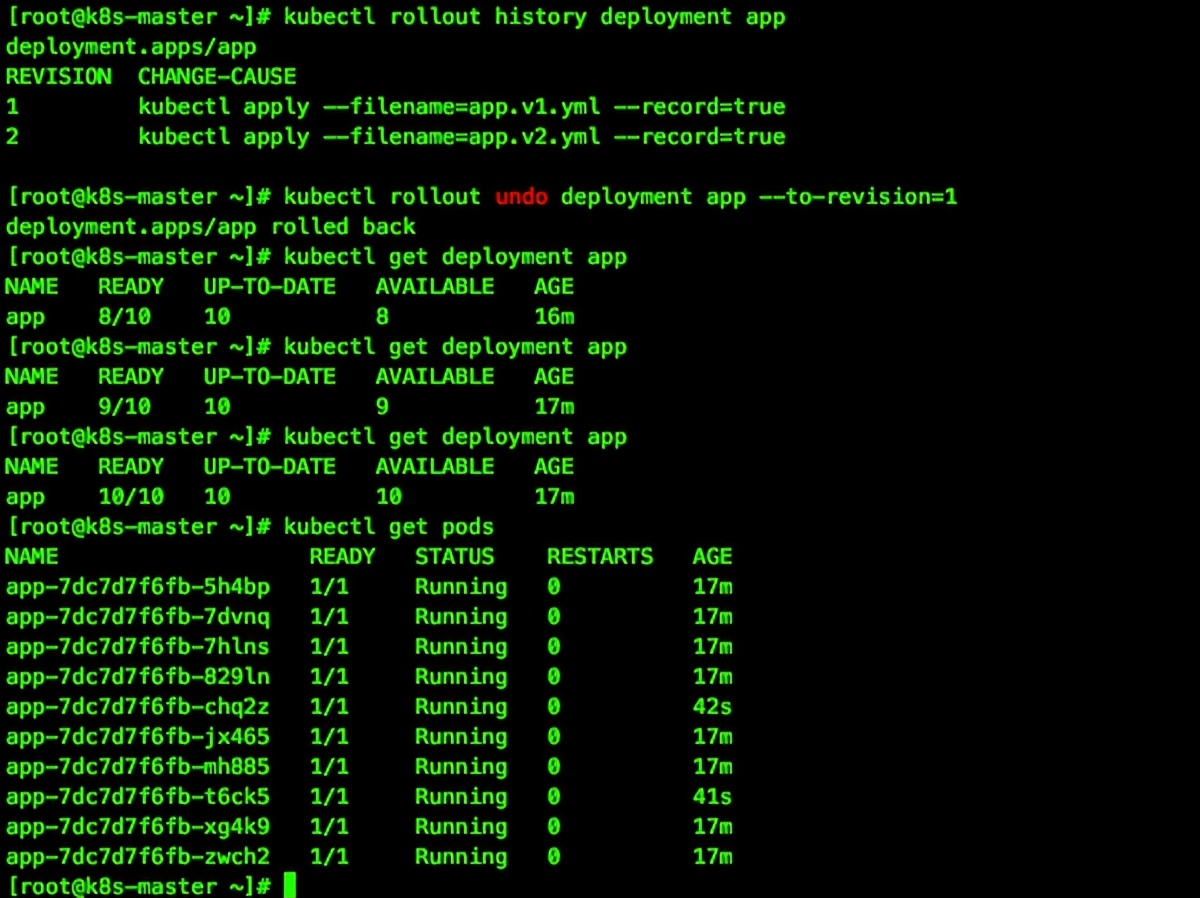

如果滚动更新失败,可以通过kubectl rollout undo回滚到上一个版本,如图所示。

如果要定制maxSurge和maxUnavailable,可以进行如下所示的配置。

[root@k8s-master ~]# cat app.v2.yml

apiVersion: apps/v1

kind: Deployment

metadata:

name: app

spec:

strategy:

rollingUpdate:

maxSurge: 35%

maxUnavailable: 35%

replicas: 10

selector:

matchLabels:

run: app

template:

metadata:

labels:

run: app

spec:

containers:

- name: app

image: busybox

args:

- /bin/sh

- -c

- sleep 3000

readinessProbe:

exec:

command:

- cat

- /tmp/healthy

initialDelaySeconds: 10

periodSeconds: 5

[root@k8s-master ~]#

以上是关于每天5分钟玩转Kubernetes | Health Check在滚动更新中的应用的主要内容,如果未能解决你的问题,请参考以下文章

每天5分钟玩转Kubernetes | Kubernetes Dashboard安装

每天5分钟玩转Kubernetes | Deployment

每天5分钟玩转Kubernetes | Deployment