伪分布式Hadoop + zookeeper + Hbase

Posted sleepy-ff

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了伪分布式Hadoop + zookeeper + Hbase相关的知识,希望对你有一定的参考价值。

目的:

CentOS7 安装 Hadoop 伪分布式环境

组件版本信息:

Hadoop: 2.7.7

Hbase: 1.4.8

zookeeper:3.4.7

资料下载:

资料包含:虚拟机安装包,CentOS7镜像,所需组件

链接:https://pan.baidu.com/s/1-Ye0vppf19bYQ9SUEDqHXg 提取码:hysl

Linux 设置:

(1.)关闭防火墙:

systemctl stop firewalld.service #停止firewall

systemctl disable firewalld.service #禁止firewall开机启动

免密登陆

ssh-keygen -t rsa -P ‘‘ -f ~/.ssh/id_rsa

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

chmod 0600 ~/.ssh/authorized_keys

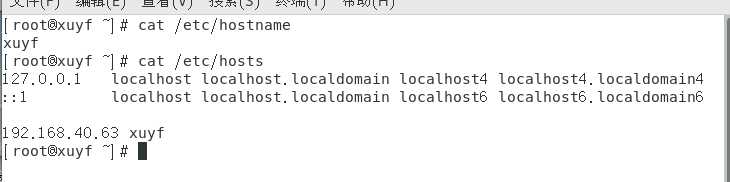

(2.)修改主机名:

vim /etc/hosts 【添加 IP 和自定义主机名】

vim /etc/hostname 【删除原有内容,替换为自定义主机名】

(3.)重启虚拟机

reboot / init 6

=================【安装前 准备】=================

cd /usr/local

mkdir mytars bigdata

所有 软件包存放在 /usr/local/mytars

所有 文件解压在 /usr/local/bigdata

==============================================

(4.)安装jdk

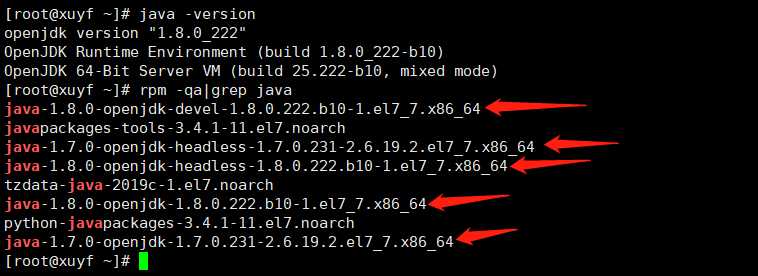

<1.> 查看 是否自带openJDK

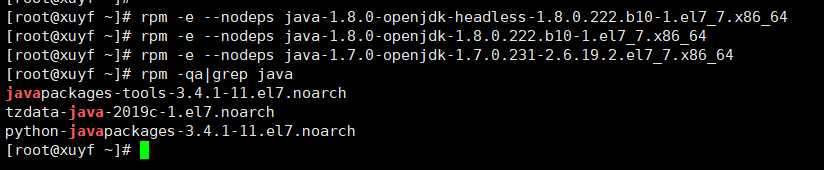

<2.> 删除 openJDK

使用 rpm -e --nodeps ... 命令进行删除;删除标准以不删除不带箭头的内容为标准

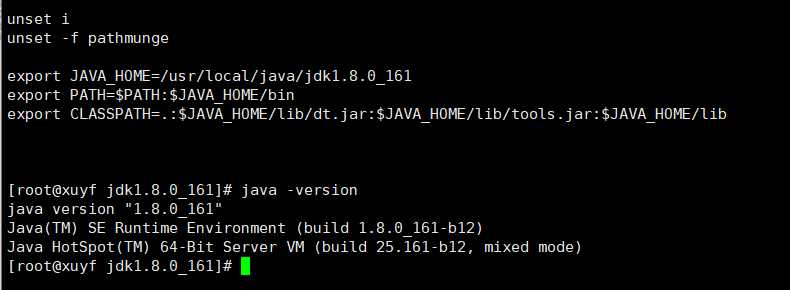

<4.> 安装JDK

#cd /usr/local

#mkdir java

#tar java.tar.gz -C /usr/local/java

<5.> 配置环境变量

vim /etc/profile

(5.)安装 Hadoop 【解压命令就不写了】

<1.> 修改配置文件

================>>>>>>> core-site.xml

<property>

<name>hbase.rootdir</name>

<value>hdfs://xuyf:9000/hbase</value>

</property>

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

<property>

<name>hbase.master</name>

<value>xuyf:60000</value>

</property>

<property>

<name>hbase.zookeeper.quorum</name>

<value>xuyf</value>

</property>

<property>

<name>hbase.tmp.dir</name>

<value>/root/hbase/tmp</value>

</property>

================>>>>>>> hadoop-env.sh

export JAVA_HOME=/usr/local/java/jdk1.8.0_161

================>>>>>>> hdfs-site.xml

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>/usr/local/bigdata/hadoop-2.7.7/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/usr/local/bigdata/hadoop-2.7.7/tmp/dfs/data</value>

</property>

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>xuyf:50090</value>

</property>

================>>>>>>> mapred-site.xml

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

================>>>>>>> yarn-site.xml

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

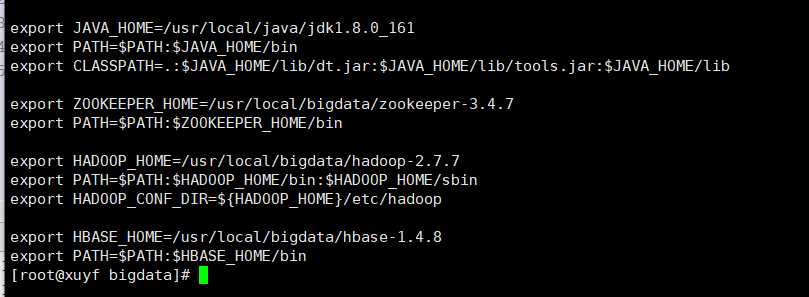

<2. > 配置环境变量 【包括所有组件的配置方法,SO 后面不再写了】

修改命令:vim /etc/profile

使之生效:source /etc/profile

<3. > 格式化namenode 启动并检查

// 格式化namenode

cd hadoop2.7.7/bin/

./hdfs namenode -format

// 启动 Hadoop

cd hadoop2.7.7/sbin/

./start-all.sh

// 检查方式:

(1.) jps ==> 显示:namenode,secondarynamenode,datanode,nodemanager.resourcemanager

(2.) 检查namenode web页面: 主机ip / 主机映射名:50070

(6.) 安装Zookeeper

<1.> 进入conf目录并拷贝默认的配置文件模板zoo_sample.cfg,并命名为zoo.cfg,并修改

// 修改

dataDir=/usr/local/bigdata/zookeeper-3.4.7/data dataLogDir=/usr/local/bigdata/zookeeper-3.4.7/logs

// 结尾处添加 server.1=xuyf:2888:3888

<2. >创建dataDir 和 dataLogDir 目录。

<3. >echo 1 > /usr/local/bigdata/zookeeper-3.4.7/data/myid

<4. >执行bin目录下的zkServer.sh start ,启动zookeeper

(7.) 安装Hbase

<1. >修改配置文件

================>>>>>>> hbase-env.sh

export JAVA_HOME=/usr/local/java/jdk1.8.0_161

export HADOOP_HOME=/usr/local/bigdata/hadoop-2.7.7

export HBASE_HOME=/usr/local/bigdata/hbase-1.4.8

export HBASE_CLASSPATH=/usr/local/bigdata/hadoop-2.7.7/etc/hadoop

export HBASE_MANAGES_ZK=false

================>>>>>>> hbase-site.xml

<property>

<name>hbase.rootdir</name>

<value>hdfs://xuyf:9000/hbase</value>

</property>

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

<property>

<name>hbase.master</name>

<value>xuyf:60000</value>

</property>

<property>

<name>hbase.zookeeper.quorum</name>

<value>xuyf</value>

</property>

<property>

<name>hbase.tmp.dir</name>

<value>/root/hbase/tmp</value>

</property>

================>>>>>>> regionservers

xuyf

<2. >注意事项:

hbase-site.xml中hbase.tmp.dir指定hbase的临时数据存储目录为/root/hbase/tmp,注意启动hbase前需要提前建立好对应目录

<3. >执行bin目录下的start-hbase.sh 启动 Hbase

<4.>检查

jps ==》HMaster ,HRegionServer

web ==》主机ip / 主机映射名:16010

以上是关于伪分布式Hadoop + zookeeper + Hbase的主要内容,如果未能解决你的问题,请参考以下文章

CentOS 7 伪分布式搭建 hadoop+zookeeper+hbase+opentsdb