1.使用hadoop是需要jdk环境的,因为hadoop里面有java程序,而运行java程序需要jdk。

2.从宿主机上传文件到虚拟机有很多方法,我选择的是在虚拟机安装lrzsz,安装lrzsz命令行:yum install -y lrzsz

3.确定好软件安装路径

/opt #工作目录

/opt/installed #安装包

/opt/software #软件包

/opt/other #其他

/opt/test #测试

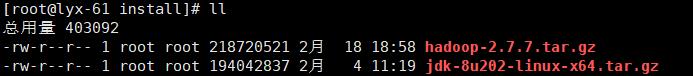

4.上传软件包

cd /opt/installed

rz #从宿主机下载jdk和hadoop的tar.gz包

hadoop的下载地址:https://dist.apache.org/repos/dist/release/hadoop/common/

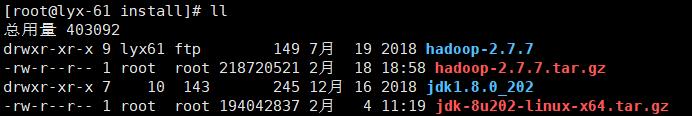

5.解压软件包

#如果虚拟机没有安装tar 使用yum安装:yum install -y tar

tar -zxvf jdk-8u202-linux-x64.tar.gz

tar -zxvf hadoop-2.7.7.tar.gz

6.把解压的jdk和hadoop移动到/opt/software/下面

mv jdk1.8.0_202 /opt/software/

mv hadoop-2.7.7 /opt/software/

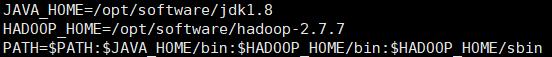

7.配置两个软件的环境变量

vi /etc/profile

i 编辑

在最下面写入

Esc 命令模式

:wq 保存

source /etc/profile

8.修改主机名(原本是localhost)

vim /etc/hostname localhost修改成hadoop101

修改主机映射

vim /etc/hosts 在最下面写入 192.168.31.54(自己的虚拟机ip地址) hadoop01(刚刚修改的主机名)

9.修改六个配置文件,全部在hadoop目录下的etc/hadoop/下面

cd /opt/software/hadoop-2.7.7/etc/hadoop/ #配置全部在这个目录下

vim hadoop-env.sh #编辑配置文件hadoop-env.sh

export JAVA_HOME=/opt/software/jdk1.8 #修改25行

export HADOOP_CONF_DIR=/opt/software/hadoop-2.7.7/etc/hadoop #修改33行

vim core-site.xml #编辑配置文件core-site.xml

<configuration>

<!-- 指定HDFS中NameNode的地址 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop101:9000</value>

</property>

<!-- 指定hadoop运行时产生文件的存储目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/software/hadoop-2.7.7/tmp</value>

</property>

</configuration>

vim hdfs-site.xml #编辑配置文件hdfs-site.xml

<configuration>

<!-- 指定HDFS副本的数量 -->

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

</configuration>

vim mapred-site.xml #编辑配置文件mapred-site.xml

<!-- 指定mr运行在yarn上 -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

vim yarn-site.xml #编辑配置文件

<!-- 指定YARN的ResourceManager的地址 -->

<property>

<name>yarn.resourcemanager.hostname</name>

<value>hadoop101</value>

</property>

<!-- reducer获取数据的方式 -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

vim slaves #编辑配置文件

只需要写入主机名就可 hadoop101

10.格式化文件系统 文件系统必须格式化才能使用

hadoop namenode -format

11.配置免密通信 因为启动hadoop要多次输入密码

ssh-keygen #创建密钥#

ssh-copy-id hadoop101 #将公钥复制到hadoop101 也就是本机

11.启动hadoop

start-all.sh #启动

stop-all.sh #停止