配置hadoop本地开发环境

Posted toFuture

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了配置hadoop本地开发环境相关的知识,希望对你有一定的参考价值。

摘要:

配置本地hadoop开发环境

配置在Eclipse环境中管理hdfs目录

hadoop下载:

https://mirrors.tuna.tsinghua.edu.cn/apache/hadoop/common //清华镜像

https://mirror.bit.edu.cn/apache/hadoop/common

https://downloads.apache.org/hadoop/common/

所有Hadoop版本

https://archive.apache.org/dist/hadoop/common/

1.本地hadoop开发环境配置

保证本机配置好jdk、安装好eclipse //我的eclipse是用的绿色版

1)windows安装hadoop

我的分布式环境hadoop版本号是2.7.5,因此下载hadoop2.7.5.zip

解压后路径:E:\\java\\hadoop

2)配置系统环境变量

配置系统变量HADOOP_HOME:E:\\java\\hadoop

配置系统变量Path: 在最后追加%HADOOP_HOME%\\bin

3)配置本地运行MR程序

E:\\java\\hadoop \\bin目录下的winutils.exe和hadoop.dll拷贝到C:\\Windows\\System32目录下。

说明:windows本地运行mr程序时(不提交到yarn,运行在jvm单线程执行),hadoop.dll防止报nativeio异常、winutils.exe没有的话报空指针异常。

2.eclipse中安装hadoop插件

1)下载插件

也可以下载hadoop-eclipse-plugin插件

https://github.com/winghc/hadoop2x-eclipse-plugin

放到eclipse-oxygen\\plugins 或 eclipse-oxygen\\dropins下

我下载的hadoop-eclipse-plugin-2.7.5.jar,放到E:\\java\\eclipse-oxygen\\plugins中

2)安装配置插件

重启eclipse

进入Windows –Preferences,我们会看见多了一个Hadoop MapReduce,说明我们安装好了eclipse的hadoop插件。

配置插件:点击Hadoop Map/Reduce选项,进入配置页面,点击Browse,选择Hadoop安装路径。 ##我的路径是E:\\java\\hadoop

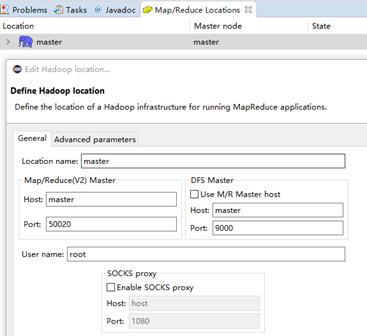

3.配置Map/Reduce Location

打开 Windows—> show view —> Other,选择MapReduce Tools下的Map/Reduce Locations。

点击下图右上角位置的小象,进入配置页面。

说明:

Location name自定义一个名字就行;

配置Map/Reduce Master

Host:master节点的hostname

Port:50070

说明:50070是hdfs文件系统的端口,192.168.56.110:50070可以查看你文件系统

配置DFS Master

port为HDFS端口号,默认是9000

User name为安装Hadoop节点用户名称

##我的master节点 [root@master hadoop]#,因此我的user name是root

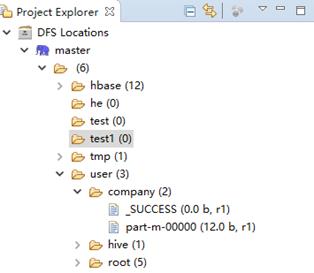

4.测试

在Xshell中,连接master,在hdfs中创建文件夹he

[root@master hadoop]# hadoop fs -mkdir /he

在eclipse中就可以适合地看见hdfs文件的情况。如下图:

通过浏览器也可以查看hdfs的情况:

http://192.168.56.110:50070/explorer.html#/

备注:一定要修改

C:\\Windows\\System32\\drivers\\etc\\hosts文件

192.168.56.110 master ##在这里耗费了好会儿

到此,eclipse配置本地hadoop环境ok。

以上是关于配置hadoop本地开发环境的主要内容,如果未能解决你的问题,请参考以下文章