大数据技术之_03_Hadoop学习_02_入门_Hadoop运行模式+本地运行模式+伪分布式运行模式+完全分布式运行模式(开发重点)+Hadoop编译源码(面试重点)+常见错误及解决方案(示例代(代

Posted haha

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了大数据技术之_03_Hadoop学习_02_入门_Hadoop运行模式+本地运行模式+伪分布式运行模式+完全分布式运行模式(开发重点)+Hadoop编译源码(面试重点)+常见错误及解决方案(示例代(代相关的知识,希望对你有一定的参考价值。

第4章 Hadoop运行模式4.1 本地运行模式4.1.1 官方Grep案例4.1.2 官方WordCount案例4.2 伪分布式运行模式4.2.1 启动HDFS并运行MapReduce程序4.2.2 启动YARN并运行MapReduce程序4.2.3 配置历史服务器4.2.4 配置日志的聚集4.2.5 配置文件说明4.3 完全分布式运行模式(开发重点)4.3.1 虚拟机准备4.3.2 编写集群分发脚本xsync4.3.3 集群配置4.3.4 集群单点启动4.3.5 SSH无密登录配置4.3.6 群起集群4.3.7 集群启动/停止方式总结4.3.8 集群时间同步第5章 Hadoop编译源码(面试重点)5.1 前期准备工作5.2 jar包安装5.3 编译源码第6章 常见错误及解决方案

第4章 Hadoop运行模式

Hadoop运行模式包括:本地模式、伪分布式模式以及完全分布式模式。

Hadoop官方网站:http://hadoop.apache.org/

4.1 本地运行模式

4.1.1 官方Grep案例

1、创建在hadoop-2.7.2文件下面创建一个input文件夹

[atguigu@hadoop101 hadoop-2.7.2]$ mkdir input

2、将Hadoop的xml配置文件复制到input

[atguigu@hadoop101 hadoop-2.7.2]$ cp etc/hadoop/*.xml input/

3、执行share目录下的MapReduce程序

[atguigu@hadoop101 hadoop-2.7.2]$ bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.2.jar grep input/ output/ \'dfs[a-z.]+\'

4、查看输出结果

[atguigu@hadoop101 hadoop-2.7.2]$ cat output/*

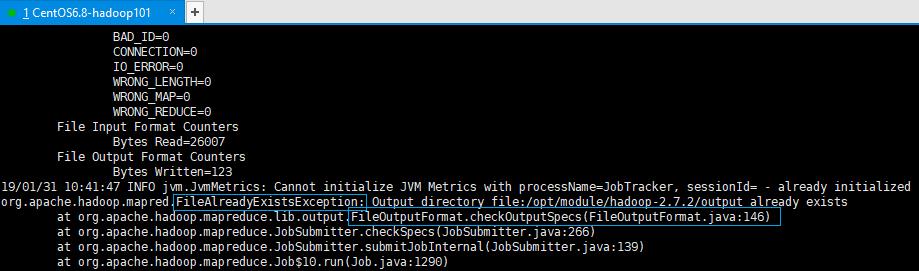

注意1:在大数据案例中,所有代码必须有输入路径和输出路径。注意2:output目录不能先存在,否则会报“文件夹已存在”异常。如下图所示:

4.1.2 官方WordCount案例

1、创建在hadoop-2.7.2文件下面创建一个wcinput文件夹

[atguigu@hadoop101 hadoop-2.7.2]$ mkdir wcinput

2、在wcinput文件下创建一个wc.input文件

[atguigu@hadoop101 hadoop-2.7.2]$ cd wcinput

[atguigu@hadoop101 wcinput]$ touch wc.input

3、编辑wc.input文件

[atguigu@hadoop101 wcinput]$ vim wc.input

在文件中输入如下内容

hadoop yarn

hadoop mapreduce

atguigu

atguigu

保存退出 :wq

4、回到Hadoop目录/opt/module/hadoop-2.7.2

5、执行程序

[atguigu@hadoop101 hadoop-2.7.2]$ hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.2.jar wordcount wcinput/ wcoutput/

6、查看结果

[atguigu@hadoop101 hadoop-2.7.2]$ cat wcoutput/part-r-00000

atguigu 2

doop 1

hadoop 1

mapreduce 1

yarn 1

4.2 伪分布式运行模式

4.2.1 启动HDFS并运行MapReduce程序

1、分析

(1)配置集群

(2)启动、测试集群增、删、查

(3)执行WordCount案例

2、执行步骤

(1)配置集群

(a)配置:hadoop-env.sh

先Linux系统中获取JDK的安装路径:

[atguigu@ hadoop101 ~]# echo $JAVA_HOME

/opt/module/jdk1.8.0_144

修改JAVA_HOME路径:

export JAVA_HOME=/opt/module/jdk1.8.0_144

(b)配置:core-site.xml

[atguigu@hadoop101 hadoop]$ pwd

/opt/module/hadoop-2.7.2/etc/hadoop

[atguigu@hadoop101 hadoop]$ vim core-site.xml

修改如下:

<!-- 指定HDFS中NameNode的地址 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop101:9000</value>

</property>

<!-- 指定Hadoop运行时产生文件的存储目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/module/hadoop-2.7.2/data/tmp</value>

</property>

(c)配置:hdfs-site.xml

<!-- 指定HDFS副本的数量 -->

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

注意:默认是3个HDFS副本(3台服务器各备份1份,不是1台服务器备份3份)。

(2)启动集群

(a)格式化NameNode(第一次启动时格式化,以后就不要总格式化!)

[atguigu@hadoop101 hadoop-2.7.2]$ bin/hdfs namenode -format

(b)启动NameNode

[atguigu@hadoop101 hadoop-2.7.2]$ sbin/hadoop-daemon.sh start namenode

(c)启动DataNode

[atguigu@hadoop101 hadoop-2.7.2]$ sbin/hadoop-daemon.sh start datanode

(3)查看集群

(a)查看是否启动成功

[atguigu@hadoop101 hadoop-2.7.2]$ jps

3090 DataNode

2995 NameNode

3161 Jps

注意:jps是JDK中的命令,不是Linux命令。不安装JDK不能使用jps。

(b)web端查看HDFS文件系统

http://hadoop101:50070/dfshealth.html#tab-overview注意:如果不能查看,看如下帖子处理:

http://www.cnblogs.com/zlslch/p/6604189.html

(c)查看产生的logs日志说明:在企业中遇到Bug时,经常根据日志提示信息去分析问题、解决Bug。

当前目录:/opt/module/hadoop-2.7.2/logs

[atguigu@hadoop101 logs]$ ls

hadoop-atguigu-datanode-hadoop.atguigu.com.log

hadoop-atguigu-datanode-hadoop.atguigu.com.out

hadoop-atguigu-namenode-hadoop.atguigu.com.log

hadoop-atguigu-namenode-hadoop.atguigu.com.out

SecurityAuth-root.audit

[atguigu@hadoop101 logs]# cat hadoop-atguigu-datanode-hadoop101.log

(d)思考:为什么不能一直格式化NameNode,格式化NameNode,要注意什么?

[atguigu@hadoop101 hadoop-2.7.2]$ cd data/tmp/dfs/name/current/

[atguigu@hadoop101 current]$ cat VERSION

clusterID=CID-f0330a58-36fa-4a2a-a65f-2688269b5837

[atguigu@hadoop101 hadoop-2.7.2]$ cd data/tmp/dfs/data/current/

[atguigu@hadoop101 current]$ cat VERSION

clusterID=CID-f0330a58-36fa-4a2a-a65f-2688269b5837

注意:格式化NameNode,会产生新的集群id,导致NameNode和DataNode的集群id不一致,集群找不到已往数据。所以,格式NameNode时,一定要先删除data数据目录和logs日志目录,然后再格式化NameNode。

(4)操作集群

(a)在HDFS文件系统上创建一个input文件夹

[atguigu@hadoop101 hadoop-2.7.2]$ bin/hdfs dfs -mkdir -p /user/atguigu/input/

(b)将测试文件内容上传到文件系统上

[atguigu@hadoop101 hadoop-2.7