指导手册03:Hadoop基础操作

Posted 飞鸟博客

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了指导手册03:Hadoop基础操作相关的知识,希望对你有一定的参考价值。

指导手册03:Hadoop基础操作

Part 1:查看Hadoop集群的基本信息

1.查询存储系统信息

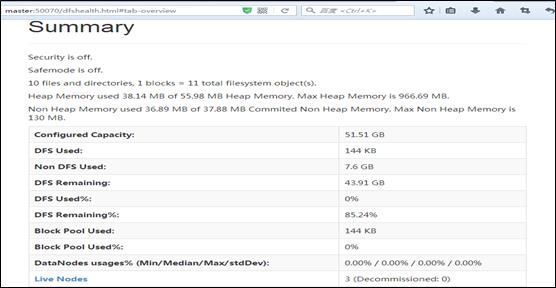

(1)在WEB浏览器的地址栏输入http://master:50070/

1.查询存储系统信息

(1)在WEB浏览器的地址栏输入http://master:50070/

请查看自己的Hadoop集群填写下表

|

Configured Capacity:己配置的文件系统存储总量 |

|

|

DFS Remaining :可使用的DFS存储总量 |

|

|

Non DFS Used 被非DFS的应用所占用的存储总量 |

|

|

DFS Used:己使用的 DFS存储总量 |

|

|

Live Nodes: 在线的数据节点: |

|

(2)显示数据节点信息

report:输出文件系统的基本信息及相关数据统计。

-report -live:输出文件系统中在线节点的基本信息及相关数据统计。

-report -dead:输出文件系统中失效节点的基本信息及相关数据统计。

-report -decommissioning:输出文件系统中停用节点的基本信息及相关数据统计。

查询HDFS信息的命令

Hdfs dfsadmin –report [-live] [-dead] [decommissioning]report:输出文件系统的基本信息及相关数据统计。

-report -live:输出文件系统中在线节点的基本信息及相关数据统计。

-report -dead:输出文件系统中失效节点的基本信息及相关数据统计。

-report -decommissioning:输出文件系统中停用节点的基本信息及相关数据统计。

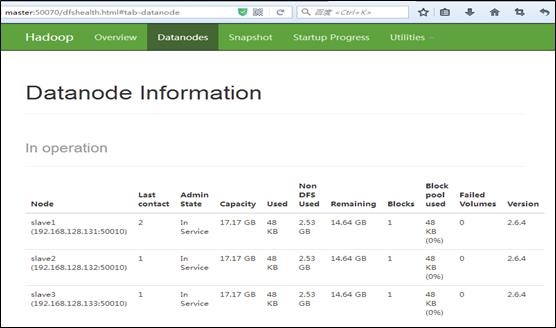

例:hdfs dfsadmin –report –live 查看在线节点的基本信息,请填写下表。

|

节点名(Node) |

总存储空间(capacity) |

己使用(DFS Used) |

DFS没使用(Non DFS Used) |

DFS 剩余(Remaining) |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

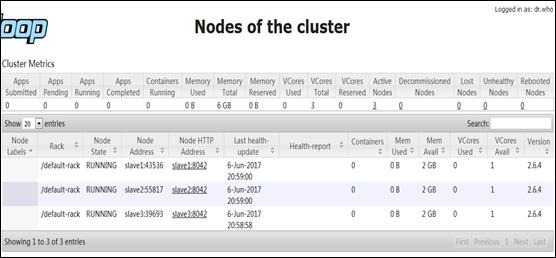

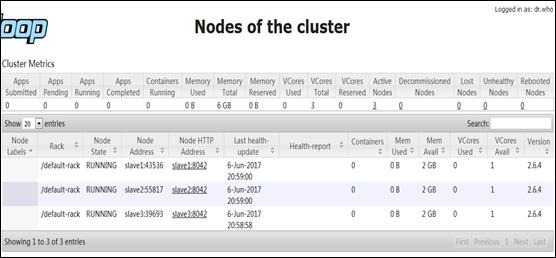

(3)查询集群的计算资源信息

在浏览器的地址栏输入“http://master:8088/cluster/nodes”

继续单击页面上的超链接“slave1:8042”,可以显示计算机slave1的各项资源信息。

Part 2:上传文件到HDFS目录

情景描述:

把存储在本机中的原始数据文件email_log.txt上传到Hadoop集群中的HDFS目录/user/root/

1.HDFS的基本操作

在本地计算机的Web浏览器可远程访问HDFS的监控服务端口(http://master:50070)。当需要访问HDFS上的目录及文件时,推荐使用http://master:50070/nn_browsedfscontent.jsp

情景描述:

把存储在本机中的原始数据文件email_log.txt上传到Hadoop集群中的HDFS目录/user/root/

1.HDFS的基本操作

在本地计算机的Web浏览器可远程访问HDFS的监控服务端口(http://master:50070)。当需要访问HDFS上的目录及文件时,推荐使用http://master:50070/nn_browsedfscontent.jsp

在集群服务器的终端输入“hdfs dfs”命令,可以完成对HDFS目录及文件的大部分管理操作。

(1) 创建新目录

hdfs dfs -mkdir [-p] <path> -p:不加只能逐级创建目录,加了可以多级创建目录

例:

[root@master]#hdfs dfs –mkdir –p /user/dfstest

[root@master]#hdfs dfs –mkdir –p /user/test/example

(2) 上传文件

(1) 创建新目录

hdfs dfs -mkdir [-p] <path> -p:不加只能逐级创建目录,加了可以多级创建目录

例:

[root@master]#hdfs dfs –mkdir –p /user/dfstest

[root@master]#hdfs dfs –mkdir –p /user/test/example

(2) 上传文件

需先关闭防火墙:service iptables stop

命令 解释

hdfs dfs [-copyFromLocal [-f] [-p] [-l] <localsrc> ... <dst>] 将文件从本地文件系统拷贝到HDFS文件系统,主要参数<localsrc>为本地文件路径,<dst>为拷贝的目标路径。

hdfs dfs [-moveFromLocal <localsrc> ... <dst>] 将文件从本地文件系统移动到HDFS文件系统,主要参数<localsrc>为本地文件路径,<dst>为移动的目标路径。

hdfs dfs [-put [-f] [-p] [-l] <localsrc> ... <dst>]

将文件从本地文件系统上传到HDFS文件系统,主要参数<localsrc>为本地文件路径,<dst>为上传的目标路径。

例:

将集群服务器节点上的本地文件a.txt上传到HDFS目录/user/dfstest中。(a.txt请自行新建)

[root@master hadoop-2.6.4] #hdfs dfs –copyFromLocal a.txt /user/dfstest

[root@master hadoop-2.6.4] #hdfs dfs –moveFromLocal a.txt /user/dfstest/b.txt

[root@master hadoop-2.6.4] #hdfs dfs –put a.txt /user/dfstest/c.txt

命令 解释

hdfs dfs [-copyFromLocal [-f] [-p] [-l] <localsrc> ... <dst>] 将文件从本地文件系统拷贝到HDFS文件系统,主要参数<localsrc>为本地文件路径,<dst>为拷贝的目标路径。

hdfs dfs [-moveFromLocal <localsrc> ... <dst>] 将文件从本地文件系统移动到HDFS文件系统,主要参数<localsrc>为本地文件路径,<dst>为移动的目标路径。

hdfs dfs [-put [-f] [-p] [-l] <localsrc> ... <dst>]

将文件从本地文件系统上传到HDFS文件系统,主要参数<localsrc>为本地文件路径,<dst>为上传的目标路径。

例:

将集群服务器节点上的本地文件a.txt上传到HDFS目录/user/dfstest中。(a.txt请自行新建)

[root@master hadoop-2.6.4] #hdfs dfs –copyFromLocal a.txt /user/dfstest

[root@master hadoop-2.6.4] #hdfs dfs –moveFromLocal a.txt /user/dfstest/b.txt

[root@master hadoop-2.6.4] #hdfs dfs –put a.txt /user/dfstest/c.txt

(3) 下载文件

命令 解释

hdfs dfs [-copyToLocal [-p] [-ignoreCrc] [-crc] <src>... <localdst>] 将文件从HDFS文件系统拷贝到本地文件系统,主要参数<src>为HDFS文件系统路径,<localdst>为本地文件系统路径。

hdfs dfs [-get [-p] [-ignoreCrc] [-crc] <src>...<localdst>] 获取HDFS文件系统上指定路径的文件到本地文件系统,主要参数<src>为HDFS文件系统路径,<localdst>为本地文件系统路径。

例:

从/user/dfstest中下载a.txt和c.txt,存储在集群服务器节点master上的本地目录/data/hdfs_test/中。(hdfs_test目录请自行创建)

[root@master hdfs_test] #hdfs dfs –copyToLocal /user/dfstest/a.txt

[root@master hdfs_test] #hdfs dfs get /user/dfstest/c.txt

[root@master hdfs_test] # ls

命令 解释

hdfs dfs [-copyToLocal [-p] [-ignoreCrc] [-crc] <src>... <localdst>] 将文件从HDFS文件系统拷贝到本地文件系统,主要参数<src>为HDFS文件系统路径,<localdst>为本地文件系统路径。

hdfs dfs [-get [-p] [-ignoreCrc] [-crc] <src>...<localdst>] 获取HDFS文件系统上指定路径的文件到本地文件系统,主要参数<src>为HDFS文件系统路径,<localdst>为本地文件系统路径。

例:

从/user/dfstest中下载a.txt和c.txt,存储在集群服务器节点master上的本地目录/data/hdfs_test/中。(hdfs_test目录请自行创建)

[root@master hdfs_test] #hdfs dfs –copyToLocal /user/dfstest/a.txt

[root@master hdfs_test] #hdfs dfs get /user/dfstest/c.txt

[root@master hdfs_test] # ls

(3) 查看文件内容

命令 解释

hdfs dfs [-cat [-ignoreCrc] <src> ...] 查看HDFS文件内容,主要参数<src>指示文件路径。

hdfs dfs [-tail [-f] <file>] 输出HDFS文件最后1024字节,主要参数<file>指定文件。

例:

[root@master hdfs_test] #hdfs dfs –cat /user/dfstest/a.txt

[root@master hdfs_test] #hdfs dfs –tail /user/dfstest/c.txt

命令 解释

hdfs dfs [-cat [-ignoreCrc] <src> ...] 查看HDFS文件内容,主要参数<src>指示文件路径。

hdfs dfs [-tail [-f] <file>] 输出HDFS文件最后1024字节,主要参数<file>指定文件。

例:

[root@master hdfs_test] #hdfs dfs –cat /user/dfstest/a.txt

[root@master hdfs_test] #hdfs dfs –tail /user/dfstest/c.txt

(4) 删除文件或目录

命令 解释

hdfs dfs [-rm [-f] [-r|-R] [-skipTrash] <src> ...] 删除HDFS上的文件,主要参数-r用于递归删除,<src>指定删除文件的路径。

hdfs dfs [-rmdir [--ignore-fail-on-non-empty] <dir> ...] 如果删除的是一个目录,则可以用该方法,主要参数<dir>指定目录路径。

例:

[root@master hdfs_test] #hdfs dfs –mkdir /user/dfstest/rmdir

[root@master hdfs_test] #hdfs dfs –rm /user/dfstest/c.txt

[root@master hdfs_test] #hdfs dfs –rmdir /user/dfstest/rmdir

命令 解释

hdfs dfs [-rm [-f] [-r|-R] [-skipTrash] <src> ...] 删除HDFS上的文件,主要参数-r用于递归删除,<src>指定删除文件的路径。

hdfs dfs [-rmdir [--ignore-fail-on-non-empty] <dir> ...] 如果删除的是一个目录,则可以用该方法,主要参数<dir>指定目录路径。

例:

[root@master hdfs_test] #hdfs dfs –mkdir /user/dfstest/rmdir

[root@master hdfs_test] #hdfs dfs –rm /user/dfstest/c.txt

[root@master hdfs_test] #hdfs dfs –rmdir /user/dfstest/rmdir

2.上传文件到HDFS

(1)把本地计算机硬盘中的数据文件email_log.txt传输到集群服务器(master)的本地目录/root/hadoop。

可以使用SSH Secure等工具上传。

(2)在集群服务器(master)的终端执行HDFS命令,上传email_log.txt到HDFS目录/user/root/

Hdfs dfs -put /root/hadoop/email_log.txt /user/root/

(1)把本地计算机硬盘中的数据文件email_log.txt传输到集群服务器(master)的本地目录/root/hadoop。

可以使用SSH Secure等工具上传。

(2)在集群服务器(master)的终端执行HDFS命令,上传email_log.txt到HDFS目录/user/root/

Hdfs dfs -put /root/hadoop/email_log.txt /user/root/

以上是关于指导手册03:Hadoop基础操作的主要内容,如果未能解决你的问题,请参考以下文章