性能测试基础概念1

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了性能测试基础概念1相关的知识,希望对你有一定的参考价值。

参考技术A 性能测试针对系统的性能指标,建立性能测试模型,制定性能测试方案,制定监控策略,在场景条件之下执行性能场景,分析判断性能瓶颈并调优,最终得出性能结果来评估系统的性能指标是否满足既定值

步骤:

在线用户数、并发用户数、压力线程数、TPS的关系如下:

1.单个用户的TPS计算:通过日志,拉取一个用户的操作记录,记录下来一个事务的操作时间。例如:1个用户,100秒内,完成了一个完整流程,有4个操作(查询商品、填写信息、支付、订单详情),调用了20个接口。

用户级TPS:1 1/100=0.01TPS。 (1个用户) (1个完成业务)/100s

操作级: 1 4/100=0.04 TPS. (1个用户) (4个操作)/100s

接口级: 1 20/100=0.2TPS (1个用户) (20个接口)/100s

2.多用户的TPS。从生产拉取1天的用户量,记算下平均完成的时间(这会有一个问题就是很多用户没有真实走完一个完整业务,所以这个TPS计算是要注意?为了方便仅做假设每个用户是在100秒内完成)假如有一100万的用户,在1天内完成业务

用户级TPS:1000000 1 1/24/60/60=11.57TPS。 1000000 (1个用户) (1个完成业务)/24小时/60分钟/60秒

操作级: 1000000 1 4/24/60/60=46.29 TPS. 1000000* (1个用户) (4个操作)/24小时/60分钟/60秒

接口级: 1000000 1 20/24/60/60=231.48TPS 1000000 (1个用户)*(20个接口)/24小时/60分钟/60秒

3.峰值时的TPS。 1000人,在1分钟内完成业务

用户级TPS:1000 1 1/60=16.67TPS。 1000 (1个用户) (1个完成业务)/60秒

操作级: 1000 1 4/60=66.67 TPS. 1000* (1个用户) (4个操作)/60秒

接口级: 1000 1 20/60=333.33TPS 1000 (1个用户)*(20个接口)/60秒

4,怎么计算并发用户数和TPS之间的关系。

假如在jmeter中,完成一个完整的流程5秒钟。

用户级TPS:1 1/5=0.2TPS。 (1个用户) (1个完成业务)/5s

操作级: 1 4/5=0.8 TPS. (1个用户) (4个操作)/5s

接口级: 1 20/5=4 TPS (1个用户) (20个接口)/5s

5,无停顿(并发用户)相当于多少有停顿的用户(在线用户)

0.2/0.01=20. 即无停顿TPS/有停顿TPS。

并发度=1/20*100% =5%

6.压力线程数

a)100万在1天内:1000000的在线TPS/并发TPS=11.57/0.2=57.85

b)1000在1分钟内: 1000的峰值TPS/并发TPS=16.67/0.2=83.35

7.并发用户数的计算

并发用户数=在线用户数×有停顿时间的单线程TPS/无停顿时间的单线程TPS

8.并发度:并发度=并发用户/在线用户×100%(取值要在同一时间段)

1.抽取业务模型,可以通过日志系统或埋点等手段获取。

2.业务模型的作用:一是评估线上的性能;二是为后面的容量测试做准备

也可称之为混合容量性能场景,即将所有业务根据比例加到一个场景中,在数据、软硬件环境、监控等的配合之下,分析瓶颈并调优的过程。

1,业务指标

2,对各业务进行基准性能场景测试,对各业务基线测试,并优化以满足业务性能指标

3,抽取线上业务模型

4,根据业务模型,编写执行脚本,进行容量测试

核心就是时长。在长时间的运行之下,观察系统的性能表现,分析瓶颈并调优的过程

1,根据实际的业务需求设置。如我们每周一个发布周期,平均2个月所有的业务线会发布一次(即服务器重启)。那么我们的稳定性测试的策略应该是以最大TPS,执行7~30天。不可少于7天。但可以多于30天。

2,为什么以容量测试的最大TPS? 如果容量测试下来的最大TPS不能稳定执行,其容量测试的结果又什么意义?

性能测试基础概念

不怕啰嗦的再次忠告,那想成为测试高手的新人,多学学基础知识。别把过多的时间放在研究新工具的使用上。工具何其多,原理差不多。不要本末倒置了。也算是自我提醒吧!

性能测试常见指标

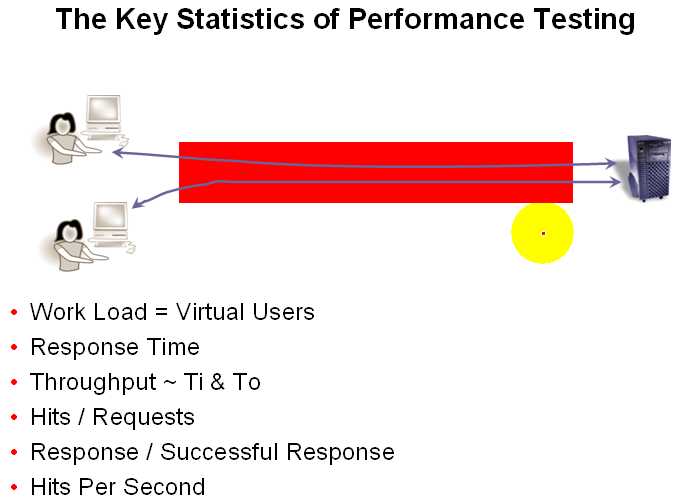

性能测试说白了就是通过工具模拟多个用户对被测系统进行访问。然后查看系统对于多个用户发来请求的处理能力。

左边的两个小人表示两个用户,向右边服务器发送请求,然后得到服务器的响应信息。

首先,我们要保证向服务器发送的请求的正确性,当然用户向服务器发送错误的请求,服务器也会个客户端响应信息,但响应的是报错信息;所以,为了保证测试数据的有效性,我们的要保证发送请求的正确性。

为什么一般的性能测试要在局域进行?

一般我们的性能测试都是在局域网中进行的。为什么一定要在局域网中进行呢?因为局域网中不受网络限制。这个说法不能绝对。但是一般测试工具的用户并发量是不会受到局域网带宽的限制,除非你做的是十万,百万级别的用户并发。相信懂一点网络知识的人都知道,当你上网很慢的时候,比如打开某某网站很慢,你肯定会骂电信的网络不给力,而不会骂这个网站响应速度不给力。因为,请求信息的耗时大部耗在传输过程中。

所以,刚做测试时,我们群里热议论,如果我们每个人都开一个压力工具对百度网站进行加压。百度,服务器会不会挂掉。有测友说这样是不道德人。呵呵!其实,完全不必有这个担心。就一般人家用的带宽,我确保,你向百度服务器发送的请求大部分都死在半路上,就算不死到了百度服务器已经不能叫并发了。何况百度服务器的集群技术以及其他各种分压技术。所以,做性能测试不了解被测系统的架构,以及各种技术的性能。很难做出有效的测试报告。

下面我们看看性能测试的一些技术指标。

Work Load = Virtual Users

工作负荷 = 虚拟用户数

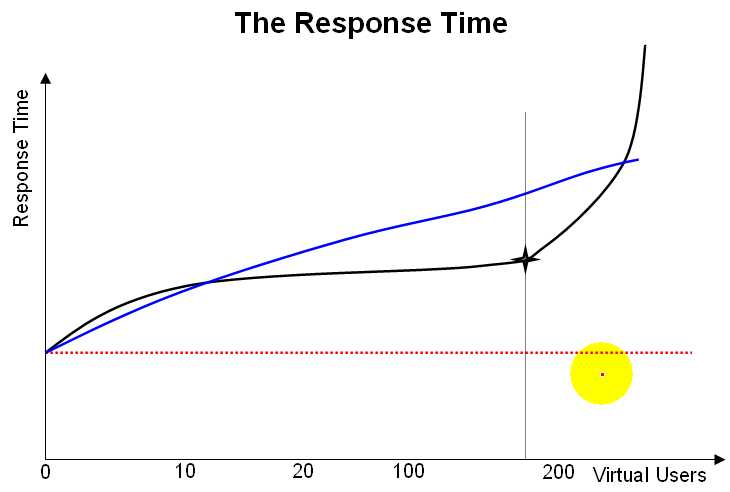

响应时间图分析

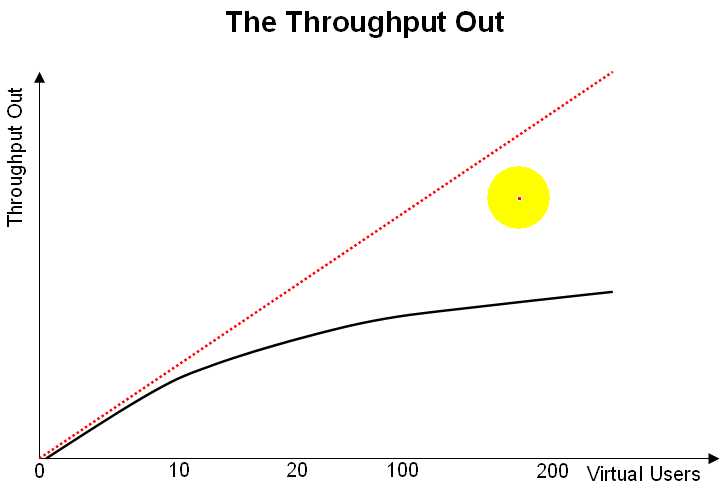

吞吐率图分析

以上是关于性能测试基础概念1的主要内容,如果未能解决你的问题,请参考以下文章